机器之心报道

-

论文标题:1000 Layer Networks for Self-Supervised RL: Scaling Depth Can Enable New Goal-Reaching Capabilities -

论文链接:https://arxiv.org/abs/2503.14858 -

GitHub 链接:https://github.com/wang-kevin3290/scaling-crl

-

范式融合:重新定义「强化学习」和「自监督学习」的关系,将它们结合形成自监督强化学习系统,采用对比强化学习(Contrastive RL, CRL)算法;

-

增加数据量:通过近期的 GPU 加速强化学习框架增加可用数据量;

-

网络深度突破:将网络深度增加到比先前工作深 100 倍,并融合多种架构技术稳定训练过程,包括:残差连接(Residual Connections)、层归一化(Layer Normalization)、Swish 激活函数。

-

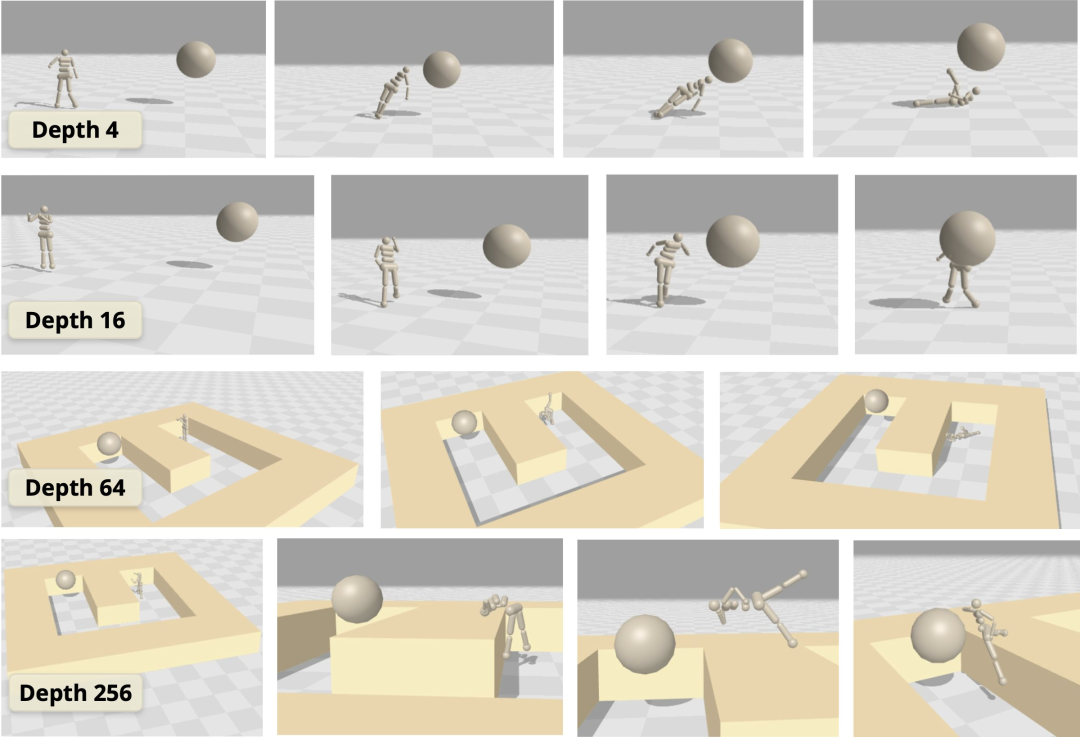

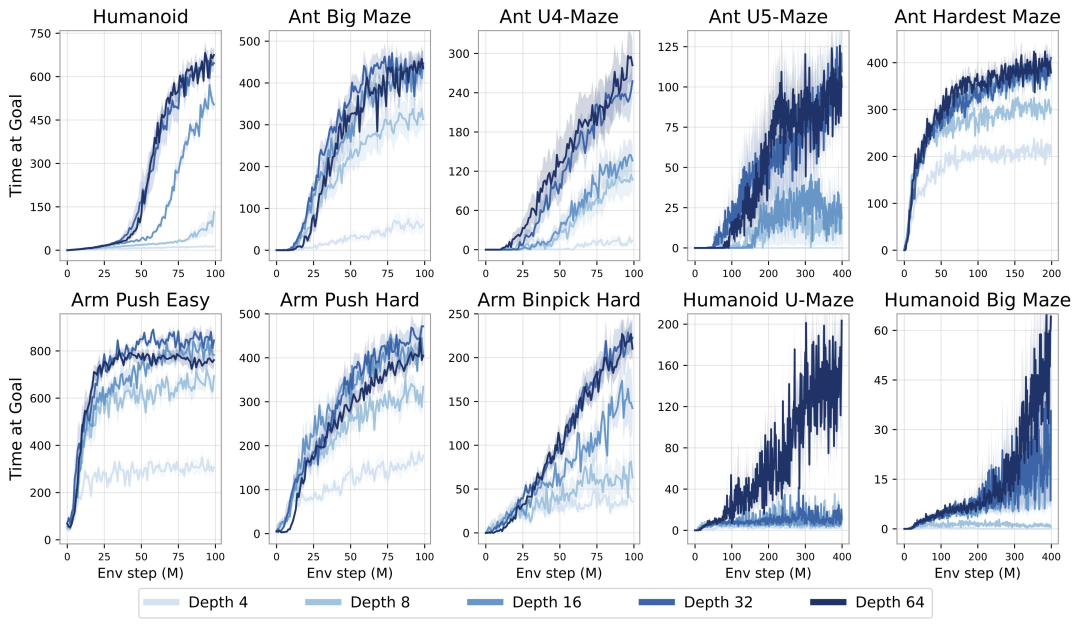

实证可扩展性:研究观察到性能显著提升,在半数测试环境中提升超过 20 倍,这对应着随模型规模增长而涌现的质变策略; -

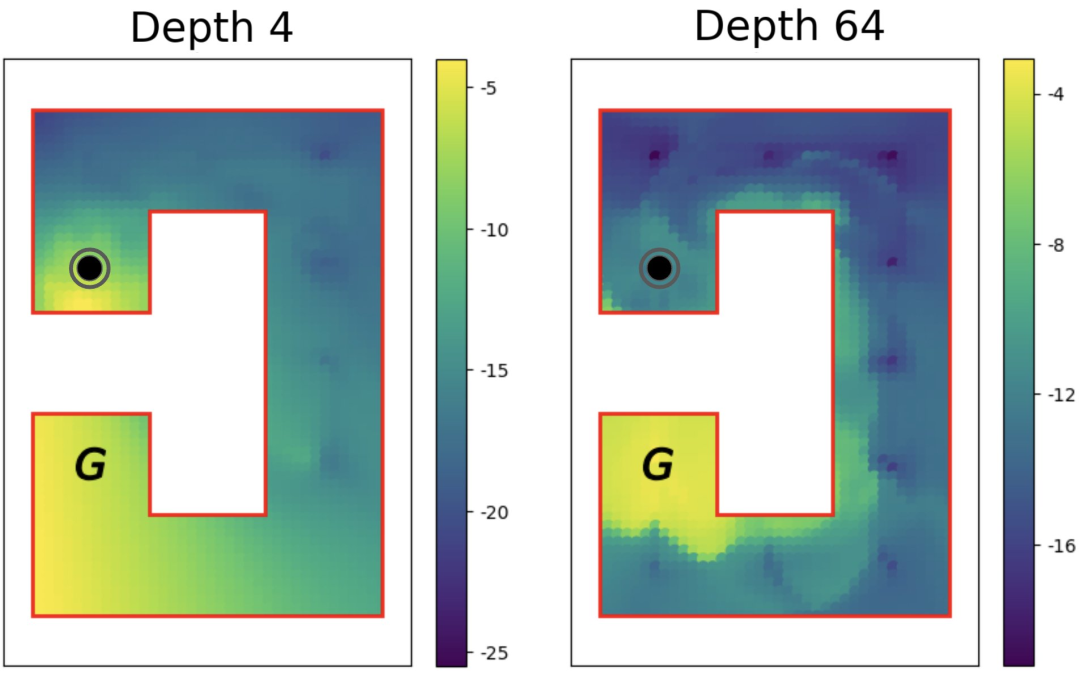

网络架构深度的扩展:虽然许多先前的强化学习研究主要关注增加网络宽度,但在扩展深度时通常只能报告有限甚至负面的收益。相比之下,本方法成功解锁了沿深度轴扩展的能力,产生的性能改进超过了仅靠扩展宽度所能达到的; -

实证分析:研究表明更深的网络表现出增强的拼接能力,能够学习更准确的价值函数,并有效利用更大批量大小带来的优势。

©

(文:机器之心)