极市导读

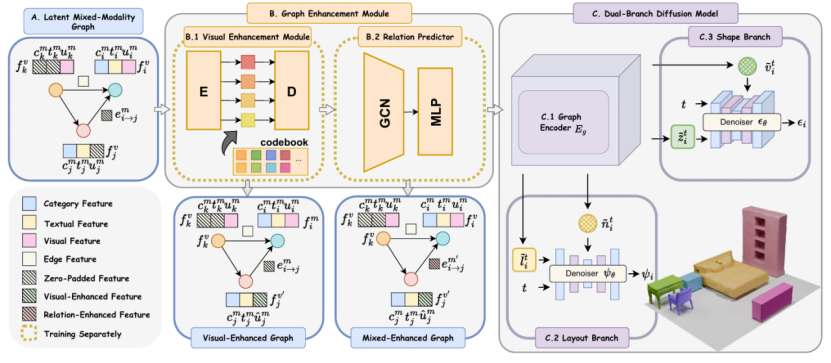

本文提出了 MMGDreamer,一种基于混合模态图(Mixed-Modality Graph)的双分支扩散模型,用于实现几何精准可控的3D室内场景生成。该方法通过引入混合模态节点(支持文本、图像或混合输入)、视觉增强模块(增强文本节点的视觉特征)和关系预测器(推断缺失的物体间关系),显著提升了场景生成的几何控制能力和整体真实性,在多项指标上达到SOTA性能。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

论文链接:https://arxiv.org/pdf/2502.05874v2

主页链接:

https://yangzhifeio.github.io/project/MMGDreamer

代码链接:

https://github.com/yangzhifeio/MMGDreamer

一. 引言

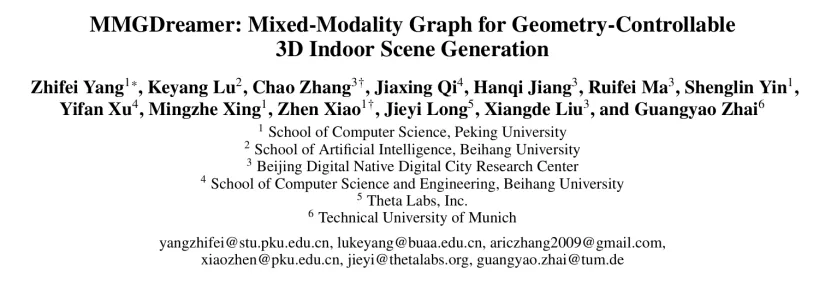

在虚拟现实、室内设计等领域,生成高真实感且几何可控的3D场景是一项关键挑战。现有方法主要依赖文本描述构建场景图,但文本难以精确描述物体几何细节,且无法灵活支持多模态输入。为此,我们提出了MMGDreamer,其核心亮点包括:

混合模态图 (MMG) :允许节点融合文本与图像信息,同时支持灵活关系设定,使生成的3D场景更具可控性。

视觉增强模块 (Visual Enhancement Module) :基于文本表示构造视觉特征,提升仅文本输入时的物体几何控制生成能力。

关系预测模块 (Relation Predictor) :利用图卷积网络(GCN)推测缺失的物体关系,使场景布局更合理。

双分支扩散模型 (Dual-Branch Diffusion Model) :分别处理场景布局和物体形态,提高生成质量。

二. 研究背景与动机

可控 3D 场景生成: 在虚拟现实和室内设计等领域,生成具有高度真实感和可控性的 3D 场景具有重要应用价值。场景图(Scene Graph)作为一种数据表示方式,能够有效抽象场景内容和物体间的关系,便于场景的生成和操纵。

现有方法的局限性:当前基于图的方法主要依赖文本输入,难以精确描述生成场景中物体的几何形状,导致对物体几何形状的控制不足。此外,这些方法对用户输入的灵活性较差,限制了其在实际应用中的表现。

三. 方法

1. 输入表示:混合模态图(Mixed-Modality Graph, MMG)

目的:解决单一模态(如纯文本)输入无法精准描述物体几何形状的问题。

结构: 节点(Nodes):可以携带文本信息、图像信息或两者的组合。 如,节点可表示为纯文本(如“椅子”)、纯图像(如椅子的照片)或图像与文本的组合。边(Edges):表示物体之间的关系(例如“左边”或“附近”),用户可以选择性提供或省略。

特征编码:通过CLIP预训练模型对节点的文本信息和图像信息分别进行编码,得到文本特征和图像特征。使用独立的嵌入层对物体类别和关系信息进行编码,分别得到类别特征和边特征。对于缺失的节点模态信息或缺失的关系,采用特征零填充(Zero-Padding),确保信息的一致性。

2. 图增强模块(Graph Enhancement Module)

图增强模块的作用是进一步提升混合模态图的表现力和完整性,分为两个关键子模块:

(1) 视觉增强模块(Visual Enhancement Module)

目的:针对仅含文本信息的节点,构造补充的视觉特征以提高节点的几何控制能力。

实现方式: 采用类VQ-VAE结构。

编码器 E:将节点的文本特征转换为潜在向量。

量化器(codebook C):从嵌入向量集合中,选取与潜在向量最近的若干个嵌入向量进行量化,获得量化后的潜在向量。

解码器 D:将量化后的向量转换为补充的视觉特征。

输出:视觉增强图(Visual-Enhanced Graph),节点视觉特征更加丰富精准。

(2) 关系预测器(Relation Predictor)

目的:自动推断节点之间缺失的关系,以提高场景布局的合理性。

实现方式: 输入为节点三元组表示(源节点特征、边特征、目标节点特征);缺失的边特征采用零填充进行处理,确保输入的统一。

模型结构:图卷积网络(GCN):捕捉节点之间的上下文关系;多层感知机(MLP):进一步精炼关系的预测结果。训练目标:使用交叉熵损失函数,优化边的关系分类准确率。

输出:混合增强图(Mixed-Enhanced Graph),包含预测和补全后的关系信息。

3. 双分支扩散模型(Dual-Branch Diffusion Model)

双分支扩散模型负责生成最终的3D场景,包括场景的布局(Layout)与物体的几何形状(Shape):

(1) 图编码器(Graph Encoder)

采用基于三元组结构的GCN,并集成了回声机制(Echo mechanism),实现节点之间的信息高效交换与关系建模。生成节点的潜在表示,用于布局与形状分支的条件引导。

(2) 布局分支(Layout Branch)

输入表示:物体边界框表示布局,每个物体用三维位置、尺寸和旋转角度进行参数化。

处理流程: 图编码器更新节点表示,用于引导后续去噪过程;利用条件节点特征,采用一维扩散去噪网络(1D-UNet)进行布局生成。

训练目标:通过回归损失函数(预测噪声与真实噪声的差距)优化布局生成精度。

(3) 形状分支(Shape Branch)

输入表示: 物体的形状采用截断符号距离场(Truncated Signed Distance Field, TSDF)表示,并通过预训练的VQ-VAE转化为潜在向量。

处理流程: 图编码器处理形状潜在向量与关系图特征,更新节点表示;条件节点特征用于引导三维扩散去噪网络(3D-UNet)进行形状生成。

训练目标: 与布局分支类似。

4. 模型训练与推理策略(Training & Inference)

模型训练分为两个阶段:第一阶段:分别训练视觉增强模块和关系预测器,独立优化以提升节点的视觉特征与关系预测精度。第二阶段:以混合模态图作为输入,同时优化图编码器和布局、形状分支的双分支扩散模型。

推理阶段:从混合模态图开始,依次经过视觉增强模块和关系预测器生成混合增强图。最终通过双分支扩散模型生成高质量、布局合理、几何精准的3D室内场景。

四. 实验结果

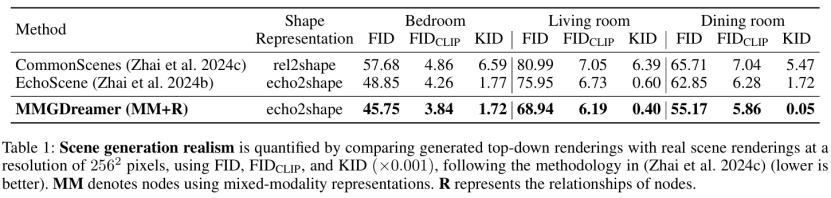

定量实验

为客观评估MMGDreamer模型生成场景的真实感与几何控制能力,我们采用了 FID(Fréchet Inception Distance)、FID CLIP和 KID(Kernel Inception Distance) 三个权威指标,在SG-FRONT数据集上与当前最新的场景生成方法EchoScene进行了对比评测。

实验结果表明,当使用混合模态节点进行场景图表达时,MMGDreamer显著优于EchoScene。尤其是在生成客厅场景时,MMGDreamer(同时启用视觉增强模块与关系预测模块,即MM+R)表现出了明显优势,FID指标降低了9%,FIDCLIP指标降低了8%,KID指标降低了33%

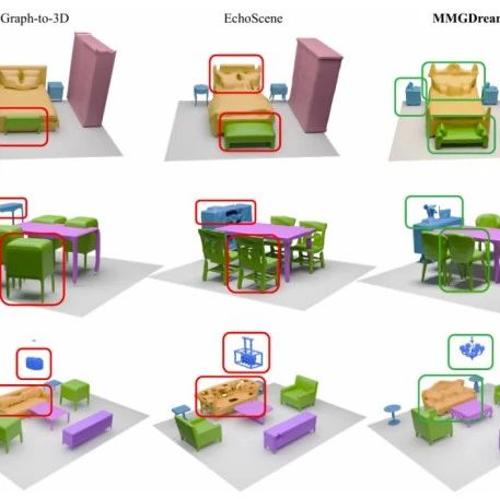

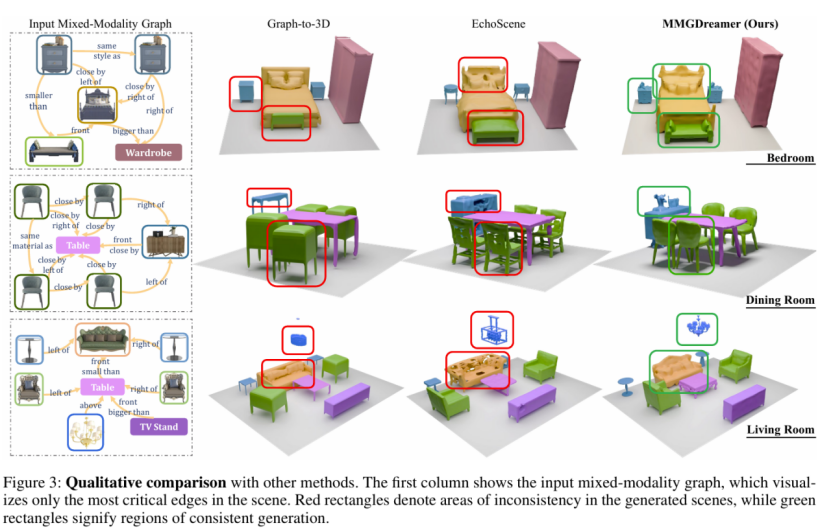

定性实验

为了更直观地展示MMGDreamer的优势,我们进一步选取卧室、餐厅与客厅三种典型室内场景进行视觉效果的对比分析:

(1)卧室场景:MMGDreamer准确生成了床和床头柜等物体的精确几何结构,而Graph-to-3D和EchoScene方法则存在明显的几何扭曲与不连贯现象。

(2)餐厅场景:在生成椅子靠背和餐具柜等复杂物体时,Graph-to-3D和EchoScene方法出现了严重的几何变形和细节缺失问题。相比之下,MMGDreamer不仅保留了物体的准确几何结构,还精准还原了餐具柜上复杂的细节装饰。

(3)客厅场景:针对复杂的客厅环境,MMGDreamer准确生成了沙发、咖啡桌与灯具,并保证了物体之间空间布局的连贯性,生成物体与输入图像高度一致。反观其他方法,则频繁出现家具几何扭曲或细节缺失的问题。例如,EchoScene生成的沙发表面存在明显孔洞,显著偏离真实几何形态。

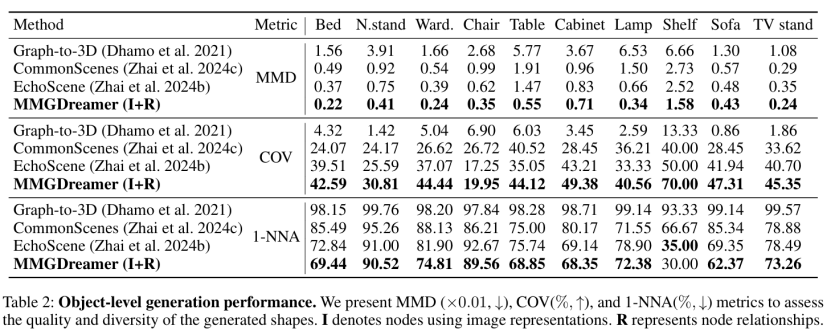

物体级生成质量分析(Object Generation)

除了场景整体的表现,我们进一步分析了单个物体的生成效果,采用了经典的点云评估方法PointFlow,并选用 MMD(Minimum Matching Distance)、COV(Coverage) 和1-NNA(1-Nearest Neighbor Accuracy) 三项指标,从精细几何控制和分布相似度两个维度进行深入评测。实验结果表明,MMGDreamer在物体级的生成质量上展现出高度的几何精准性与一致性。

五. 结论

本文提出了MMGDreamer,一种基于混合模态图(Mixed-Modality Graph)和双分支扩散模型的新型3D室内场景生成框架。MMGDreamer通过灵活融合文本与视觉信息,有效解决了传统方法模态单一、几何控制精度不足的问题。同时,视觉增强模块显著提升了物体的几何细节生成能力,关系预测器有效补全了缺失的物体关系,优化了整体场景的布局合理性。大量实验表明,MMGDreamer在多个关键指标上超越了当前主流方法,成功实现了精准可控、真实且连贯的3D室内场景生成,为虚拟现实、增强现实、室内设计及游戏开发等领域提供了有力的技术支持与广泛的应用前景。

(文:极市干货)