最新研究表明,全年使用AI 聊天机器人消耗的能源,还比不过你洗上5次澡的开销!

之前总听见有人抱怨AI 耗电多

特别是流传一个说法「ChatGPT一次对话就要消耗3瓦时电量,是谷歌搜索的10倍」。

这是说我们的AI 使用会给环境带来巨大负担?

带着这个疑问,我深入研究了下Marcel Salathé 和Epoch AI 的最新报告

结果发现了一个惊人事实——

我们对AI能耗的认知被严重夸大了!

且往下看

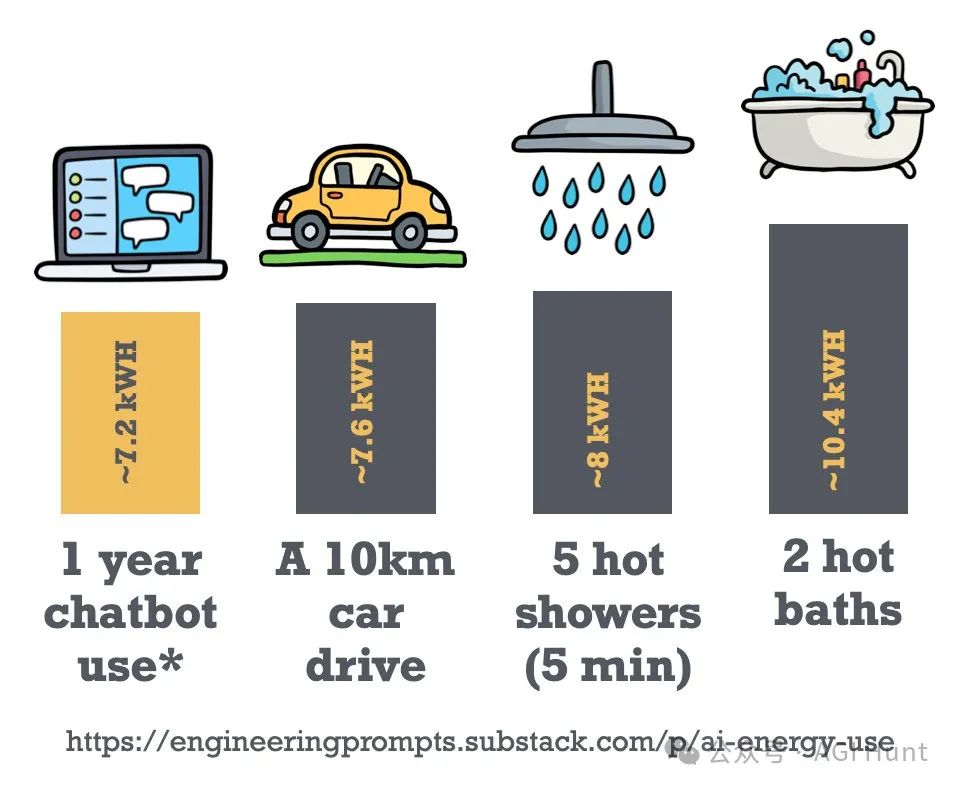

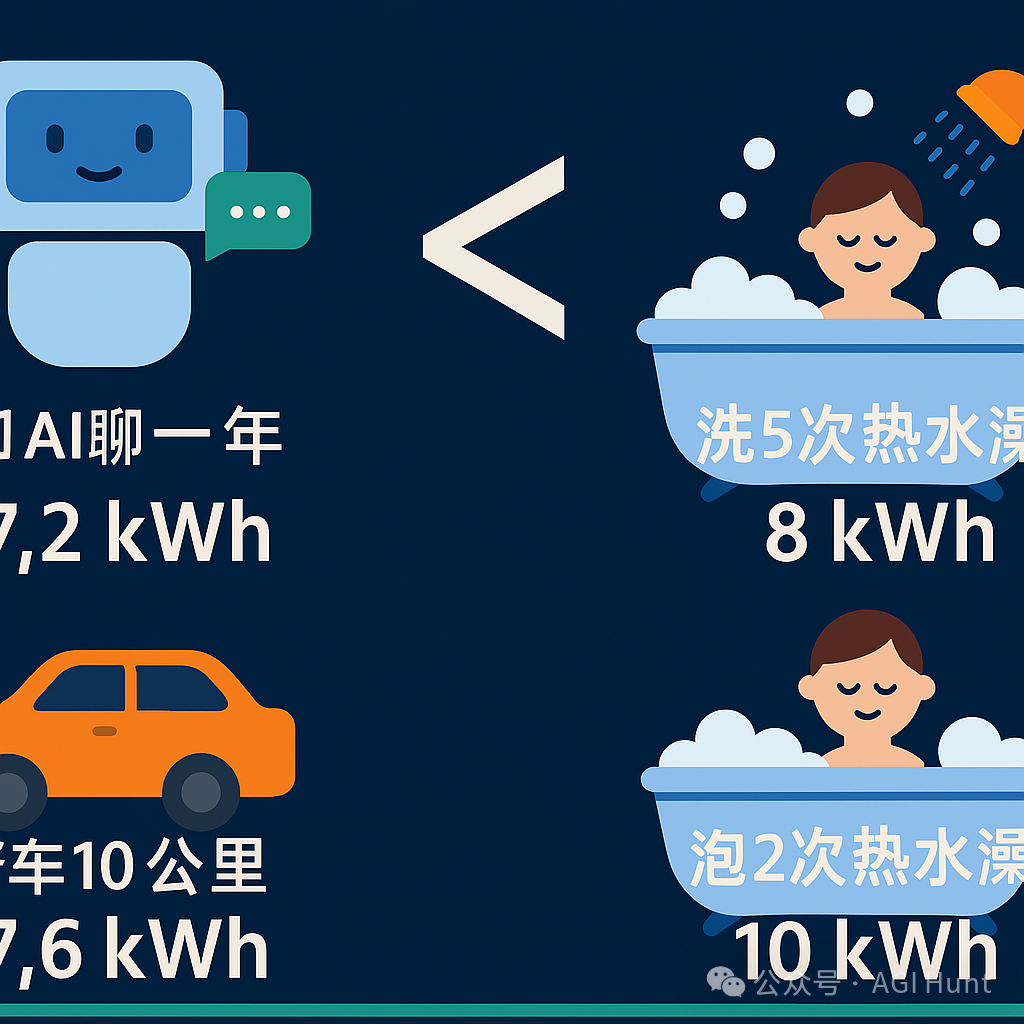

和AI 聊一年,耗电有多少?

拿目前主流的GPT-4o来说

每次纯文字交互实际只消耗约0.3瓦时(Wh) 电量,而不是广为流传的3瓦时

假设你每天进行约100次交互(相当于10次对话,每次来回约10轮)

全年下来也就消耗约7.2千瓦时(kWh)。

这数字听着可能没什么概念?

我给你换几个直观对比:

🚗 开车10公里

普通汽油车百公里油耗约7升,开10公里就得烧0.7升油。

每升汽油能量约9.7千瓦时,算下来这短途行驶就用了约7.6千瓦时能量。

电动车效率更高,相同距离大约只需四分之一能耗,但考虑大多数车仍使用汽油,这个比较还是很实在的。

🚿 洗5次热水澡

一次5分钟热水澡,平均用水约32.5升,水温升高30°C。

理想情况下需要1.13千瓦时能量

但考虑实际热损耗,单次热水澡耗能约1.6千瓦时,五次就是8千瓦时。

🛁 泡2次热水澡

相比淋浴,泡澡用水更多。

一个小浴缸就得装80-100升水

考虑热效率,单次就得消耗5.2千瓦时,两次就超过10千瓦时了。

也就是说——

你跟AI 聊个一年的耗电量,竟然连5次热水澡都不如!

为什么之前的估算差这么多?

查了下,发现之前广为流传的3瓦时/查询估计,是来自Alex de Vries 2023年的一项研究。

而最新研究估算出的0.3瓦时,足足低了10倍

哪里出了问题呢?

主要有三大原因:

之前研究假设每次查询会有2000个输出token(约1500词,相当于本文一半长度)

而实际上一般用户的查询输出约500个token(400词左右)。

新研究基于最新的英伟达H100芯片计算,而非旧款A100。

H100性能更高、能效比更好。

估计GPT-4o的活跃参数约1000亿,而之前估算GPT-3.5有1750亿参数。

参数减少,计算量和能耗也相应降低。

能耗计算的细节

而这个0.3瓦时,是怎么算出来的?

我来拆解一下这个过程:

首先

GPT-4o可能有约2000亿总参数,但作为一个混合专家模型(MoE)

每次只有大约四分之一的参数被激活,也就是约1000亿活跃参数。

每生成一个token(约0.75个词),需要每个活跃参数进行2次浮点运算

所以生成一个token需要2000亿次浮点运算。

一般对话模型输出约500个token

所以总共需要500 × 2000亿 = 1 × 10^14次浮点运算。

运行这些计算的H100 GPU,官方额定功率为700瓦

但考虑服务器和数据中心开销,每GPU实际耗电约1500瓦

H100每秒能执行989万亿次浮点运算,理论上0.1秒就能处理完一次查询。

但GPU在推理时不可能达到理论峰值,利用率可能只有10%

而且功耗也会降到峰值的70%左右

所以实际上,一次AI查询需要约1秒GPU时间,能耗约为0.3瓦时。

不过,这只是常规使用情况

如果你用AI处理特别长的输入,能耗会大幅增加:

-

1万token(短论文长度)输入:约2.5瓦时

-

10万token(约200页文本)输入:高达40瓦时

这是因为Transformer模型处理长输入时,注意力机制的计算量会与输入长度的平方成正比。

其他AI模型的能耗情况呢?

除了GPT-4o,市面上还有各种大模型:

-

GPT-4o-mini:参数量更少,API价格仅为GPT-4o的十分之一,能耗可能也低得多

-

o1和o3-mini:OpenAI的推理模型,虽然每token能耗可能较低,但由于生成长推理链,每次查询总能耗可能更高。非正式测试表明,这些模型生成的token数是GPT-4o的2.5倍

-

Claude 3.5 Sonnet:估计有约4000亿参数,能耗可能与GPT-4o相当

-

DeepSeek-V3:只有371亿活跃参数(总计6710亿参数),每token能耗可能低于GPT-4o

随着技术发展,AI模型能效正在不断提升。

硬件厂商开发更高效芯片,AI公司让小模型能力更强

研究人员发明多token预测等推理优化技术,这些都在降低AI能耗。

但另一方面

如果用户开始大量使用需要复杂推理的高级模型,或者处理更大规模的输入

则单次查询的能耗可能会增加

OpenAI新推出的需要深度推理的Deep Research产品就是这一趋势的早期信号。

AI的上游能耗:训练与硬件制造

除了日常使用的能耗,我们还应考虑AI 的”上游”能源成本

包括模型训练和硬件制造。

模型训练

当前一轮大模型训练耗电约20-25兆瓦,持续大约三个月

足以供应约2万美国家庭用电

但考虑到ChatGPT有3亿用户,而且模型一旦训练好可以使用很长时间

平均到每个用户头上的训练能耗并不高。

硬件制造

制造GPU和服务器所需的”内含能源”也是一个因素。

根据研究,制造AI 硬件的内含碳排放约为模型训练排放的一半

而且因为法国电力清洁(主要来自核电),内含能源比例可能更低。

台积电2023年总耗电约240亿千瓦时,相当于平均功率2.7吉瓦。

这与其生产的GPU总功耗相当,但需要考虑GPU使用寿命更长,且台积电产品不仅限于AI芯片。

把AI能耗放在更大视角

将ChatGPT的能耗与日常生活对比:

美国普通家庭年均用电约10,500千瓦时,日均超过28,000瓦时。

对比之下,ChatGPT的使用能耗微不足道。

当然,从宏观角度看,一些研究预测到2030年,AI 可能会消耗美国10%的电力

这确实值得关注

目前AI 数据中心估计消耗美国0.3%的电力(约110亿千瓦时),到2030年可能增长30倍。

但就个人使用而言,不必过度担忧AI聊天耗电。

如果你想为环保做贡献,不妨考虑减少开车,选择淋浴而非泡澡,或者缩短些洗澡时间

这些小改变就能轻松抵消一整年的AI 聊天能耗了!

以上

事实就是——

虽然AI 整体发展确实需要关注能源问题,但普通人日常使用AI 的能耗影响,其实微乎其微。

与其担心每天和ChatGPT聊两句会不会毁灭地球,增加碳排放

不如看看自己生活中其他耗能大户,从那里开始节能减排

比如少洗几次澡

效果反而好得多!

(文:AGI Hunt)