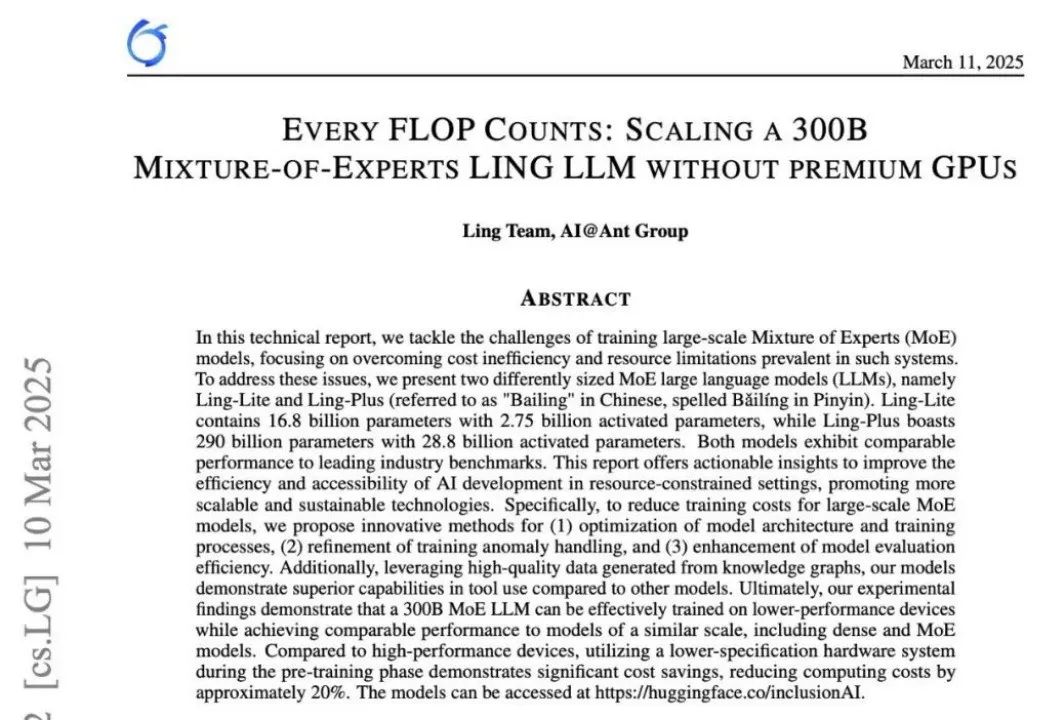

近日,蚂蚁集团在 AI 模型训练技术上取得突破,结合“专家混合机器学习”方法,在混合算力的系统下,依然能保证模型性能,并进一步降低训练成本。蚂蚁这一研究成果的论文于 3 月 11 日发表(论文地址:https://arxiv.org/pdf/2503.05139),其中介绍了蚂蚁集团如何通过精细化的系统优化,实现大模型训练的效率和性能双重提升。

-

模型架构:基于对密集模型和 MoE 模型缩放规律的综合分析,蚂蚁团队选择与可用计算资源最匹配的架构,实现了资源利用率的最大化。这一策略性选择在资源有限的情况下,确保了模型性能的最优表现。

-

训练框架:为了充分发挥异构计算平台的潜力,蚂蚁团队将多个训练框架整合为一个统一的分布式深度学习框架,即开源项目 DLRover。此外,他们还开发了轻量级调试工具 XPUTimer 和弹性分布式训练策略 EDiT, 在大幅减少内存占用的同时,显著提升了训练效率。

-

存储系统:蚂蚁团队通过采用设备多租户和用户空间文件系统(FUSE)等技术,实现了大规模训练的高性能和多集群适应性。存储和训练流程的协同设计不仅提高了 MoE 场景中的 I/O 效率,还将时间开销减少了 50%。

-

推理优化:基于自主创新的离线推理框架 Flood,蚂蚁构建了一套可扩展的跨集群评估系统,确保了训练效果的稳定性和可靠性。

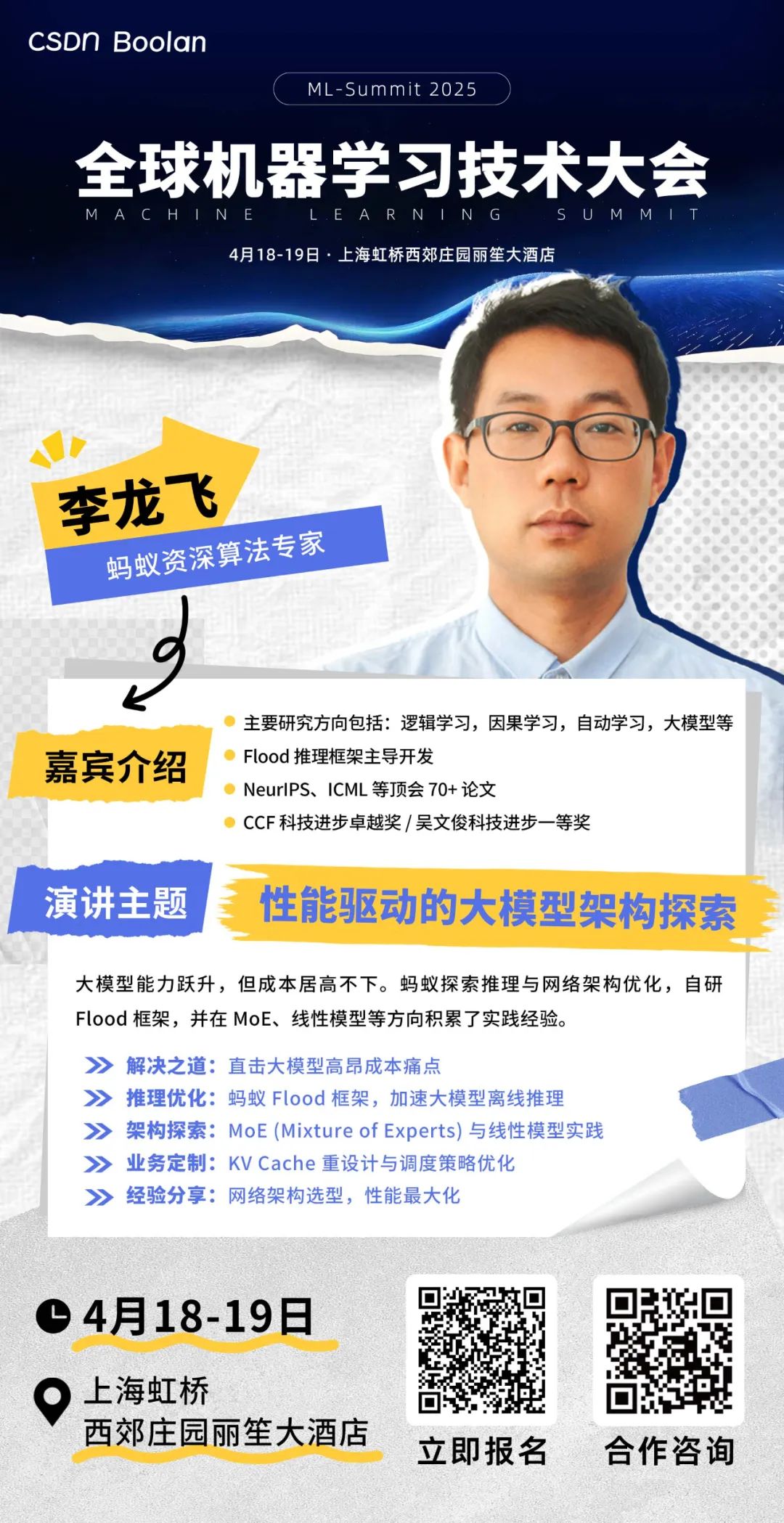

与此同时,在由 CSDN & Boolan 联合举办的 2025 全球机器学习技术大会上,来自蚂蚁的资深算法专家李龙飞将带来《性能驱动的大模型架构探索——网络架构及推理架构》的精彩分享,深入剖析蚂蚁在降低大模型应用成本方面的探索与实践。

李龙飞拥有十年的蚂蚁工作经验,在逻辑学习、因果学习、自动学习、大模型等方向有深入研究,并在 NeurIPS、ICML、KDD、SIGIR 等国际顶级会议上发表论文 70 余篇。他主导参与了蚂蚁内部的多个核心平台和项目,深度参与蚂蚁百灵大模型的开发,并主导了大模型离线推理框架 Flood 的开发(GitHub 地址:

https://github.com/alipay/PainlessInferenceAcceleration )。凭借其在人工智能领域的卓越贡献,李龙飞荣获了 CCF 2020 科技进步卓越奖和吴文俊 2023 科技进步一等奖。

近年来,大语言模型能力突飞猛进,然而高昂的部署成本始终制约着其广泛应用。为此,蚂蚁集团从推理架构和网络架构两大方向入手,进行了系统性的优化探索。 李龙飞将在 2025 全球机器学习技术大会上深入探讨蚂蚁集团在大模型低成本部署方面的创新实践:

-

推理架构优化: 结合具体业务,重新设计 KV Cache 和调度策略,并基于此开发了 Flood 框架,在离线推理中取得了显著的性能提升。

-

网络架构探索: 在 MoE(Mixture of Experts)、线性模型等方向进行了深入探索,积累了丰富的实战经验。

这些探索最终助力蚂蚁集团实现了使用国产芯片降本增效的目标。李龙飞的分享将为与会者提供宝贵的借鉴和启发,为行业提供宝贵经验,助力开发者和研究者在降低大模型应用成本方面取得突破。

ML Summit 2025:汇聚全球智慧,共绘 AI 新蓝图

2025 全球机器学习技术大会 (ML Summit 2025) 不仅是技术交流的平台,更是推动 AI 生态融合、促进行业协同创新的重要契机。大会设有 12 大技术专题,覆盖 AI 领域的前沿热点。此外,大会还将设置 AI 企业创新展区,展示最新的技术产品和解决方案。

我们诚挚邀请全球 AI 产业参与者积极加入 ML Summit 2025,共同探索 AI 的未来发展方向,推动 AI 在更广泛的应用场景中落地生根。期待与您在 ML Summit 2025 携手见证 AI 时代的新篇章!

我们诚邀全球 AI 产业参与者积极加入,共同捕捉前沿趋势,探索产业升级路径,推动 AI 走向更广阔的应用场景。期待在 ML Summit 2025,与每一位同行者携手见证 AI 时代的新篇章!

↓↓ 点击「阅读原文」,查看「2025 全球机器学习技术大会」嘉宾最新动态与演讲议题!

(文:AI科技大本营)