随着人工智能领域的不断发展,深度学习模型在多个任务中展现出强大的能力,尤其是在大规模语言模型(LLMs)和多模态大语言模型(MLLMs)中。

最近,DeepSeek R1 的提出引发了对强化学习(RL)在大模型优化中的巨大潜力的广泛关注。特别是,rule-based 的强化学习通过基于规则的奖励机制,成功地为模型提供了一种高效且可靠的优化途径。这种方法不仅能够在数据有限的条件下显著提升大语言模型的性能,还展现了其在多模态任务中的强大适应能力。

随着这一技术的逐步发展,已经被扩展应用到多模态大语言模型的训练中,进一步推动了多模态推理能力的提升,展现了其广泛的应用前景。本篇文章将讨论来自 Aligning Multimodal LLM with Human Preference: A Survey(https://arxiv.org/abs/2503.14504)中五篇近期关注多模态 O1-reasoning 相关的文章。

CUHK: LMM-R1

1.1 Motivation 与主要贡献

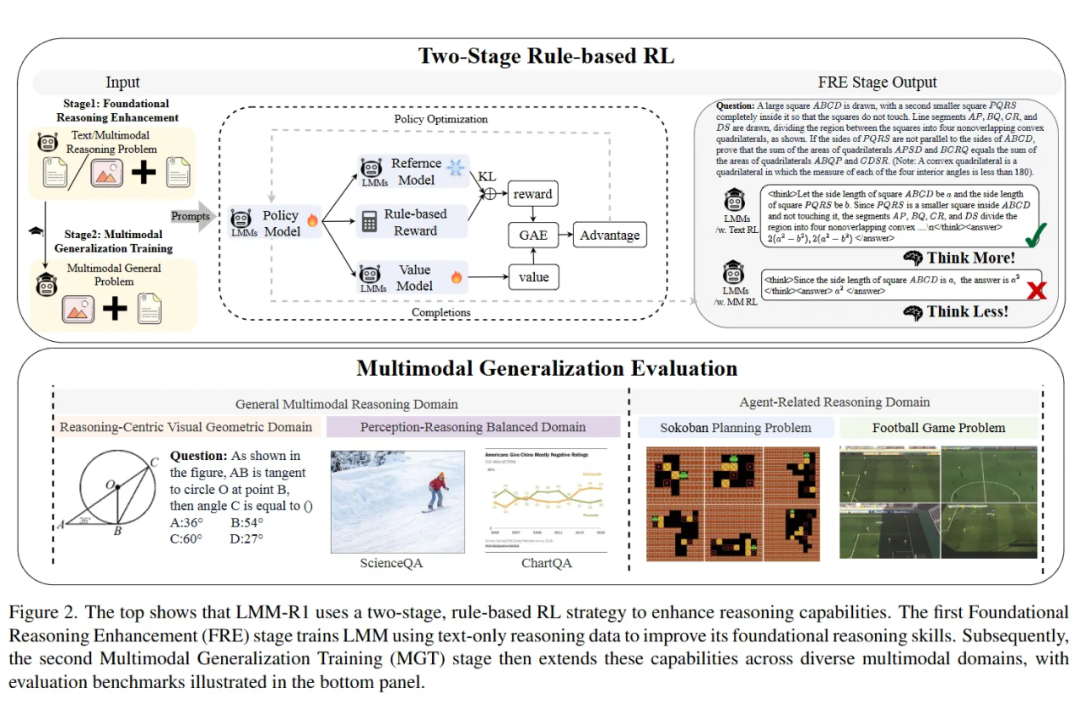

本文提出了 LMM-R1 框架,旨在增强大规模多模态模型(LMMs)的推理能力。文章的动机源于 LMMs 在视觉感知与逻辑推理之间复杂的交互作用,尤其是对于 3B 参数架构而言,由于架构约束,其推理能力和模态对齐能力受到限制。

当前,基于规则的强化学习(RL)在文本领域表现良好,但将其扩展到多模态领域面临两大挑战:一是数据不足,尤其是在多模态任务中存在答案模糊和复杂推理示例稀缺的问题;二是多模态预训练导致基础推理能力下降。

为了应对这些挑战,本文提出了 LMM-R1 框架,该框架通过基础推理增强(FRE)和多模态泛化训练(MGT)两个阶段,利用基于规则的 RL 方法有效提升多模态推理能力。

实验结果表明,LMM-R1 在多模态和文本基准任务中相较于基线模型有显著提升,验证了基于文本的推理增强能够有效地进行多模态泛化,从而避免了昂贵的高质量多模态训练数据的需求。

1.2 方法部分

LMM-R1 的训练流程分为两个阶段:基础推理增强(FRE)和多模态泛化训练(MGT)。

强化学习算法

-

文章采用了 PPO 算法训练 LMMs,目标是最大化以下目标函数: -

-

其中, 为生成的答案, 为图像输入, 为文本提示, 为策略模型, 为固定的初始策略, 为KL散度的惩罚系数。

奖励函数设计

-

文章使用了双重奖励机制: -

格式奖励:检查模型回答是否遵循指定的结构格式,即在 <think></think>标签内展示推理过程,并将最终答案放在<answer></answer>标签内。 -

准确性奖励:通过符号验证方法评估答案的正确性,解析模型的回答和地面真值解决方案,并进行等价性比较。 -

最终奖励函数为:,其中, 为格式奖励, 为准确性奖励, 控制格式奖励与准确性奖励的相对重要性。

LMM-R1 模型的两阶段训练

-

第一阶段:增强基础推理能力。首先利用大量高质量的文本数据进行规则强化学习训练,提升模型的推理能力。

-

第二阶段:在多模态任务中进行推理能力的泛化训练,针对不同的任务域进行训练,提升模型的多模态推理能力。

多模态泛化训练

-

在两个不同的任务域中进行训练:

-

通用多模态推理域:包括几何推理领域和感知推理平衡领域,前者关注几何问题,后者涉及视觉问答、文档理解等任务。

-

代理相关推理域:通过使用经典的 Sokoban 规划游戏和足球比赛任务,测试模型的空间推理、规划能力以及在复杂视觉环境中的决策能力。

1.3 实验部分

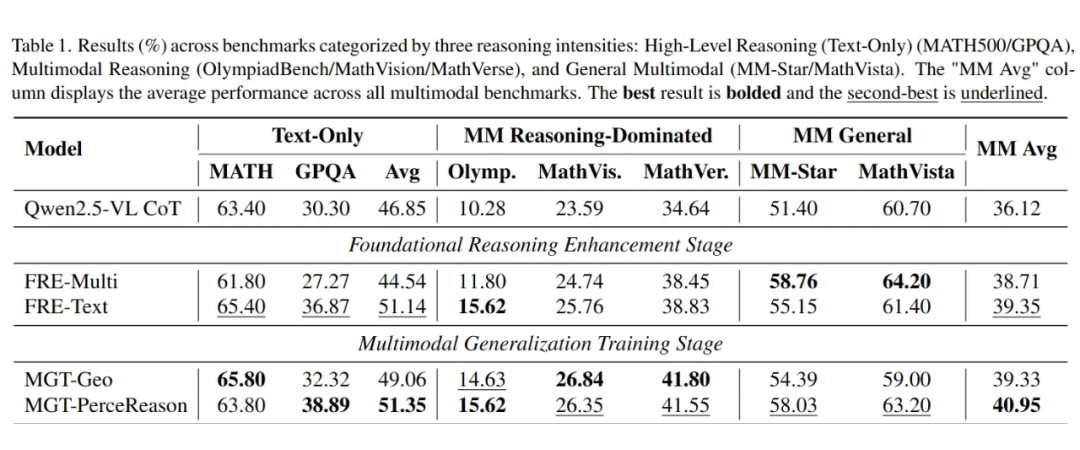

FRE 阶段实验

-

在文本推理任务上,FRE-Text 模型相比基线模型有显著提升,MATH500 和 GPQA 任务上分别提高了 2.0% 和 6.57%。

-

然而,在多模态任务中,FRE-Text 模型的提升较为温和,而 FRE-Multi 在视觉推理任务上表现更好,尤其是在 MathVista 和 MM-Star 任务上。

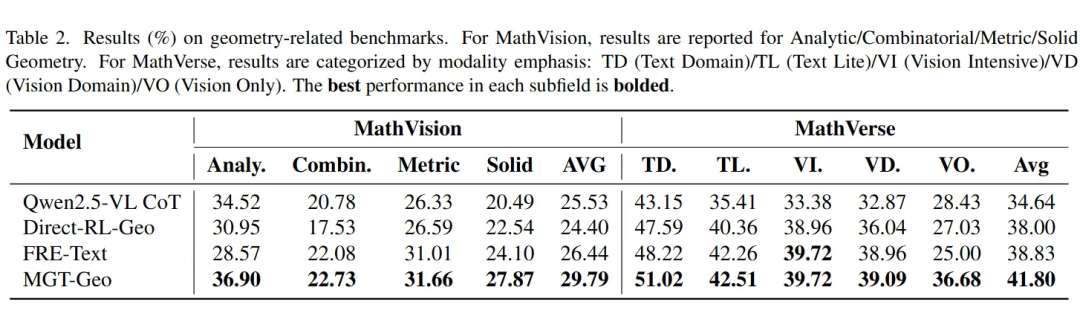

MGT 阶段实验

-

几何领域(MGT-Geo):MGT-Geo 模型在多模态基准任务上超过了基线模型 3.21%,在几何相关任务上也有显著提升。与 Direct-RL-Geo 模型相比,MGT-Geo 在 MathVision 和 MathVerse 任务上表现更好,证明了FRE阶段对多模态推理的积极影响。

-

感知-推理平衡领域(MGT-PerceReason):该模型在视觉任务上表现出显著提升,尤其在 MathVista 和 MM-Star 任务上,且在推理任务上的表现保持稳定。

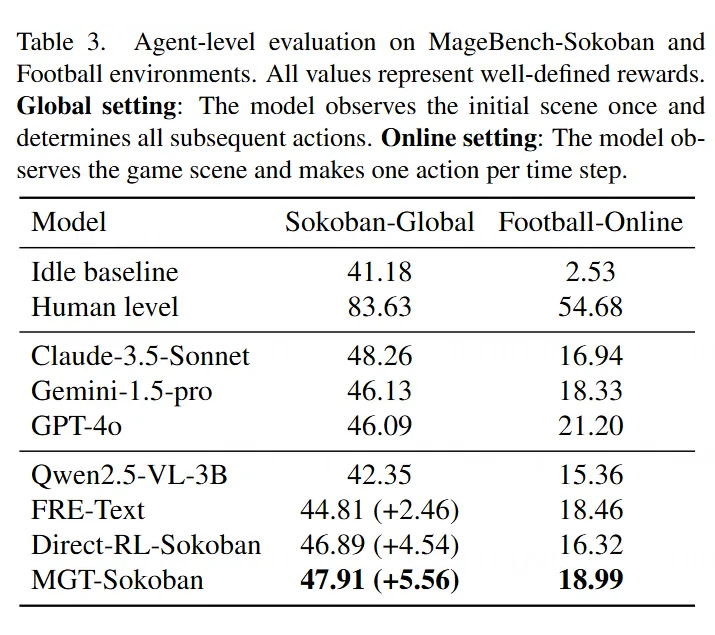

代理相关推理实验

-

Sokoban 任务:MGT-Sokoban 模型在 Sokoban-Global 环境中相较于基线提高了 5.56%,在 Football-Online 任务中也有显著提升。相比之下,FRE-Text 和 Direct-RL-Sokoban 模型在这些任务中的表现较弱,验证了基于规则的强化学习对代理任务的有效性。

SFT 与 RL 的比较

-

对比 SFT 与 RL 训练,实验结果显示,SFT 方法会导致严重的灾难性遗忘,而 RL 训练能够有效避免这一问题,并在下游任务中取得更好的表现,尤其在几何任务中的表现更为突出。

1.4 讨论与结论

LMM-R1 框架通过两阶段的训练策略显著提升了大规模多模态模型的推理能力,尤其是在复杂的推理任务和视觉任务中。实验结果表明,文本推理增强提供了强大的推理基础,而多模态数据的加入则增强了视觉推理能力。

与传统的多模态强化学习方法相比,LMM-R1 框架通过合理选择训练数据,在避免灾难性遗忘的同时,提升了模型在多模态任务中的表现。未来的工作将进一步扩展该框架,探索更多领域的多模态推理应用。

通义实验室:R1-Omni

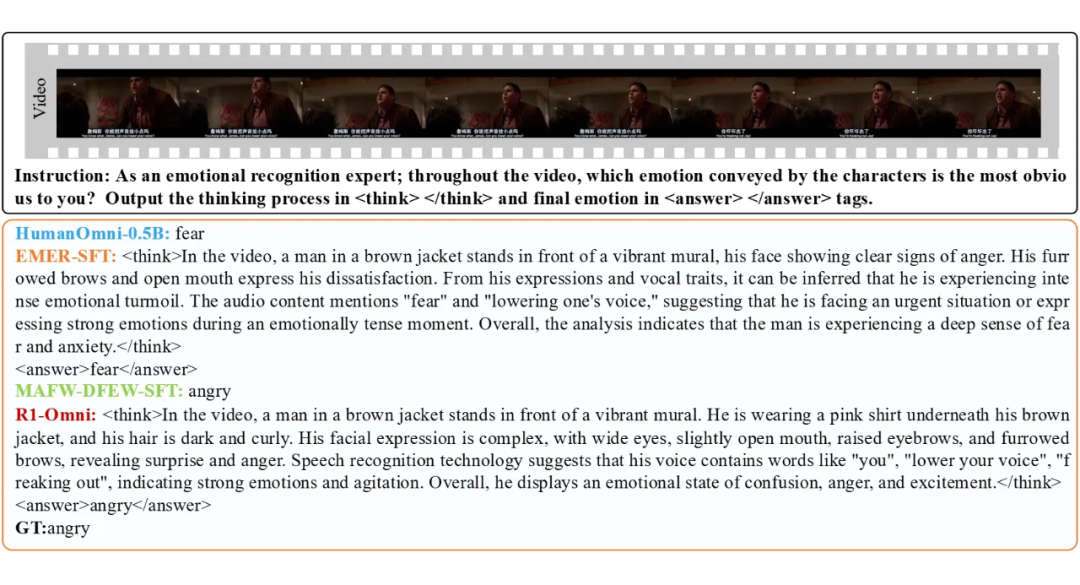

尽管 RLVR 在图像-文本多模态任务(如几何推理和视觉计数)中取得了成功,但目前尚未有研究将其应用于更复杂的多模态任务,例如结合视频、音频和动态视觉内容的情感识别任务。

情感识别是一项对视觉和音频信息高度依赖的任务,具有丰富的跨模态信息交互需求。本文旨在填补这一空白,将 RLVR 应用于视频 Omni 多模态模型,探索其在情感识别任务中的潜力。

2.1 主要贡献

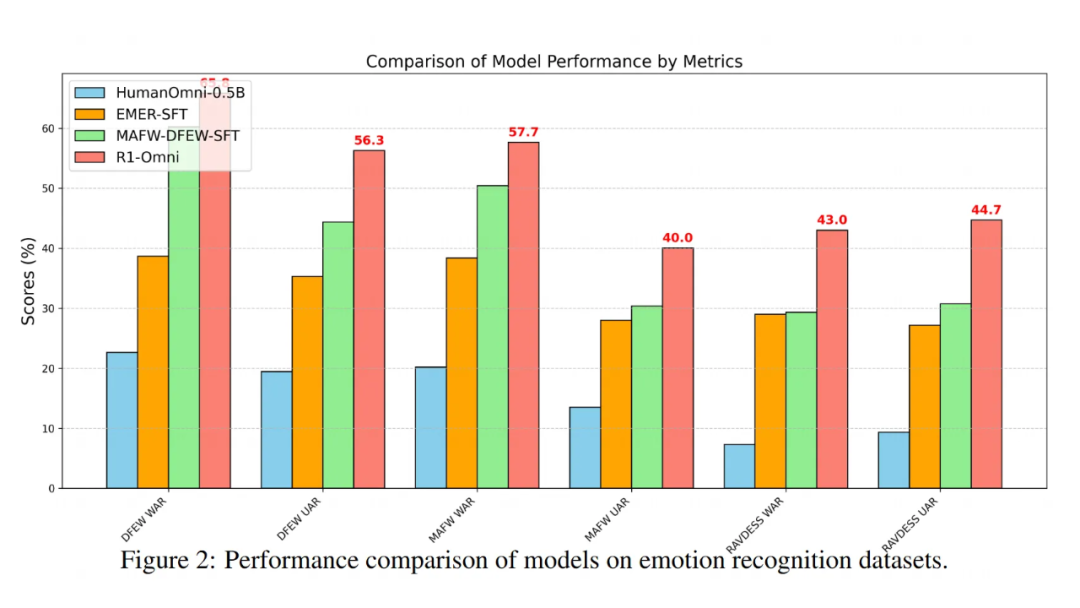

1. 首次将 RLVR 应用于视频 Omni 多模态模型:通过整合视觉和音频信息,优化情感识别任务。

2. 增强推理能力:模型能够清晰分析视觉和音频信息在情感识别中的贡献,为多模态模型的优化提供重要洞察。

3. 提升情感识别准确性:相比监督微调(SFT),RLVR 显著提高了情感识别任务的性能。

4. 强化泛化能力:RLVR 模型在分布外(OOD)数据集上的表现远超 SFT,展现了更强的鲁棒性和适应性。

2.2 方法部分

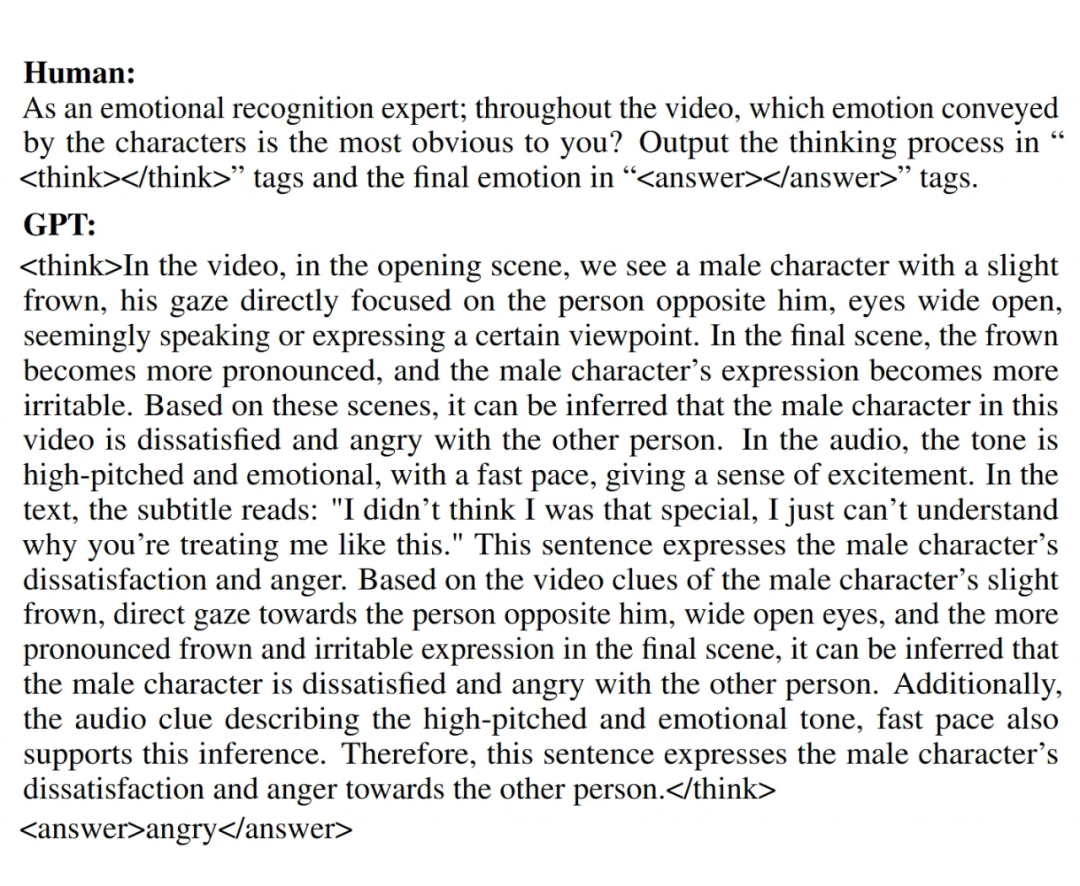

2.2.1 冷启动阶段(EMER数据集)

在冷启动阶段,HumanOmni 模型通过在 EMER 数据集和手动标注的 HumanOmni 数据集上进行微调,利用多模态数据(视频和音频)来提升初步的情感推理能力。

EMER 数据集包含了详细的情感推理过程注释,通过对视频中的人物表情、语音特征和文本内容的综合分析,模型能够学会如何从视觉和音频线索中推测出情感状态。

2.2.2 强化学习优化(RLVR)

在 RLVR 训练过程中,HumanOmni-0.5B 模型的训练通过强化学习框架进一步优化。该过程以多模态输入数据(视频帧和音频流)为基础,模型生成候选回应并附带详细的推理过程。

推理过程中,模型解释如何整合视觉和听觉信息以得出情感预测。为了优化模型的预测准确性,设计了一个包含准确性奖励(Racc)和格式奖励(Rformat)的复合奖励函数。准确性奖励衡量预测情感是否与真实标签匹配,而格式奖励确保模型输出符合预定的格式要求。

在 RLVR 训练阶段,结合准确性奖励和格式奖励的复合奖励函数能够有效地引导模型提高情感识别的准确性,并确保输出格式的规范性。

实验结果显示,RLVR 框架下训练的模型在情感识别任务中取得了显著的性能提升,特别是在多模态数据融合方面,模型能够更好地整合视觉与听觉信息,做出更精确的情感预测。

Shanghai AI Lab: MM-EUREKA

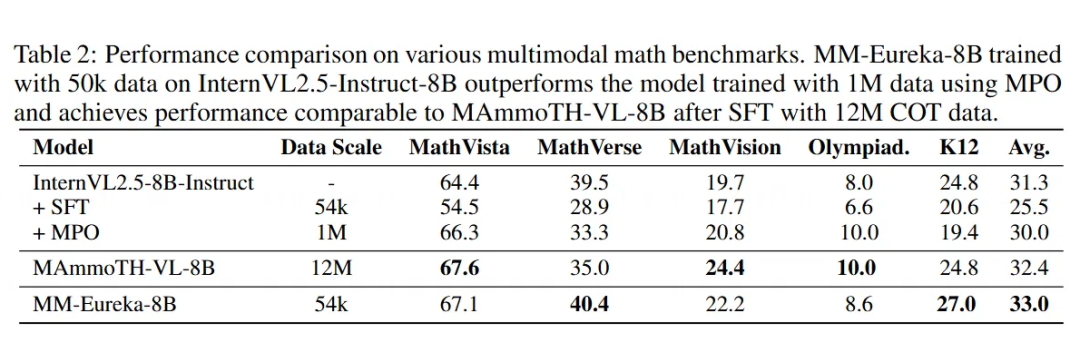

本文旨在研究大规模 RL 在多模态推理中的有效性,并且开源了完整的训练流程和模型。研究表明,通过基于规则的 RL,无需监督微调(SFT),指令调优和预训练模型均能开发出强大的多模态推理能力。此外,与其他后训练方法相比,MM-Eureka 表现出了卓越的数据效率和竞争力。文章的主要贡献包括:

-

提出了基于 Open-RLHF 的多模态大规模强化学习框架,支持多种模型并增强了可扩展性,能够训练更大的模型;

-

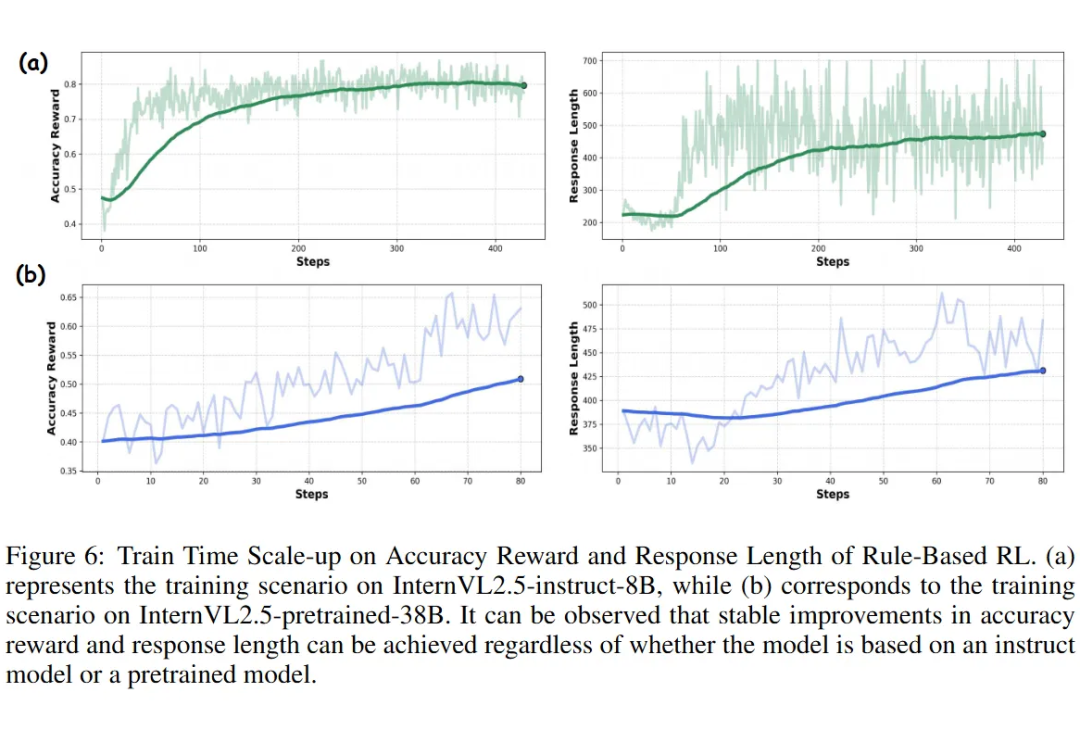

构建了多模态推理模型 MM-Eureka-8B 和 MM-Eureka-Zero-38B,二者均能表现出“视觉 Aha 时刻”,并在推理过程中实现精度奖励和响应长度的稳步增长;

-

通过实验展示,简单的基于规则的 RL 相比其他后训练方法(如 MPO 和 SFT)具有显著的数据效率优势,且在多个基准任务上取得了优异的表现。

3.1 方法部分

为了进行实验,文章选择了 InternVL2.5 作为基础模型,因为它提供了多种模型规模,适合用于规模化实验。通过使用强大的基础模型,能够系统性地研究在强化学习(RL)中扩展的影响。

RL 算法与 DeepSeek-R1 类似,使用基于规则的奖励(如准确性奖励和格式奖励)进行训练。此外,构建了一个基于 OpenRLHF 的多模态输入 RL 框架,支持不同模型规模的训练,兼容如 InternVL 等常用模型。

3.1.1 数据集

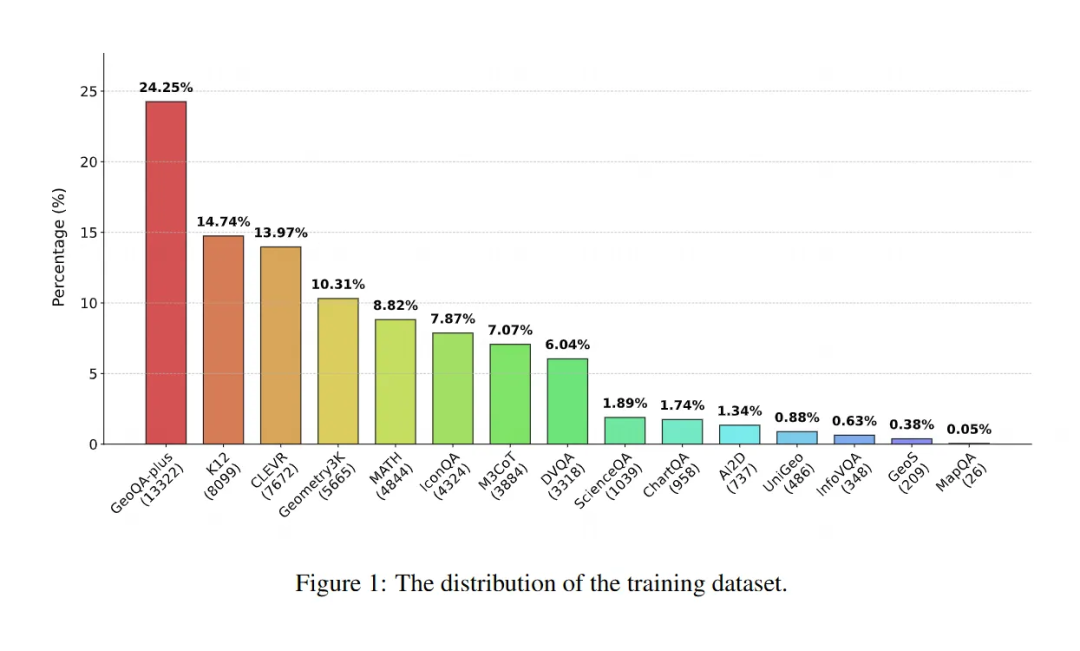

数据集构建过程中,文章主要依赖开源数据,结合人工收集的 K-12 水平数学推理问题,增强数据的推理特性。数据清洗的过程包括:

数据收集:从多个开源数据集(如 GeoQA、ChartQA、MATH 等)收集具有数学推理属性的数据。同时,人工收集了 K-12 级别的多模态数学推理问题,共收集了 75514 个样本,涵盖多个关键类别,如图表理解、科学推理和数学推理等。

数据过滤:采用两步过滤策略剔除低质量数据。首先,排除没有明确答案的问题和难以解析的多选题;其次,使用 InternVL2.5-8B-Instruct 模型生成每个问题的 8 个答案,通过准确度评估问题的难度,并去除准确度为 0 或 1 的样本,确保 RL 训练过程的稳定性。

3.1.2 奖励函数

基于 DeepSeek-R1,文章采用了简单的基于规则的奖励函数,而非使用结果或过程奖励模型,从而避免了奖励欺骗问题。具体而言,使用两种奖励:

准确性奖励:通过 math-verify 库从模型输出中提取答案,并与参考答案进行比较,若匹配则返回 1,否则返回 0。

格式奖励:检查模型输出是否符合规定的格式(例如:<think>…</think><answer>…</answer>),符合则返回 1,否则返回 0。

最终奖励由准确性奖励和格式奖励加权求和而得,其中格式奖励的贡献通过 λ 进行调整。实验表明,这种简单的稀疏奖励足以显著提高模型的多模态推理能力。

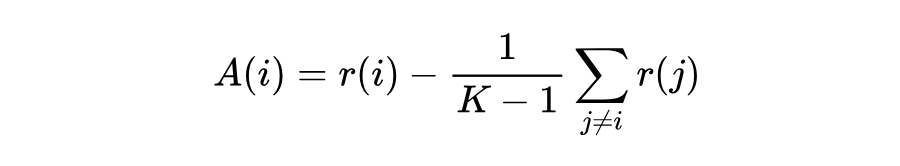

3.1.3 优势估计与策略更新

在强化学习训练阶段,文章采用了 REINFORCE Leave-One-Out(RLOO)算法。与 GRPO 算法类似,RLOO 算法无需使用评论家模型,从而有效降低了训练成本。此外,RLOO 算法通过留一法基准来减少策略梯度估计中的方差。优势估计的计算公式为:

对于 actor loss,采用了 PPO-clip 损失(PPO-clip loss),以避免在更新过程中产生过大的偏差,保持训练的稳定性。

3.1.4 关键发现

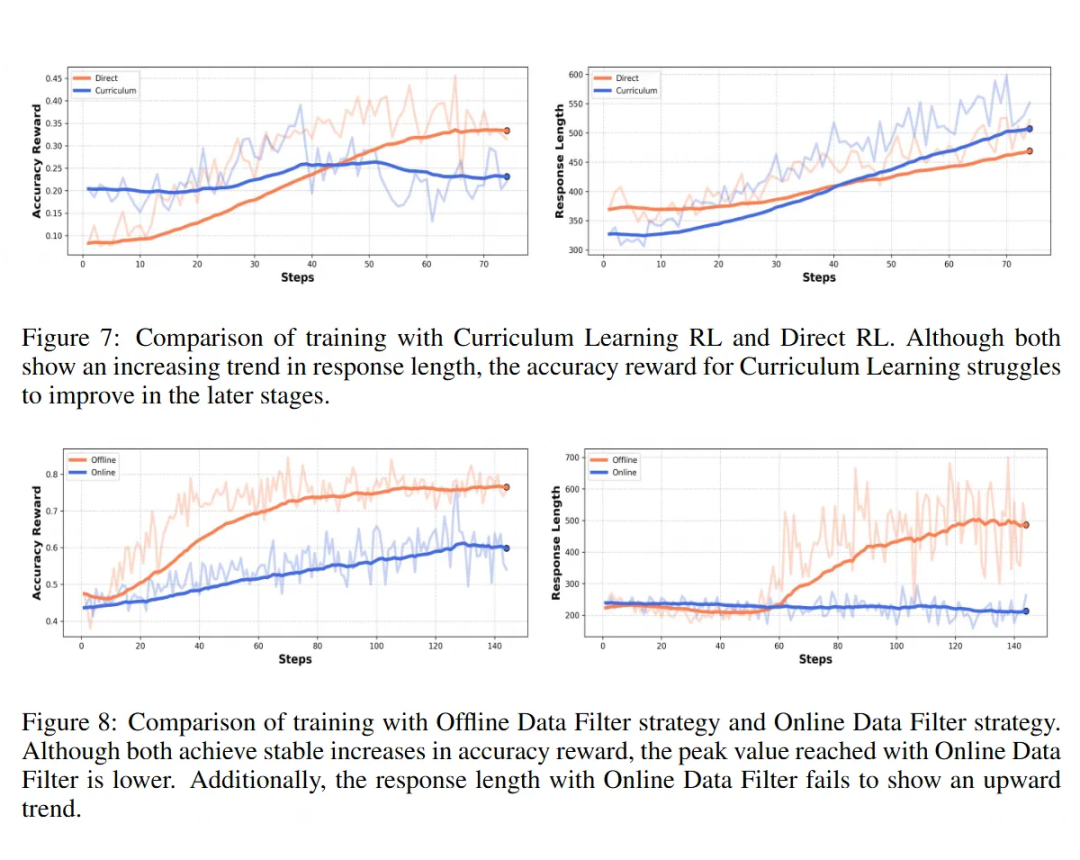

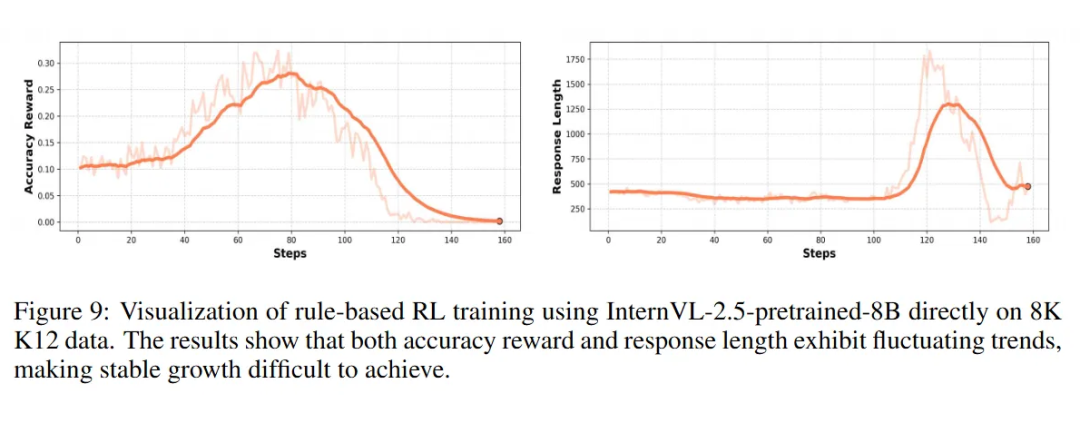

数据过滤对稳定训练的重要性:数据过滤对多模态推理中的稳定 RL 训练至关重要。通过对比有无数据过滤的训练结果,发现未经过滤的数据训练非常不稳定,准确性奖励呈波动趋势,响应长度呈下降趋势。

这表明,包含错误答案的数据会导致奖励的不稳定,使学习变得困难。

简单的 RL 训练设置足够有效:实验发现,最简单的训练设置(不使用 KL 散度)同样能够有效复现 DeepSeek-R1 在多模态推理中的推理模式。尽管之前的研究表明,保持 KL 散度有助于防止模型在训练过程中过度优化奖励,导致语言模式的退化。

但本文的结果表明,当从指令调优模型开始微调时,省略KL散度不仅能减少训练的计算成本,还能保证响应长度的稳定增长。

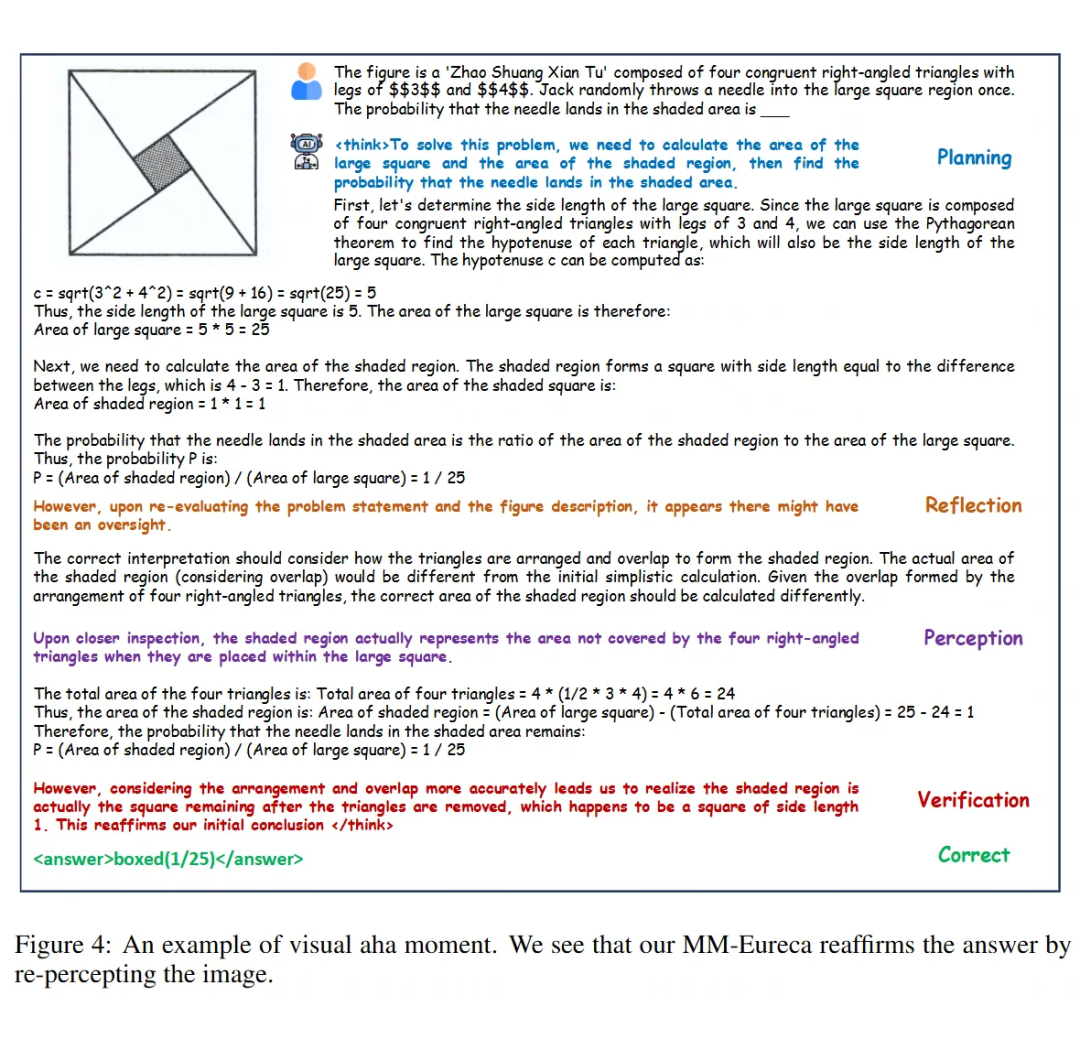

视觉 Aha 时刻:通过基于规则的 RL 训练,模型在多模态推理场景中表现出了类似的反思和验证行为(例如 “Aha 时刻”)。实验中发现,模型在推理过程中会重新感知图像并检查中间步骤,通过这种反思行为,模型能够纠正之前的错误,并通过验证步骤得到正确答案。

这种行为表明,模型不仅在数学问题中能展现出类似的思维模式,对于视觉常识问题和图表理解任务,模型也表现出了延伸的思维过程,包含了反思和类似的操作。

3.2 实验部分技术细节

模型训练设置

-

对于 instruct 模型和预训练模型,采用了不同的提示策略。在 instruct 模型中,保留了内建的系统提示,并将格式相关的信息包含在用户提示中。相比之下,基于 DeepSeek-R1-Zero 方法的 base 模型,则是在系统提示中直接提供格式信息。

-

在强化学习设置中,对于两种模型,格式奖励的系数有所不同。由于 instruct 模型具有更强的指令遵循能力,格式奖励系数设为 0.5;而对于 base 模型,考虑到其较弱的指令遵循能力,格式奖励系数设为 1.0,以鼓励其更严格地遵循指定的响应结构。

训练超参数设置

-

rollout 批次大小设为 128,训练批次大小设为 64,每个样本生成 8 个 rollouts。模型生成温度设为 1,不计算 KL 散度。

-

对于 8B 模型,学习率设为 3e-7;对于 38B 模型,学习率设为 5e-7。

后训练策略

-

SFT:直接使用强化学习数据进行 SFT 训练,按照 InternVL2.5 的默认设置训练 1 个 epoch。

-

COT SFT:由于收集的数据不包含 COT 注释,作为基线使用 MAmmoTH-VL-8B 模型进行 COT SFT 训练。

-

MPO:由于缺乏负例数据,使用 MMPR 进行 MPO 训练,以作为基线。

数据集和基准评估

-

文章使用了多个基准数据集进行评估,如 MathVista、MathVerse、MathVision 和 OlympiadBench,这些数据集涉及视觉问答、几何推理等任务。

-

还引入了新的 K12 数学数据集,评估模型解决中学到高中级别数学问题的能力。

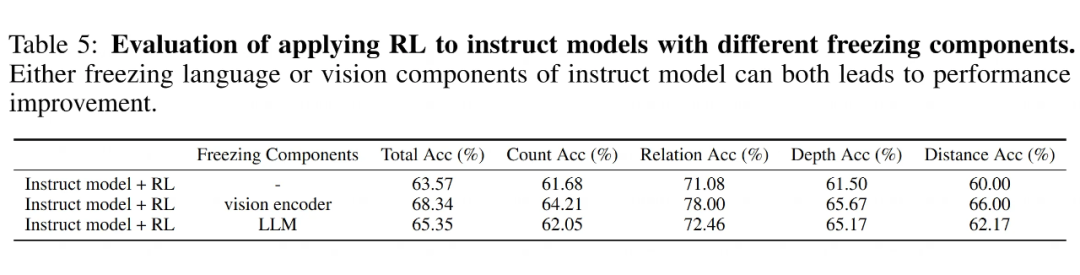

训练策略与实验

-

RL from Instruct Model:在 InternVL-8B-Instruct 模型上应用基于规则的 RL 训练,训练过程中不仅提高了准确性奖励,还增加了响应长度,从而提升了推理能力和整体表现。

-

RL from Pretrained Model:在 InternVL-38B-Pretrained 模型上进行 RL 训练,即使数据量较少(9.3K 数据样本),也取得了显著的性能提升,尤其是在 K-12 基准上提高了 8.2% 的准确性。

3.3 实验部分有趣的实验发现

不同后训练策略的比较

-

SFT:直接用强化学习数据进行训练,与传统的 SFT 方法相比,效果较为平稳,但性能提升较慢。

-

COT SFT:通过使用大量 COT 注释数据,取得了显著的性能提升,尤其在多模态数学推理任务上。

-

MPO:使用 MPO 方法进行训练时,尽管使用了更多的数据样本(1M 数据),但效果相对较为逊色。

训练过程中性能提升

-

在规则强化学习的训练过程中,无论是在 instruct 模型还是预训练模型上,随着训练的进行,准确性奖励和响应长度都呈现出稳定的增长趋势。

-

尽管训练数据量较小,38B 预训练模型的 RL 训练仍显著提高了性能,特别是在 K-12 任务中的表现。

数据过滤策略的实验

-

离线数据过滤(Offline Data Filter):这种方法能够稳定训练过程,但在数据利用效率上有所浪费。

-

在线数据过滤(Online Data Filter):尽管这种方法增强了训练稳定性,但未能显著提高准确性奖励或响应长度,主要是由于训练过程中的梯度不稳定。

模型规模的影响

-

在多模态推理任务中,较小的模型(如 8B)无法保持稳定的规则强化学习训练,尤其在精确度奖励和响应长度方面表现波动较大。

-

相比之下,较大的 38B 模型则能在相同数据条件下保持稳定训练,且性能提升更加明显。

小红书:Vision-R1

本文提出了 Vision-R1,旨在通过结合冷启动初始化和强化学习(RL)训练来提高推理能力。

当前,传统的推理方法通常依赖简单的直接预测,缺乏明确的推理步骤,因此在复杂推理任务中往往表现不佳。尽管近年来有研究尝试通过链式思维(CoT)提升 LLMs 的推理能力,但在多模态任务中,现有的技术仍然难以产生复杂的推理过程。

为了解决这一问题,文章提出了一种新的方法,通过数据生成和强化学习,使得多模态模型能够自我发展出复杂的推理能力。

文章的主要贡献包括:

-

提出了 Vision-R1,这是一种结合冷启动初始化和 RL 训练的多模态推理模型。该模型是首个通过 RL 增强 MLLM 推理能力的探索性工作。

-

通过模态桥接和数据过滤技术,构建了一个 200K 样本的高质量多模态 CoT 数据集,作为 Vision-R1 的冷启动初始化数据。

-

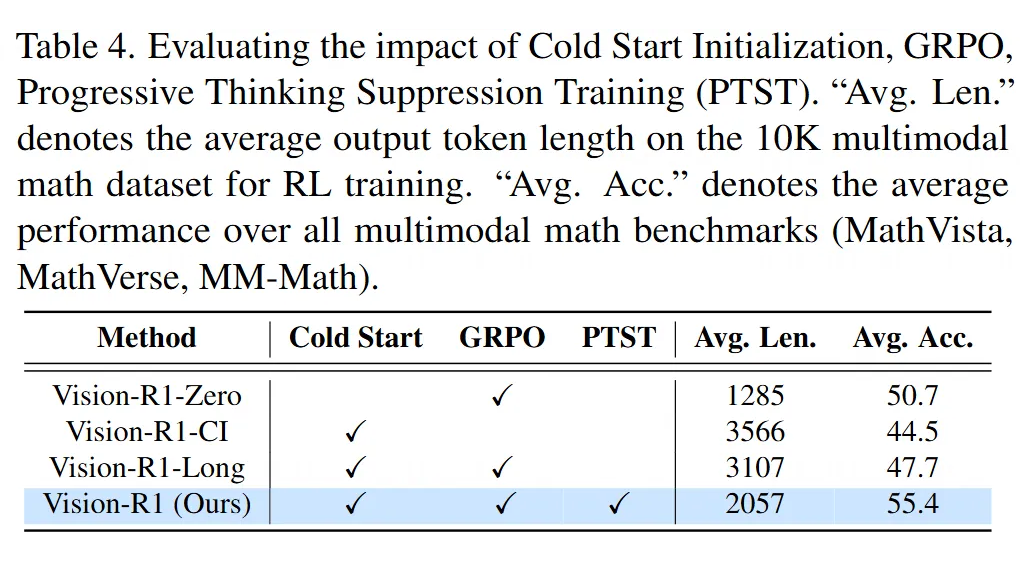

提出了渐进式思维抑制训练(PTST)策略,配合 Group Relative Policy Optimization(GRPO)算法,有效解决了冷启动初始化后模型的“过度思考”问题,推动了模型推理能力的逐步提升。

4.1 方法部分

4.1.1 直接使用强化学习(RL)是否能激励MLLMs的推理能力?

文章的初步实验尝试了通过直接使用 RL 来激励多模态大语言模型(MLLMs)发展出复杂的推理能力。

实验中使用了 10K 个开源数学问题数据集,并采用了 DeepSeek-R1-Zero 的训练流程,使用 Group Relative Policy Optimization(GRPO)算法进行训练。奖励函数包括格式奖励和结果奖励:

-

格式奖励:模型输出必须符合 <think> </think><answer> </answer> 的格式要求。

-

结果奖励:模型生成的最终结果必须与地面真值匹配。

经过纯 RL 训练的模型被命名为 Vision-R1-Zero。然而,实验发现,直接将 RL 应用于训练 MLLMs 并不能有效激发复杂的 CoT 推理,模型在生成长且复杂的推理链时出现了性能下降。

因此,作者提出,直接使用 RL 来激励 MLLMs 的推理能力仍然面临很大挑战,尤其在数据质量、数量和计算资源的限制下。

4.1.2 Vision-R1 的概述

为了解决上述问题,文章提出了 Vision-R1,这是一种结合冷启动初始化和强化学习(RL)训练的多模态推理模型。该模型首先通过冷启动初始化,使用一个多模态 CoT 数据集来训练基础模型,使其学习“类人”的推理方式。之后,通过 RL 训练来引导模型采用正确的推理过程,从而进一步激励模型的推理能力。

4.1.3 冷启动初始化

Vision-R1 的训练首先依赖于冷启动初始化,这一过程通过构建一个高质量的多模态 CoT 数据集来实现。

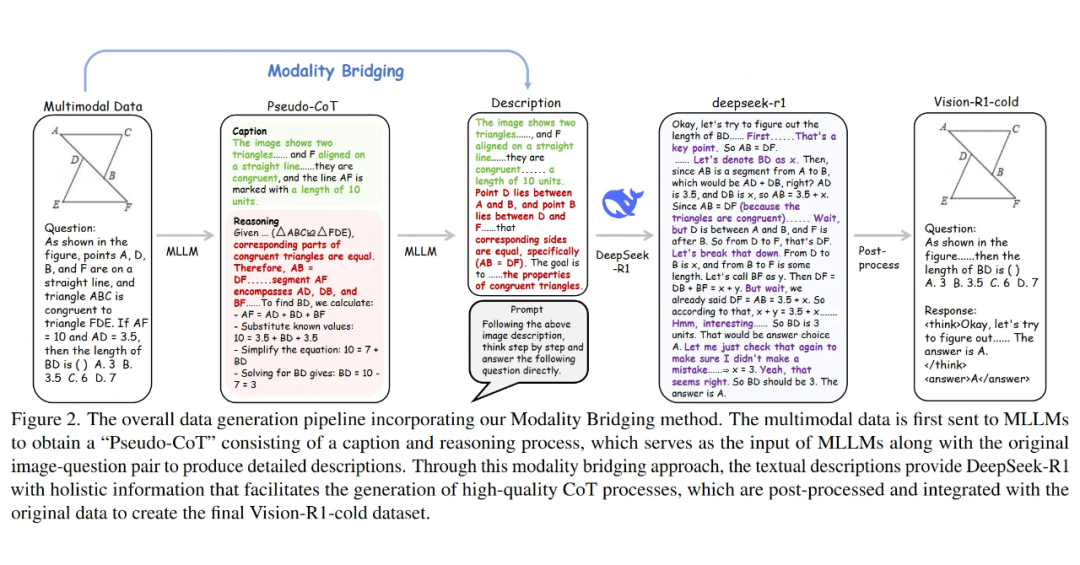

在此过程中,使用现有的多模态大语言模型(MLLM)和 DeepSeek-R1,结合模态桥接技术,将多模态信息转化为文本信息,从而生成“伪 CoT” 推理文本。这些文本包含了详细的视觉描述和推理过程,帮助模型学习更复杂的推理任务。

模态桥接:

-

利用现有的 MLLM 和 DeepSeek-R1,先通过输入图像-问题-答案对生成“伪 CoT” 推理文本,接着将这些文本与图像信息结合,最终生成高质量的推理过程。通过这种方法,将视觉信息转换为文本描述,使模型能够从中提取更丰富的推理信息。

通过这种方式,最终获得的 Vision-R1-cold 数据集包含了 200K 个多模态人类级复杂 CoT 推理样本,作为 Vision-R1 的冷启动初始化数据。

4.1.4 过度思考优化问题

在 Vision-R1 的冷启动初始化过程中,作者发现模型倾向于在某些问题上进行过长的推理过程,而正确的推理过程通常集中在较短的推理链中。这一现象被称为“过度思考优化问题”,即模型在处理复杂问题时,尽管推理链的长度增加,但错误的推理并没有带来性能的提升。

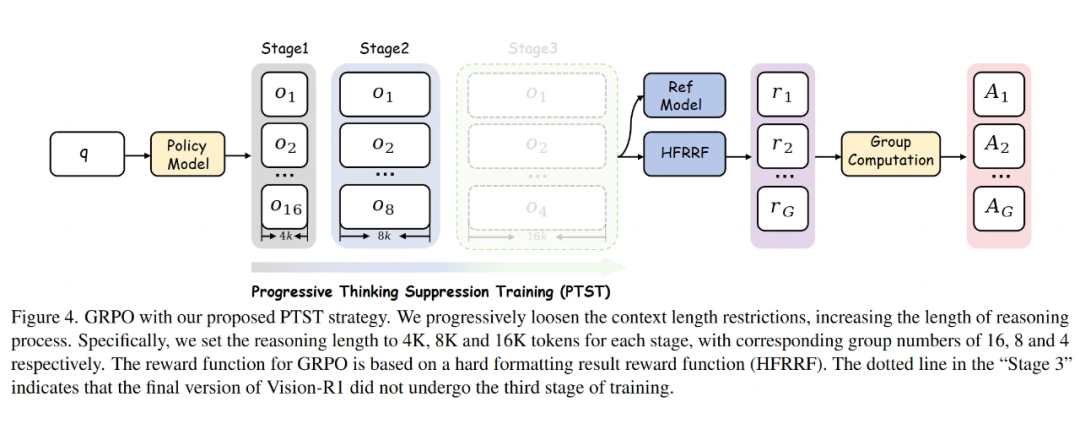

4.1.5 渐进式思维抑制训练(PTST)

为了解决过度思考问题,文章提出了渐进式思维抑制训练(PTST)策略。在 RL 训练的早期阶段,通过限制推理长度来引导模型学习正确的推理方法。

随着训练的进行,逐步放宽这些限制,让模型自我学习如何使用更长的 CoT 推理来解决更加复杂的问题。PTST 结合了 GRPO 和硬格式结果奖励函数,帮助 Vision-R1 逐步提升推理能力。

GRPO 与 PTST 的实施:

-

在训练过程中,PTST 通过限制推理的长度,确保模型能在较短的推理链上掌握正确的思维方式,而随着训练的推进,逐步增加推理链的长度,从而帮助模型处理复杂的推理任务。

-

GRPO 则通过对生成的多个输出进行比较和优化,帮助模型在多个样本中选择最优的推理路径。

4.2 实验部分

4.2.1 实验设置

数据集和基准测试:为了获取冷启动数据集,文章使用了多模态视觉问答(VQA)数据集、LLaVA-CoT 数据集(100K)和 Mulberry 数据集(260K),并结合这些数据集构建了 Vision-R1-cold 数据集(200K)。

在 GRPO 训练过程中,使用了多个数学数据集,包括 We-Math、MathVision、Polymath、SceMQA 和 Geometry3K,作为 RL 训练数据,总数据量约为 10K。

评估基准:为了评估 Vision-R1 的推理能力,选择了三个广泛使用的多模态数学基准:MM-Math、MathVista 和 MathVerse,这些基准覆盖了多种数学领域,有助于全面评估 MLLM 的数学推理能力。

此外,还选取了四个通用的多模态基准(MM-Star、ChartQA、MME 和 HallBench)来展示模型的通用能力。

实现细节:Vision-R1-cold 数据集的准备使用了 128 个 NVIDIA H800 80G GPU,部署了开源 MLLM Qwen-2.5-VL-72B 和推理 LLM DeepSeek-R1,约 2 天内处理了 VQA 数据集。

对于 Vision-R1-7B 的冷启动初始化,使用 Qwen-2.5-VL-7B-Instruct 作为基础模型,通过监督微调(SFT)在 32 个 NVIDIA H800 80G GPU 上进行 2 个 epoch 的训练。冷启动初始化后,得到了 Vision-R1-CI-7B 模型,随后通过 GRPO 在 64 个 NVIDIA H800 80G GPU 上进行训练,约 2 天。

模型概述:

文章中提到的各模型如下:

-

Vision-R1-Zero:直接将 RL 应用于基础 MLLM,无冷启动初始化。

-

Vision-R1-CI:基础 MLLM 通过 Vision-R1-cold 数据集进行冷启动初始化。

-

Vision-R1-Long:将生成长度最大为 16K tokens 的模型,经过 300 步训练。

-

Vision-R1:采用渐进式思维抑制训练(PTST)策略,应用两阶段 RL 训练过程。

4.2.2 主要结果

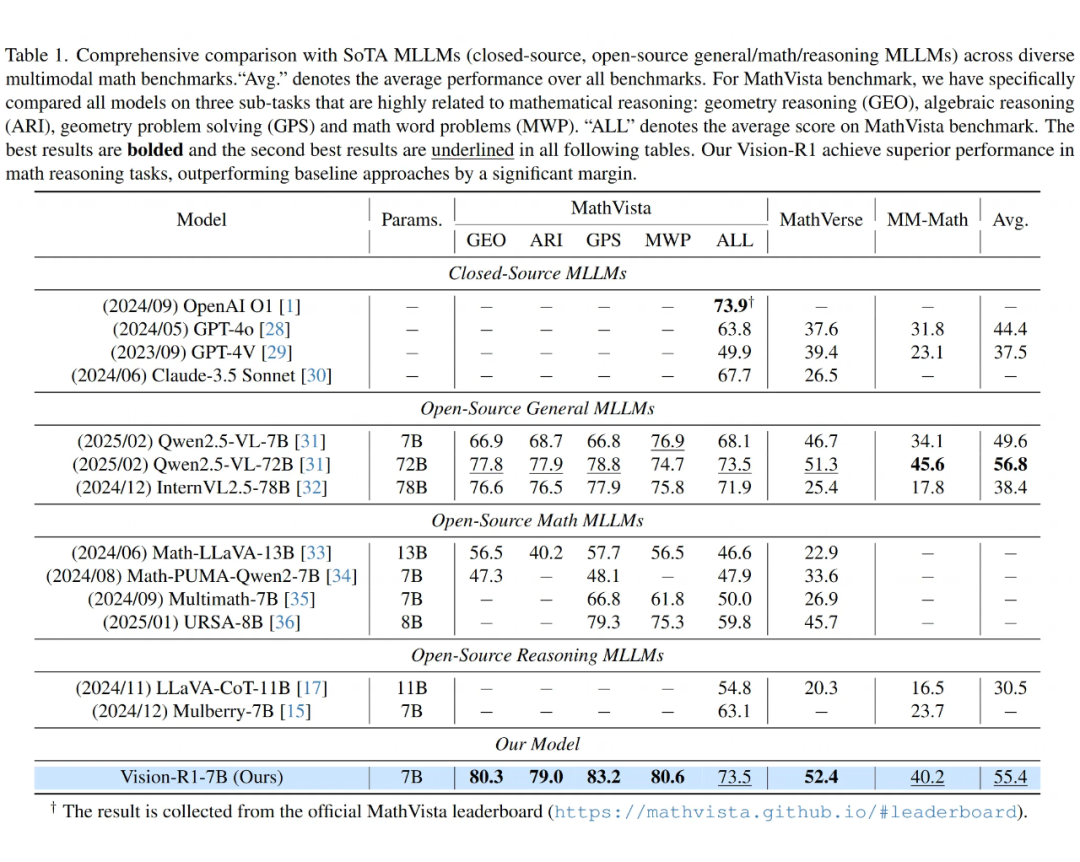

数学推理:在多个数学推理基准上,Vision-R1-7B 表现出色,尤其是在 MathVista 基准测试上,Vision-R1-7B 的得分为 73.5%,仅比领先的推理模型 OpenAI O1 低 0.4%。

在 MathVista 的复杂数学推理子任务(几何推理、代数推理和几何问题解决)中,Vision-R1-7B 分别达到了 80.3%、79.0% 和 83.2% 的得分,平均准确率比基础模型 Qwen-2.5-VL-7B 提高了超过 10%。

在更具挑战性的 MathVerse 和 MM-Math 基准上,Vision-R1-7B 分别排名第一和第二,证明了其解决复杂数学问题的有效性。

冷启动数据集质量:通过对 Vision-R1-cold 数据集的质量分析,发现该数据集与现有的多模态 CoT 数据集相比,显著提高了认知自我反思和检查的比例。这些复杂的 CoT 结构有助于基础 MLLM 学习推理机制,从而为后续的 RL 训练提供了高质量的冷启动初始化数据。

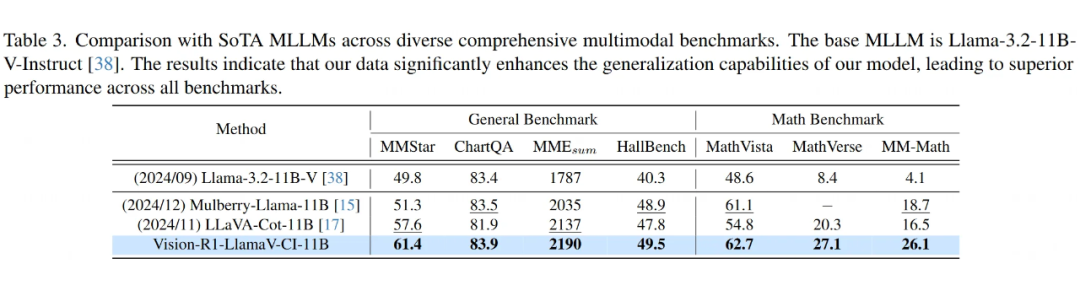

Vision-R1-LlamaV-CI-11B 模型在 SFT 后的表现超过了 LLaVA-CoT-11B 和 Mulberry-Llama-11B,特别是在 MM-Math 基准上,Vision-R1-LlamaV-CI-11B 比 Mulberry-Llama-11B 提高了 7.4% 的准确率,验证了 Vision-R1-cold 数据集的优越性。

消融实验:通过对不同 RL 训练策略的比较,结果显示,Vision-R1-Zero(直接使用 RL 训练而不进行冷启动初始化)在生成长且复杂的 CoT 推理时表现不佳,限制了其处理复杂推理任务的能力。

而 Vision-R1-CI 则倾向于生成过长的 CoT 推理,尽管推理链长度增加,但却未能提高性能。相比之下,Vision-R1 模型能够有效平衡 CoT 复杂性和准确性,在推理表现上具有显著优势。

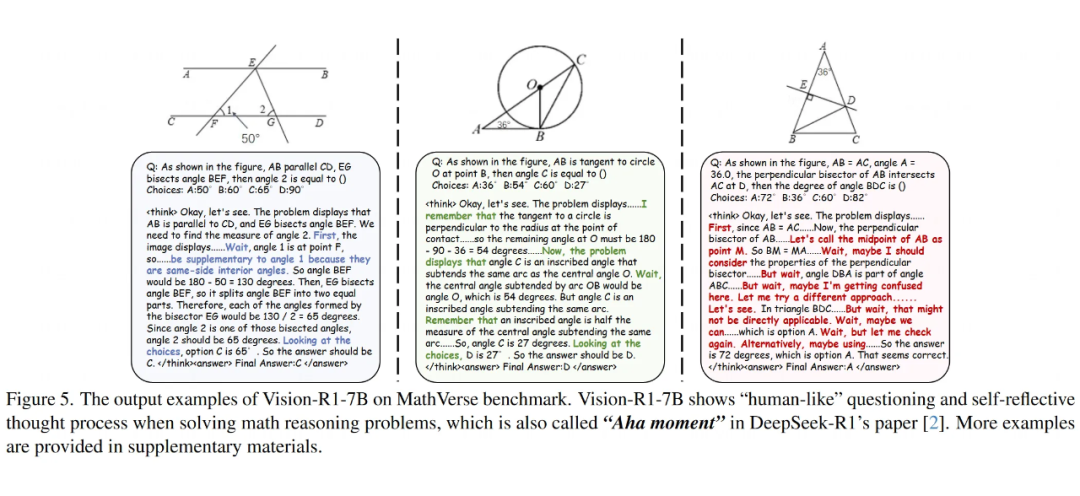

可视化:通过对 Vision-R1-7B 的可视化分析,发现该模型能够生成复杂的推理过程,并且展示了类似于人类认知过程中的“顿悟时刻”(Aha moment)现象,即通过反思和检查,模型能够逐步改进推理路径。这种复杂的推理能力显著提高了模型的推理性能,使其能够在复杂推理任务中取得优异的成绩。

4.3 动机与主要贡献

现有工作尝试将这种成功扩展到多模态推理时,通常无法复制这些关键特性。本文的动机就是在非 SFT 的 2B 模型上,首次成功地复现这些多模态推理任务中的关键特性,尤其是“顿悟时刻”和推理长度的增加。

主要贡献:

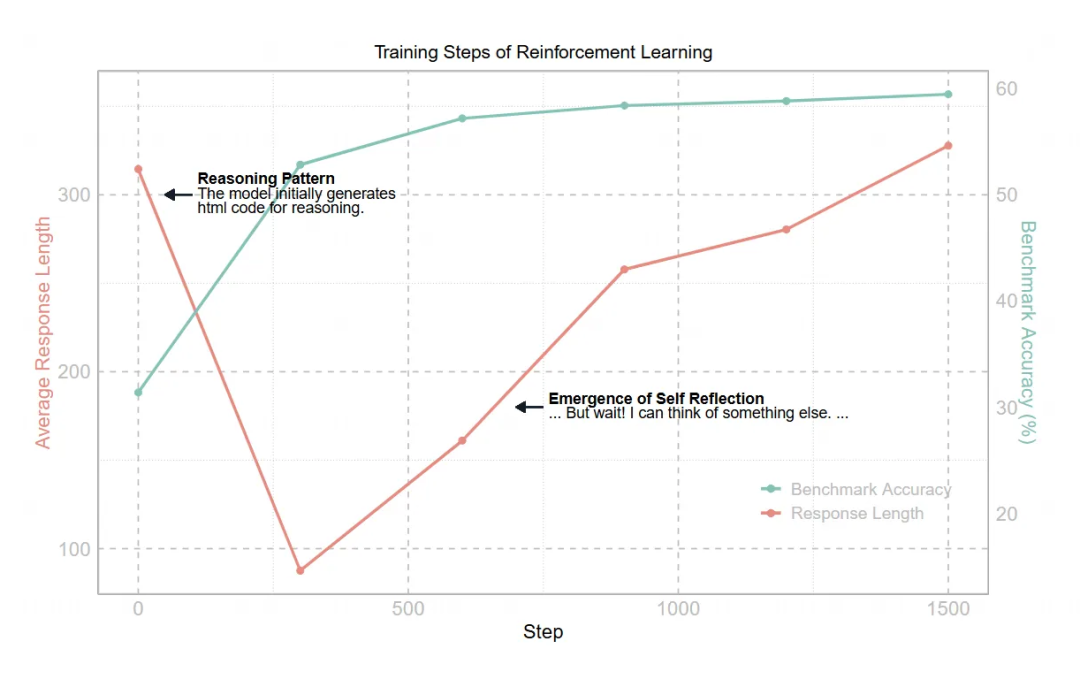

首次在非SFT 2B模型上复现“顿悟时刻”和推理长度增加:通过直接在 Qwen2-VL-2B 模型上应用强化学习,成功复现了多模态推理中的“顿悟时刻”现象,并观察到推理长度和准确度之间的正相关关系。

多模态推理任务中的推理能力提升:在直接应用强化学习进行多模态推理任务时,模型在 CVBench 上的准确率达到了 59.47%,比基础模型提高了约 30%,并且比 SFT 模型高出约 2%。

揭示了 SFT 模型的局限性:通过比较不同模型的实验,发现直接在 SFT 模型上应用强化学习时,往往产生表面的推理过程,而缺乏真正的复杂问题解决策略。

开放源代码:为便于社区进行进一步研究,文章还开源了该项目的代码,促进多模态推理的研究发展。

VisualThinker-R1-Zero

5.1 方法

基础模型:该方法以 Qwen-2-VL-2B 为基础模型,应用 GRPO 算法和定制的聊天模板与提示策略来增强模型的推理能力。与在指令微调模型上进行训练的方式不同。与指令微调的 Qwen-2-VL-2B-Instruct 模型相比,该方法消耗的训练资源明显较少,同时能够在推理过程中成功复现 DeepSeek-R1 所观察到的“顿悟时刻”。

训练流程:模型直接在 SAT 数据集上进行训练,让基础模型探索每个问题的空间推理。每个问题的聊天模板如下:

A conversation between User and Assistant. The user asks a question about the image, and the Assistant solves it. The assistant first thinks about the reasoning process in the mind and then provides the user with the answer.

User: {QUESTION}

Assistant: Let me solve this step by step.

<think>

模型根据这个模板生成响应,并使用 GRPO 进行优化。

奖励建模:与 DeepSeek-R1 类似,采用简单的基于规则的奖励函数,避免使用复杂的奖励模型或蒙特卡罗树搜索(MCTS)等技术。具体的奖励方式如下:

-

如果响应提供了正确的最终答案,则模型获得 +1 的准确性奖励。

-

如果响应将思考过程包裹在 <think></think> 标签中,并且最终答案在 <answer></answer> 标签内,则模型获得 +1 的格式奖励。

-

其他情况下,模型不会获得奖励。

实验表明,这种奖励函数能够帮助策略模型快速收敛到生成符合预期格式的响应。

5.2 实验设置与结果

目标与数据集:该研究旨在展示通过 RL 训练,小型非 SFT 模型如何解决视觉中心的空间推理任务,这类基准任务通常对更大的模型来说也具有挑战性。

实验使用了 SAT 数据集,包含 218k 个问题-答案对,问题通过照片级物理引擎合成,旨在增强空间智能。训练主要集中在静态子集,包括相对空间关系、深度关系和物体计数等问题。

评估方法:为了测试方法的泛化能使用了 CVBench 基准,这是一项包括 2638 个实例的视觉中心基准,旨在评估二维和三维推理任务,涉及空间关系、物体计数、深度排序和相对距离等。该设置能够系统地检验训练方法在空间推理能力上的提升。

实验实现细节:所有实验都使用四块 NVIDIA H100 GPU(每块 80GB),每个设备的批量大小设置为 1。模型训练 1500 步,学习率为 1 × 10-6,温度为 1.0。为了在训练过程中观察到响应长度的增加,最大响应长度设置为 700。在 GRPO 优化过程中,每步采样 8 个响应,并使用 KL 系数 0.04。

主要结果

在实验中,Qwen2-VL-2B 非 SFT 模型经过微调后,我们在 CVBench 上的评估结果显示,模型自发地展现了增加响应长度的趋势,同时表现也随之提高。与 SFT 方法相比,直接在基础模型上应用RL获得了更优的性能。

此外,我们还在多个空间推理数据集(如 BLINK 和 VSR)上进行了测试,结果表明,我们的方法在 CVBench 上相较于Qwen2-VL-2B(基础模型)提高了约 30%,相较于 Qwen2-VL-2B SFT 模型提高了约 2%。在 BLINK 和 VSR 基准上,我们的方法也表现优异,相较于 SFT 训练的模型,提升了约 27%。

多模态“顿悟时刻”:在训练过程中,我们观察到了与 DeepSeek-R1 相似的“顿悟时刻”现象。模型在训练中会自发地重新审视其先前的判断并探索其他选择。这表明,RL 训练能够促进模型自发产生推理策略,不仅是简单的学习答案,而是通过反思和自我纠错来逐步提升推理能力。

关于 RL 应用于 SFT 模型的挑战:尽管从零开始使用非 SFT 模型取得了成功,但当我们尝试将 RL 应用于经过 SFT 的模型时,遇到了一些问题。

尤其是,在 SFT 模型上应用 RL 时,常常导致推理变得肤浅,出现了“平庸推理轨迹”。例如,在回答问题时,模型可能只是简单地复制标准的回答模式,缺乏深入的推理。

我们发现,虽然 RL 训练可以改善 SFT 模型的表现,但并未显著提高推理能力。我们还尝试冻结视觉编码器或语言模型来改进训练结果,虽然性能有所提升,但仍未能解决推理深度的问题。

长度奖励的尝试与失败:我们还尝试通过引入长度奖励来鼓励生成更长的响应,然而,简单的长度奖励机制并未带来推理能力的提高,反而引发了模型生成无意义的长响应的现象,这表明增加响应长度并不能自动提升推理能力。

总结:本研究展示了 VisualThinker-R1-Zero 如何通过 RL 训练,在非微调的 Qwen2-VL-2B 模型上成功复现了 DeepSeek-R1 的“顿悟时刻”和响应长度增加的现象。通过 RL 训练,模型在 CVBench 上取得了 59.47% 的准确率,超过了基础模型和 SFT 模型的表现。

此外,本文还揭示了将 RL 应用于 SFT 模型时的一些问题,包括推理模式的肤浅化以及简单长度奖励机制的无效性。这个研究是一个持续更新的工作,未来将进一步探讨和优化这些方法。

主流的实验发现

6.1 RL 在多模态模型中的集成应用

框架如 LMM-R1、R1-Omni 和 MM-Eureka 都强调了使用基于规则的 RL 来避免灾难性遗忘,并在没有监督微调(SFT)的情况下提升数据效率。这种方法特别适用于数据稀缺的多模态推理任务。

除了传统的数学和几何推理,多模态 RL 方法正被应用于视频情感识别、代理决策(如 Sokoban、足球比赛)、空间推理等更复杂的任务场景。整体上,方法正在从单一文本任务向跨模态、动态任务扩展,显示出广泛的适用性和较高的鲁棒性。

6.2 数据与训练策略的重要性

Shanghai AI Lab 的 MM-EUREKA:通过数据过滤、简单奖励设计和 REINFORCE Leave-One-Out(RLOO)算法,证明了即便不引入复杂的奖励模型,基于规则的RL也能有效提升多模态推理能力,且数据过滤在稳定训练中起到了关键作用。

小红书的 Vision-R1 系列:通过冷启动初始化结合 RL 训练,并引入渐进式思维抑制训练(PTST),解决了直接 RL 训练中“过度思考”问题,使得模型能平衡推理链的复杂性与答案准确率。

6.3 模型规模与训练方法的影响

大模型优势:38B 模型在相同数据量下训练更稳定(MM-EUREKA),而 8B 模型易波动。

小模型潜力:2B 模型通过 RL 实现 30% 性能提升(VisualThinker),但需避免 SFT 导致的推理浅层化。

一些还比较矛盾的实验讨论

7.1 是否需要 KL 散度约束

部分实验(如 MM-EUREKA):在强化学习训练中省略 KL 散度不仅降低了计算成本,还保证了响应长度的稳定增长,并能有效提升推理性能。

传统观点及部分工作:此前的研究普遍认为,引入 KL 散度可以防止模型过度优化奖励,避免语言模式退化,从而保持生成质量。

7.2 冷启动初始化与 RL 训练的效果

Vision-R1 的实验表明,冷启动初始化结合 RL 训练有效地解决了多模态推理中的“过度思考”问题,模型能够在更复杂的推理任务中稳定表现。

但是其他的工作比如 VisualThinker-R1-Zero argue 了在 base 模型的基础上直接进行 RL 更容易得到更好的结果。

(文:PaperWeekly)