项目简介

腾讯混元发布视频生成大模型,千题盲测第一,现已全面开源

模型特点:

(1)超写实质感:模型生成的视频内容具备高清质感、真实感,可用于工业级商业场景例如广告宣传、创意视频生成等商业应用。

(2)高语义遵循:用户可以进行细致的刻画,例如生成主体的细节,人物概念的组合等。模型可以准确的表达出文本的内容。

(3)运动画面流畅:可生成大幅度的合理运动,运动镜头流畅、符合物理规律,不易变形。

(4)原生镜头转换:模型原生具备自动生成多视角同主体的镜头切换画面,增强画面叙事感。

我们推出了 HunyuanVideo,这是一种新颖的开源视频基础模型,其视频生成性能即使不优于领先的闭源模型,也可与领先的闭源模型相媲美。为了训练HunyuanVideo模型,我们采用了多项模型学习关键技术,包括数据管理、图像视频联合模型训练以及旨在促进大规模模型训练和推理的高效基础设施。此外,通过扩展模型架构和数据集的有效策略,我们成功训练了具有超过 130 亿个参数的视频生成模型,使其成为所有开源模型中最大的。

我们进行了大量的实验并实施了一系列有针对性的设计,以确保高视觉质量、运动多样性、文本视频对齐和生成稳定性。根据专业的人类评估结果,混源视频的性能优于之前最先进的模型,包括 Runway Gen-3、Luma 1.6 和 3 个表现最好的中国视频生成模型。通过发布基础模型及其应用的代码和权重,我们的目标是弥合闭源和开源视频基础模型之间的差距。这一举措将使社区中的每个人都能够尝试他们的想法,从而培育一个更具活力和活力的视频生成生态系统。

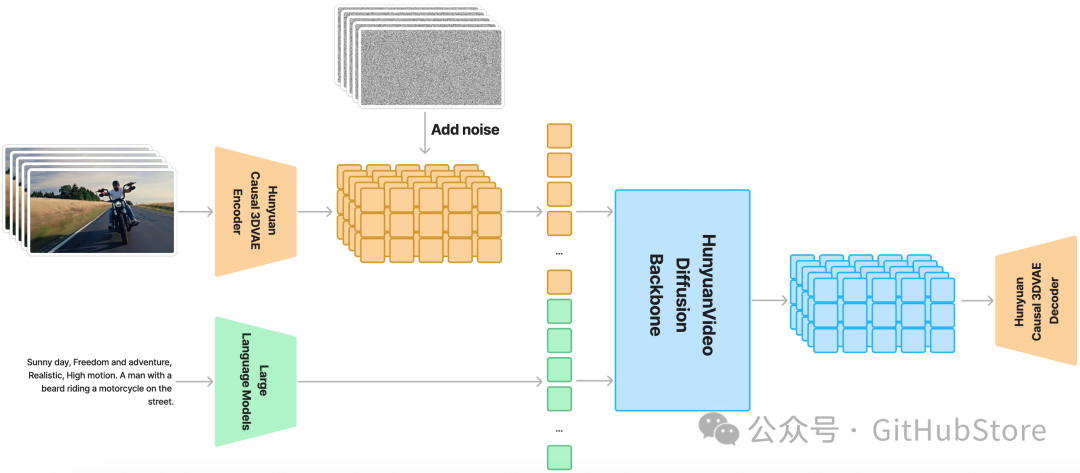

混源视频整体架构

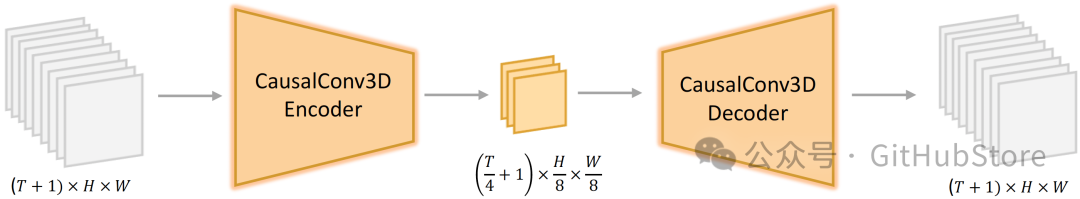

HunyuanVideo 在时空压缩的潜在空间上进行训练,该潜在空间通过 Causal 3D VAE 进行压缩。文本提示使用大型语言模型进行编码,并用作条件。将高斯噪声和条件作为输入,我们的生成模型生成潜在输出,通过 3D VAE 解码器将其解码为图像或视频。

🎉混源视频主要特点

统一图像和视频生成架构

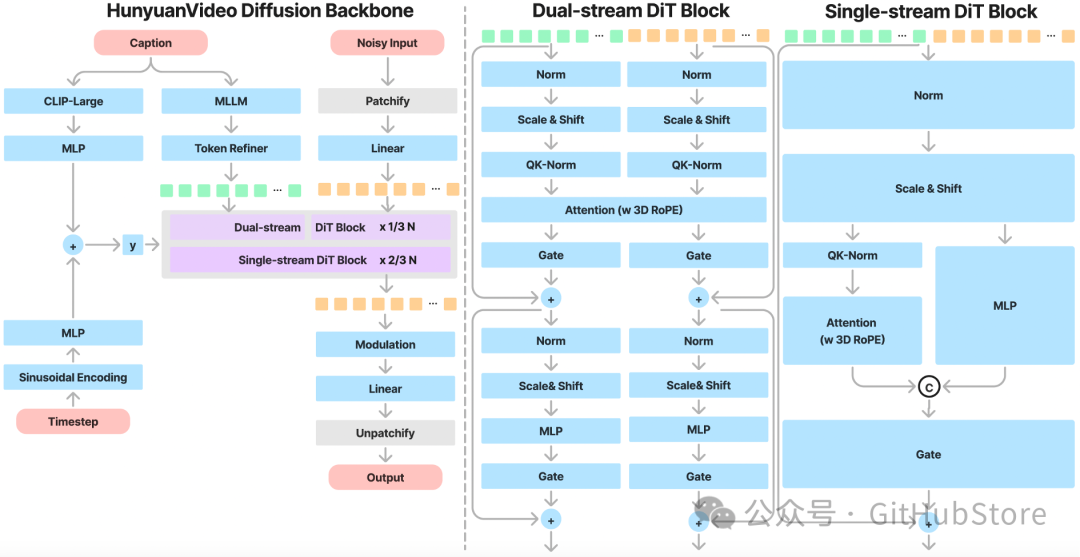

HunyuanVideo引入了Transformer设计,并采用Full Attention机制来统一图像和视频生成。具体来说,我们使用“双流到单流”混合模型设计来生成视频。在双流阶段,视频和文本标记通过多个 Transformer 块独立处理,使每种模态能够在不受干扰的情况下学习自己合适的调制机制。在单流阶段,我们将视频和文本标记连接起来,并将它们输入到后续的 Transformer 块中,以实现有效的多模态信息融合。这种设计捕获了视觉和语义信息之间的复杂交互,从而提高了模型的整体性能。

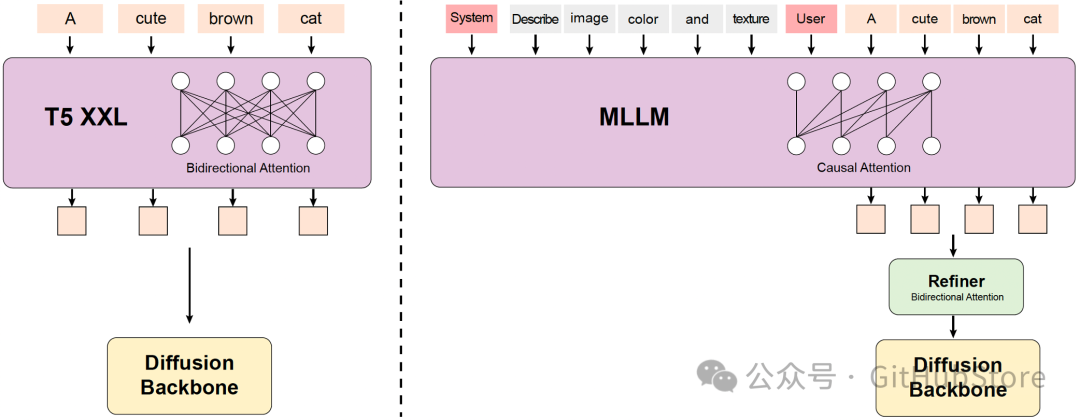

MLLM 文本编码器

之前的一些文本转视频模型通常使用预训练的 CLIP 和 T5-XXL 作为文本编码器,其中 CLIP 使用 Transformer Encoder,T5 使用 Encoder-Decoder 结构。相比之下,我们利用具有 Decoder-Only 结构的预训练多模态大语言模型(MLLM)作为我们的文本编码器,它具有以下优点:(i)与 T5 相比,视觉指令微调后的 MLLM 在图像文本对齐方面具有更好的图像文本对齐能力。特征空间,减轻了扩散模型中指令遵循的难度;(ii) 与 CLIP 相比,MLLM 在图像细节描述和复杂推理方面表现出了优越的能力;(iii) MLLM 可以通过遵循用户提示前的系统指令来扮演零样本学习者的角色,帮助文本特征更加关注关键信息。此外,MLLM 基于因果注意力,而 T5-XXL 利用双向注意力,为扩散模型产生更好的文本指导。因此,我们引入了一个额外的双向令牌细化器来增强文本特征。

3D VAE

HunyuanVideo 使用 CausalConv3D 训练 3D VAE,将像素空间视频和图像压缩到紧凑的潜在空间中。我们将视频长度、空间和通道的压缩比分别设置为4、8和16。这可以显着减少后续扩散变压器模型的令牌数量,使我们能够以原始分辨率和帧速率训练视频。

Prompt 重写

为了解决用户提供的提示的语言风格和长度的可变性,我们对Hunyuan-Large 模型作为我们的提示重写模型进行了微调,以使原始用户提示适应模型首选提示。

我们提供两种重写模式:普通模式和主模式,可以使用不同的提示来调用。此处显示提示。正常模式旨在增强视频生成模型对用户意图的理解,有助于更准确地解释所提供的指令。主模式增强了对构图、灯光、摄像机运动等方面的描述,倾向于生成具有更高视觉质量的视频。然而,这种强调有时可能会导致一些语义细节的丢失。

Prompt Rewrite Model可以直接使用Hunyuan-Large原代码进行部署和推断。我们在这里发布了提示重写模型的权重

项目链接

官网:aivideo.hunyuan.tencent.com代码:github.com/Tencent/Hunyua模型:huggingface.co/tencent/Hunyua

扫码加入技术交流群,备注「开发语言-城市-昵称」

(文:GitHubStore)