今天,在美国拉斯维加斯举行的Google Cloud Next大会上,谷歌CEO Sundar Pichai带队推出了压箱底儿的AI王炸大礼包:

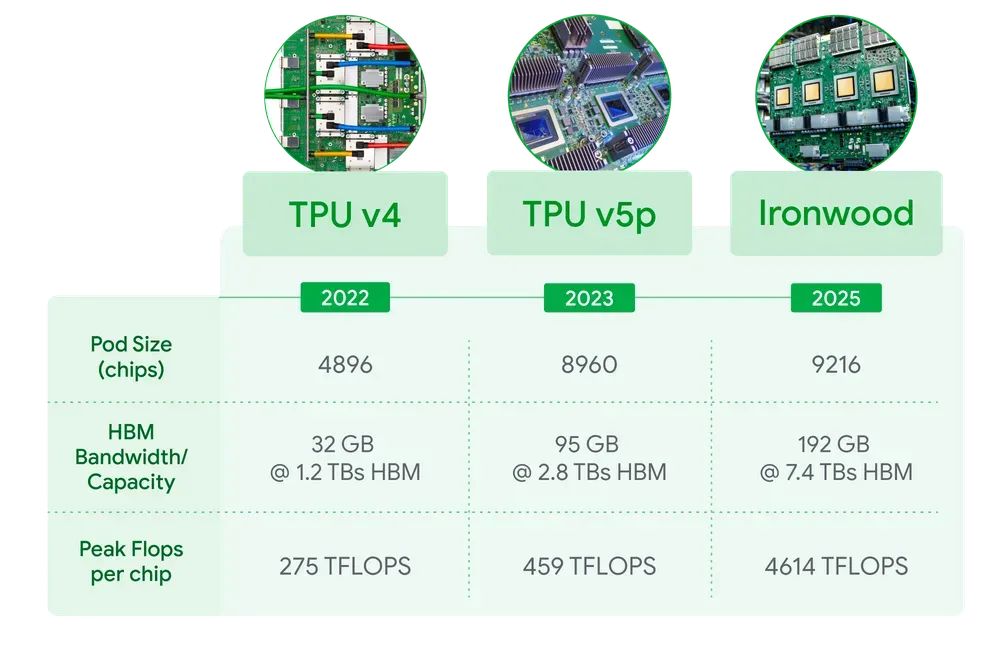

其中,第七代张量处理单元(TPU)Ironwood首次亮相,据悉与第一代云TPU相比,性能提升了3600倍,能效提升了29倍,与上一代TPU Trillium相比,峰值算力提升了五倍,高带宽内存容量提升了六倍,该芯片将于今年晚些时候正式投入使用。

此外,谷歌旗下的Vertex AI也升级成为拥有视频、图像、语音和音乐生成模型的全面平台,开发者能够更轻松地发现、创建和采用AI代理;新一代云广域网(Cloud WAN)性能提升超过40%;还有Gemini 2.5 Flash、Imagen 3、Veo 2等一系列模型与产品更新。

从算力硬件、AI模型到开发平台、网络架构的全量上新亮点满满,再现AI霸主实力。

自2015年起,谷歌就开始在内部使用TPU,过去十年,TPU逐渐成为谷歌进行最先进的AI训练和云计算的独特算力构成。

据介绍,Ironwood是谷歌迄今为止性能最强、能效最高的TPU,并且专为大规模支持思考和推理AI模型而设计。

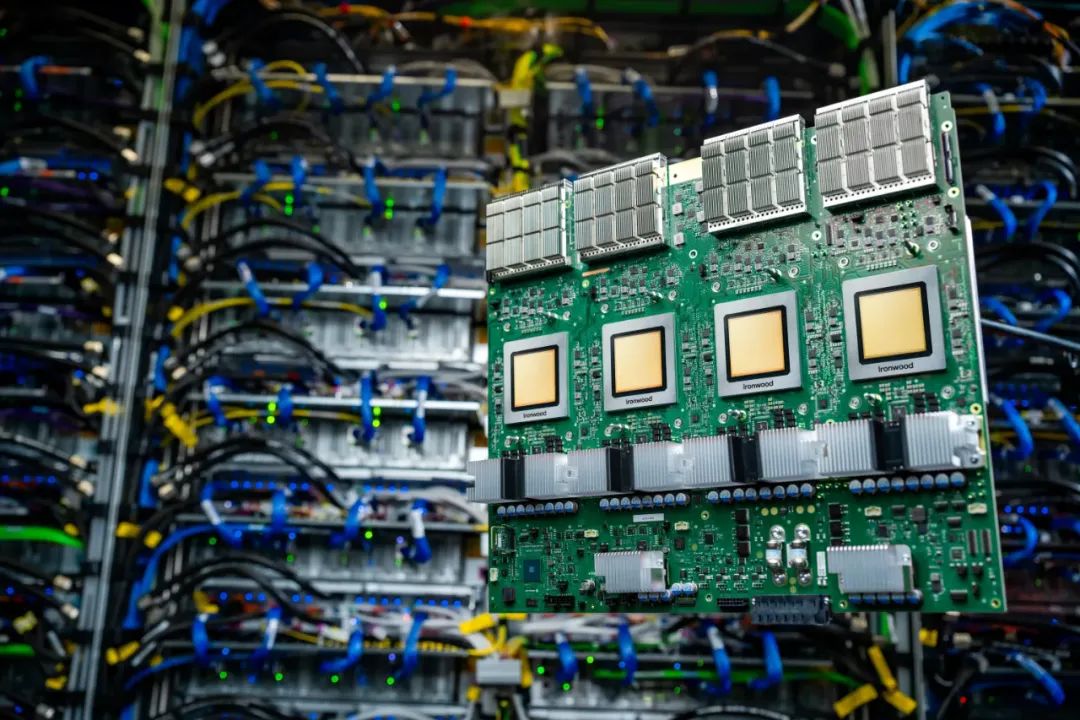

Ironwood旨在满足生成式AI的下一阶段发展及其巨大的计算和通信需求,它支持大型语言模型(LLM)、混合专家模型(MoE)和高级推理任务,可扩展至9216个液冷芯片组合,并通过改进的芯片间互联(ICI)网络连接技术,功率接近10兆瓦,是Google Cloud AI超级计算机架构的新组件之一。

每一块Ironwood芯片的峰值计算能力可达4614万亿次浮点运算(TFLOPs),当计算单元(pod)配备9216块芯片时,可实现总计42.5百亿亿次浮点运算(Exaflops)的算力,所支持的计算能力是目前世界上最大的超级计算机El Capitan的24倍还多。

Ironwood的每瓦性能是去年发布的第六代TPU Trillium的两倍,而且采用了液冷解决方案和优化的芯片设计,即使在持续繁重的AI工作负载下,也能维持高达标准风冷两倍的性能。

此外,谷歌大幅提升了TPU高带宽内存 (HBM) 容量,每芯片容量高达192 GB,是Trillium的6倍,能够处理更大的模型和数据集,减少频繁数据传输的需求,单芯片HBM带宽也高达7.2 TBps,是Trillium的4.5倍,双向带宽提升至1.2 Tbps,是Trillium的1.5倍。

对于Google Cloud客户,Ironwood根据AI工作负载需求将提供256芯片和9216芯片两种不同算力配置。

软件层面,谷歌为Ironwood配置了增强版SparseCore专用加速器以及Pathways机器学习运行时系统,能够支持加速更广泛和尖端的工作负载,并能在芯片之间实现高效的分布式计算,同时还增添了新一代的GKE推理功能,以及将vLLM引入了TPU,这使得已使用vLLM针对GPU优化PyTorch的客户能够轻松转到TPU上运行其工作负载。

虽然最新的TPU很强,但谷歌并没有计划要完全取代英伟达,Google Cloud方面表示,会继续为客户提供AI硬件的可选性,包括搭载NVIDIA最新B200和GB200 Blackwell GPU的A4和A4X虚拟机,据说未来也会是首批采用NVIDIA下一代Vera Rubin GPU的平台。

最新推出的Gemini 2.5 Flash模型,是谷歌最强模型Gemini 2.5 Pro的轻量化版本,一款专为低延迟和成本效益而优化的主力模型,即将在Google AI Studio、Vertex AI和Gemini 应用程序中推出。

Gemini 2.5 Flash会根据提示的复杂程度调整推理深度,还可以根据客户的预算控制性能,在日常用例中更加经济实惠。

除了Gemini 2.5 Flash,其他的各类生成式AI模型均有更新升级。

Imagen 3文本转图像模型改进了图像生成和修复功能,可重建图像中缺失或损坏的部分,此次更新提升了对象移除的质量,带来更自然、更流畅的编辑体验。

Chirp 3音频生成模型现在包含一种新方法,只需输入10秒音频即可创建自定义语音,使企业能够开发个性化呼叫中心、开发无障碍内容并建立独特的品牌声音,新的转录功能可以在多说话人录音中分离并识别单个说话人,可以提高会议摘要、播客分析和多方通话录音等应用的转录清晰度和可用性。

Lyria则是一款企业级文本转音乐模型,可将简单的文本提示转换为30秒的音乐片段,生成高保真音频,呈现丰富细腻的乐曲,涵盖多种音乐类型,可用于营销活动、产品发布、沉浸式店内体验、播客和其他数字内容等。

备受关注的Veo 2视频生成模型改进也非常多,包括:修复功能,用于去除不需要的背景图像、徽标或干扰元素,无需手动修饰即可进行专业编辑;扩展功能,用于扩展现有视频素材的帧,能够针对不同的屏幕尺寸和平台优化视频;先进的电影技术,用于提供镜头构图、摄像机角度和节奏;插值功能,可以定义视频序列的开始和结束,Veo能无缝生成连接帧。

这使得谷歌Vertex AI成为目前业内唯一一个拥有涵盖视频、图像、语音和音乐的生成媒体模型的平台。

据悉,Vertex AI平台目前接入了200多个模型,除了Google模型,还包括来自 Anthropic、AI21和Mistral等公司的第三方模型,以及Gemma和Llama等开放模型。

谷歌致力于将Vertex打造成云端最开放的AI开发者平台,帮助开发者们构建和管理AI应用程序和代理,以及进行模型训练和部署。

值得关注的是,谷歌也开始在标准协议层发力,用来开拓多代理生态系统。

Agent2Agent(A2A)协议:该协议旨在帮助企业支持多智能体生态系统,使智能体能够相互通信,而不受底层技术的限制。目前,谷歌正在与50多家AI公司展开合作,旨在推动A2A成为代理和AI应用程序的互操作性语言。

代理开发套件(ADK):这是一个开源框架,它简化了构建复杂多代理系统的流程,同时保持了对代理行为的精确控制。借助ADK,开发者只需不到100行代码即可构建一个AI代理,同时,ADK还支持模型控制协议(MCP),允许开发者轻松插入各种可用的工具。

Agent Garden:包含一系列即用型示例和工具的集合,可直接在ADK中访问,允许将代理连接到100多个预置连接器、自定义API、集成工作流或云数据集上。

底层技术之上,谷歌也正在加速把最新的AI技术带入产品层,例如Google Workspace,用AI加持包含Gmail、Docs、Drive和Meet等10余款热门应用实现新的功能体验和工作效率提升,据悉每月为企业用户提供超过20亿次AI辅助。

作为老牌科技巨头,谷歌比OpenAI更强的优势还在于遍布全球的骨干网络设施,在200多个国家和地区拥有超过200个接入点(PoP),铺设了超过200万英里的光纤和33条海底电缆。

谷歌将升级后的骨干网称为云广域网(Cloud WAN),与公共互联网相比,该云广域网的性能最高可提升40%。

拥有庞大数据中心网络的大型全球化企业,通常需要能够可靠地传输大量数据,Cloud WAN可提供灵活的连接选项,用于连接地理位置分散的数据中心,为容量有限、运营成本高且可靠性低的传统解决方案提供现代化的替代方案。

Google Cloud Interconnect在区域和本地数据中心之间提供私有且专用的低延迟连接,可以从全球159多个地点将数据中心连接到Google Cloud,此外,跨云互连还支持Google Cloud与其他公共云环境(包括亚马逊AWS、微软Azure和甲骨文OCI)之间的多云连接,目前已在21个地点提供。

简单来说,Cloud WAN算是谷歌专门为AI时代升级搭建的星球级网络基础。

除了一些新技术和产品平台发布,谷歌CEO Sundar Pichai还强调未来大举投资AI的计划。虽然全球经济存在波动,但Sundar Pichai表示在2025年仍将会投入约750亿美元继续突破AI能力极限和全栈技术创新,堪称大手笔。

尽管谷歌技术实力强悍且布局全面,但在AI领域,颠覆式创新的不断涌现仍是科技巨头们最忌惮的力量,OpenAI、Anthropic、DeepSeek等AI新秀的崛起便是最好的见证。

作为世界级科技巨头,谷歌对全球AI技术生态的推动力不言而喻,接下来会激发出哪些市场创新值得关注和期待。

(文:头部科技)