在人工智能领域,语音合成技术一直是研究的热点之一。随着深度学习的发展,语音合成系统不断取得突破,从早期的机械语音到如今自然流畅的语音输出,技术的进步为众多行业带来了变革。近期,字节跳动与浙江大学合作推出的MegaTTS 3零样本语音合成系统,凭借其轻量级、高效、高质量的特点,引起了广泛关注。本文将深入探讨MegaTTS 3的技术原理、主要功能、应用场景以及如何快速上手使用,为技术爱好者和从业者提供全面的参考。

一、项目概述

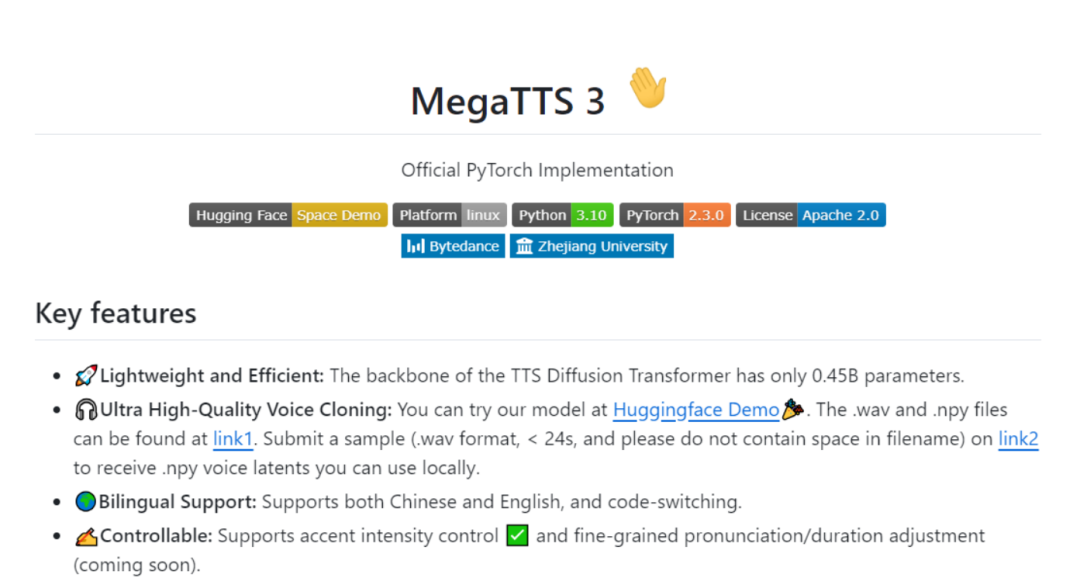

MegaTTS 3是由字节跳动与浙江大学联合研发的零样本文本到语音合成系统,采用轻量级扩散模型,参数量仅为0.45亿,能够高效生成高质量语音。它将语音分解为内容、音色、韵律等属性分别建模,支持超高音质的语音克隆、双语合成、口音强度控制等功能,可应用于语音合成、语音编辑等场。

二、技术原理

(一)轻量级扩散模型

MegaTTS 3采用了轻量级的扩散模型(TTS Diffusion Transformer),其参数量仅为0.45B。扩散模型是一种生成模型,通过逐步添加和去除噪声来生成目标语音。它包括两个核心过程:前向过程(加噪)和反向过程(去噪)。在前向过程中,模型会将语音信号逐步加入噪声,使其逐渐接近噪声分布;而在反向过程中,模型则通过学习去除噪声,逐步恢复出目标语音。这种模型结构不仅保证了生成语音的高质量,还使得模型在计算效率上具有显著优势,能够在短时间内完成语音合成任务。

(二)语音分解与建模

MegaTTS 3将语音分解为内容、音色、韵律和相位等不同属性,并为每个属性设计了合适的模块进行建模。音色建模使用全局向量(global vectors)来实现,因为音色是随时间缓慢变化的全局属性,全局向量能够有效地捕捉这种全局特性。韵律建模则利用基于潜在码的语言模型(latent code language model)来拟合韵律的分布,由于韵律在句子中快速变化,语言模型能够捕捉局部和长距离的依赖关系,从而生成自然流畅的韵律。内容建模采用基于VQGAN的声学模型生成语谱图,VQGAN能够将语音内容的特征有效地编码到语谱图中。相位建模则由基于GAN的声码器适当构建,由于相位的复杂性较高,使用GAN能够更好地生成高质量的相位信息。

(三)数据与训练

MegaTTS 3在大规模多领域数据集上进行训练,包含20K小时的语音数据。这些数据涵盖了多种语言、口音和说话风格,使得模型在零样本语音合成、语音编辑和跨语言语音合成任务上表现出色。通过在如此大规模的数据集上进行训练,模型能够学习到丰富的语音特征和模式,从而提高其泛化能力和生成质量。

(四)稀疏对齐算法

MegaTTS 3引入了稀疏对齐算法,为潜在扩散变换器(DiT)提供稀疏对齐边界来引导生成过程。这种算法在不缩小搜索空间的情况下降低了对齐难度,使得生成的语音在自然度和相似度上得到了显著提升。稀疏对齐算法通过在语音和文本之间建立稀疏的对应关系,帮助模型更好地理解语音的结构和语义信息,从而生成更加自然和准确的语音。

三、主要功能

(一)零样本合成

MegaTTS 3能够实现零样本语音合成,即无需目标说话人的特定语音数据,仅通过少量提示即可生成其语音,快速完成语音克隆。这一功能极大地降低了语音合成的门槛,使得在没有大量语音数据的情况下也能够快速生成高质量的语音,为语音合成的应用带来了更多的可能性。

(二)多语言支持

MegaTTS 3支持中文、英文以及中英混合语音合成,能够满足不同语言场景下的需求。无论是在国际化的语音交互应用中,还是在多语言的有声读物制作中,MegaTTS 3都能够提供高质量的语音合成服务,为用户带来更加丰富的语音体验。

(三)高音质输出

生成的语音自然流畅,音质清晰,与目标说话人高度相似。MegaTTS 3通过先进的技术手段,确保生成语音的音质能够达到高水准,让用户在使用过程中能够感受到如同真人般的语音效果。

(四)音色控制

用户可以根据需要调整生成语音的音色,使其更接近目标说话人或添加特定的音色效果。这一功能为语音合成的应用提供了更大的灵活性,例如在制作有声读物时,可以根据角色的性格特点调整音色,增强故事的感染力。

(五)韵律调整

MegaTTS 3支持对语音的韵律进行控制,如语速、语调等,让语音更具表现力。通过调整韵律参数,用户可以生成不同情感色彩和语境下的语音,使语音合成更加贴近实际的交流场景。

(六)口音强度控制

通过参数调整,MegaTTS 3可以生成带有不同口音强度的语音,模拟多种语言风格。这一功能对于跨语言语音合成和多语言环境下的语音交互具有重要意义,能够更好地满足用户的个性化需求。

(七)快速克隆

仅需几秒目标说话人的音频样本,MegaTTS 3就可以快速生成其语音,实现高效语音克隆。这一功能在需要快速生成特定说话人语音的场景下非常实用,例如在语音交互设备中,用户可以快速将自己的声音克隆到设备中,提升交互的自然度和个性化体验。

四、应用场景

(一)学术研究

研究人员可以利用MegaTTS 3来测试语音合成技术,分析不同参数和模型结构对语音合成效果的影响。通过对latents(潜在特征)的研究,可以进一步探索语音合成的内在机制,为语音合成技术的发展提供理论支持。

(二)教育辅助

在教育领域,MegaTTS 3可以将教材内容转化为语音,生成有声读物,帮助学生更好地理解和学习知识。特别是对于视力障碍的学生或喜欢听书的学生来说,这一功能具有重要的意义。同时,它还可以用于语言学习,帮助学生练习发音和语调,提高语言能力。

(三)内容制作

对于视频制作、播客等媒体内容制作行业,MegaTTS 3可以为视频或播客生成旁白,节省人工录音的成本和时间。通过调整音色和韵律,可以生成符合不同内容风格和情感需求的语音,提升内容的吸引力和专业性。

(四)语音交互

开发者可以将MegaTTS 3集成到智能语音交互设备中,实现中英文语音对话。这将为用户提供更加自然、流畅的语音交互体验,提升设备的智能化水平和用户体验。

五、快速使用

(一)安装环境

1、Linux环境

克隆项目仓库:

git clone https://github.com/bytedance/MegaTTS3cd MegaTTS3

创建Python 3.10的conda环境并安装依赖:

conda create -n megatts3-env python=3.10conda activate megatts3-envpip install -r requirements.txt

设置根目录环境变量:

export PYTHONPATH="/path/to/MegaTTS3:$PYTHONPATH"[可选]设置GPU环境变量:

export CUDA_VISIBLE_DEVICES=02、Windows环境

注释掉requirements.txt中WeTextProcessing的依赖:

# WeTextProcessing==1.0.4.1创建Python 3.10的conda环境并安装依赖:

conda create -n megatts3-env python=3.10conda activate megatts3-envpip install -r requirements.txtconda install -y -c conda-forge pynini==2.1.5pip install WeTextProcessing==1.0.3

[可选]如果需要GPU推理,安装特定版本的PyTorch:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126如果遇到`ffprobe`或`ffmpeg`相关问题,通过以下命令安装:

conda install -c conda-forge ffmpeg设置根目录环境变量:

set PYTHONPATH="C:\path\to\MegaTTS3;%PYTHONPATH%" # Windows$env:PYTHONPATH="C:\path\to\MegaTTS3;%PYTHONPATH%" # Powershell on Windowsconda env config vars set PYTHONPATH="C:\path\to\MegaTTS3;%PYTHONPATH%" # For conda users

[可选]设置GPU环境变量:

set CUDA_VISIBLE_DEVICES=0 # Windows$env:CUDA_VISIBLE_DEVICES=0 # Powershell on Windows

3、Docker环境

下载预训练检查点文件并放置在`./checkpoints/xxx`目录下。

构建Docker镜像:

docker build . -t megatts3:latest启动Docker容器(GPU推理):

docker run -it -p 7929:7929 --gpus all -e CUDA_VISIBLE_DEVICES=0 megatts3:latest启动Docker容器(CPU推理):

docker run -it -p 7929:7929 megatts3:latest访问`http://0.0.0.0:7929/`以使用Gradio界面。

(二)模型下载

预训练检查点文件可以从Google Drive或HuggingFace下载,并放置在`./checkpoints/xxx`目录下。需要注意的是,由于安全问题,WaveVAE编码器的参数没有上传到上述链接,用户只能使用预提取的latents进行推理。如果需要为说话人A合成语音,则需要在同一个目录下有“A.wav”和“A.npy”文件。

(三)推理使用

1、命令行使用(标准)

使用中文提示音频和文本生成语音:

python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "另一边的桌上,一位读书人嗤之以鼻道,'佛子三藏,神子燕小鱼是什么样的人物,李家的那个李子夜如何与他们相提并论?'" --output_dir ./gen使用英文提示音频和文本生成语音:

python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text 'As his long promised tariff threat turned into reality this week, top human advisers began fielding a wave of calls from business leaders, particularly in the automotive sector, along with lawmakers who were sounding the alarm.' --output_dir ./gen --p_w 2.0 --t_w 3.0其中,`p_w`(可理解性权重)和`t_w`(相似性权重)是两个重要的参数。通常,带有更多噪声的提示需要更高的`p_w`和`t_w`值。在合理范围内增加`t_w`(2.0~5.0),可以增加生成语音的表现力和相似度,尤其是在一些情感表达较强的场景下。

2、命令行使用(带口音的TTS)

当`p_w`(可理解性权重)≈1.0时,生成的音频会更接近说话人的原始口音。随着`p_w`的增加,生成的语音会逐渐向标准发音靠拢。`t_w`(相似性权重)通常设置为比`p_w`高0~3个点,以获得最佳效果。这一功能对于带口音的TTS或解决跨语言TTS中的口音问题非常有用。例如:

python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text '这是一条有口音的音频。' --output_dir ./gen --p_w 1.0 --t_w 3.0python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text '这条音频的发音标准一些了吗?' --output_dir ./gen --p_w 2.5 --t_w 2.53、Web UI使用

启动Web UI服务:

python tts/gradio_api.py通过Web UI界面,用户可以更直观地进行语音合成操作,调整各种参数并实时查看生成结果。需要注意的是,使用CPU进行推理可能会比较慢,大约需要30秒(10步推理)。

六、结语

MegaTTS 3作为字节跳动与浙江大学合作推出的零样本语音合成系统,凭借其轻量级、高效、高质量的特点,在语音合成领域展现出了巨大的潜力和应用价值。它不仅能够快速生成与目标说话人高度相似的语音,还支持多种语言、音色控制、韵律调整等功能,满足了不同场景下的多样化需求。

七、项目地址

GitHub仓库:https://github.com/bytedance/MegaTTS3

HuggingFace模型库:https://huggingface.co/ByteDance/MegaTTS3

(文:小兵的AI视界)

也没说啥时候开源的