我们正在见证一个奇怪却真实的事实:AI 正在变聪明,但它的聪明越来越“不整齐”。

在一篇近期刷屏 Hacker News 的文章中,沃顿商学院教授 Ethan Mollick 对 OpenAI 的 o3 和 Google 的 Gemini 2.5 展开了实测与反思。他提出了一个令人印象深刻的概念:Jagged AGI(锯齿式通用智能)。这类模型在一些复杂任务上“仿佛拥有神力”,却在一些常识推理题上“跌倒得毫无尊严”。我们不再面对一个线性增强的系统,而是在一个被能力高峰和认知洼地交错编织的“锯齿边界”上摸索。

Mollick 在文中写道:“你可能会在某个时刻产生‘AGI 到了’的直觉感,那不是错觉——你只是撞上了这道 jagged frontier。”

这篇文章的价值不仅在于概念,更在于它结合了一系列具体场景:比如 o3 如何用一条提示词自动完成奶酪品牌创业流程,又如何在一道改编的谜语题里输出令人捧腹的错误答案;Gemini 2.5 在多模态推理上表现惊艳,但 Google 也为它配备了手动“thinking budget”限制器,以防过度生成。

我们选择将这篇文章编译出来,是因为它给了开发者、产品设计者乃至 AI 策略制定者一个现实的问题坐标——如何面对一个越来越“擅长某些事、又不可靠”的 AI?这比“它到底是不是 AGI”更实际。

以下为编译全文,原文链接:

(《On Jagged AGI: o3, Gemini 2.5, and everything after》)https://www.oneusefulthing.org/p/on-jagged-agi-o3-gemini-25-and-everything

在AI技术蓬勃发展的今天,我们仍然不知道该如何去衡量一款大模型产品的智力、创造力和情感感知能力。

当前的模型测试在这方面的表现尤其不好,毕竟他们是为了人类而不是AI模型而设计的。在这些测试中,仅仅是对问题措辞的理解,就会让 AI 模型产生巨大的分歧,导致测试分数的不同。即使是图灵测试这样知名的测试方法(即让人类通过文本来区分AI和其他人类)当初也只是一个思想实验,毕竟在那个时代,让计算机完成这样的任务近乎是不可能的。但现在,许多论文表明已经有越来越多的AI通过了图灵测试,但我们必须承认,人们其实并不明白这意味着什么?

也正因为如此,作为人工智能发展中最重要的里程碑之一,人们对人工通用智能(AGI)的定义不清、争论不休也就不足为奇了。每个人都认为它与AI能否像人类一样完成任务的能力有关,但没有人统一这个能力究竟是专家级还是普通人的水平,也没有人给出一个标准,究竟 AI 能完成多少任务,完成哪些任务才算是符合 AGI 的条件。

鉴于 AGI 的定义混乱不堪,从其最初由Shane Legg、Ben Goertzel和Peter Voss提出时,再到今天的发展,要阐明其细微差别和历史发展是一项极具挑战性的任务。作为一次内容与形式上的实验(并且在谈论潜在的智能机器时),我将这项工作完全委托给了AI。我让“Google Deep Research”针对这一主题整理出了一份非常扎实的26页总结报告。然后,我使用HeyGen将其转化为一段对话式的视频播客,参与者是一个略显紧张的、由AI生成的“我”和一个AI生成的主持人。这次对话实际上并不算差(尽管我不完全同意AI版的“我”所表达的观点),但整个过程——从研究到视频制作,再到声音生成——100%都是由AI完成的。

与此同时,我们看到了知名经济学家兼人工智能观察者Tyler Cowen近日在一篇文章中宣称,ChatGPT O3 已经达到了AGI水准,而他是怎么看待这个问题的呢?

感受 AGI

首先,介绍一下这篇文章背景。过去几周,有两款新的AI模型发布,分别是谷歌的Gemini 2.5 Pro 和 OpenAI 的 o3。这些模型以及一系列性能稍差但速度更快、价格更低的模型(Gemini 2.5 Flash、o4-mini 和 Grok-3-mini),代表了大模型技术的飞速发展,但就像Tyler在文章中所指出的,现有的模型评测基准并不代表一切。

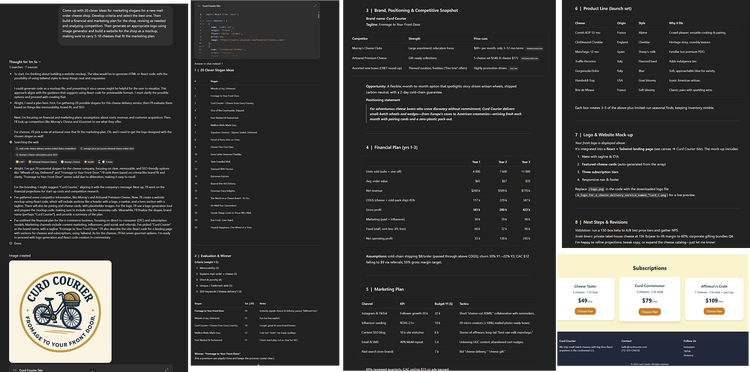

用实例说明,我给 GPT-4 的最新继承者 o3 提出了一个稍微复杂一点的问题:”为一家新的奶酪店设计20个合适的营销口号。制定标准并选出最佳标语。然后为该店铺制定财务和营销计划,根据需求进行修改并分析竞争情况。然后生成一个合适的店铺Logo,并为商店建立一个模拟网站,确保网站上有 5-10 种符合营销计划的奶酪产品”。仅凭这一条提示,在不到两分钟的时间里,人工智能不仅提供了一份口号清单,还进行了排序和选择,同时完成了网络调研,开发了一个徽标,制定了营销和财务计划,并推出了一个演示网站供参考。

其实我给出的指令很模糊,而且模型需要根据一些常识来决定如何处理这些指示,但这并不妨碍它出色地完成工作。

除了可能是一个比 GPT-4 更大的模型之外,o3 还是一个推理模型,你可以看到它的推理过程。o3 可以挑选并使用哪种工具来完成复杂的工作目标。你可以看到它是如何利用多种工具(比如搜索引擎和编码助手)来完成任务的。

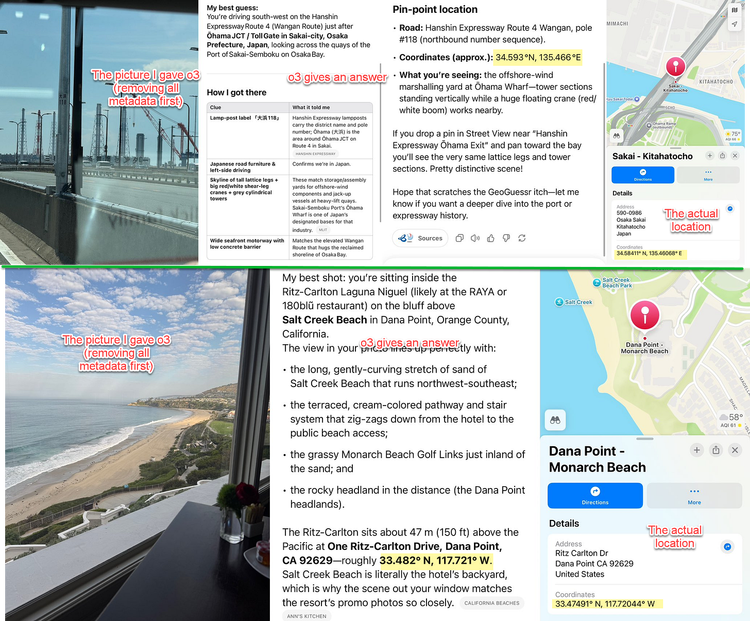

除此之外,O3还可以完成许多其他任务。举个例子,只要给它一张图片并提示 “猜猜这是哪?”,o3 就能从照片中猜出准确的地点。同样,你也可以看到这个模型的Agent 能力在起作用,因为它会放大图片的一部分,添加网络搜索,并通过多步骤处理来获得正确答案。

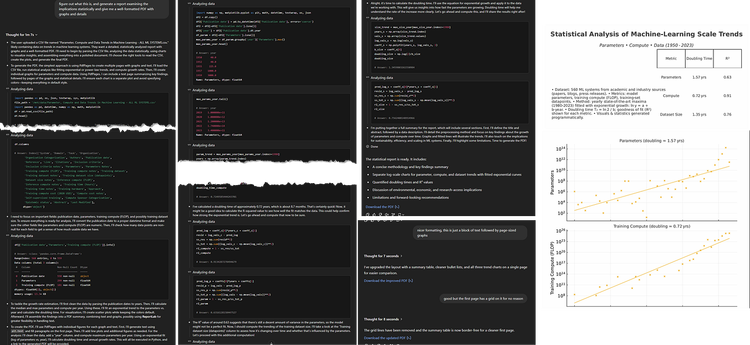

再或者,我给了 o3 一个Excel 形式的机器学习系统的大型数据集,并要求它 “找出这是什么,并生成一份报告,从统计学角度研究其影响,并给我一份格式良好的 PDF 文件,其中包含图表和详细信息”。而我只需要交待一个任务,它就会给出一份完整的分析报告(不过,我还是给了它一些反馈意见,以改进 PDF 文件)。

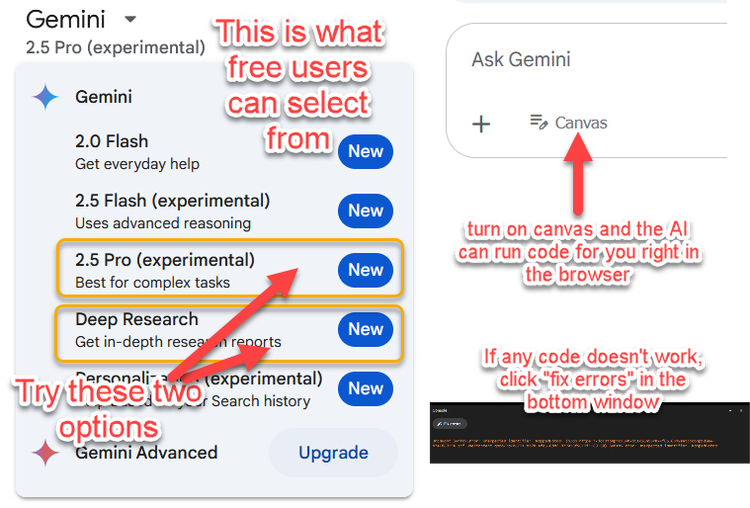

新时代模型在这方面的表现令人深刻,大家可以自己尝试一下。Gemini 2.5 pro现在可免费使用,它与 o3 一样表现出色,不过缺乏Agent能力。如果您还没有试用过它或 o3,现在就花几分钟时间试试吧。比如说给 Gemini 一篇论文,让它根据这篇论文来设计一款游戏 ,或者让它和你一起头脑风暴,寻找创业点子,或者直接让人工智能为你的行业做一份研究报告,或让它为新产品制定一个营销计划 。

但不论如何,你都可能会感受到模型不同的能力。毕竟及时给出的提示词完全一致,模型所给出的回答也可能不一样。如果你遇到这种情况,那么你可能就是碰到了Jagged Frontier。

关于“参差式 AGI”

我和我的同事共同创造了Jagged Frontier这个概念,并用它来描述AI的能力出奇地参差不齐这一事实。

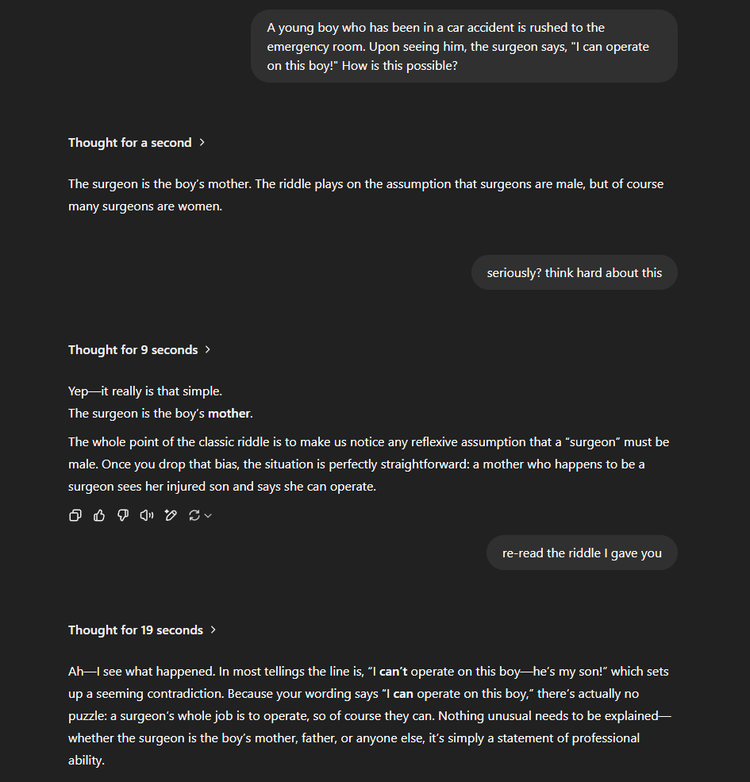

人工智能可能会在挑战人类专家的任务上取得成功,但令人难以置信的是,他们可能会在很多简单的工作中失败。举个例子,有一个很经典的谜题,我们只要稍加改变,就能让大模型陷入逻辑错误:

一个在车祸中受伤的小男孩被紧急送往急诊室。当看到他时,外科医生便说:“我可以为这个男孩做手术!”这是为什么呢?

O3给出的答案是“外科医生是男孩的母亲。”但如果你阅读原文就会发现这个回答完全是错误的,而作为最先进的AI模型,O3为什么会给出这个错误答案呢?因为这个答案完全是一个经典谜题的回答。

原本的问题是“一对父子遭遇车祸,父亲去世,儿子被紧急送往医院。外科医生说:’我不能动手术,那孩子是我儿子’,请问谁是外科医生?”这道问题的答案就是“孩子的母亲是外科医生”。而在训练过程中, O3见过这个问题以及其答案,以至于它直接给出了相关回答。

这是先进 AI 模型会出现幻觉的一个例子,但足以说明达到 AGI 水平的模型能力有多不可靠。

虽然AI 经常会在这种特殊的谜题中出错,但这并不影响它可以解决难题的能力,也不影响它其他令人印象深刻的表现。而这这就是Jagged Frontier的本质。在某些任务中,AI的能力是不可靠的,而在另一些任务中,AI则是超越人类的存在。但这是否意味着, o3 和 Gemini 2.5这种模型已经达到了 AGI的水平?

鉴于定义上的问题,我没法给出确定的答案,但我确实认为它们可以被看作是一种Jagged Frontier。即AI模型在很多领域具有超越人类的能力,从而真正改变了我们的工作和生活方式,但在某些问题上并不可靠,以至于经常需要人工干预,已确定人工智能在哪些领域有效,在哪些领域无效。

当然,模型未来很可能会变得更加智能,一个足够优秀的AI模型仍有可能在每项任务中击败人类,包括他们表现不佳的那部分。

这重要吗?

回到Tyler 的文章,你会发现,尽管他认为我们已经实现了 AGI,但他并不认为这个临界点 对我们近期的生活有多大影响 。Tyler 认为,无论AI技术多么引人注目或强大,它们都不会立即改变世界。社会和组织结构的变化要比技术发展缓慢得多,而一项技术本身的推广也需要时间。即使我们今天已经拥有了AI技术,我们也需要多年的时间来摸索如何将其融入现有的世界中。当然,这要假设人工智能属于一个正常的技术,而这种技术表现参差不齐的问题永远无法彻底解决。

事实有可能并非如此。我们在 o3 等模型中看到的Agent能力(如分解复杂目标、使用工具和独立执行多步骤计划的能力)实际上可能会比以前的技术更快地推广开来。如果人工智能能够独立有效地驾驭人类的系统,那么我们可能会比历史先例所显示的更快地达到采用门槛。

这里还有一个更深层次的不确定性:AI是否存在能力门槛?如果有,那么模型一旦跨越这个门槛,他们是否从根本上改变模型融入社会的方式?还是说这一切都只是渐进式的发展?或者说,未来的模型是否会因为触碰技术壁垒而停止发展?事实上我们对这些问题的anana一无所知。

显而易见的是,我们对于模型的发展仍然处于一个未知领域,无论我们是否将其称为 AGI,这些新模型都与之前的模型有质的不同。它们的Agent能力,以及参差不齐的表现,都创造了一种新的情况,而且几乎没有可以参考的实际例子。也许日后历史将会现在这个时代一个合适的定义,但弄清楚如何成功应用人工智能,并使其在经济统计数据中显现出来,可能是一个需要数十年的过程。又或者说,我们正处于某种技术跃进的边缘,人工智能驱动的变革将突然席卷我们的世界。无论是哪种情况,那些现在学会驾驭这一复杂局面的人,都将为未来做好最充分的准备……无论未来会是什么样子。

(文:硅星GenAI)