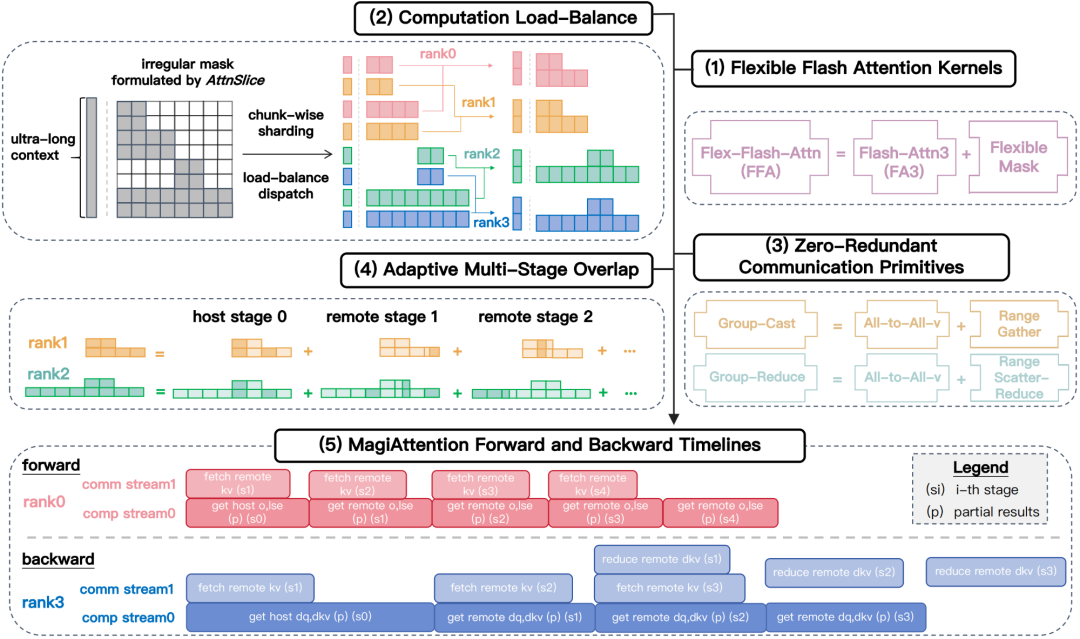

MagiAttention:为超长文本和异构数据训练提供线性可扩展的分布式注意力机制。亮点:

-

支持多种注意力掩码类型,灵活性极高; -

在Hopper GPU上性能与Flash-Attention 3相当; -

实现零冗余通信,大幅提升分布式训练效率。

参考文献:

[1] http://github.com/SandAI-org/MagiAttention

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)