如果你对 Transformer 感兴趣,或想了解 OpenAI、谷歌、Meta 等顶尖研究者的最新思考与实践——那一定不能错过斯坦福大学开设的这门神课:CS25 – Transformers United V5!

这门课曾经邀请过“深度学习教父”Geoffrey Hinton、前 Tesla AI 总监 Andrej Karpathy、OpenAI 的 Hyung Won Chung 和 Jason Wei 等业界传奇人物授课,在 AI 社区引发巨大反响。

🆕2025 春季课程震撼来袭!

今年春季学期的 CS25 课程已正式上线!新一期阵容同样豪华,包括:

-

🧠 Denny Zhou|Google DeepMind 推理团队创始人 & 负责人

-

🧠 Karina Nguyen|OpenAI Canvas 项目负责人

-

🧠 Hongyu Ren(任泓宇)|OpenAI 研究科学家

-

🧠 Andrew Brown|Meta 视频生成团队研究科学家

他们将围绕 Transformer 架构、大语言模型、推理能力、视频生成等前沿主题展开深入分享。

✅完全开放,无需注册!

这门课程对全球完全免费开放,你无需注册斯坦福账号,也不需要任何权限。你可以选择:

🔴 线下现场旁听(Stanford 校园)

🔵 线上 Zoom 直播参与

📺 课后回放 YouTube 视频

课程官网地址:

👉 https://web.stanford.edu/class/cs25/recordings/

目前第一期课程视频已上线:

🎥 https://www.youtube.com/watch?v=JKbtWimlzAE

📅课程时间(北京时间)

每周三上午 6:00 – 7:20

(太平洋夏令时间周二下午 3:00 – 4:20)

记得提前设好闹钟,错过直播也没关系,回放视频会陆续上传到官方频道!

🔥往期精选讲座回顾

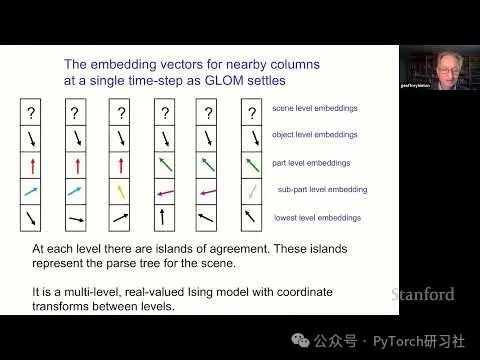

🎙Geoffrey Hinton:神经网络中的部分-整体结构表示

Hinton 在讲座中提出 GLOM 模型,模拟人类视觉系统如何处理复杂场景。通过动态树结构与自注意力机制结合,提升 Transformer 在视觉理解任务中的表现。

📺 视频地址:https://www.youtube.com/watch?v=CYaju6aCMoQ&t=2s

🎙Andrej Karpathy:Transformer 架构原理全解

从《Attention is All You Need》讲起,系统拆解 Self-Attention、多头注意力机制,并讲述 Vision Transformer(ViT)等跨领域应用的前沿进展。

📺 视频地址:https://www.youtube.com/watch?v=XfpMkf4rD6E

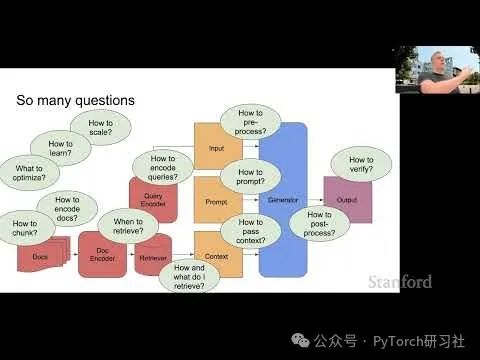

🎙Douwe Kiela:Retrieval-Augmented Generation(RAG)深度解析

Kiela 深入分析 RAG 技术如何为 LLM 提供外部知识上下文,减缓幻觉与过时问题,评估如 Realm、Atlas、Retro 等架构,并展望多模态 RAG 的发展方向。

📺 视频地址:https://www.youtube.com/watch?v=mE7IDf2SmJg

🎙Jason Wei & Hyung Won Chung:OpenAI 的 LLM 研究洞察

两位 OpenAI 科学家从 Scaling Law、涌现能力、自注意力演变等角度探讨 LLM 的本质,还介绍了 FLAN-T5、Codex 等实际项目经验。

📺 视频地址:https://www.youtube.com/watch?v=3gb-ZkVRemQ

🧠 跟上世界前沿,从这一课开始!

CS25 不仅是一门课,更像是一场大型的 AI 知识盛宴——

🌐 聚焦全球顶级大模型专家

📚 涵盖 Transformer、推理、RAG、多模态等关键主题

💻 在线开放、无门槛参与

无论你是 AI 研究者、开发者、学生,或是 LLM 爱好者,这门课都值得你每周早起一次!

📌 建议收藏:

-

课程主页:

🔗 https://web.stanford.edu/class/cs25/recordings/ -

YouTube 视频入口:

🔗 https://www.youtube.com/watch?v=JKbtWimlzAE

想了解更多 AI 一线知识和课程推荐,欢迎关注我们,我们将持续更新!

(文:PyTorch研习社)