OpenAI 发布季第三天,正式发布 Sora。

于 2024 年 2 月首次亮相的 Sora,经过近 10 个月的迭代后, 正式上线。引领了视频生成风潮的Sora,在今天要面对国内外各种视频模型的竞争,比如可灵、即梦、Vidu 等。

在文、图生视频的基础功能之上,它加入了故事板(相当于通过分镜创作自己的故事)、用文本调整原视频、不同场景视频的融合等功能(相当于给视频直接加特效),整个产品功能设计似乎都在让视频更接近创作者的自我表达、帮助他们完成一个理想的镜头故事。

当地时间 12 月 9 日晚些时候,美国、以及大多数其他国家的用户,可以访问官网体验 Sora。它被包含在 ChatGPT Plus、ChatGPT Pro 的会员订阅中,无需额外付费。其中,Plus 能生成最多 50 个高级视频、视频分辨率最高达 720p、时长为 5 秒,而 Pro 则能生成最多 500 个高级视频、分辨率高达 1080p、时长为 20 秒、还能去水印。

Sam Altman 介绍做 Sora 有三大原因:

一是从工具性角度,OpenAI 喜欢为创意人员制作工具,这对公司的文化很重要;

二是从用户交互角度,人工智能系统不能只通过文本交互,也应该理解并生成视频,帮助人类使用人工智能。这类似于国内大模型公司谈到的,「模型每扩展一次模态,用户渗透率就会上升。」

三则是从技术角度,这对 OpenAI 的 AGI 路线图至关重要,人工智能应该学到更多关于世界的规律,这正是所谓理解物理规律的「世界模型」。

既要用技术改变世界,也要用产品促进人类创造,这就是 Sora 在做的事情。

01

生成视频之外,

还能分镜、加特效、无限创作

Sora 最基础的,首先是文生视频、图生视频功能。

打开主界面,用户可以查看和管理所有的视频生成内容,并且切换网格视图、列表视图,以及创建文件夹和收藏夹,查看书签等。研究人员称这个主界面设计,是为了更好地帮助用户创作故事。

在主页面的中间底部,是 Sora 的文生视频、图生视频功能。

比如,Sam Altman 先给到文字输入,「长毛猛犸象在沙漠中行走,广角镜头拍摄」。接着,需要选择视频的画面比、分辨率、时长(5-20 秒)、以及最终生成的视频数量(最多可生成四段以供挑选)等,才能获得生成的视频。

最终,可以看到生成的视频效果非常真实、有质感,且基本遵照了输入的指令。对于 Sora 视频生成效果的出色表现,或许人们是不意外的。

输入「长毛猛犸象在沙漠中行走,广角镜头拍摄」的文字后,Sora 生成了四段视频 | 图片来源:OpenAI

但此次,Sora 还发布了一系列独有的、进阶的的产品功能。在极客公园看来,这些功能基本围绕视频的更准确表达,也就是通过分镜、加特效等等方式,让人们能通过视频创作出一个自己想要的故事。

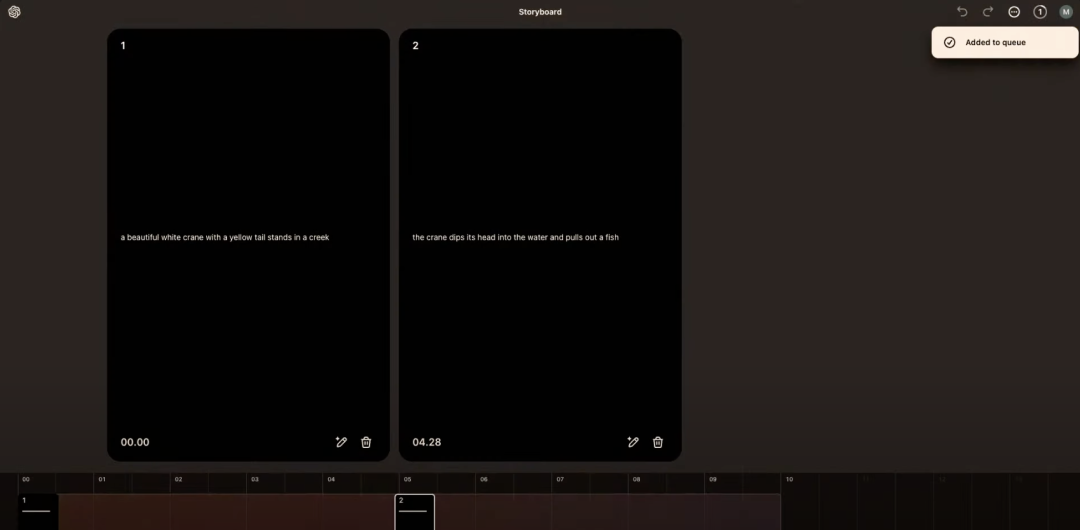

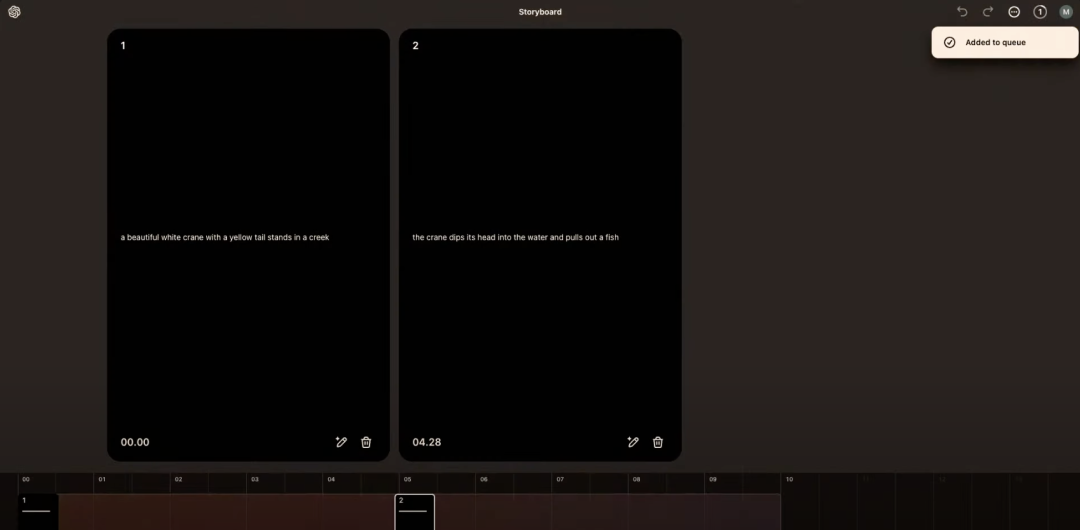

首先是故事板(storyboard),它被研究人员称为是一种「全新的创意工具」。

从产品设计上看,它相当于按时间轴的方式,把一段故事(视频)切成了多个不同的故事卡(视频帧)。用户只需要设计和调整每张故事卡(视频帧),Sora 会自动把它们补成一段流畅的故事(视频)——这很像电影里的分镜、动画的手稿,当导演画好分镜、一个片子就拍出来了,一个漫画师写好手稿、一个动画就设计出来了。

比如研究人员设想的第一个分镜是,「美丽的白鹤站在小溪中,拥有一条黄色的尾巴。」第二个分镜是,「鹤将头探入水中,并捉出一条鱼」。那他做的工作就是,分别创建这两张故事卡(视频帧),并在两者之间设大概五秒钟的间隔。这个间隔对 Sora 很重要,给了它把两组动作连起来的发挥空间。

最终,他得到了一个完整的视频镜头,「美丽的白鹤站在小溪中,它拥有一条黄色的尾巴。接着鹤将头探入水中,并捉出一条鱼。」

通过两张故事卡(视频帧),Sora 生成了一个完整的故事(视频) | 图片来源:OpenAI

更为奇妙的是,在这个故事板上,创作要素不只是故事卡,也可以是直接的图片、视频。也就是说,可以将任意的图片、视频拉到故事板上,结合故事卡,对它进行创作。

以视频为例,研究人员将上述白鹤的视频切下来导入故事板,进行了剪切,这就给视频的前方和后方留出了继续创作的间隙,也就是说可以有新的开头和结尾。

这带来的想象是,故事板可以无限的创作下去。也就是说 Sora 生成的 20 秒视频,可以被不断地创造、剪切、创造……直至完全达到心目中理想的镜头。这个过程就像一个剪辑师、导演,通过对分镜设计和镜头素材的不断生成剪辑,慢慢剪出自己心中的片子。

和真实世界中不同,Sora 提供的素材是无限的。而和其他的文生视频产品不同,Sora 的视频是可以修改加工的。这使得它生成的视频一定会更符合用户心中的想象、创意。

这似乎正是 Sora 此次产品的核心思路:尽最大可能地,让生成的视频符合用户心中想要的创意。

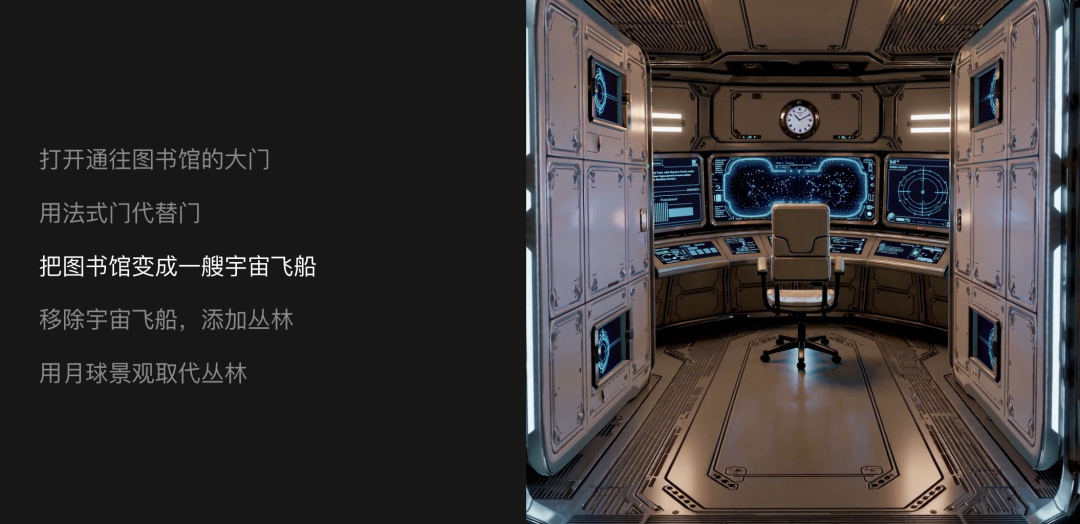

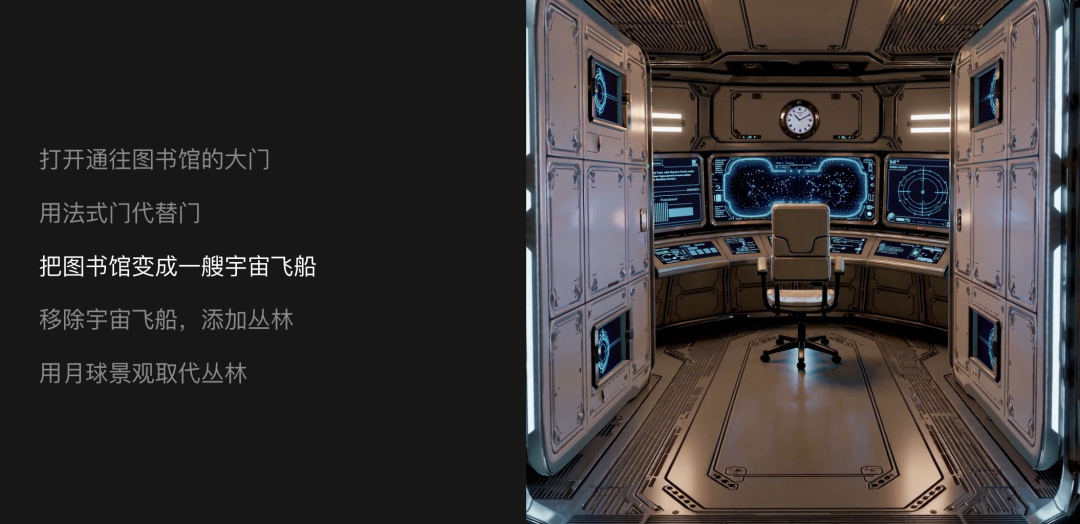

这样可以更好理解 Sora 的其他功能,比如可以通过文字直接修改视频、可以无缝融合两段不同的视频、可以给视频改变画风等,这相当于是直接给视频加「特效」了。而一般的文生视频产品,可能需要不断地调整 prompt(提示词)、不断重新生成视频。

通过调整文字,用户可以直接调整视频 | 图片来源:OpenAI

Sora 能将两个两段视频合并为一段无缝剪辑 | 图片来源:OpenAI

总的来说,Sora 除了在生成视频上不出意料的出色表现之外,它还带来了更独有的视频创作产品功能,相当于给视频加分镜、剪辑、特效。这意味着,每个人都有机会创作出自己真正想要的表达,离当一个导演也更近了。

「如果你带着期望进入 Sora,认为你只需要点击一个按钮就可以生成一部电影,那么我认为你的期望是错误的。」OpenAI 研究人员说道。

他表示,Sora 是一种工具,允许人们同时在多个地方、尝试多个想法,尝试以前完全不可能的事情,「实际上我们认为这是创作者的超级特殊延伸。」

02

不单独收费,

但生成数量有限制

作为文生视频赛道的开创者,Sora 的推出时间算是最晚的。对此,OpenAI 研究团队表示,为了对 Sora 进行广泛的部署,需要找到让模型更快、更便宜的办法。为此,研究团队做了大量的工作。

在直播中,OpenAI 宣布推出 Sora turbo,这是原始 Sora 模型的新高端加速版本。它具有今年早些时候 OpenAI 在「世界模拟技术」报告中谈到的所有功能,此外还增加了从文本生成视频、动画图像和混合视频等功能。这是此次 Sora 产品功能背后的技术基础。

看起来相比文字,视频的推理成本更高,但此次 OpenAI 并没有单独针对 Sora 收费。20 美元/月的 ChatGPT Plus 会员、以及 200 美元/月的 ChatGPT Pro 会员,都可以使用 Sora。

前者的权益包括最多 50 个高级视频、分辨率达 720p,时长为 5 秒,后者的权益包括最多 500 个高级视频、无限普通视频,分辨率高达 1080p、持续时间为 20 秒、并且下载无水印。

不同会员对 Sora 的使用额度 | 图片来源:OpenAI

Sora 对 OpenAI 的意义不止于此。团队发现,视频模型在大规模训练时会展现出许多有趣的新能力,使得 Sora 能够模拟现实世界中人、动物和环境的某些方面。「我们的结果表明,扩展视频生成模型是构建物理世界通用模拟器的一条有希望的道路。」

或许正是因此,让 Sora 尽快被大众用起来、用数据更好地训练世界模型,对于 OpenAI 最终的 AGI 梦想如此重要。

「这个版本的 Sora 会犯错误,它并不完美,但它已经到了我们认为它将对增强人类创造力非常有用的地步。我们迫不及待地想看看世界将用它来做什么。」缔造它的 OpenAI 如此说道。

03

MKBHD:

效果很棒、问题不少

知名科技博主 Marques Brownlee(MKBHD)在社交平台 X 上抢先爆料了 Sora 的发布消息,并展示了他参与测试期间生成的视频样例。这些视频展示了 Sora Turbo 在生成新闻主播形象、科技评测内容等场景中的高超表现。

MKBHD指出:

-

Sora 在捕捉高频细节方面表现卓越(视频看起来一点都不模糊),这是我认为它最令人惊艳的地方。

-

一如预期,Sora 对知名地标的还原效果非常棒——AI 生成定制“素材”镜头的潜力依然巨大。

-

物理效果还是很不自然(目前没有奇迹般的改进)——比如犀牛在地面上乱跑,手机像魔术般忽然出现又消失。

-

训练数据显然包含大量新闻素材——它能轻松生成夜间颗粒感的画面,毫无压力。

-

图像转视频的“再创作”功能挺有趣,但显然需要更好的用户界面支持,比如 可灵或 Runway 的动态绘图工具。否则操作起来会很混乱,就像在玩一场“拉老虎机”的运气游戏。

MKBHD 强调,尽管 OpenAI 对生成真人肖像、暴力及成人内容设立了严格限制,但 AI 视频生成技术的快速发展可能引发更广泛的社会讨论。他在评测中写道:“Sora 是一个令人惊叹的工具,但也提醒我们 AI 视频生成的力量需要被谨慎对待。”

04

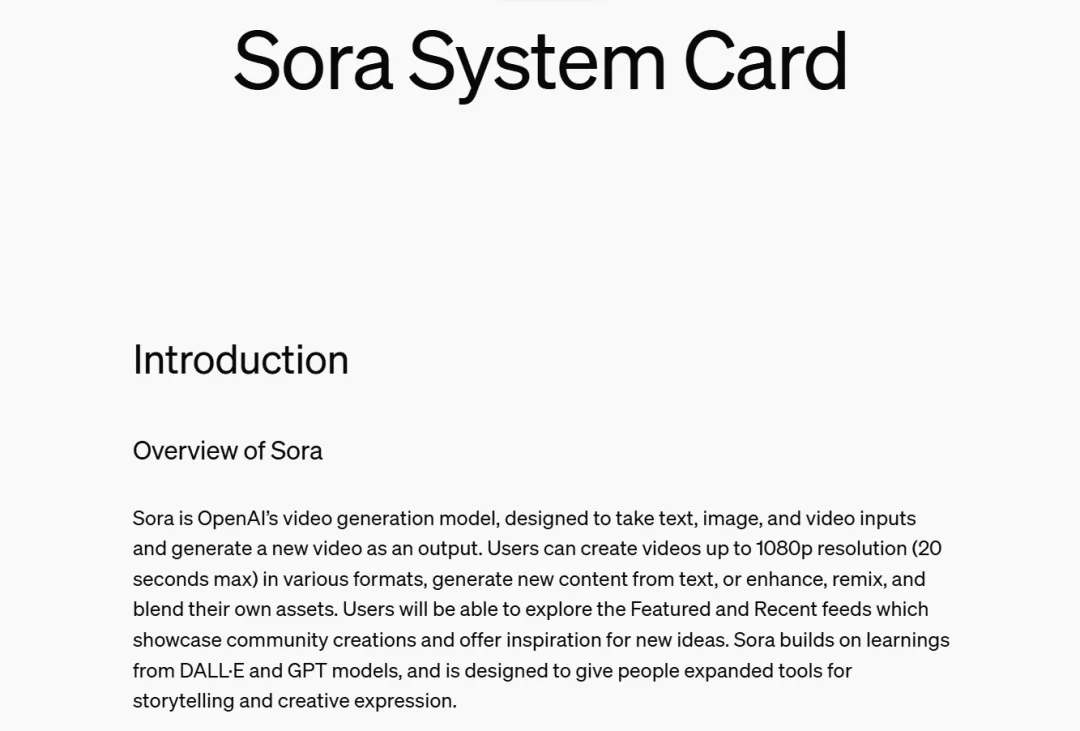

Sora System Card

在今年 2 月份,Sora 刚发布时,OpenAI 曾公布了 Sora 的技术报告。

OpenAI 认为,扩展视频生成模型是构建物理世界通用模拟器的一条有前途的途径。

今天随着 Sora 的正式发布,OpenAI 也放出了 Sora 的系统卡(System Card),感兴趣的开发者们可以深挖一下技术细节。

地址:https://openai.com/index/sora-system-card/

Sora 是 OpenAI 的视频生成模型,旨在获取文本、图像和视频输入并生成新视频作为输出。用户可以创建各种格式的高达 1080p 分辨率(最长 20 秒)的视频。

Sora 建立在 DALL・E 和 GPT 模型的基础上,旨在为人们提供创意表达的工具。

Sora 是一种扩散模型,它从看起来像静态噪声的基本视频开始生成新视频,通过多个步骤消除噪声来逐渐对其进行转换。通过一次为模型提供多帧预测,Sora 解决了一个具有挑战性的问题,即确保画面主体即使暂时离开视野也能保持不变。与 GPT 模型类似,Sora 使用 transformer 架构,释放出卓越的扩展性能。

Sora 使用 DALL・E 3 中的重描述(recaptioning)技术,该技术涉及为视觉训练数据生成高度描述性的字幕(captions)。因此,Sora 能够更忠实地遵循生成视频中用户的文本指令。

除了能够仅根据文本指令生成视频之外,该模型还能够获取现有的静态图像并从中生成视频,准确地将图像内容动画化并关注细节。该模型还可以获取现有视频并对其进行扩展或填充缺失帧。Sora 是能够理解和模拟现实世界的模型的基础,OpenAI 认为 Sora 将成为通往 AGI 的重要里程碑。

在数据方面,正如 OpenAI 在 2 月的技术报告中所述,Sora 从大型语言模型中汲取灵感,这些模型通过互联网规模数据的训练来获得通才能力。LLM 得以确立新范式,部分得益于创新了 token 使用的方法。研究人员们巧妙地将文本的多种模态 —— 代码、数学和各种自然语言统一了起来。

在 Sora 中,OpenAI 考虑了生成视觉数据的模型如何继承这种方法的好处。大型语言模型有文本 token,而 Sora 有视觉 patch。此前的研究已经证明 patch 是视觉数据模型的有效表征。OpenAI 发现 patch 是训练生成各种类型视频和图像的模型的可扩展且有效的表征。

在更高层面上,OpenAI 首先将视频压缩到较低维的潜在空间,然后将表征分解为时空 patch,从而将视频转换为 patch。

Sora 接受过各种数据集的训练,包括公开数据、通过合作伙伴获取的专有数据以及内部开发自定义数据集:

-

公开可用的数据。这些数据主要从行业标准的机器学习数据集和网络爬虫中收集。

-

来自数据合作伙伴的专有数据。OpenAI 建立合作伙伴关系来获取非公开数据。例如,与 Shutterstock Pond5 合作构建、提供人工智能生成的图像。OpenAI 还委托创建适合自己需求的数据集。

-

人工数据。来自人工智能训练师、红队队员和员工的反馈。

(文:Founder Park)