在人工智能和机器人技术迅速发展的当下,机器人在复杂环境中的任务规划与决策能力显得尤为重要。然而,现有的许多机器人系统在处理复杂任务时往往面临推理效率低下、决策不准确等问题。为了解决这一挑战,中科视语推出了LightPlanner,这是一个开源的轻量化具身推理大模型,旨在提升机器人在复杂任务中的推理和决策能力。本文将深入探讨 LightPlanner 的项目背景、技术原理、功能特点、应用场景以及如何快速上手使用,帮助读者全面了解这一前沿技术。

一、项目概述

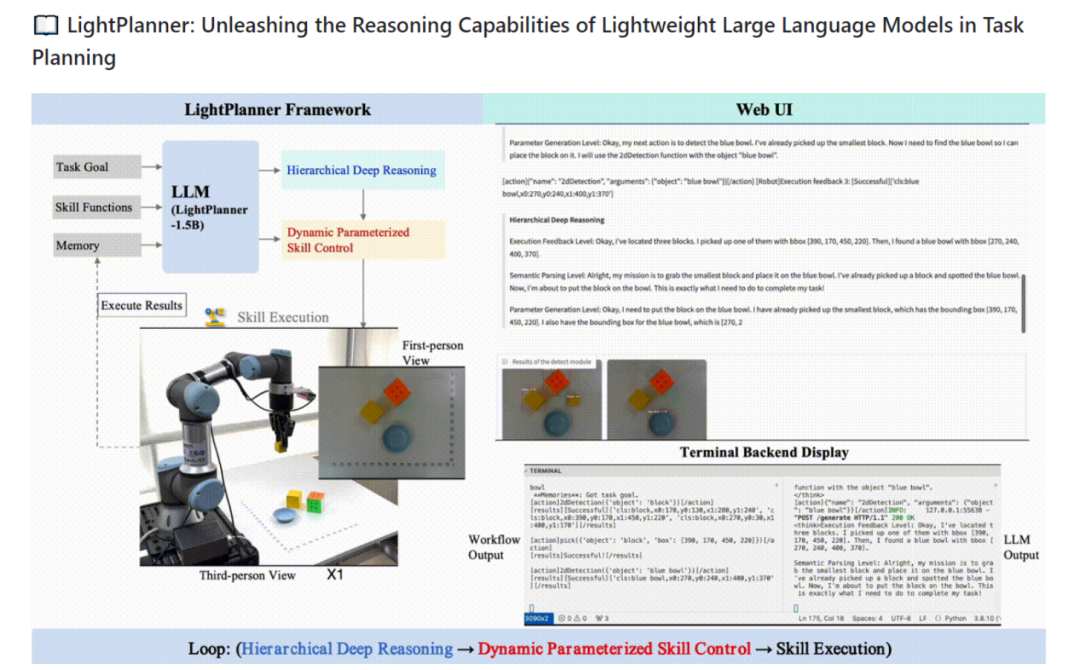

中科视语推出LightPlanner,是一个专为机器人设计的轻量化具身推理大模型,它的主要目标是开发一个轻量级、高效的具身推理模型,能够支持机器人在复杂环境中的任务规划和决策。具体目标包括:

1. 提升机器人在复杂任务中的推理效率,减少推理时间。

2. 提高机器人决策的准确性,减少错误决策。

3. 优化模型的资源占用,使其能够在边缘设备上高效运行。

二、技术原理

(一)层次化深度推理

LightPlanner 采用了层次化深度推理技术,模拟人类的决策逻辑。在每一步执行前,模型会触发三层验证,包括执行反馈、语义一致性和参数有效性。这种多层次的验证机制能够有效减少错误决策,实现“错误自愈”,从而提升模型的推理准确性和鲁棒性。

(二)参数化动态技能链

传统的具身推理模型通常依赖于固定的技能模板,这限制了模型在处理复杂任务时的灵活性。LightPlanner 引入了参数化动态技能链,突破了这一限制。通过上下文感知的函数调用机制,模型能够动态解析指令中的动态参数,从而执行需要视觉或空间推理的复杂具身任务。

(三)边缘设备友好架构

为了满足边缘设备的部署需求,LightPlanner 在大模型的输入端引入了动态更新的历史行动记忆模块,并结合迭代式上下文管理,显著降低了显存占用。这种架构优化使得 LightPlanner 能够在资源受限的边缘设备上高效运行,而不失推理性能。

三、功能特点

(一)高效推理能力

LightPlanner 在推理效率方面表现出色。实验结果显示,在真实世界环境中的具身决策规划任务中,尽管 LightPlanner 的参数数量最少,仅为 1.5B,但其任务成功率最高。在需要空间语义推理的任务中,其成功率比 ReAct 高出 14.9%。

(二)动态参数化技能控制

LightPlanner 支持动态参数化技能控制,能够根据任务需求动态调整技能参数。这种灵活性使得机器人能够更好地适应复杂多变的环境,执行各种复杂的具身任务。

(三)开源量化模型

为了促进技术的普及和应用,中科视语开源了LightPlanner 的量化模型。提供 0.9 到 2.7G 多种量化版本,这些模型在 Hugging Face 平台热度飙升,为研究人员和开发者提供了丰富的资源。

(四)丰富的数据集支持

LightPlanner 配套发布了 LightPlan-40K 数据集,这是首个具身决策深度推理数据集,覆盖动作序列长度为 2-13 的不同复杂度任务,总计包含 4 万个带有层次化深度推理的动作决策步骤。

四、应用场景

(一)物流领域

在物流仓库中,机器人需要高效地规划路径、搬运货物,并处理各种突发情况。LightPlanner 能够显著提升机器人在这些任务中的推理和决策能力,优化物流效率。

(二)制造业

在复杂的制造环境中,机器人需要执行高精度的组装和加工任务。LightPlanner 的动态参数化技能控制功能能够帮助机器人更好地适应这些任务,提高生产效率和产品质量。

(三)服务行业

服务机器人需要在动态环境中与人类进行交互,执行各种服务任务。LightPlanner 的高效推理能力和动态技能控制功能能够使服务机器人更好地适应这些需求,提供更优质的服务。

五、快速使用

(一)环境准备

在开始之前,请确保您已经安装了以下必要的软件和库:

– Python 3.10

– PyTorch 2.2.0

– LightPlanner 代码库

(二)安装步骤

1. 克隆代码库:

git clone https://github.com/unira-zwj/LightPlanner.gitcd LightPlanner

2. 安装依赖项:

pip install fastapi pydantic transformers torch asyncio gradio re如果您使用的是UR 机器人,还需要安装 `urx`:

pip install urx(三)硬件连接

1. UR 机器人和 Robotiq 夹爪:

– 将 UR 机器人的网络电缆连接到 Jetson(或 PC)。

– 将 Robotiq 的 USB 电缆插入 Jetson(或 PC)。

– 将 Inter D435 相机的 USB 连接到 Jetson(或 PC)的 USB 3.0 端口。

– 确保 UR 机器人的末端执行器与相机对齐,并在软件设置中配置坐标变换矩阵。

2. 设置 IP 地址:

– 将 UR 机器人的 IP 地址设置为 192.168.0.1。

– 将 Jetson(或 PC)的 IP 地址设置为 192.168.0.2(或确保与 UR 机器人在同一网段)。

3. 查询 Robotiq 的 tty 设备号:

– 通常为 `/dev/ttyUSB0`。

4. 设置坐标变换矩阵:

– 在 `lightplanner_callback_v2.py` 的第 110 行设置:

R_C_to_T = np.eye(3) # 从相机到工具的旋转矩阵t_C_to_T = np.array([-0.038, -0.065, -0.135]) # 从相机到工具的平移向量

5. 设置机器人的初始位置:

– 在 `lightplanner_callback_v2.py` 的第 106 行设置:

HOME_POSE = [-0.025, -0.32, 0.2, 0, 3.133, 0] # 垂直向下任务的初始位置HOME_POSE_H = [-0.025, -0.48, 0.15, 0, 2.24, -2.16] # 水平操作任务的初始位置

(四)模型下载

– 从 [Hugging Face](https://huggingface.co/lightplanner) 下载模型文件。

– 将下载的模型文件移动到 `checkpoints` 文件夹中,或者在 `llm-serve.py` 的第 24 行更改模型路径。

(五)启动服务

1. 启动 FastAPI 服务:

uvicorn llm-serve:app --host 0.0.0.0 --port 80002. 启动 Web 界面:

python web-v2.py(六)使用示例

1. 发送请求:

– 打开浏览器,访问:http://localhost:8000。

– 在 Web 界面中输入指令,例如:

In: What action should the robot take to {<INSTRUCTION>}?Out:

– 模型将生成相应的动作指令,并显示在界面上。

六、结语

LightPlanner 作为中科视语推出的开源轻量化具身推理大模型,凭借其层次化深度推理技术、参数化动态技能链和边缘设备友好架构,在机器人任务规划和决策领域取得了显著的成果。通过提升推理效率和决策准确性,LightPlanner 为机器人在复杂环境中的应用提供了强大的支持。随着技术的不断发展和开源社区的贡献,LightPlanner 有望在物流、制造、服务等多个领域发挥更大的作用,推动机器人技术的发展和普及。

项目主页:https://github.com/unira-zwj/LightPlanner

AI大模型+具身智能2025·系列

1.RoboMamba:推理速度提升7倍,北大如何打造高效机器人多模态大模型?

2.斯坦福团队开源!OpenVLA:小白也能搞机器人,100条数据就能微调!

3.CMU×上交大搞出「全能机器人」!开放场景任务成功率超90%

(文:小兵的AI视界)