如果要说AI行业有哪些项目是真的赚了钱。

克隆数字人,音频驱动口型生成视频,绝对算是其中之一。

前有Heygen拿到融资立马带整个团队出去,现在也市值几万美金;后有Heygem开源,让大家用上了免费的数字人。

今天给大家推荐的是一个音频驱动图片中人物口型,生成视频的项目。

阿里、高德、北京邮电大学团队共同开发的FantasyTalking。

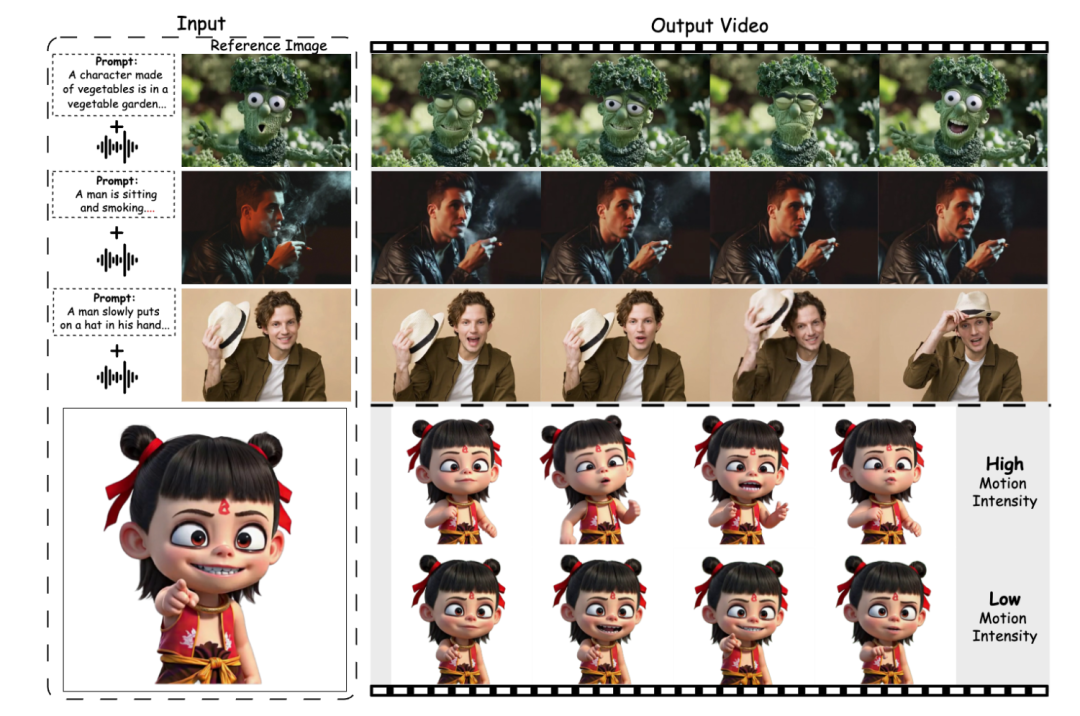

FantasyTalking 还可以控制动态肖像的运动强度。

扫码加入AI交流群

获得更多技术支持和交流

(请注明自己的职业)

项目简介

FantasyTalking 是一款先进的音频驱动肖像动画生成技术,能够从单一静态肖像生成高逼真的动态视频。它支持通过音频信号控制表情、唇部动作和身体姿态,生成自然流畅的动画,适用于游戏、影视和虚拟现实场景。用户可灵活调节动作强度,打造个性化动画效果。基于约15万视频片段训练,生成效果在多样性和真实感上达到业界领先水平。

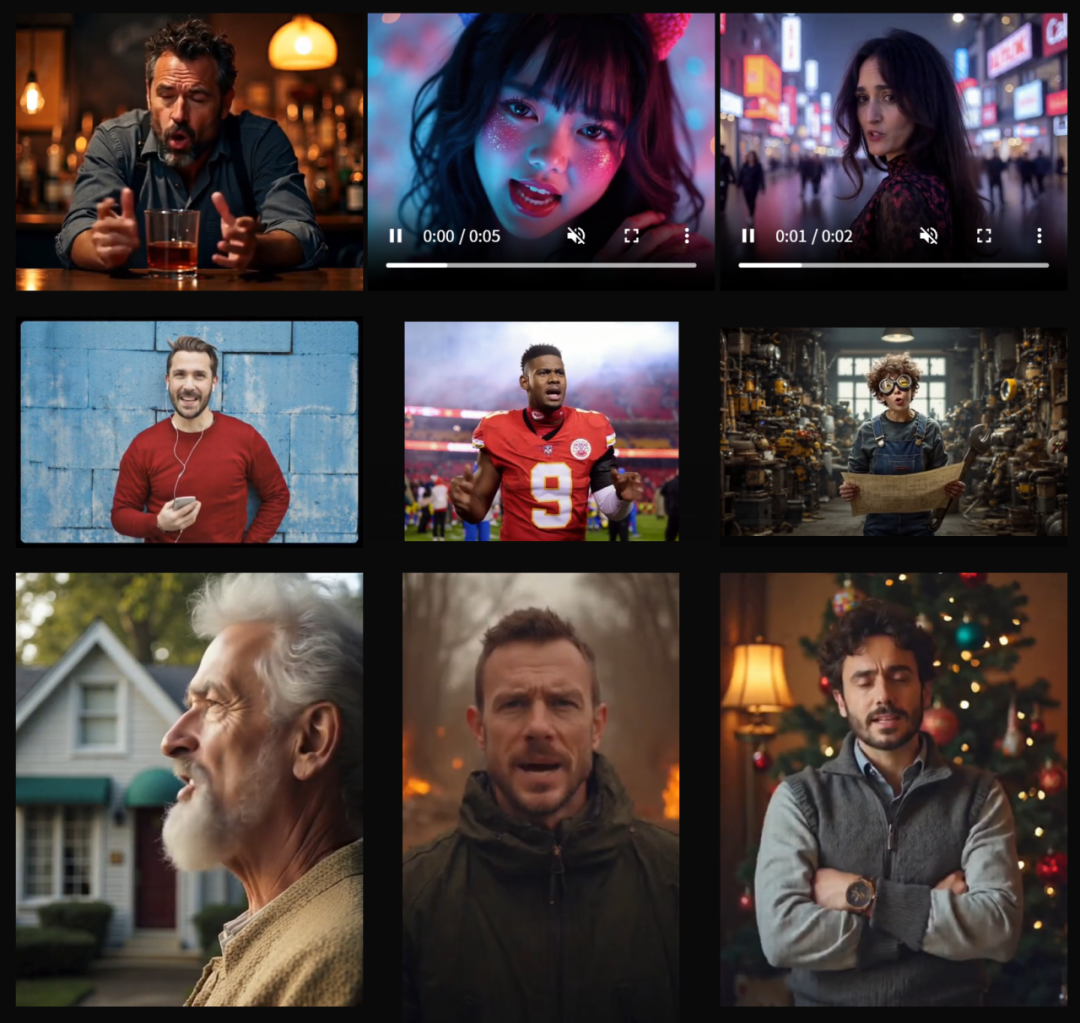

DEMO

功能特点

1、生成的视频

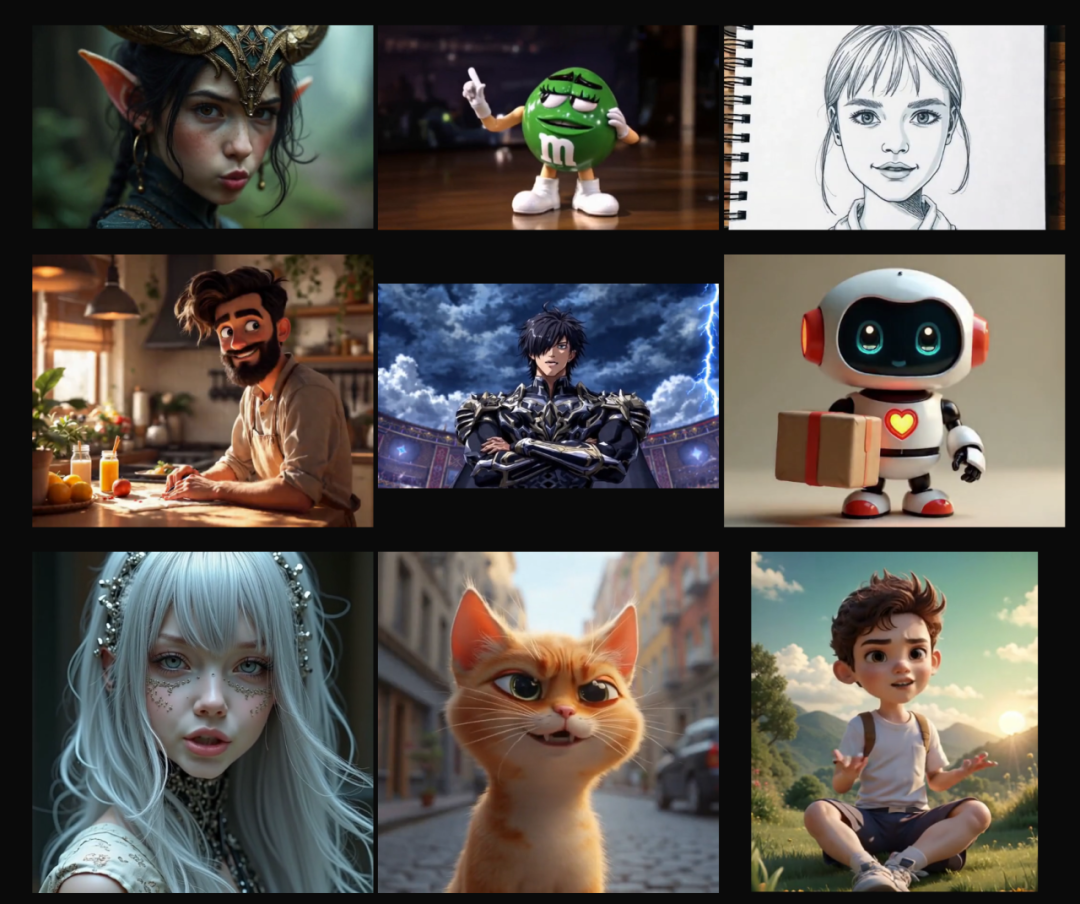

FantasyTalking 可以生成高度逼真的唇部同步效果,确保角色的嘴部动作与音频完全匹配。支持各种风格的虚拟角色,无论是写实风格还是卡通风格,都能生成高质量的对话视频。

2、逼真的谈话视频

FantasyTalking 支持生成各种身体范围和方向的逼真说话视频,包括特写肖像、半身、全身以及正面和侧面姿势。

3、多样化角色风格

FantasyTalking 能够以多种风格为角色和动物制作动画,生成充满动感、富有表现力且自然逼真的风格化视频。

技术特点

-

双阶段音视频对齐:首阶段通过剪辑级训练捕捉全局运动,包括肖像、背景及上下文对象;次阶段利用唇部追踪掩码精炼唇部动作,确保音视频精准同步。

-

面部聚焦跨注意力模块:取代传统参考网络,聚焦面部区域建模,通过 ArcFace 和 Q-Former 提取并对齐身份特征,有效保持视频中身份一致性。

-

运动强度调制网络:通过 MediaPipe 和 DWPose 提取面部表情和身体动作系数,实现对表情和身体运动幅度的可控调节。

-

基于扩散变换器(DiT):采用 Wan2.1 架构,结合 3D VAE 和 UMT5,增强视频生成的时间空间建模能力,提升生成质量和多样性。

-

高效训练与评估:利用约 15 万过滤视频片段训练,结合 Flow Matching 和多维度评估(FID、FVD、Sync-C/D 等),在视频质量、唇部同步和运动多样性上达到 SOTA 水平。

项目链接

https://github.com/Fantasy-AMAP/fantasy-talking

关注「开源AI项目落地」公众号

(文:开源AI项目落地)