大模型的困境:能力越强,成本越高!

LLM 虽然能解数学题、答冷知识,但运行成本极高,好比“雇一个年薪百万的博士随时待命”。

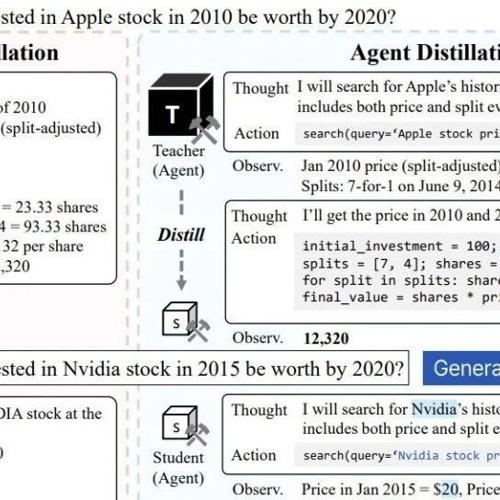

展示了LLM如何通过思维链(CoT)解答“100美元投资苹果股票”的问题,但普通用户根本用不起这样的“豪华配置”。

论文:Distilling LLM Agent into Small Models with Retrieval and Code Tools

链接:https://arxiv.org/pdf/2505.17612

小模型的痛点:学不会、记不住、算不准

传统方法让小模型模仿大模型的“解题步骤”(CoT蒸馏),但小模型容易“开脑洞”——比如硬背答案却不会查资料,或强行心算导致错误。

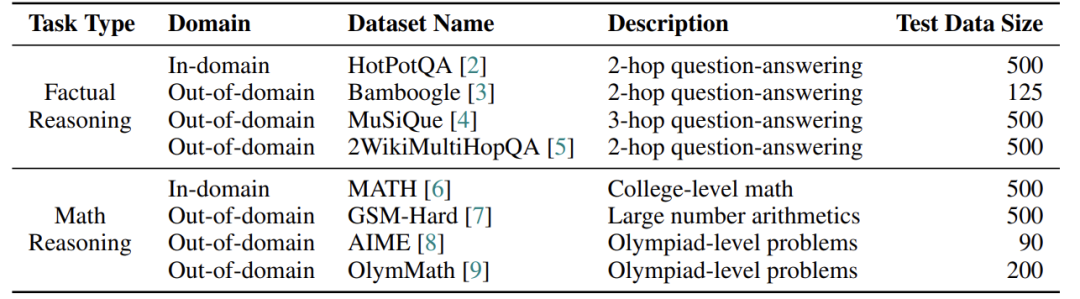

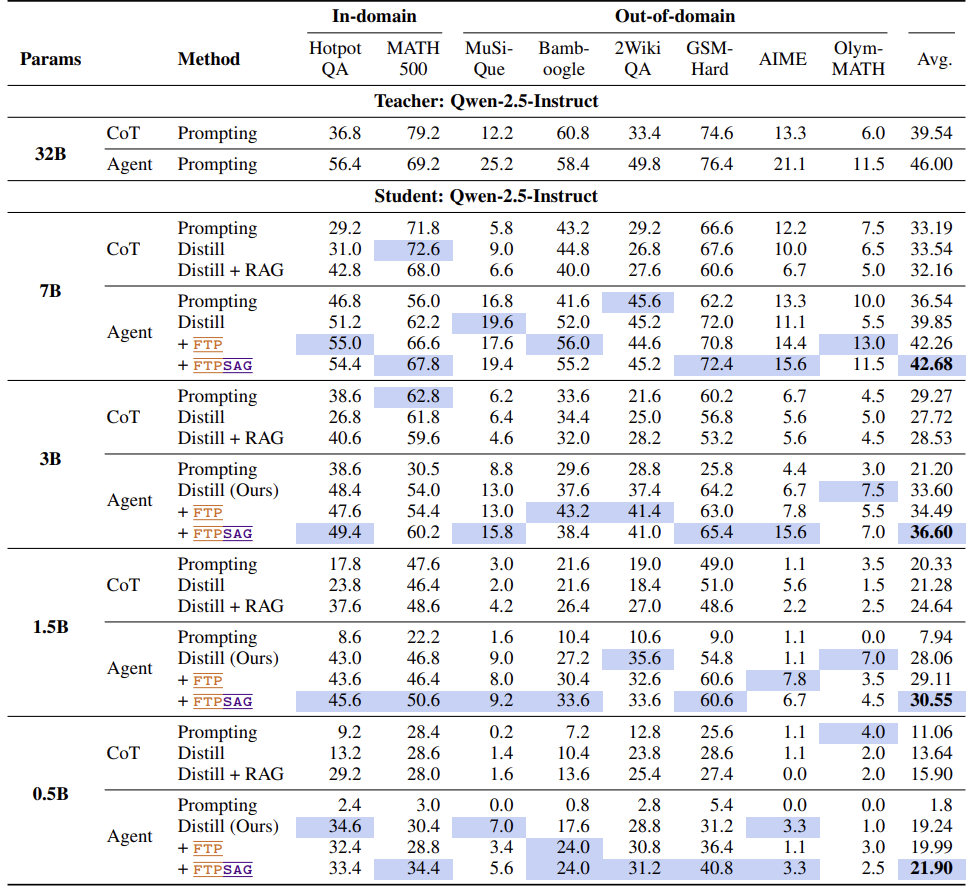

列出的8个测试任务中,小模型在复杂数学题和多跳知识问答上频频翻车。

Agent蒸馏:让小模型学会“用工具”

论文提出Agent蒸馏:不再让小模型死记硬背,而是教它像人类一样用工具!比如:

-

检索工具:查资料代替硬记(比如搜“几何之父是谁”) -

代码工具:写代码做计算(比如用Python算复利)

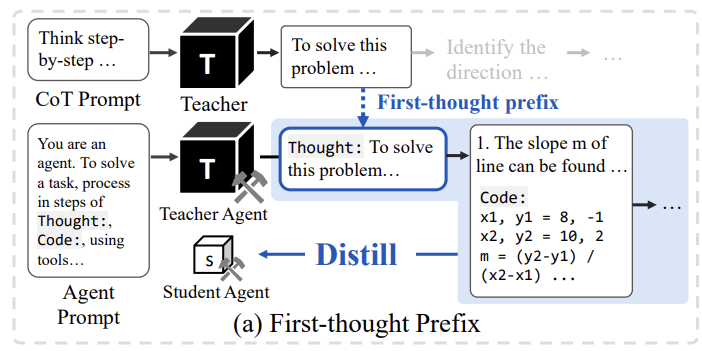

对比了传统CoT蒸馏和代理蒸馏的区别,后者让小模型学会“动手解决问题”。

方法:首思前缀 + 自我纠错

为了让小模型学得更好,作者加了两个“外挂”:

-

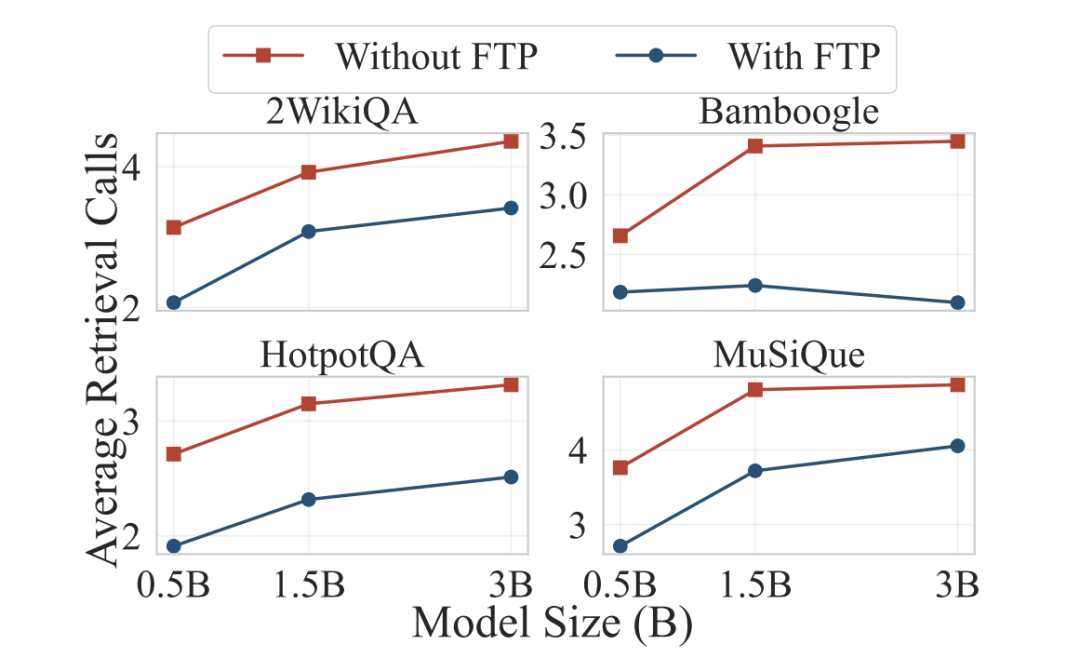

首思前缀(FTP):让大模型先写“解题大纲”,再生成具体步骤。比如解方程时,先写“第一步:整理方程形式”,避免小模型一上来就跑偏。

-

自我纠错(SAG):让小模型生成多个方案,选最靠谱的那个。比如写代码时,先试8种写法,排除报错的,再投票选正确答案。

结果:小模型性能直逼大模型

显示,经过Agent蒸馏的0.5B小模型(参数仅5亿),在投资计算、多跳问答等任务上,性能直接追上传统方法训练的1.5B模型(15亿参数)。3B小模型甚至超越7B大模型!

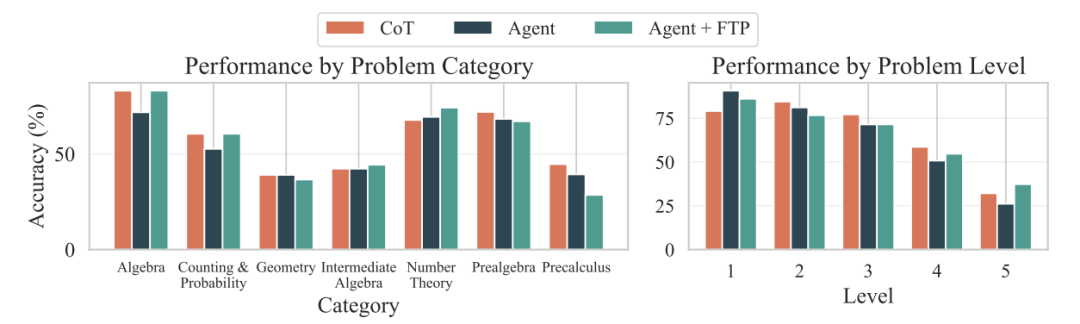

进一步分析:Agent蒸馏让小模型在高难度数学题(如奥数题)上表现更稳,靠代码工具解决了复杂计算。

展望:低成本Agent的时代来了

论文证明,小模型也能“四两拨千斤”——只要学会用工具,就能在手机、平板上运行智能助手,甚至替代部分大模型场景。未来若结合强化学习,小模型还能在更复杂任务中进化。

(文:机器学习算法与自然语言处理)