编辑:泽南

端侧大模型,正在发生质变。

端侧语言模型,终于迎来了脱胎换骨式的创新。

上周五,2025 智源大会上,国内知名 AI 创业公司面壁智能正式发布了旗下最新一代「小钢炮」模型 MiniCPM 4.0,一下子把 AI 的发展推到了「前进四」。

在发布会上,面壁智能 CEO 宣布 MiniCPM 4.0 实现了行业首个系统级上下文稀疏语言模型创新,实现了 5% 的极高稀疏度,能够在端侧跑起长文本推理,开启了端侧长文本时代。

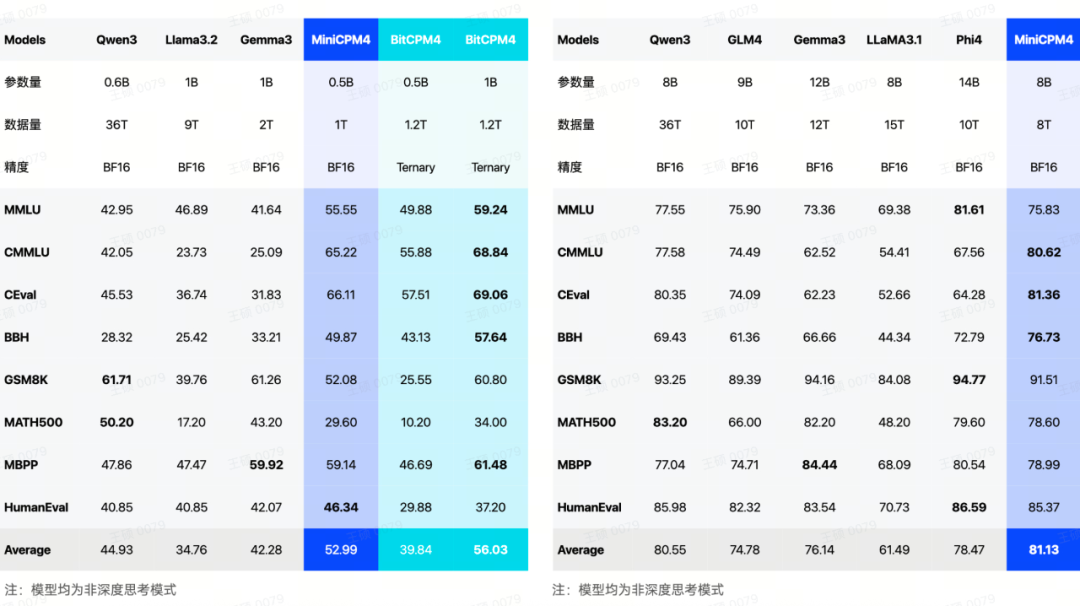

本次发布的 MiniCPM 4.0 分为 8B 和 0.5B 两个参数版本,均刷新了端侧模型能力的上限。

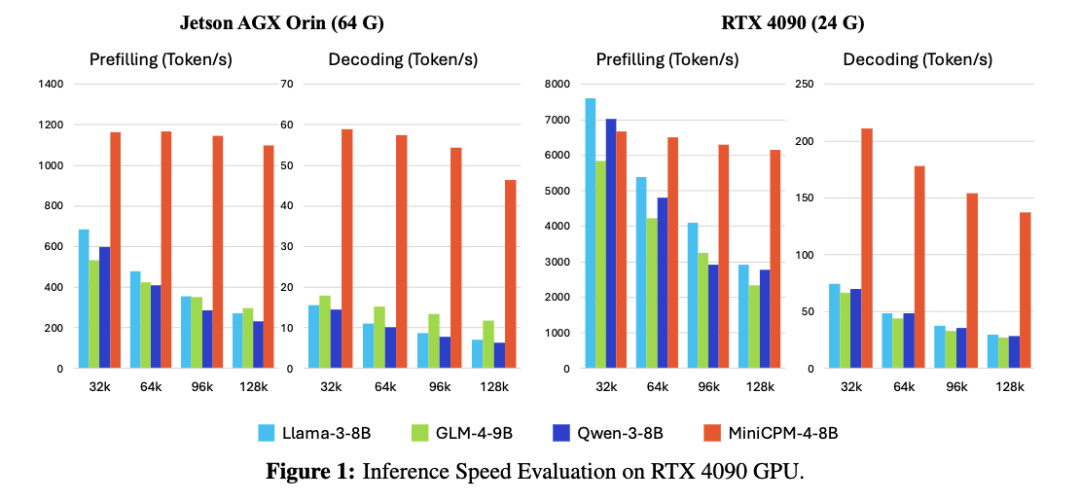

据介绍,通过架构、算法、数据及系统层面的多维度创新,新一代上下文稀疏高效架构模型 MiniCPM 4.0 8B 相较于 Qwen-3-8B、Llama-3-8B、GLM-4-9B 等同体量模型实现了长文本推理速度稳定 5 倍,极限场景下最高 220 倍加速,实现了同级最佳模型性能。同时进一步实现了长文本缓存的大幅锐减,在 128K 长文本场景下,MiniCPM 4.0-8B 相较于 Qwen3-8B 仅需 1/4 的缓存存储空间。

模型、预训练数据和端侧推理框架均已开源。

-

GitHub 链接:https://github.com/openbmb/minicpm

-

技术报告:https://github.com/OpenBMB/MiniCPM/blob/main/report/MiniCPM_4_Technical_Report.pdf

-

Huggingface 链接:https://huggingface.co/collections/openbmb/minicpm-4-6841ab29d180257e940baa9b

-

Model Scope 链接:https://www.modelscope.cn/collections/MiniCPM-4-ec015560e8c84d

MiniCPM 4.0 系列在卫冕全球最强端侧模型的同时,也让我们看到了继 DeepSeek 之后大模型领域又一次源自底层架构的技术突破。

速度提升百倍

端侧最强,以小博大

MiniCPM 4.0 的提升可以说是全方位的,在端侧推理的各项任务上,它再次巩固了面壁「小钢炮」系列模型的领先地位。

面壁智能报告说,MiniCPM 4.0-8B 在 MMLU、CEval、MATH500、HumanEval 等 AI 领域流行的基准测试中,性能对标 Qwen-3-8B,超越 Gemma-3-12B。

面向更多端侧设备的小体量语言模型 MiniCPM 4.0-0.5B,可以实现每秒 600 token 的高速推理,性能也超越了 Qwen-3 0.6B。

要知道,4 月刚推出的 Qwen3-0.6B 模型性能已经超越了 Gemma 4B。这样的以小打大让我们喜闻乐见,意味着未来更多应用可以用得起大模型。

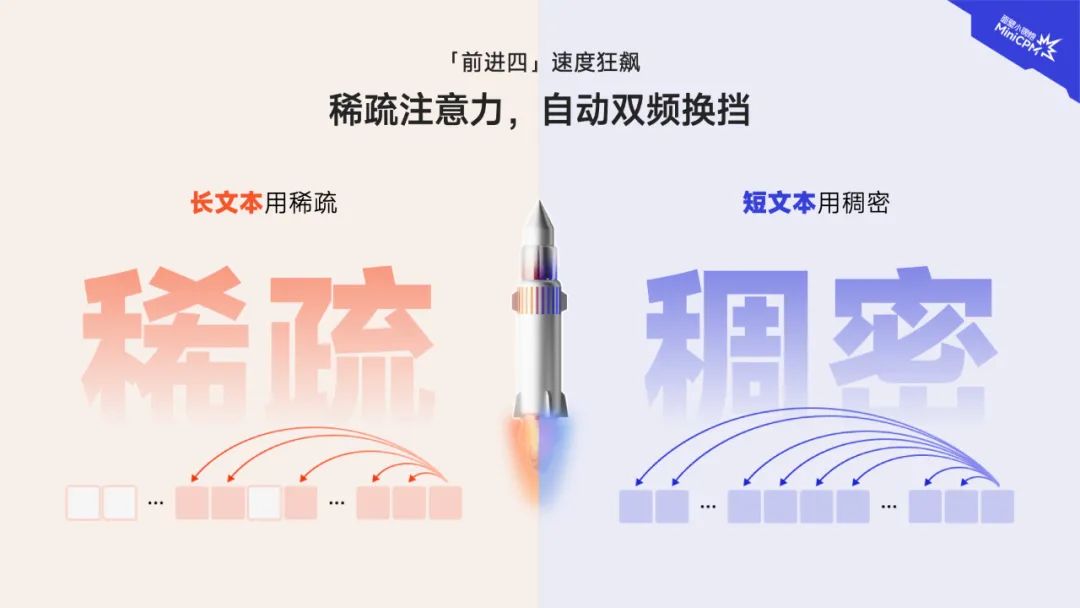

为了进一步提升效能、适应更多场景,面壁为新模型设计了「高效双频换挡机制」,让模型能够根据任务特征自动切换注意力模式:处理长文本、深度思考任务时启用稀疏注意力以降低计算复杂度,在短文本场景下切换稠密注意力以确保精度,这样一来,就可以在不同任务上均实现高效响应。

MiniCPM 4.0 也大幅降低了长文本任务的缓存需求。在 128K 场景下,MiniCPM 4.0-8B 相较于 Qwen3-8B 仅需 1/4 的缓存存储空间。

此外,MiniCPM 4.0 进一步提高了运行效能。从算法、系统到硬件推理,它是首个打通端侧全链条自研的大模型,真正做到了可落地的系统级软硬件稀疏化。

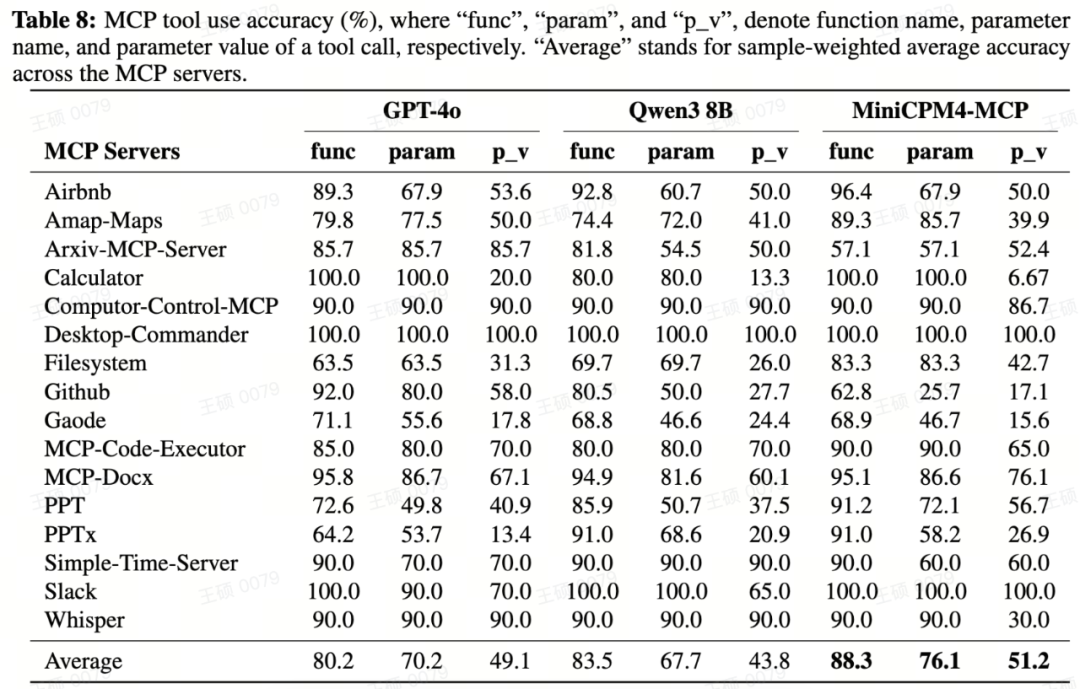

基于 MiniCPM-4.0,面壁智能继续强调其面向应用端的优势:这代小钢炮模型已在英特尔、高通、联发科、华为昇腾等主流芯片平台上完成适配,可在 vLLM、SGLang、llama.cpp、LlamaFactory、XTuner 等开源框架部署,并加强了 MCP 支持,保证了模型应用的便捷性。

看起来在端侧小模型技术突破后,各家厂商手机、车机内置的 AI 端侧模型可能很快就会迎来一波更新,不少 App 要被「重写一遍」了。

强悍性能背后

面壁实现架构级创新

众所周知,最近一段时间 DeepSeek 引领了 AI 领域的技术突破,其 V3、R1 等模型在架构上的创新大幅提升了 AI 的深度思考能力。

如今,强推理、长文本处理等高阶能力已成为大模型应用的标配:只有在模型能够很好理解长文本结构和语义之后,生成的内容才能拥有更好的一致性;在应用上,长文本理解也意味着 AI 能够成为真正的「个人助理」,能够记住更多的个人信息上下文。

而只有把模型部署在端侧,才能降低 AI 反应的延迟,在保证个人数据安全的情形下构建起未来的智能化产品。

「如今的云端大模型技术在应用层面上还存在一些局限,我们使用它们就像是在用过去的搜索引擎,」面壁智能联合创始人、首席科学家刘知远表示。「如果说 AI 最终的目标是 AGI(通用人工智能),那么它的形态就应该会像钢铁侠里的贾维斯一样,知晓你的个人信息,了解你的偏好。这些事情都是需要大模型长期记忆来实现的。」

但另一方面,如何在端侧跑起这样的高智商 AI,成为了摆在工程师面前的新挑战。

在 MiniCPM-4 的技术报告中,面壁工程师们介绍了其对于端侧模型架构、训练数据、训练算法和推理系统四个关键维度的系统性创新。

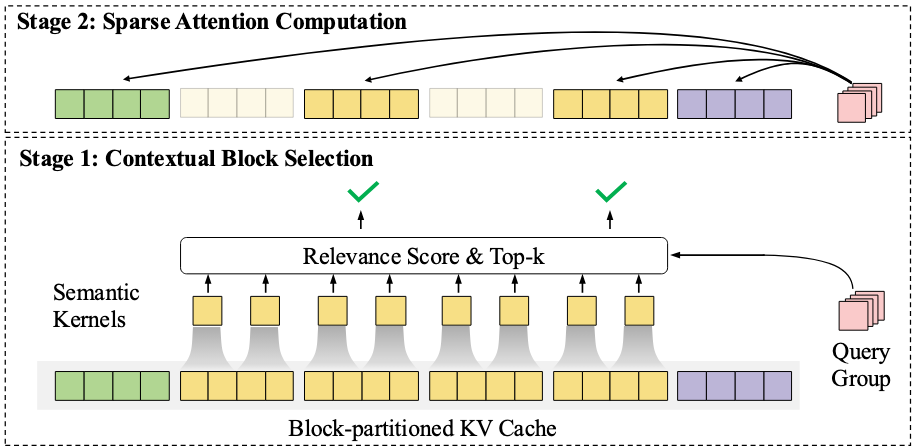

在模型架构方面,面壁提出了 InfLLM v2,这是一种可训练的稀疏注意力层,能同时加速长上下文处理的预填充和解码阶段,在保持模型性能的同时,实现了高效的长文本处理。

对于长上下文内容处理来说,InfLLM 在 AI 领域已经获得了认可。去年 2 月,面壁智能联合创始人、清华刘知远团队发表的初代 InfLLM 讨论了稀疏注意力的改进。今年 2 月,DeepSeek 展示的长文本处理架构 NSA(Native Sparse Attention)也采用了相同思路,并在其论文中引用、对比了 InfLLM。

不过此前业内的方法对于短文本推理速度仍然较慢,InfLLMv2 的出现解决了短文本推理的短板,其混合稀疏注意力结构再次升级,改变了传统 Transformer 模型的相关性计算方式。它在对文本进行分块分区域处理后,会通过智能化选择机制,只需对最相关的重点区域进行注意力计算「抽查」。

相比于 v1 版本,InfLLMv2 构建了更精准的上下文查询机制,实现了高效的训练与推理算子,将稀疏度从行业普遍的 40%-50% 降至 5%,仅需 1/10 的计算量即可完成长文本计算,效率提高了一大截。

在推理层面上,MiniCPM 4.0 通过自研的 CPM.cu 推理框架、BitCPM 极致低位宽量化、ArkInfer 自研跨平台部署框架等技术创新实现端侧推理加速。

其中推理框架 CPM.cu 做到了稀疏、投机、量化的高效组合,实现了 5 倍速度提升。其中,FR-Spec 轻量投机采样类似于小模型给大模型当「实习生」,并给小模型进行词表减负、计算加速。通过创新的词表裁剪策略,让小模型专注于高频基础词汇的草稿生成,避免在低频高难度词汇上浪费算力,再由大模型进行验证和纠正。

BitCPM 量化算法,实现了业界 SOTA 级别的 4-bit 量化,探索了 3 值量化(1.58bit)方案。通过精细的混合精度策略和自适应量化算法,模型在瘦身 90% 后仍能保持出色性能。

ArkInfer 跨平台部署框架则面向多平台端侧芯片优化,实现了大平台的高效投机采样和限制编码,确保端侧多平台 Model zoo 丝滑使用。

在模型训练和数据层面,面壁提出了 UltraClean,一种高效准确的预训练数据过滤和生成策略,实现了 90% 的验证成本下降,其针对互联网语料建立了严格的准入机制,只有能够真实提升模型性能的数据才能被纳入预训练语料中。利用轻量化的 FastText 工具进行大规模数据质检,在工作流程中处理 15 万亿 token 数据仅需 1000 小时 CPU 时间。

面壁利用 UltraChat-v2 合成了百亿 token 的高质量对齐数据,针对知识类、指令遵循、长文本、工具使用等关键能力进行强化。

在 MiniCPM 4 系列中,面壁应用了「模型风洞」ModelTunnel V2,能够实现更高效的训练策略搜索。先在小模型(0.01B-0.5B)尺度上进行的训练实验,再迁移到更大的模型上。在 MiniCPM 4 上,面壁优化了小模型的搜索次数,相比于风洞 v1,只需一半的实验次数就能完成最优配置搜索。

在高质量数据与高效训练策略的加持下,相比同尺寸开源模型(Qwen-3 8B),MiniCPM 4.0 仅用 22% 的训练开销,就达到了相同的能力水平。

通过多维度的优化,MiniCPM 4 真正实现了行业内唯一的端侧全流程优化,成为了 AI 领域探索高效率语言模型的又一里程碑。

面壁报告说,通过进一步的适配,MiniCPM 4 成功支持了各种应用,包括可信调查问卷生成、基于模型上下文协议的工具使用,充分展现了其广泛的可用性。

今年是大模型应用爆发的一年,作为创业公司的面壁坚持构建基座模型,为未来的智能端侧应用打好了基础。

面壁的高效率模型探索

DeepSeek 之外的另一条路径

随着大模型技术竞争螺旋上升,扩展定律(Scaling Laws)驱动的方式已进入深水区。一方面模型越来越大的参数量正在撞向算力、并行化的瓶颈,另一方面参与训练的数据体量也在挑战着各家公司的获取与处理能力。在这样的情况下,长期钻研模型新形态的一小部分玩家逐渐站到了台前。

国内 AI 创业队伍中,DeepSeek 已经因为 V3、R1 大模型的创新推动了全球大模型技术的一轮进步,而在端侧模型这一方向上,受到目光聚焦的一直是面壁。

有趣的是,面壁与 DeepSeek 走的都是从硬件协同优化开始,全流程的高效率强推理大模型道路。与 DeepSeek 着重强化模型能力上限,云端部署方向不同的是,面壁团队一直以来不断探索针对端侧的稀疏化方案。

提升 AI 效率,降低使用成本,是面壁智能成立的初衷。随着 Transformer 架构成功,语言模型规模不断扩大,人们一直在寻求更有效的模型范式,模型稀疏化被认为是一种很有前途的解决方向。面壁是国内最早探索稀疏化道路的团队,其研究一直在引领业界。

早在 2019 年,面壁创始团队就开始探索稀疏 FFN 方面的工作,其研究被谷歌、苹果等公司跟进。

2021 年 6 月,该团队参与发布了千亿参数级高效易用大模型 MoE 大模型 CPM-2 。同年,面壁团队在《MoEfication:Transformer Feed-forward layers are Mixtures of Experts》工作中提出将稠密模型转化为等参数量的 MoE 模型能够实现大幅度推理加速。

2024 年 7 月,面壁开源了 MiniCPM-S 模型,其采用稀疏激活的方式,能够在同等参数条件下减少大模型的推理能耗。

去年底,清华、面壁团队又提出了类脑高效稀疏架构 Configurable Foundation Model,革新了以往的 MoE 架构,强调将大模型根据功能拆解为若干模块,通过模块的检索、组合、更新、增长实现复杂能力。从实现的效果上看,新架构对于大模型「知识密度」提升显著,也对端侧模型低能耗推理能产生了推动作用。

从更广泛的角度看,虽然科技巨头纷纷在为大模型加码云端算力设施,但能将先进模型部署在端侧,引入全球超过 70 亿智能手机,以及未来的 AI PC、智能车机,其重要性同样不言而喻。

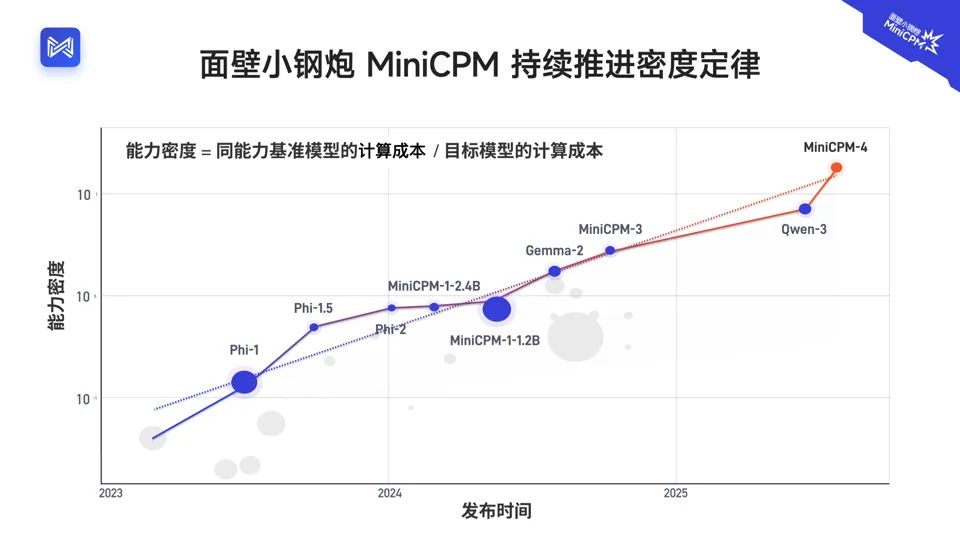

有趣的是,在最近一系列研究中,面壁研究人员已经总结出了大模型的密度定律「Densing Law」,认为随着技术的不断演进,语言模型的能力密度平均每 100 天翻一番,人们还可以不断训练出计算更加高效,性能更加强大的基础大模型。

MiniCPM-4.0 将 A I 能力密度推进到了更高的节点,与 DeepSeek R1 在模型能力上的高点遥相呼应。

朝着这个方向,面壁计划会在近期继续推出更多 MiniCPM 系列基础模型,以及多模态模型。

下一代小钢炮,还会为我们带来更大的惊喜。

©

(文:机器之心)