系统UI靓眼,AI略显不足,这就是观众看完WWDC演讲的感受!

北京时间6月10日凌晨,苹果全球开发者大会(WWDC)正式拉开帷幕。尽管外界高度期待苹果在AI领域带来突破,苹果也花了1个半小时大谈AI,但本次大会的AI相关发布却略显保守,尤其是AI增强版Siri并未如期亮相,让许多期待落空。

在演讲过程中,苹果极力强调操作系统在视觉方面的进步。苹果宣称,现在iPad可以像传统Mac一样工作。但整体来看,发布会平平无奇。Wedbush Securities分析师Daniel Ives直言不讳称,发布会很平淡,投资者耐心被耗光。

苹果软件工程高级副总裁Craig Federighi告诉听众:“Siri功能需要更多时间才能达到高质量标准。“他透露,苹果将在未来一年陆续公布更多AI相关进展,但AI增强版Siri的正式推出可能要等到2026年。

此前,苹果曾暗示将推出更智能、更个性化的Siri,甚至支持在第三方App内执行任务。然而,这些功能的落地时间显然比预期更晚。尽管如此,在WWDC上,苹果还是在AI方面展示了一些值得关注的进展,包括iOS 26在AI方面的渐进式改进。

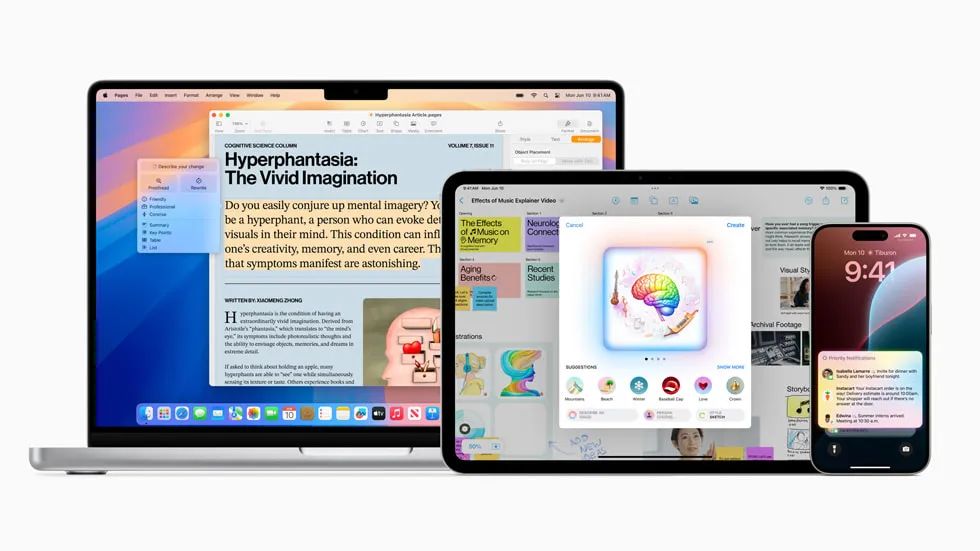

最新版操作系统iOS 26将于今年秋天亮相,此次更新集中呈现了苹果AI成果,涵盖支持更多语言的实时翻译功能、与ChatGPT整合的全新Genmoji功能,以及备受瞩目的Liquid Glass设计语言。

——第一项更新:Liquid Glass

Liquid Glass本质上是一套深度集成Apple Intelligence的设计语言,其核心优势在于能实现跨设备的无缝协作。该设计语言致力于为用户带来多设备统一的视觉体验,具体体现在半透明玻璃质感面板、悬浮式菜单、圆角设计以及动态反射效果等细节之中。

以Safari浏览器为例,苹果对其进行了半透明处理优化。用户在浏览网页时,内容可覆盖整个屏幕,当滚动页面时,浏览器标签栏会自动隐藏,带来更沉浸的浏览体验。

苹果之所以推出Liquid Glass,主要是想通过Liquid Glass在整个产品系列中打造统一的外观风格。未来,无论是工具栏、应用程序界面还是控制面板,都将具备透明且富有光泽的视觉效果。

彭博社指出:“Liquid Glass界面是今年WWDC最令人兴奋的亮点。不过,这也可能让用户与苹果的现实处境产生某种疏离感。在AI领域,苹果处于追赶者的位置,这是不争的事实,但WWDC正试图改变这一形象,哪怕只是一点点。竞争对手已开始转向AI界面,iOS固然是成功的,苹果也并未停滞不前,正努力让系统变得更强大、更流畅。”

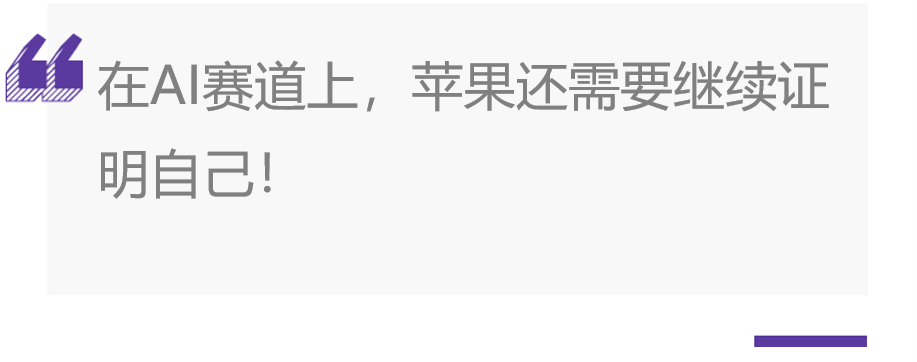

——第二项更新:Live Translation翻译功能

Live Translation功能借助AI技术实现文本信息的自动翻译,在FaceTime通话时可实时生成翻译字幕。当用户使用iPhone通话时,若对方说外语,手机屏幕会自动显示翻译后的字幕。

苹果三大核心程序Phone、FaceTime、Messages均已支持翻译功能,iPad群聊场景也纳入了翻译支持范围。

该翻译功能无需依赖云计算,直接调用设备上的AI模型即可完成翻译操作。即便用户拿着iPhone与其他品牌的智能手机通话,同样能实现翻译功能,不过苹果目前暂未公布具体支持的语言列表。

——第三项更新:Genmoji与Image Playground的优化

在苹果升级Apple Intelligence的进程中,表情符号Genmoji和图乐园Image Playground也得到优化。

苹果与ChatGPT展开合作,将图像生成功能引入Image Playground应用程序,使用户能够自行制作AI图片。

当用户以朋友形象为灵感制作表情符号时,可对特征进行调整,例如改变发型,使其与朋友的外表更加匹配。

——第四项更新:Visual Intelligence

Visual Intelligence作为苹果重点宣传的功能,让用户在App中看到任何内容时,都能搜索并采取行动。比如用户查看图片时,若对图中的台灯感兴趣,点击即可触发搜索,甚至能引导至购物网站完成购买。

当视觉智能识别到用户正在关注某一事件时,会主动建议将该事件添加到日程表,为用户提供更便捷的智能服务。

在WWDC上,苹果正式推出名为Foundation Models Framework(基础模型框架)的软件工具包,开发者可借助该框架利用AI大语言模型开发App。

Craig Federighi表示:“我们认为,这个工具包将催生一系列全新的智能体验,这些体验将融入用户日常使用的各类程序中。“

苹果在官网介绍称:“在2025年WWDC上,我们推出新一代语言基础模型,它能够在最新的苹果软件上增强Apple Intelligence功能。同时,我们还推出一个基础模型框架,通过该框架,开发者可以在Apple Intelligence内核中调用基于本地设备的基础语言模型。“

通过该模型框架,开发者能够提升工具使用和推理能力,深入理解用户输入的图片和文本内容,并且实现更快的处理速度。

苹果工程师已对最新的基础模型进行优化,使其能够在苹果芯片上高效运行。另外,苹果为该框架提供多个模型支持,其中包括一个参数量约为30亿的端侧语言模型(可直接在手机等终端设备上运行),以及一个更大的基于服务器的语言模型(性能可与GPT-4对标)。

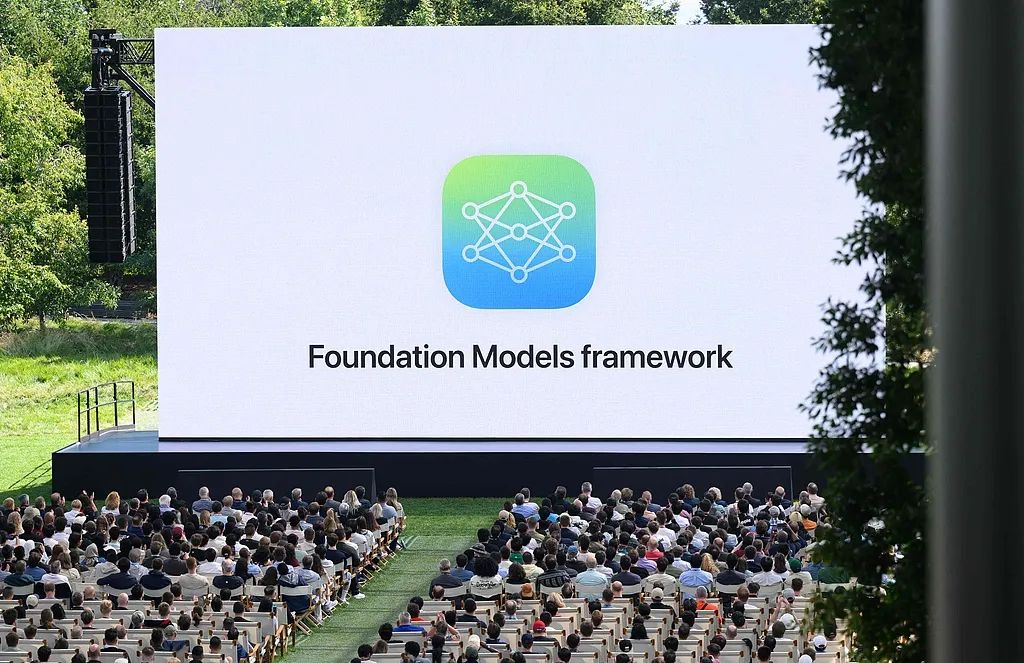

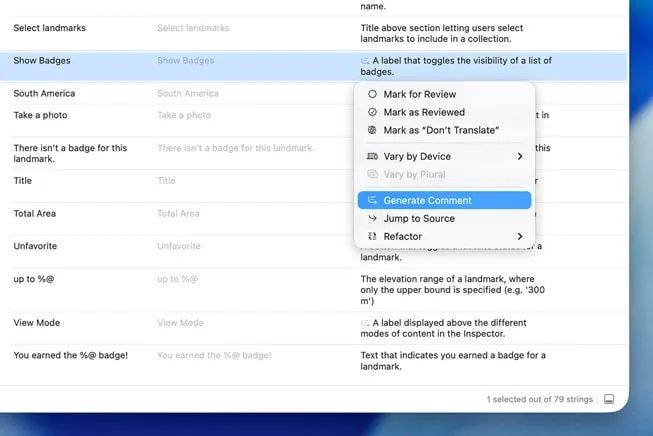

除基础模型框架外,Xcode 26与Swift 6.2也成为开发工具箱的重要部分。作为开发、测试、分发的核心平台,Xcode 26支持连接多LLM模型,ChatGPT已集成至开发流程。

全新推出的Coding Tools编程工具具备代码预览生成与故障修正能力。开发者不仅能调用ChatGPT,还可将其他AI模型接入Xcode 26。正如苹果在博文中所述:“开发者可将AI模型直接融入编程体验,用于代码编写、测试记录、设计更新与错误修正等场景。“在交互层面,Xcode 26做了升级,重新设计导航逻辑、优化本地化目录,并支持全语音界面导航。

尽管苹果目前缺乏能与OpenAI、Meta、谷歌抗衡的强大模型,但通过丰富开发者工具可以加快追赶速度。IDC分析师Francisco Jeronimo指出,苹果让开发者接入自己的AI模型是相当重要的一步,因为苹果在程序员群体中拥有强大的号召力。

WWDC大会开始不到6分钟,苹果股价便开始下跌,跌幅超过2.5%,股价从206美元跌至201美元,市值约蒸发750亿美元。

投资者抛售股票的主要原因是市场期待的革命性AI功能(尤其是全新的“超级Siri”)并未如期出现。苹果公司软件工程资深副总裁Craig Federighi在谈到Siri时表示,团队正在让Siri变得更加个性化,但该工作还需时间才能达到高质量标准,未来一年会分享更多信息。这意味着备受期待的AI增强版Siri尚未准备好,未能满足投资者预期。

Wedbush Securities分析师DanIves在报告中指出:“WWDC为开发者描绘了一幅愿景蓝图,但Apple Intelligence并没有带来重大进步。“他还提到:“我们知道苹果的战略方向,但今年是关键之年,苹果需要为AI变现做准备,也许库克最终会下定决心进行AI大并购,才能真正启动AI战略。我们对苹果有信心,相信它能完成任务,但留给苹果的时间有限。“

过去一年间,业界始终紧盯苹果,期待其推出重磅AI成果。当谷歌、微软、OpenAI在AI赛道加速狂奔时,苹果却再次透露Siri仍需打磨。种种迹象暗示:苹果在构建现代AI所需的基础设施与基础模型方面已显迟缓,亟待加速追赶。

Forrester分析师Dipanjan Chatterjee认为:“关于Siri,苹果基本保持沉默,这一沉默实际上‘响声极大‘。Siri话题被搁置,留到明年某个时间再讨论。虽然苹果一直在对Apple Intelligence进行微调,但无论文字纠错功能进步了多少,也无论能制作多可爱的表情符号,都无法弥补苹果在直观、互动AI方面留下的空白。当Siri准备就绪时也许才能提供类似的体验,只是我们不知道还要等多久。“

对苹果来说,追求完美本没有错,这也是它以往的行事风格。但在当下的AI竞赛中,单纯的等待也许并不会让苹果成为赢家。

相比往年,今年的WWDC对苹果公司而言更为关键。

在去年的WWDC上,苹果推出Apple Intelligence,但后续新功能持续延误、AI表现未达预期,使其饱受业界指责。正因如此,外界迫切期待苹果在今年的大会上证明自身实力。

对苹果来说,单一产品延迟尚属麻烦,更严峻的是其在AI领域的困境:现有AI工具与对手功能高度同质化,缺乏差异化竞争力。彭博社记者Mark Gurman指出,从今年WWDC展示的内容看,苹果可能仍无法证明其AI实力,本届大会或会以“令人失望”的结局收场。

已推出14年的Siri是苹果困局的缩影。如今用户可用Siri打开智能灯、激活Apple Watch运动功能,但这些功能在14年前就已存在;若用户想探索新功能,往往会碰壁。过去14年间,Siri几乎没有什么“有意义的进步”。若明年Siri年满15岁时没有新版本推出,或增强版依旧表现平平,对苹果将是沉重打击。

反观Android阵营,谷歌Gemini的惊艳表现不断刷新行业标准,苹果在AI赛道已没有更多时间可以浪费。

-END-

(文:头部科技)