随着 AI 语言模型日益强大,如何有效引导其输出变得尤为重要。负面提示可以帮助我们明确指出不希望模型生成哪些内容,从而精细控制生成结果。这种方法在处理敏感话题、确保事实准确性,或保持特定语气或风格时尤其有用。

本教程探讨了负面提示(Negative Prompting)的概念,以及在使用大型语言模型时避免不良输出的技术。我们将重点介绍如何结合使用 Qwen3 模型和 LangChain 库来实现这些策略。

我们将从配置必要的库环境开始,然后探索各种负面提示技术:

-

基础负面示例:演示如何提供不良输出的示例来引导模型避免类似输出。

-

明确排除内容:使用提示语清晰指出哪些内容不应出现在模型回复中。

-

实现约束机制:借助 LangChain 构建更复杂的提示语,以对输出施加特定限制。

-

评估与优化:讨论如何评估负面提示的效果,并进行迭代改进。

在整个教程中,我们将通过实际示例来展示这些概念,并提供相应的代码片段以便实现。

完成本教程后,你将对负面提示技术有深入理解,并能将其应用于避免语言模型产生不良输出。这将帮助你在各种应用场景中生成更加可控、准确且得体的 AI 内容。

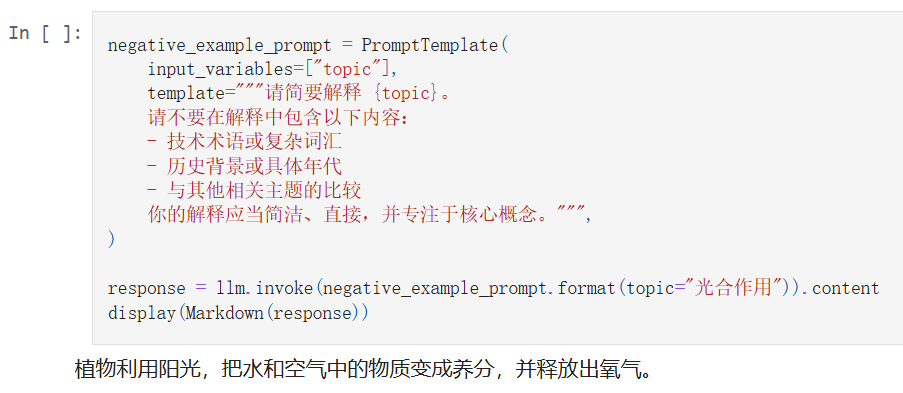

使用负面示例

让我们从一个简单示例开始,演示如何使用负面示例来引导模型的输出。

这个示例中,我们通过在提示语中明确指出不希望包含的内容(例如术语、历史或比较),来引导模型生成更简洁、聚焦的解释。

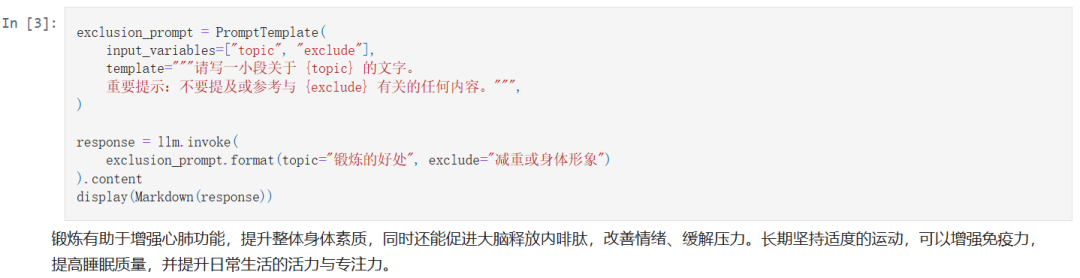

明确排除内容

接下来,让我们看看如何明确指定在模型回复中应排除的内容。

在这个示例中,我们通过设置 exclude 参数,清晰地告诉模型哪些话题不能出现在输出中,从而更有针对性地控制生成内容的范围。

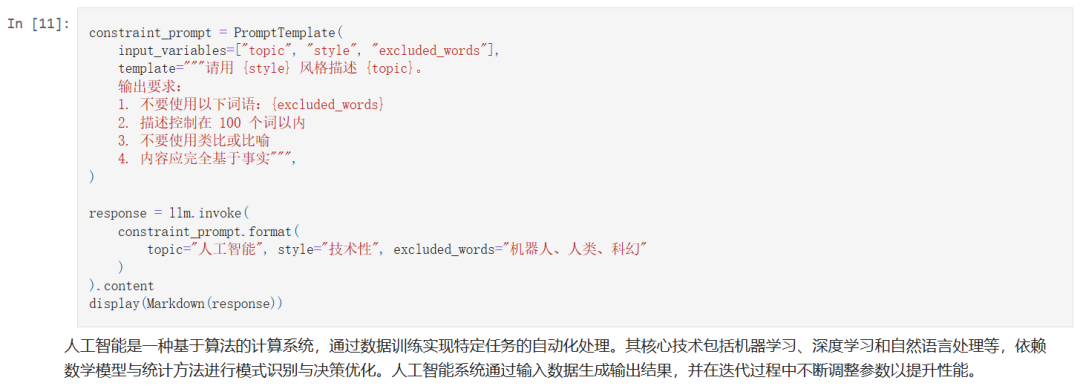

实现输出约束

现在我们来使用 LangChain 构建更复杂的提示语,对输出施加具体约束。

这个例子中,我们利用 LangChain 提供的模板机制,对生成内容设置了多重约束,比如禁止使用特定词语、限制字数、避免比喻,并聚焦于事实内容,从而提高生成文本的可控性和专业性。

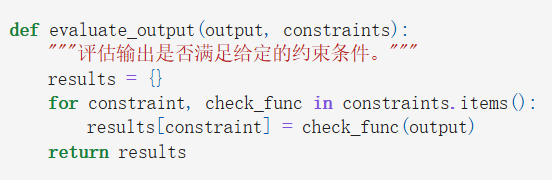

评估与优化

为了评估和优化我们的负面提示,我们可以编写一个函数,用于检查模型输出是否符合指定的约束条件。

定义一些示例约束条件:

评估前面的输出结果:

(文:PyTorch研习社)