跳至内容

作者|沐风

来源|AI先锋官

2025年初,在DeepSeek掀起的新一轮开源大模型竞赛中,曾经风光无限的“AI六小龙”几乎从舆论场中消失。

零一万物将超大模型交给了阿里训练,明确不再追逐AGI,放弃预训练转向应用。

百川智能则专注医疗垂类赛道,其基础模型更新陷入静默。

萧条之下,仅剩智谱AI、MiniMax、月之暗面、阶跃星辰四家仍在坚持。

具有先发优势的“AI六小龙”也被字节、阿里、腾讯等大厂完全赶超。

就在业界认为“六小龙时代”落幕之际,6月17日,MiniMax与月之暗面突然同一天宣公布了各自的开源新成果,并对下一步路线做出了部署。

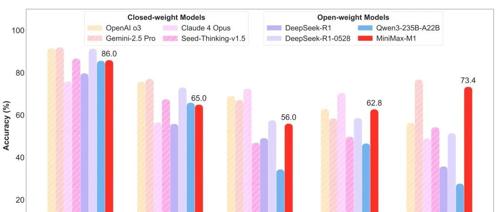

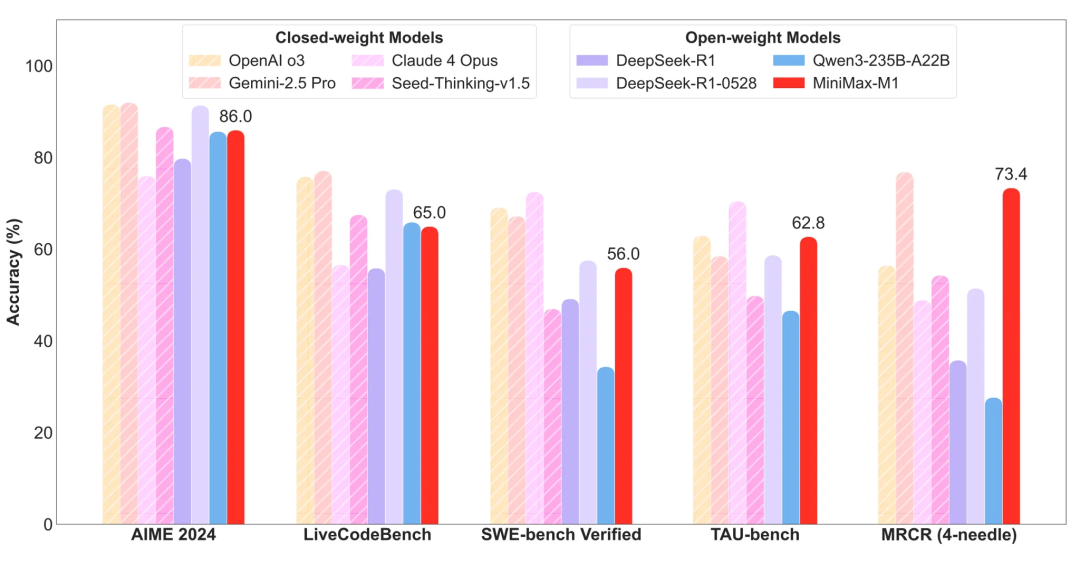

MiniMax称,其开源的MiniMax-M1(以下简称“M1”)是全球首个开放权重的大规模混合注意力推理模型,同时还是在面向生产力的复杂场景中能力是开源模型中的最好一档,超过国内的闭源模型,接近海外的最领先模型,同时又有业内最高的性价比。

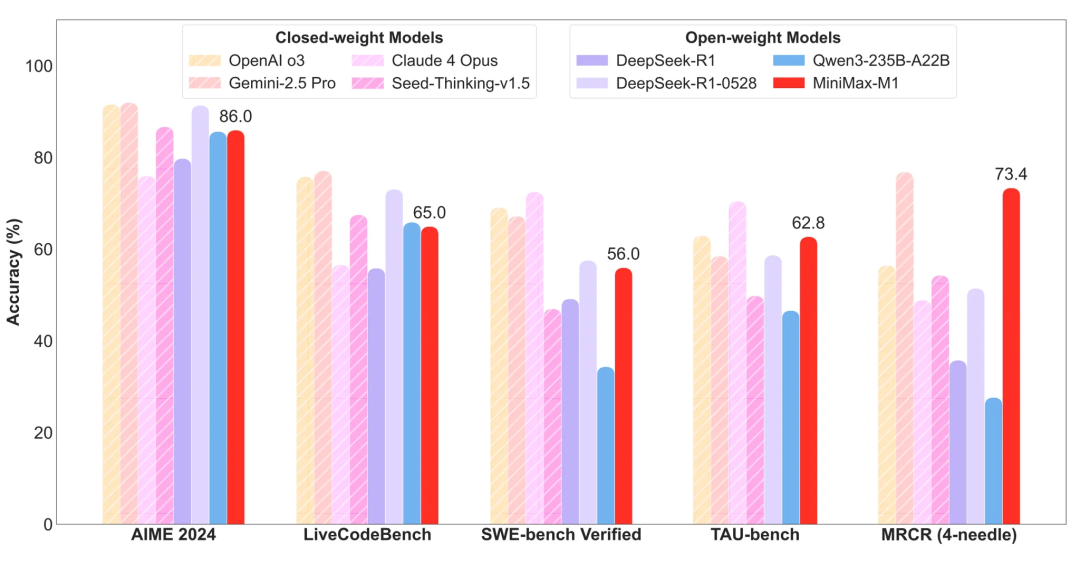

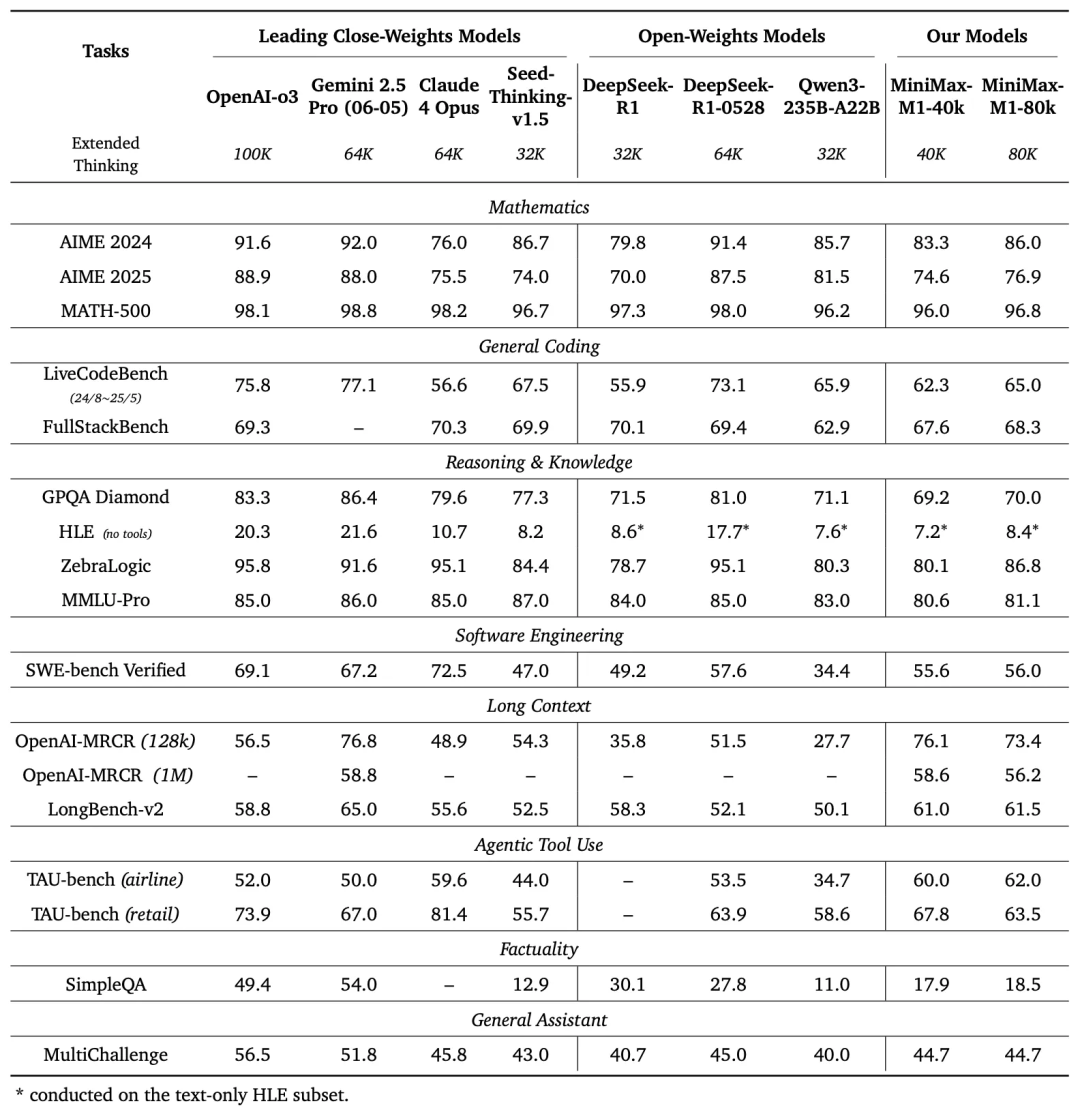

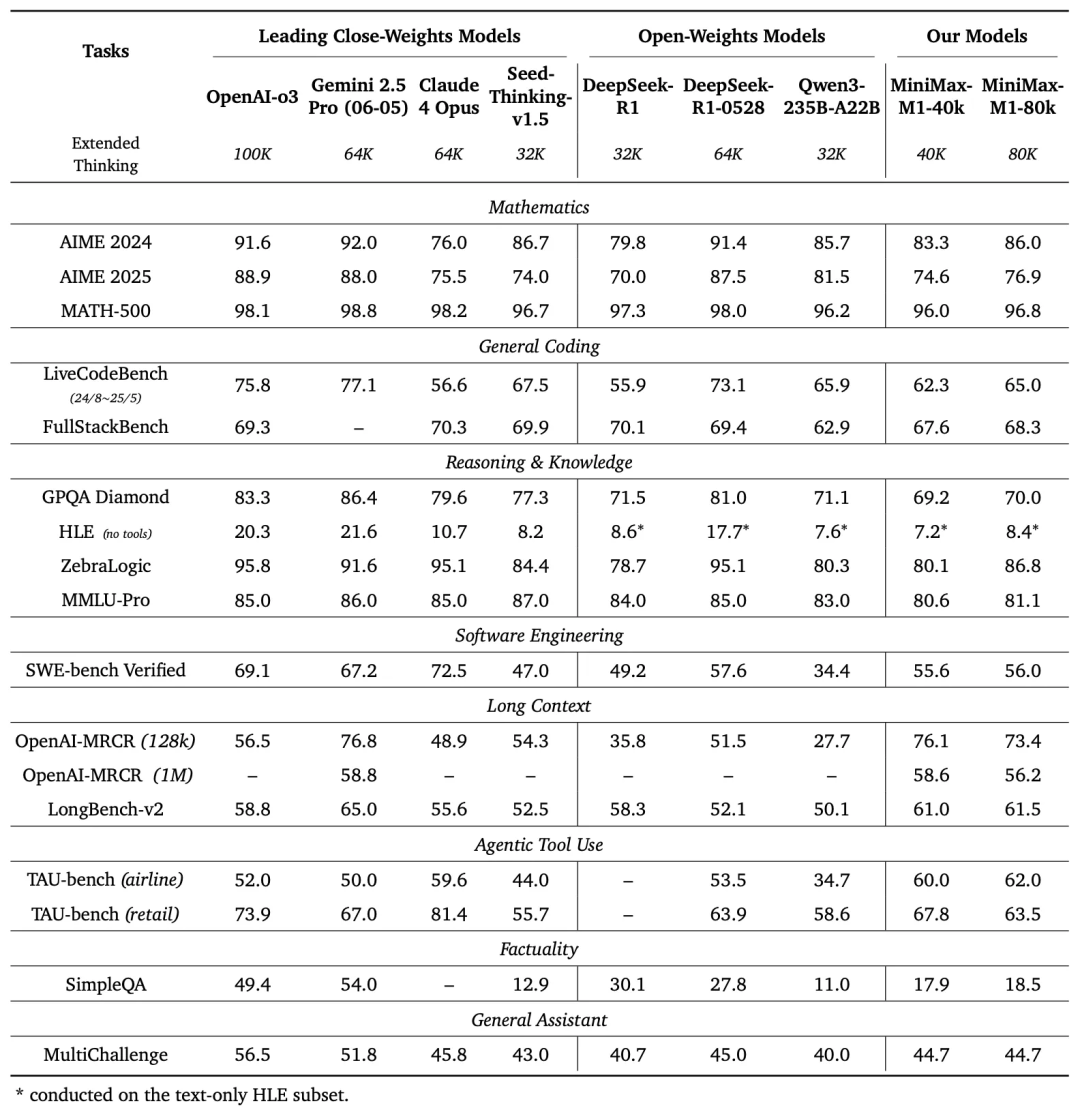

MiniMax在17个业内主流评测集上对 M1 模型进行了全面评估,结果显示,M1在软件工程、长上下文处理和工具使用等面向生产力的复杂场景中,拥有显著优势。

在软件工程基准验证中,M1-40k和M1-80k版本分别取得了55.6%和56.0%的成绩,略逊于 DeepSeek-R1-0528 的 57.6%,但显著超越其他所有开源模型。

在上下文能力的评测基准中,M1的表现远超DeepSeek-R1-0528和Qwen3-235B 在内的所有开源模型,甚至超越OpenAI o3和Claude 4 Opus,全球排名第二,仅以微弱差距落后于 Gemini 2.5 Pro。

在代理工具使用TAU-Bench (airline)中,M1-40k/80k领跑所有开源模型,其实力甚至超越了闭源的Gemini-2.5 Pro。

取得这一成绩得益于其两大核心技术:混合注意力机制Lightning Attention和强化学习算法CISPO。

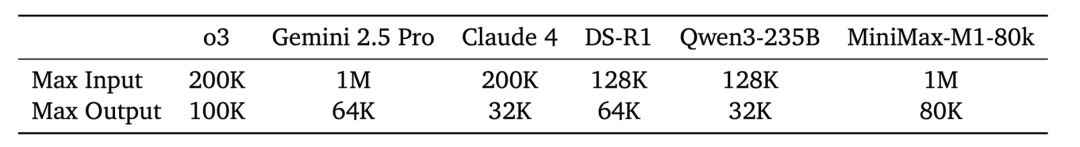

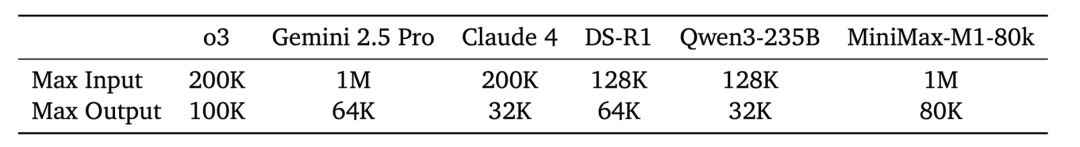

M1模型总参数达到4560亿,原生支持100万token的上下文长度输入,与闭源模型Gemini 2.5Pro一样,是DeepSeek R1的8倍,同时,它还支持8万Token推理输出。

报告提到,M1进行8万Token的深度推理时,所需的算力仅为DeepSeek R1的约30%,生成10万token时,推理算力只需要DeepSeek R1的25%。

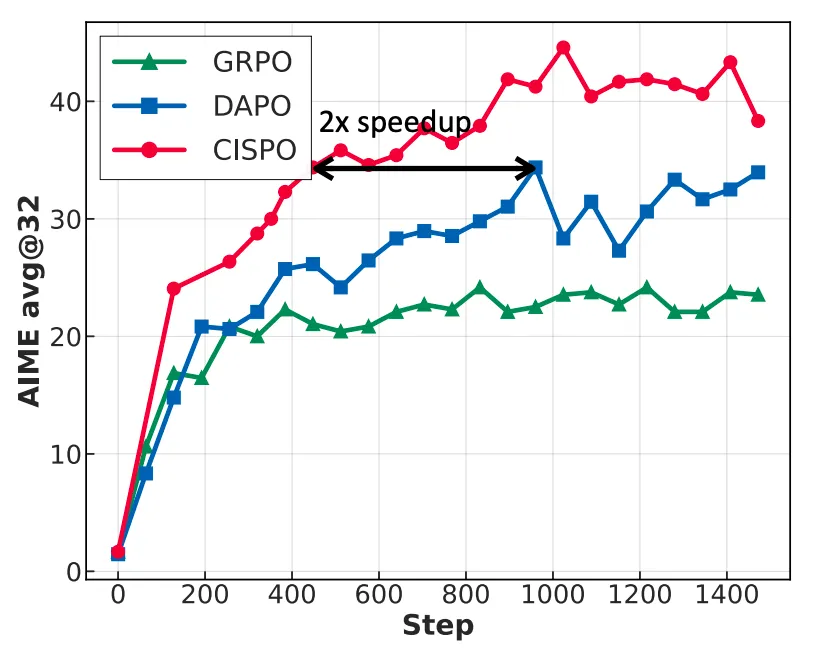

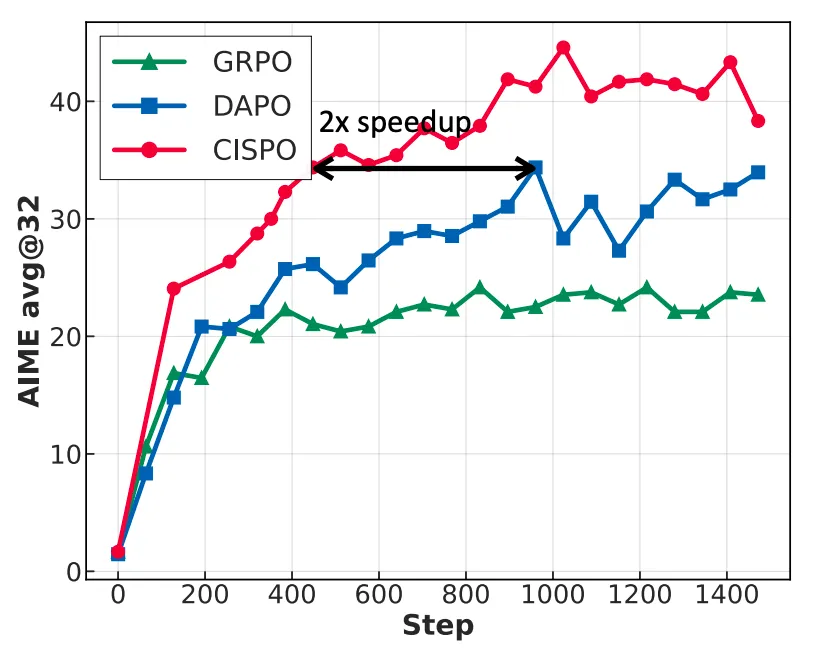

另外,MiniMax此次提出的CISPO算法,通过裁剪重要性采样权重,来提升强化学习的效率和稳定性。

实验数据显示,在AIME(AI-powered Moral Evaluator)等测试中,CISPO的收敛性能比字节跳动近期提出的DAPO算法快一倍,也显著优于DeepSeek早期使用的GRPO算法。

整个M1的完整强化学习训练在512张H800 GPU上仅用3周完成,以目前的GPU租赁价格计算,成本仅为53.47万美元。

MiniMax官方表示,这一成本“比最初的预期少了一个数量级”。

值得一提的是,MiniMax官方还表示,发布 M1 只是一个开始,在接下来的数个工作日内,还将公布一系列令人期待的技术更新,敬请关注。

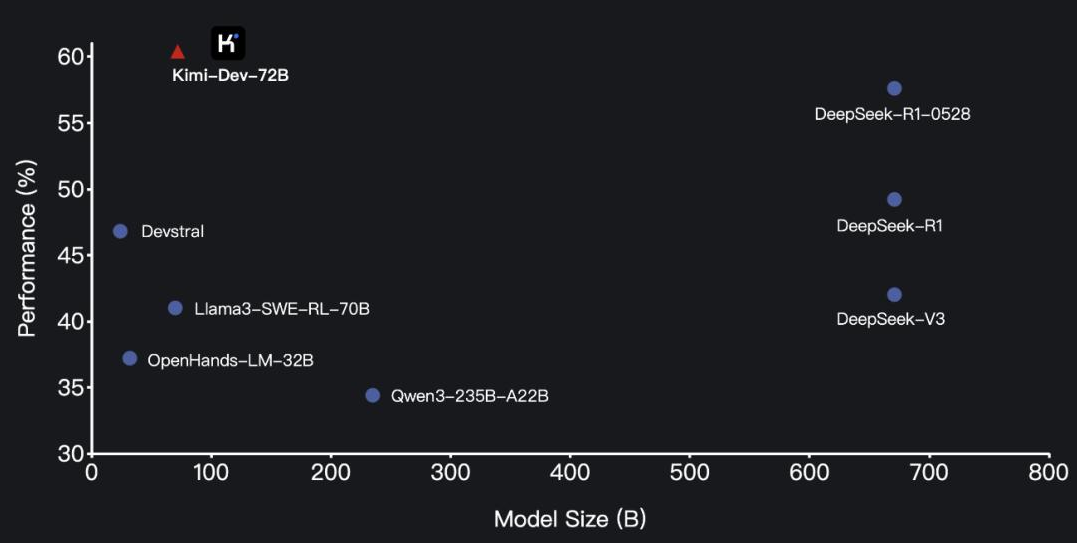

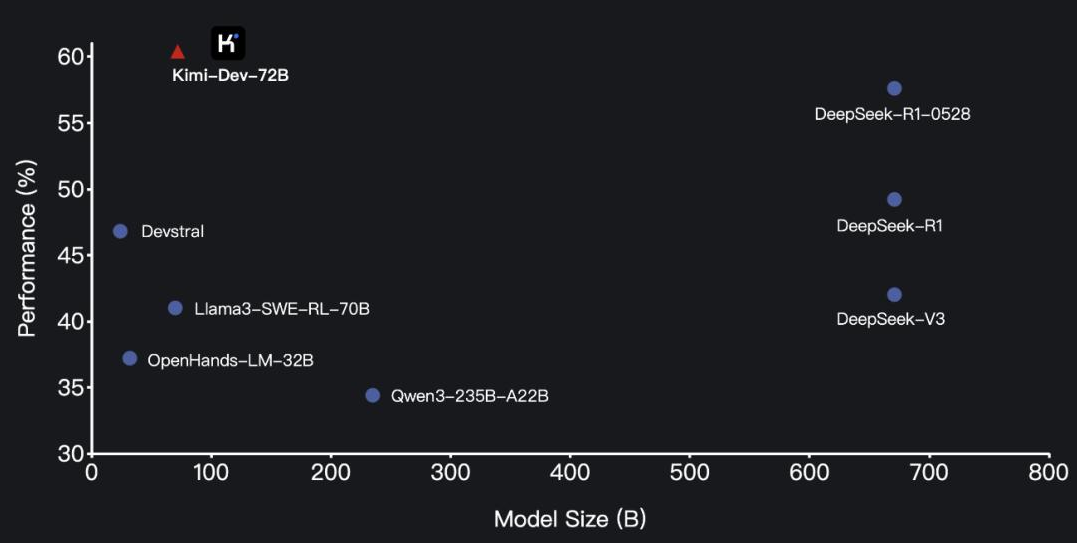

Kimi-Dev-72B是月之暗面推出的一款针对软件工程任务的开源代码大模型。

尽管该模型参数量仅为72B,但其在SWE-bench Verified编程基准测试中上取得了60.4%的高分,超越了不久前刚刚发布、参数规模达到671B的新版DeepSeek-R1,达到了当前全球开源模型中的领先水平。

目前,Kimi-Dev-72B已在Hugging Face和GitHub上提供下载和部署。

huggingface.co/moonshotai/Kimi-Dev-72B

github.com/MoonshotAI/Kimi-Dev

但其完整技术报告还暂未发布,不过官方透露了其中的一些关键技术。

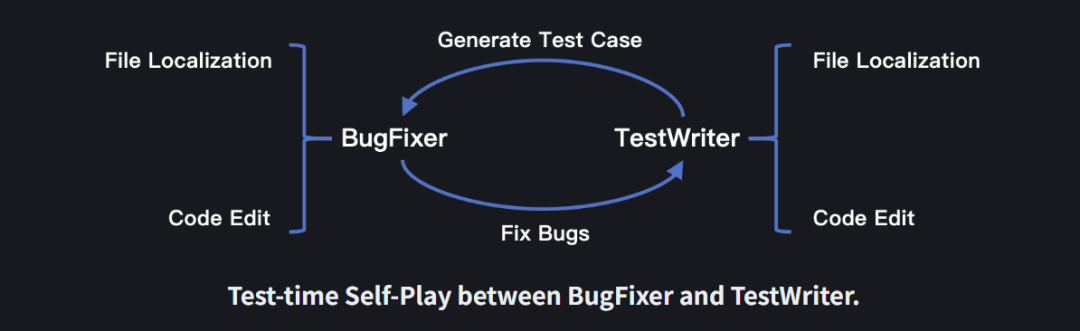

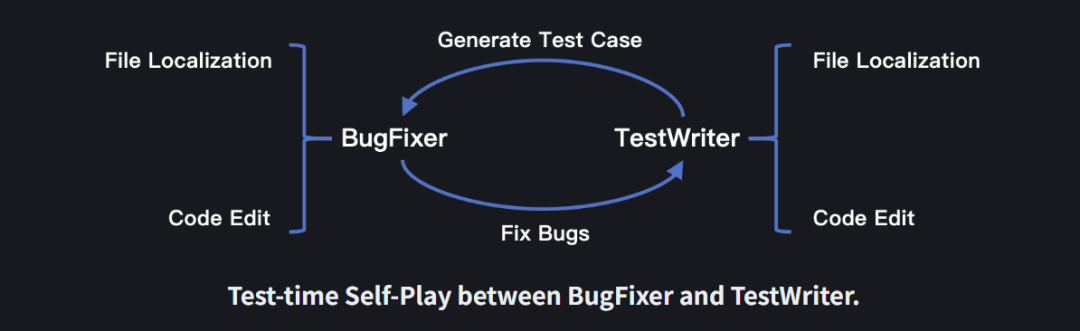

据介绍,Kimi-Dev-72B的设计理念和技术细节,包括BugFixer和 TestWriter的组合、中期训练、强化学习和测试时自我博弈。

其中,BugFixer和TestWriter的互补结合设计是模型的核心架构之一,使模型在修复错误和测试用例生成方面都表现出色。

为了增强Kimi-Dev-72B作为BugFixer和TestWriter的先验知识,月之暗面使用约1500亿个高质量的真实数据进行中期训练,大幅提升了模型对实际代码错误修复和单元测试任务的理解能力。

而在强化学习阶段则专注于提升其代码编辑能力,使其在文件本地化和代码编辑方面表现出色。

经过强化学习后,Kimi-Dev-72B能同时掌握BugFixer和TestWriter的角色。

在测试过程中,它会采用自我博弈机制,协调自身Bug修复和测试编写的能力。

Kimi-Dev-72B会遵循标准Agentless设置,为每个问题生成最多40个补丁候选和40个测试候选选项。因此会观察到测试时自播放的缩放效果。

以上就是月之暗面对Kimi-Dev做出的介绍,更多细节将在后续的技术报告中揭晓。

下一步,月之暗面还计划探索更复杂的软件工程任务,并将于与流行的IDE、版本控制系统和CI/CD流水线进行更深入的集成。

这两次开源,无疑证明了实MiniMax与月之暗的能力及在AI大模型这条路上坚定走下去的决心。

接下来,不知道其他“AI六小龙”会不会再给我们带来惊喜。

(文:AI先锋官)