“ 智能体中,大模型就是人,工具就是人使用的工具,提示词就是你想让大模型做什么,以及怎么做。”

智能体作为AI领域潜力无限的一个应用方向,很多技术从业者都扑在了智能体上,同时也有更多的人想入行智能体开发;但面对智能体领域各种乱七八糟的新概念,新名词很多人都不知道该从哪下手,以及怎么下手。

特别是智能体是结合大模型LLM+Prompt+Tools组成的一个复合概念;最重要的是很多人刚开始很难弄明白大模型都是干啥的,以及应该怎么干。

从人的角度理解大模型和智能体

事实上智能体的理解很简单,就是一个人(LLM)+工具(Tools),然后再告诉它应该怎么做(prompt)。

举个简单的例子,某天你老板让你把你现在做的业务给简单介绍一下,并画个流程图啥的;这时你可以通过口述把你做的事情给描述一遍,这个你就是大模型;而老板的要求——介绍你现在做的业务,就是提示词Prompt。

那么什么是智能体呢?

老板不但让你介绍你做的工作,还让你画个流程图什么的;这个流程图应该怎么画?

是拿张纸和笔用手画,还是打开电脑用wps或者其它绘图工具画;这里的纸和笔或者电脑就是工具(Tools),让你做什么事之前总需要给你工具才可以。

所以,智能体是什么?

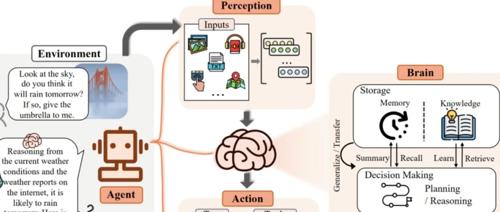

智能体就是一个具备独立思考能力的大模型(大脑),然后配备了多种工具(只不过需要告诉大模型这些工具都是干啥的,以及怎么用),最后再通过提示词告诉大模型要做什么,然后让大模型自己去思考,然后使用某个工具完成某件事情。

但是,大模型这个脑袋并不是万能的,它也会犯错而且可能会经常犯错;哪怕是人脑很多时候沟通都会产生很大的偏差,所以基于大模型构建的智能体出现问题的可能性就更大了。

而且,程序员在开发接口或者工具的过程中,不同的接口或功能都会有其固定的格式;但大模型不同,根据业务需要可能大模型要集成多种不同的工具,而这些工具的参数和返回值格式都不尽相同,而这也为大模型的后续处理带来很大的困难;特别是在多智能体交互的过程中。

所以,面对这种问题只能尽可能地去约束大模型或者工具的输出结构,然后由大模型自动或者通过人工规则约束的方式来规范数据格式。

但这种方式也只能尽可能的降低智能体出错的概率,而并不能完全避免出现问题;所以,在智能体的开发过程中需要有完善的容错机制,才能让智能体更稳定,更健壮。

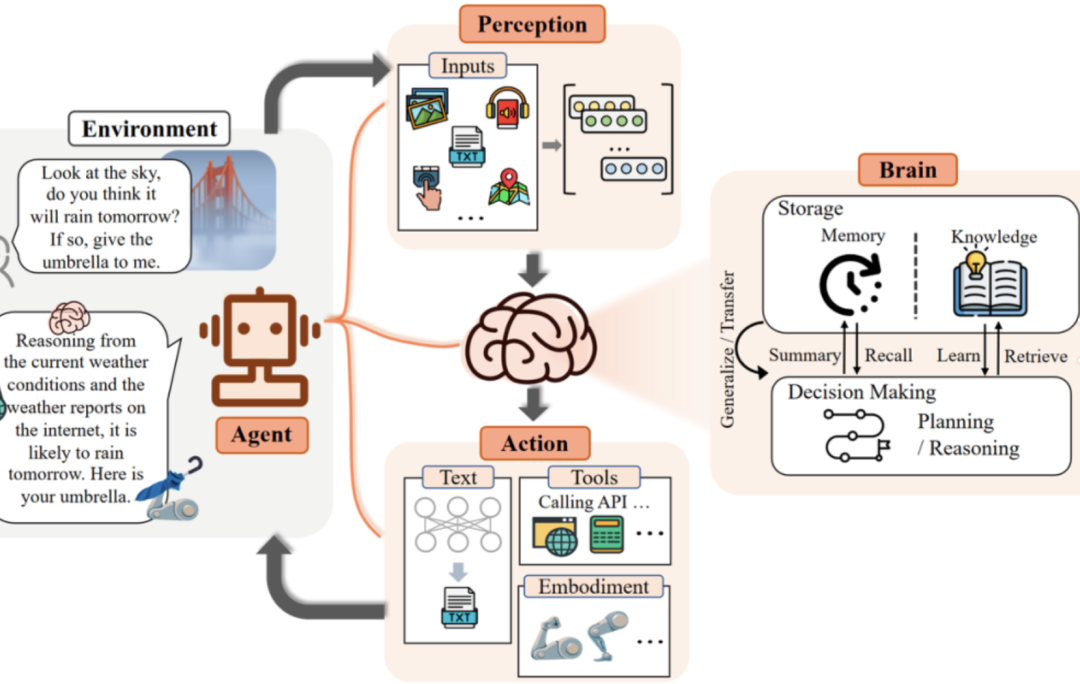

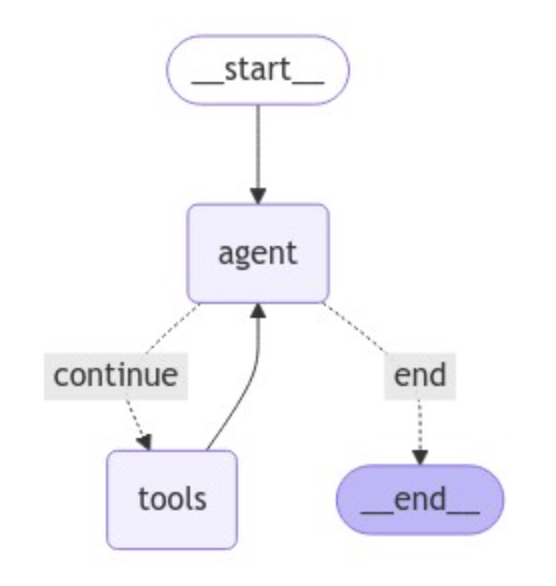

还有一点就是,在这种长链路的执行过程中,数据在智能体或者在不同智能体之间的流转就成了一个问题;而这种只能借助第三方或者独立的数据流转模块;而在Langgraph中,就是通过状态图来实现的。

(文:AI探索时代)