4个多月前,百度承诺将在6月30日开源文心大模型。

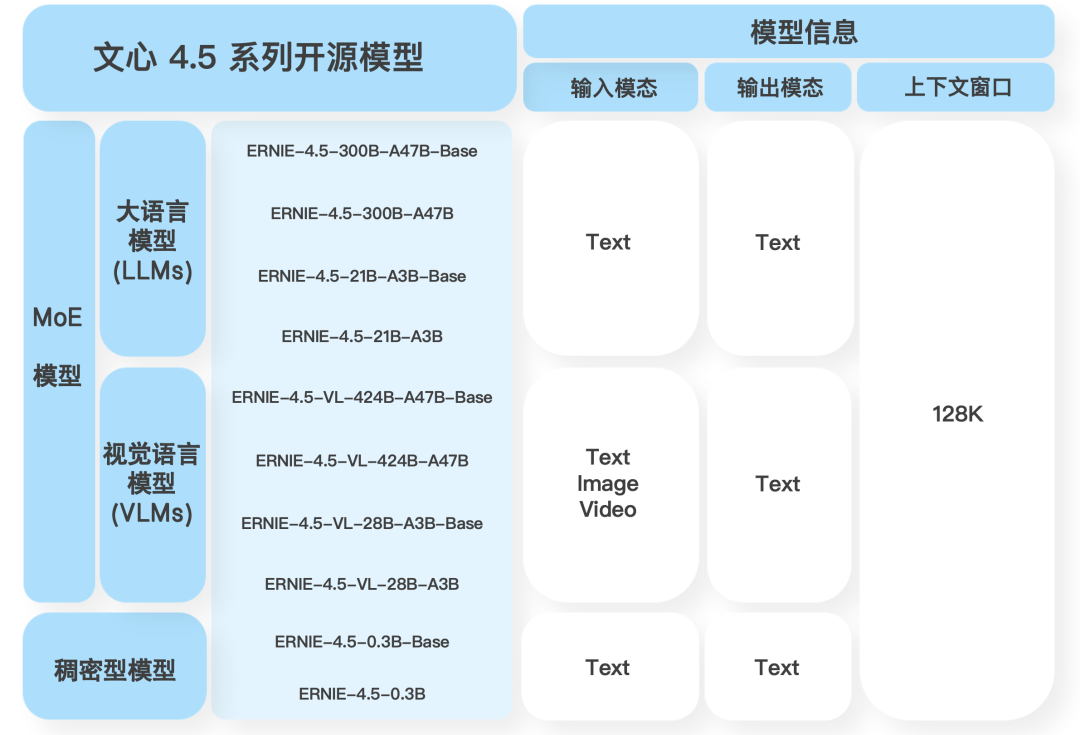

今天如期而至,他们一口气开源了文心4.5系列共10款模型。

既有文本模型,也有VL视觉理解模型(支持thinking),最小参数0.3B,最大参数424B(激活参数47B)。

本次开源的全部模型(包括预训练权重和推理代码)和项目,都可以在Hugging Face、GitHub和飞桨社区下载。

Hugging Face:https://huggingface.co/baidu

GitHub:https://github.com/PaddlePaddle/ERNIE

飞桨社区:https://aistudio.baidu.com/overview

技术报告:https://yiyan.baidu.com/blog/posts/ernie4.5

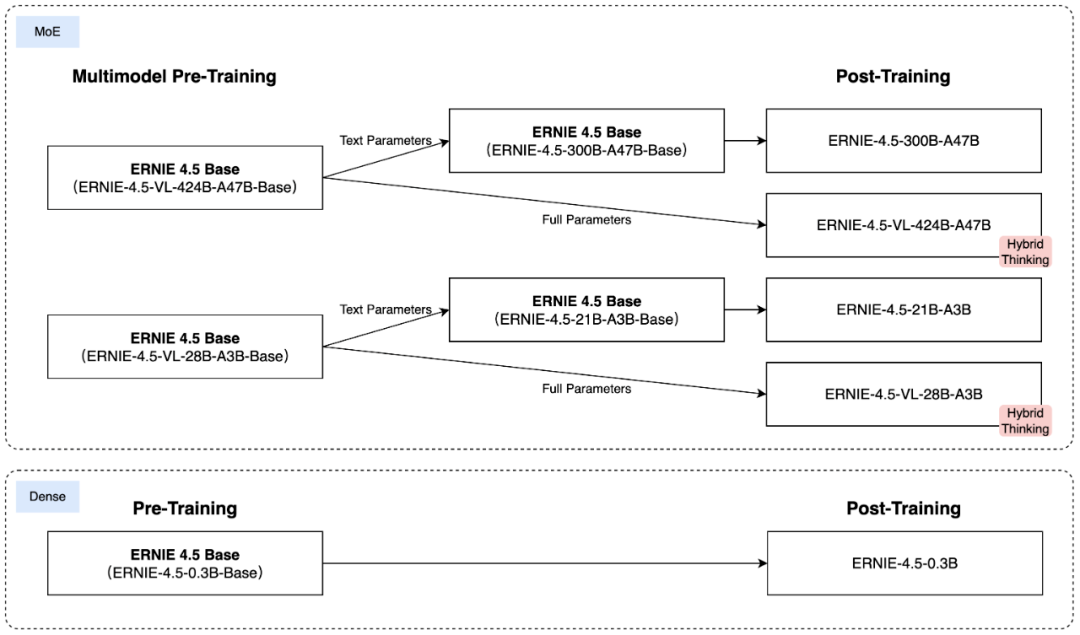

针对MoE架构,百度提出了一种新的多模态异构模型结构,通过跨模态参数共享机制实现模态间知识融合,同时为各单一模态保留专用参数空间。此架构非常适用于从大语言模型向多模态模型的预训练,在保持甚至提升文本任务性能的基础上,显著增强多模态理解能力。

文心4.5系列模型,全部使用飞桨深度学习框架进行训练、推理和部署。在预训练过程中,模型FLOPs利用率(MFU)达到47%。

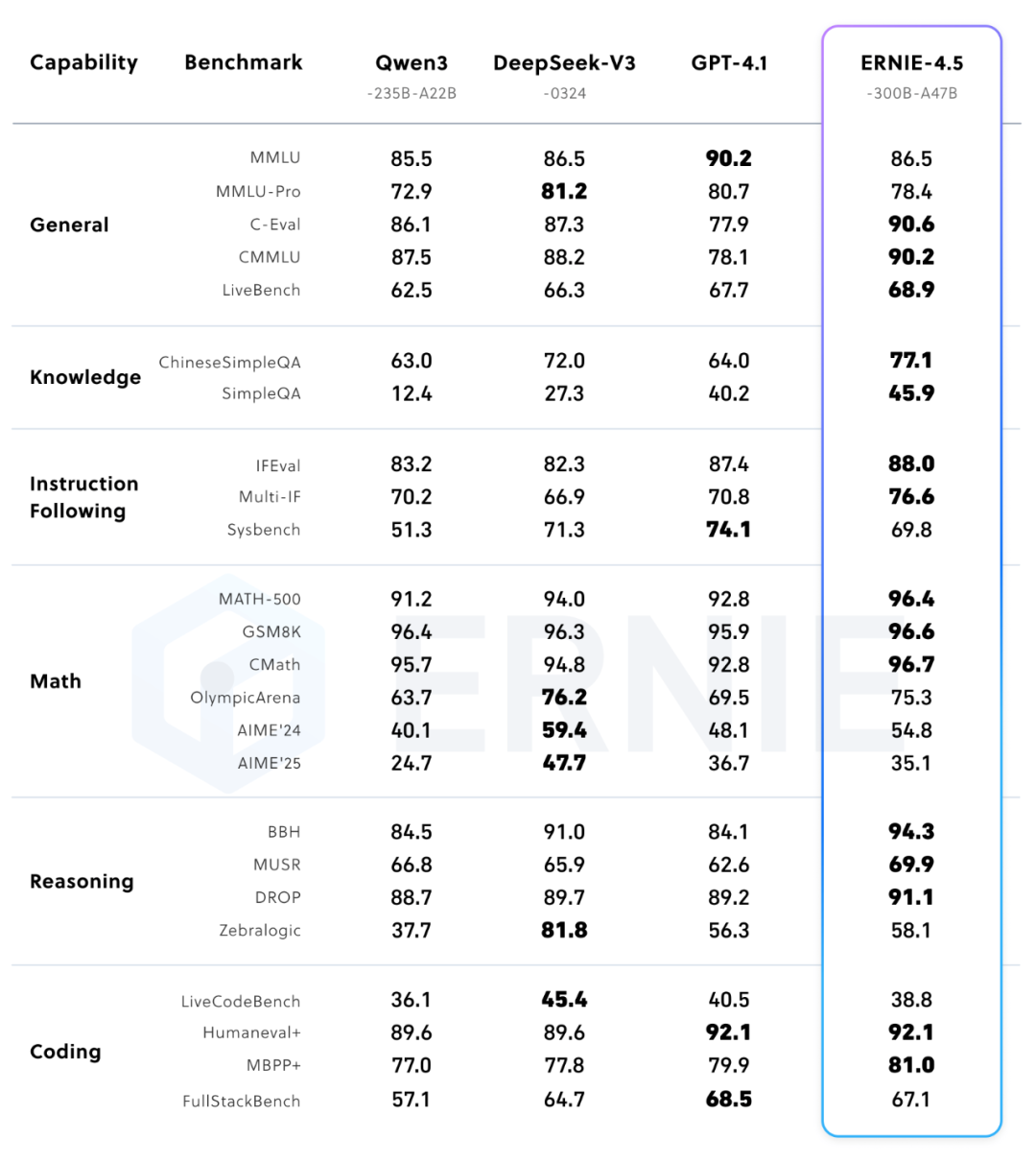

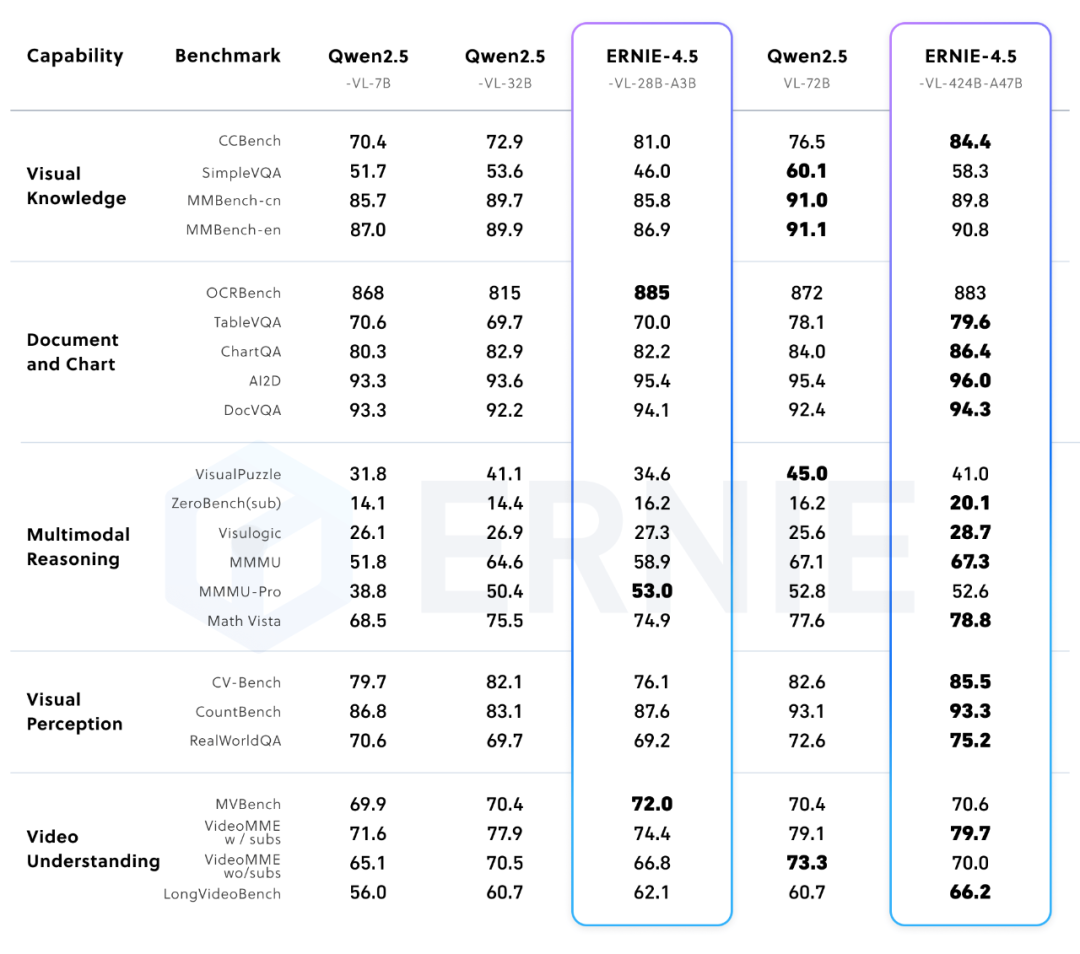

在多个文本和多模态基准测试中,文心4.5系列模型达到SOTA水平,在指令遵循、世界知识记忆、视觉理解和多模态推理任务上效果尤为突出。

ERNIE-4.5-300B-A47B表现不输Qwen3、DeepSeek-V3-0324

ERNIE-4.5-VL-424B-A47B表现不输Qwen2.5-VL-72B

模型权重,按Apache 2.0协议(与MiniMax一致)开源,而非MIT协议(如DeepSeek、智谱、Qwen等)。

具体部署方法,请参考技术Blog:

https://yiyan.baidu.com/blog/posts/ernie4.5

(文:沃垠AI)