大型语言模型(LLM)的思维链(Chain-of-Thought, CoT)推理虽提升了复杂任务性能,但其自回归特性导致计算过程难以分解。传统可解释性方法关注单次前向传播的神经元激活,对多步推理的”黑箱”结构束手无策。

-

论文:Thought Anchors: Which LLM Reasoning Steps Matter? -

地址:https://www.arxiv.org/abs/2506.19143

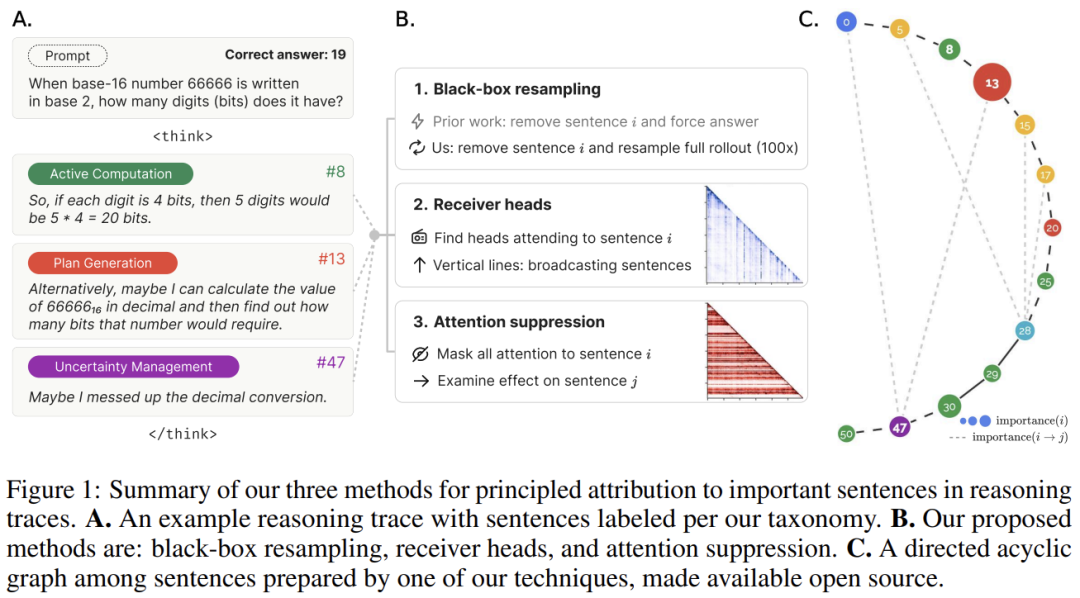

本文提出思维锚点(Thought Anchors)概念——指在推理轨迹中对后续步骤和最终答案具有超比例影响的关键句子。通过开发三种互补的归因方法(黑箱/白箱/因果),论文首次系统论证:

-

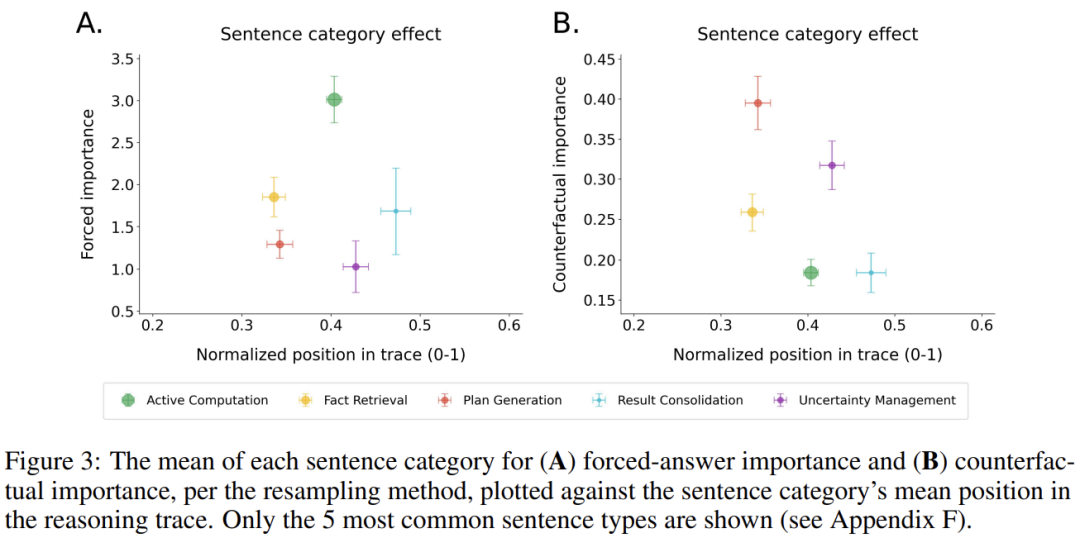

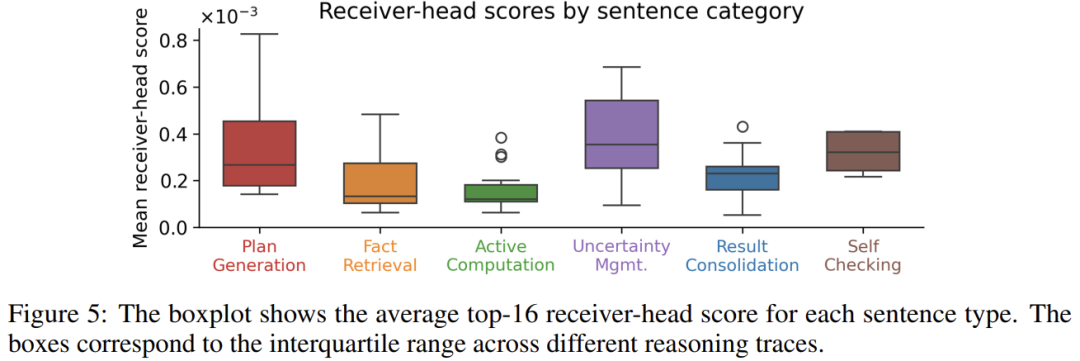

高级组织句(如计划生成、不确定性管理)比低级计算句(如数值运算)更具全局影响力 -

模型通过特定”接收头”(Receiver Heads)持续聚焦锚点句,形成结构化推理 -

锚点主导错误修正与路径转向,是提升模型可靠性的关键干预点

研究为理解LLM推理机制、调试安全风险开辟新途径,开源工具thought-anchors.com支持可视化分析。

2. 方法论框架

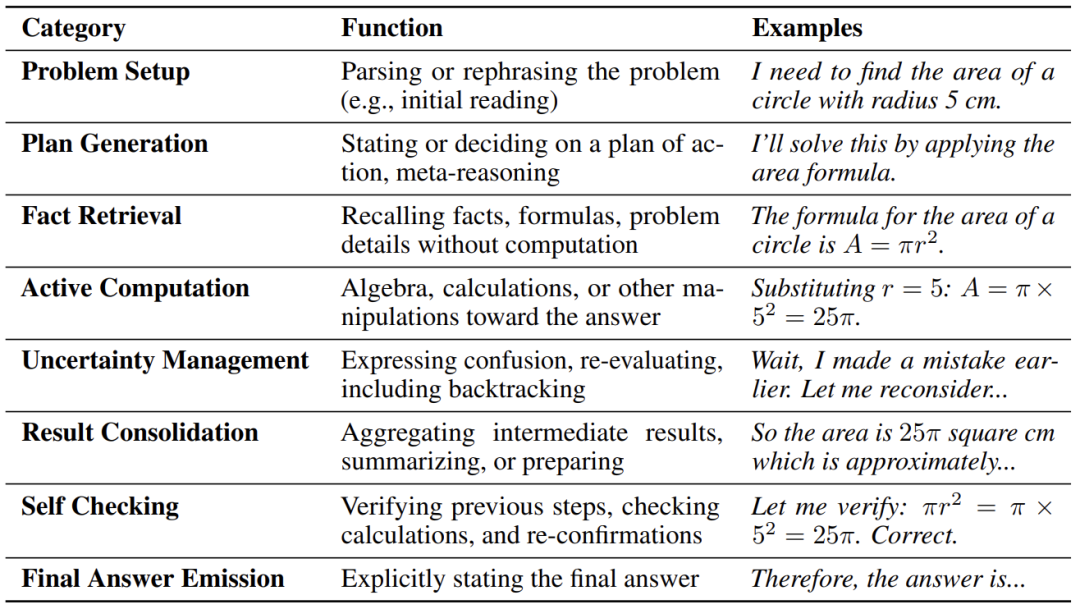

2.1 句子分类体系

论文将推理句分为8类,通过LLM自动标注:

-

问题解析(Problem Setup) -

计划生成(Plan Generation, PG) -

事实检索(Fact Retrieval, FR) -

主动计算(Active Computation, AC) -

不确定性管理(Uncertainty Management, UM) -

结果整合(Result Consolidation) -

自我检查(Self Checking, SC) -

最终答案(Final Answer Emission)

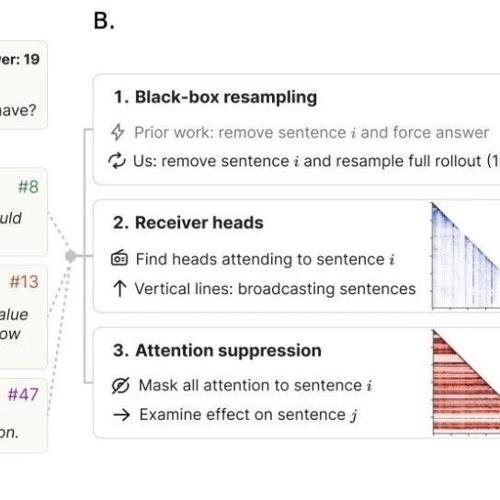

2.2 三大归因方法

方法1:黑箱重采样法

目标:量化句子对最终答案的反事实影响。

流程:

-

重采样:对每个句子位置 (S_i),生成两组推理轨迹: -

保留组:包含原句 (S_i) -

替换组:替换为语义不同的 (T_i)(余弦相似度<0.8) -

分布对比:计算两组最终答案分布的KL散度: 符号说明: -

:最终答案分布 -

:强制替换句与原句语义差异大 -

:衡量分布差异,值越大说明句子越关键

创新点:

-

避免传统”强制作答法”(中断模型)对前置句重要性的低估 -

过滤语义相似替换句,解决推理轨迹的超定问题(Overdetermination)

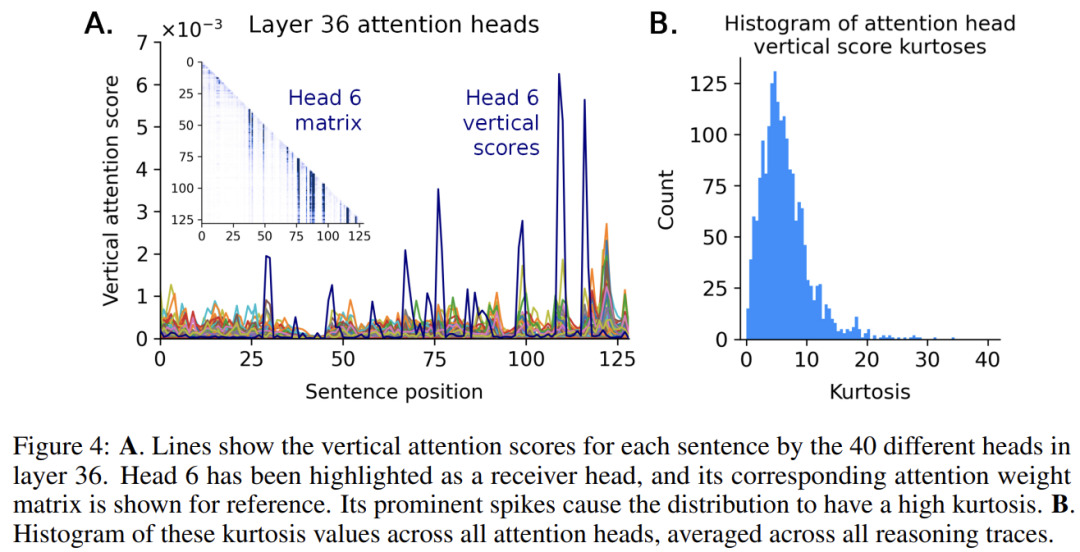

方法2:白箱注意力聚焦法

目标:通过注意力模式识别被模型”广播”的关键句。

流程:

-

计算垂直注意力:将token级注意力矩阵聚合为句子级矩阵 -

识别接收头: -

计算每列(句子)接收下游注意力的峰度(Kurtosis) -

高峰度头 = 将注意力窄化到特定句子的”接收头” -

量化广播强度:高接收头关注的句子即潜在锚点

核心发现:

-

接收头多存在于深层(如Layer 36),且跨问题一致性高((r=.67)) -

推理模型比基础模型更依赖接收头(注意力聚焦强度高1.8倍) -

消融接收头导致准确性显著下降(512头消融:28% vs 随机头37%)

方法3:注意力抑制因果法

目标:直接测量句子间的因果依赖关系。

流程:

-

干预:屏蔽后续token对目标句 (S_i) 的所有注意力 -

测量影响:计算后续句token的logits KL散度: 符号说明: -

:无干预时的token概率 -

:屏蔽注意力后的token概率

价值:

-

补充重采样法的间接效应,捕获直接因果链路 -

与重采样重要性矩阵显著相关(,间隔<5句时)

3. 关键发现

3.1 思维锚点的存在证据

三大方法共同揭示:

-

计划句(PG)与回溯句(UM)主导推理方向 -

反事实重要性超AC句2.3倍 -

接收头对PG/UM句关注度超AC句4倍 -

锚点句组织推理”区块” -

案例中句子13(PG:”转十进制计算位数”)开启正确解路径 -

屏蔽其注意力导致后续句KL散度飙升

3.2 跨方法一致性

-

接收头关注度 ⇨ 重采样重要性(( \rho=.22 )) -

注意力抑制效应 ⇨ 重采样重要性(( \rho=.19 )) -

三角验证表明:句子级分析是解构推理的有效抽象层

4. 实验验证

数据集与模型

-

任务:MATH数据集数学问题(10道模型正确率25–75%的难题) -

模型:DeepSeek R1-Distill-Qwen-14B(温度0.6,top-p 0.95) -

轨迹:每条平均144句/4208 token,生成20条(10正确+10错误)

鲁棒性检验

-

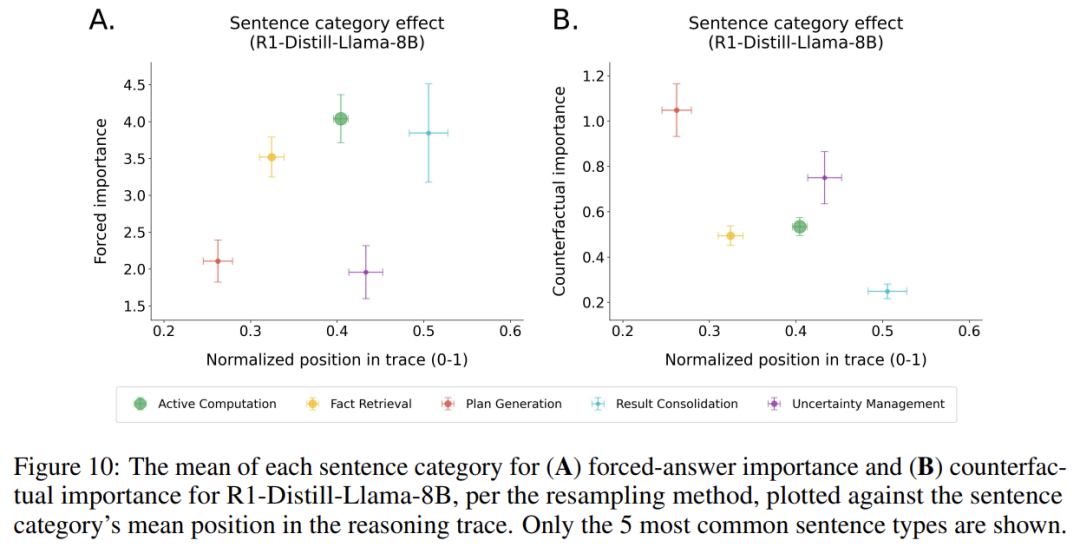

跨模型:R1-Distill-Llama-8B重现PG/UM句高重要性(Figure 10) -

消融实验: -

消融512个接收头 → 准确率降至28%(随机头消融为37%) -

证明接收头对推理的必要性(Appendix J)

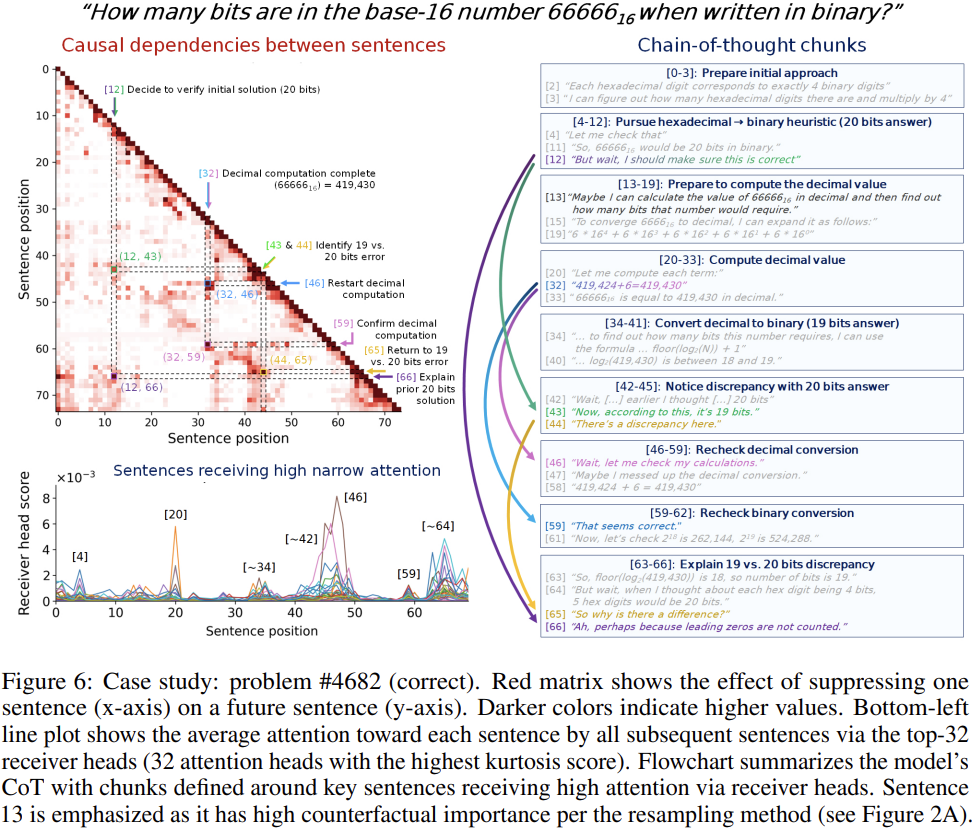

5. 案例研究(问题#4682)

问题:

16进制数 (66666_{16}) 转2进制后的位数是多少?

错误初始解:

-

句8:”5个16进制位×4比特=20位”(忽略前导零问题)

锚点句作用:

-

句13(PG):提议转十进制→启动正确计算路径 -

句43(UM):”20位与19位结果冲突” → 触发验证 -

句66(PG):”前导零不计位” → 解释错误根源

方法协同:

-

重采样:句13使准确率从40%→100%(Figure 2A) -

接收头:句13/32/66获高注意力,划分计算区块(Figure 6流程图) -

注意力抑制:屏蔽句12→句43的因果效应最强(Figure 6红矩阵)

7. 结论与展望

核心结论

-

LLM推理依赖思维锚点(计划/回溯句),而非计算细节 -

模型通过接收头持续广播锚点句,形成模块化推理区块 -

句子级归因是破解CoT黑箱的有效抽象层

未来方向

-

动态干预:基于锚点实时修正错误推理路径 -

训练优化:增强锚点句生成以提高模型可靠性 -

跨域扩展:将框架应用于法律/科学等复杂推理场景

将思维锚点转化为"推理旋钮",实现人类可引导的AI推理。

(文:机器学习算法与自然语言处理)