扩散模型近年来在图像和视频生成方面取得了显著成功,极大地激发了图像动画领域的研究。

尤其是人像图像动画利用生成模型根据一系列姿态序列动画化参考图像,从而合成可控的人体动画视频,这在娱乐内容创作和虚拟现实体验等应用中具有广泛前景,具体应用场景包括:

1. 娱乐与影视:帮助动画师轻松制作高质量虚拟角色动画,显著提升工作效率;

2. 游戏与元宇宙:为游戏角色和虚拟形象提供逼真的动作生成,让玩家体验更沉浸;

3. 个性化内容创作:为短视频创作者、数字艺术家提供新的创意工具,实现精准的动态形象设计。

人像动画生成的核心在于:在参考图像的基础上,根据输入的动作序列生成动态视频,同时保持人物的身份信息(尤其是面部特征)。然而,现有方法在复杂动作变化场景下,常出现以下问题:

1. 身份(ID)一致性差,面部区域容易因动作变化出现失真;

2. 视频质量下降,最新的人像图像动画生成模型(MimicMotion和 ControlneXt)依赖于第三方换脸工具(FaceFusion)对生成的视频进行后处理,导致视频整体质量下降;

3. 空间与时序建模冲突,即使当前有很多针对 ID 一致性的图片生成模型,但是将这些来自图像生成的模型直接插入到视频生成模型中容易导致空间与时序建模冲突,根本原因是现有视频扩散模型在加入时间建模层后,空间特征的分布发生变化,而这些 ID 一致性的图片生成模型依赖于稳定的空间特征分布,时序建模导致的空间特征分布扰动会影响图片生成模型的性能急剧下降,从而造成 ID 保留与视频保真度之间的冲突。

为了解决上述问题,来自复旦、微软、虎牙、CMU 的研究团队提出 StableAnimator 框架,以实现高质量和高保真的 ID 一致性人类视频生成,目前代码已开源,包括推理代码和训练代码。

项目主页:

项目代码:

项目Demo:

方法简介

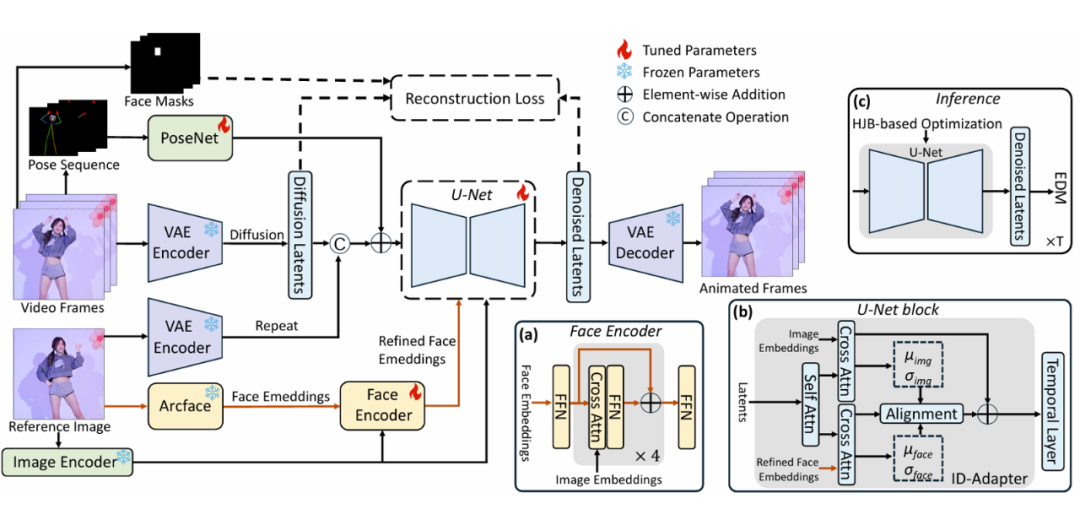

如下图所示,StableAnimator 基于先前工作的常用骨干模型 Stable Video Diffusion(SVD)构建。用户输入的参考图像通过扩散模型经过三条路径处理:

1. 通过冻结的 VAE 编码器转换为潜变量特征,潜变量特征被复制以匹配视频帧数,并与主要潜变量进行拼接;

2. 通过 CLIP 图像编码器编码以获得图像嵌入,这些嵌入分别输入到去噪 U-Net 的每个交叉注意力块和 StableAnimator 的面部编码器中,用于调控生成的外观;

3. 输入到 ArcFace 以获得面部嵌入,ArcFace 是一种人脸特征提取模型,这些嵌入随后通过 StableAnimator 的面部编码器进一步优化以实现更高的对齐度。优化后的面部嵌入随后被输入到去噪 U-Net 中。PoseNet 类似于 AnimateAnyone 中的结构,负责提取姿态序列的特征,这些特征随后被添加到噪声潜变量特征中。

在推理阶段,StableAnimator 将原始输入视频帧替换为随机噪声,同时保持其他输入不变。StableAnimator 引入了一种新颖的基于 Hamilton-Jacobi-Bellman(HJB)方程的面部优化方法,用于提升身份一致性并彻底摆脱对第三方后处理工具的依赖。

该方法将 HJB 方程的求解过程整合到去噪过程中,HJB 方程的最优解会更新 U-Net 中的潜变量特征,迫使它在去噪过程中往能实现更高的 ID 一致性的方向进行分布移动。

StableAnimator 具有三个核心技术点:

1. 全局内容感知面部编码器(Global Content-aware Face Encoder):引入一种新型的面部编码器,使面部嵌入特征与图像整体布局进行深度交互,面部特征通过多层交叉注意力模块,与参考图像的全局上下文特征对齐,有效减少与身份无关的背景噪声,提升面部建模质量;

2. 分布感知的身份适配器(Distribution-aware ID Adapter):针对扩散模型时序层对空间特征分布的扰动,提出一种分布对齐策略。通过计算面部特征和图像特征的均值与方差,确保两者在每个去噪步骤中逐步对齐,从而避免特征失真,适配器的设计允许面部特征与时序层的无缝结合,同时不损失视频的整体保真度;

3. 基于Hamilton-Jacobi-Bellman(HJB)方程的面部优化:该优化过程只在模型推理阶段触发,并且不会训练更新 U-Net 的任何模块,StableAnimator 将 HJB 优化方程引入扩散模型的推理过程中,以增强面部质量,HJB 方程通过动态系统中的最优变量选择原则,将面部特征优化与去噪过程并行进行,优化后的变量能够约束去噪路径,引导模型生成与参考图像一致的身份特征,显著减少细节失真。

生成结果示例

请访问项目主页获取以上示例的高清原视频:

实验对比分析

1. 与SOTA方法的定性对比实验

Disco、MagicAnimate、AnimateAnyone 和 Champ 在面部/身体变形以及服装变化方面存在明显问题,而 Unianimate 准确地修改了参考图像的动作,MimicMotion 和 ControlNeXt 有效保留了服装细节。

然而,所有对比的模型均难以保持参考图像的身份一致性。相比之下,我们的 StableAnimator 能够基于给定的姿势序列精确地动画化图像,同时保持参考身份信息的完整性,突显了我们模型在身份保持和生成精确、生动动画方面的优势。

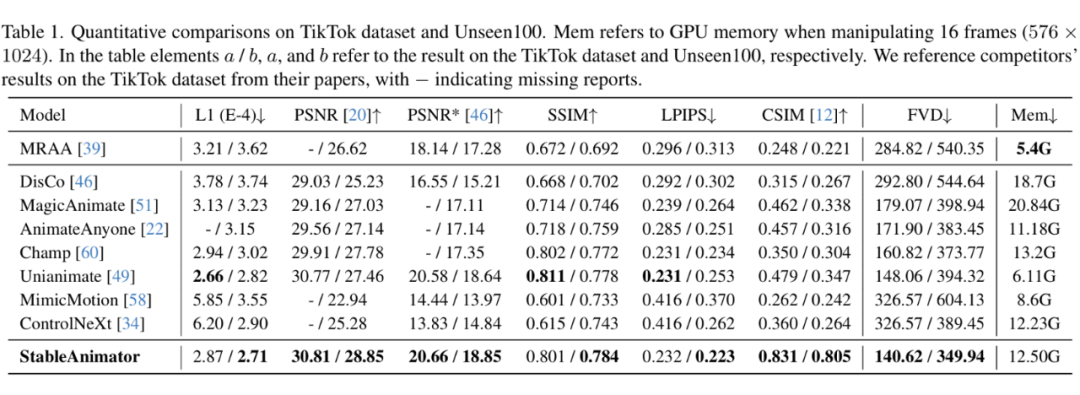

2. 与SOTA方法的定量对比实验

StableAnimator 与当前的 SOTA 人像图像动画模型在 TikTok 数据集和 Unseen100 数据集进行定量对比,其中 Unseen100 数据集是作者额外在主流视频网站收集的 100 个视频,相比于以前的主流数据集 TikTok 数据集,Unseen100数据集含相对复杂的动作信息以及精细的主体外观。

此外,Unseen100 数据集中的一些视频中,位置和面部表情动态变化,例如摇头动作,使得保持身份一致性更具挑战性。值得注意的是所有模型均在 StableAnimator 的训练集上训练后再对 Unseen100 进行评估,以确保公平性。

对比实验结果如上表所示,CSIM 衡量两个图像的面部嵌入的余弦相似度,可以发现 StableAnimator 在面部质量(CSIM)和视频保真度(FVD)方面均超过了所有对比模型,同时保持了较高的单帧质量。

具体而言,StableAnimator 相比于最领先的对比模型 Unianimate,在两个数据集上的 CSIM 分别提高了 36.9% 和 45.8%,而未牺牲视频保真度和单帧质量。

3.与SOTA方法在长视频生成的对比实验

更多的对比实验可以参考原论文。基于上述对比实验结果,StableAnimator 相比于以前的 SOTA 方法可以生成更加高质量逼真的 ID 一致视频,StableAnimator 在娱乐内容创作和虚拟现实体验方面可以给用户带来全新的高保真的人类形象动画体验。

(文:PaperWeekly)