今天,是2024总结的第3篇,给大家分享AI搜索公司Exa CEO Will Bryk在X(原推特)上发的一篇长文。

Ps.Exa这家公司很有意思,他们专注为AI提供搜索引擎,而并非为人类。随着LLM的日益普及,他们认为AI比人类更频繁地搜索网络,但市面上几乎没有专门服务AI的搜索产品,于是他们研发了第一个专注服务AI的搜索引擎,利用向量数据库和嵌入技术,让AI能够理解和预测下一个链接,从而避免AI搜索中充斥着大量SEO垃圾和AIGC垃圾。

-

o3模型被大大低估;

-

o系列模型将首先改变知识类工作,比如数学家、物理学家、生物学家;

-

o系列模型对软件工程师提效显著,预计是10倍提效。短期内AI不会替代工程师,因为工程师还需要跟物理世界(客户、团队)打交道;

-

目前AI对机器人帮助有限,机器人还需要解决硬件提升、快速/可靠的感知以及动作模型等问题;

-

o系列模型让推理比训练更重要,这对英伟达来说不是好事,因为推理芯片比训练芯片更容易制造;

-

AI接下来发展,重点关注能否做创新。目前o3模型已经到了博士水平,我们有可能在近几年内见到由AI发明的创新;

-

不要害怕AI,要加入AI,我们每一个人都有责任帮助我们的世界渡过这段艰难时期;

-

面对困难,最重要是:学习成为一个高水平的问题解决者和出色的团队合作者。

以下是中译全文。

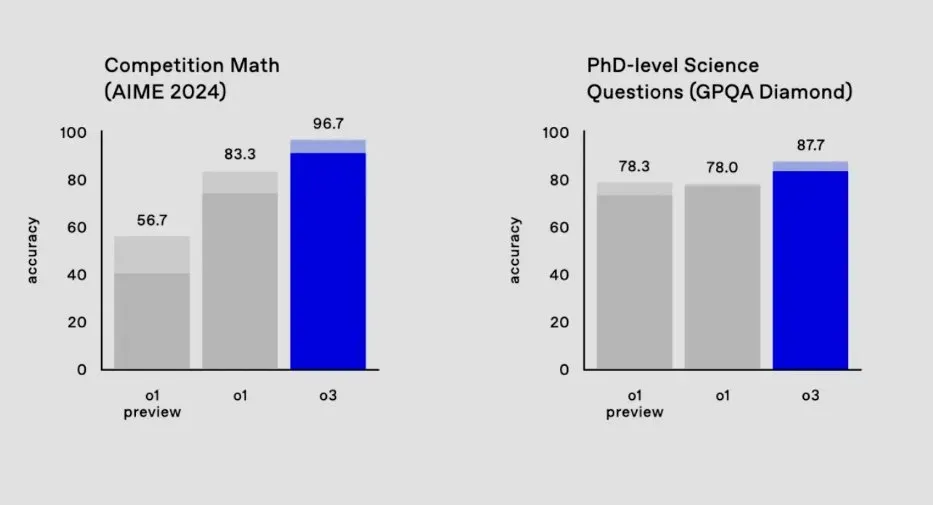

本周,我和几位朋友讨论了o3(OpenA最新推出的超强推理模型,一个问题2000美刀,预计2025年春节上线)。他们的反应基本都是”天哪,这真的要发生了吗?”

是的,这正在发生。接下来的几年将是疯狂的,是历史性的,甚至是银河系的。

可笑的是,这正在发生的事情几乎没什么深入的讨论。人工智能实验室不能谈论它,新闻媒体不报道它,政府也不理解它。

我们竟然是通过社交媒体的梗图(meme)来讨论这一人类的新技术,这感觉就像是一部荒诞的情景喜剧,但事实就是如此。

注意,这些思考都是不成熟和有趣的推测。我没有足够的时间去深入思考或研究这些思考,这些思考有可能是错误的。但我确实希望这些思考对那些试图理解当前形势的人有所帮助。

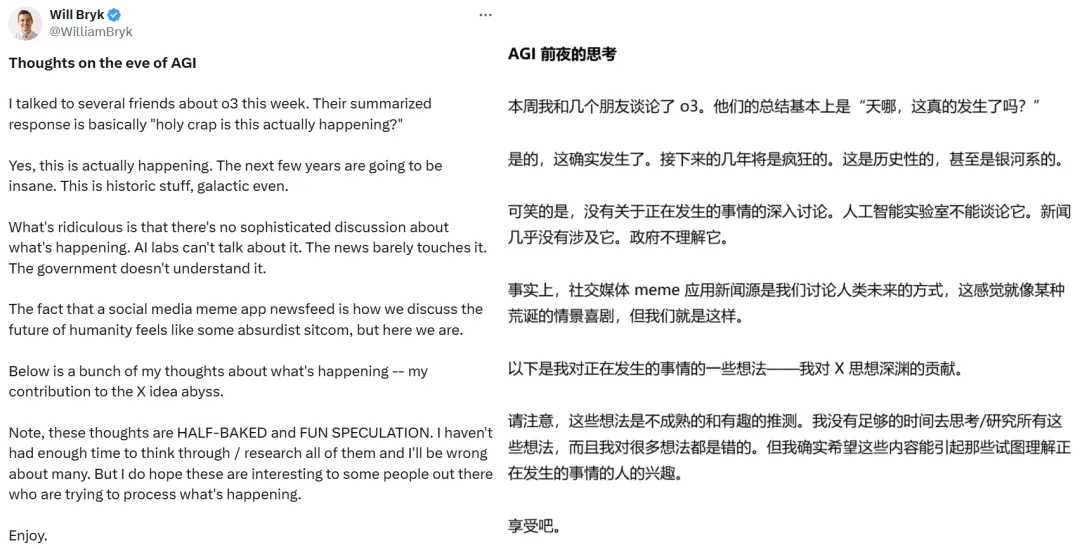

o3本不应该让人震惊。两个月前,OpenAI就放出了测试时间扩展图,而计算机的发展史已经告诉我们应该相信趋势线,不论它们看起来多么令人难以置信。真正令人震惊的是,它在2个月内就实现了。2个月,本科水平的AI就进化成了博士水平的AI。对人类来说,变化激动人心,但快速变化则会让人震惊。

接下来会发生什么是显而易见的。o3模型在优化任何可以定义奖励函数(对LLM的动作进行即时奖励(惩罚),就像你小时候读书获得小红花奖励,动力提升了不少呢![]() )的任务方面都非常出色。数学和编程的奖励函数相对容易设计,小说创作则比较困难。

这意味着在短期内(1年),我们就能得到能力不均衡的模型。它们在数学、编码和一般推理方面基本上达到AGI级别,但写的小说还很普通。虽然更好的推理能力会让模型在各方面都显得更智能,但它们仍会在没有经过强化学习的领域(即在训练数据之外的领域,也被称作泛化能力)犯一些愚蠢的错误。

从长远来看(1-3年),我们会不断增加新的领域来训练它们(情感数据、感知数据等),直到这些盲点被修复。届时,这些模型对任何人来说都将明显是AGI了。当然,除Gary Marcus(他是“AGI即将实现论”的强烈反对者)以外。

)的任务方面都非常出色。数学和编程的奖励函数相对容易设计,小说创作则比较困难。

这意味着在短期内(1年),我们就能得到能力不均衡的模型。它们在数学、编码和一般推理方面基本上达到AGI级别,但写的小说还很普通。虽然更好的推理能力会让模型在各方面都显得更智能,但它们仍会在没有经过强化学习的领域(即在训练数据之外的领域,也被称作泛化能力)犯一些愚蠢的错误。

从长远来看(1-3年),我们会不断增加新的领域来训练它们(情感数据、感知数据等),直到这些盲点被修复。届时,这些模型对任何人来说都将明显是AGI了。当然,除Gary Marcus(他是“AGI即将实现论”的强烈反对者)以外。

智能体将在2025年真正到来。o3模型一定能够浏览网页/应用并采取行动。这类任务的奖励模型很容易设计。(自动化计算机工作)是一个巨大的市场,所以对需要证明其巨额投入合理性的实验室来说有很大的激励。我猜,到2025年12月,你就可以让你的电脑执行任何涉及浏览网页/应用和移动数据的工作流程了。

在所有”被颠覆”的知识类工作中,受影响最大的可能是数学家。数学家的工作领域范围是符号空间,他们的工作与物理世界几乎没有联系,因此不会受到物理世界的阻碍。而LLM是符号空间之王,数学本身并不难,只是灵长类动物不擅长而已。正则表达式(一种描述和匹配字符串的文本处理模式,反正就是比较抽象)也是如此。

一个重要问题是:生成研究生水平合成数据有多难?我猜没那么难。博士水平的数学和研究生水平的数学对我们来说看起来有质的区别,但对AI来说可能只是程度的差异,只需要再增加几个数量级的RL强化学习就可以了。

我给数学家700天时间。(这听起来很疯狂?但如果说o6还不能战胜数学家,那这听起来更疯狂;所以我对这个预测的信心超过50%,就像这篇文章中的其他预测一样)。还有700天,人类就不再是数学领域的顶尖群体了。

那我们这些软件工程师呢?短期内,AI将助益软件工程师。每位软件工程师都能晋升技术主管,很不错。对于那些充分采用LLM的人来说,到2025年底,编程将更像是编排一堆小任务再让小智能体去执行。

任何有明确规范的PR(拉取请求)都可以由o系列模型完成,并且错误率也小得可以接受。不过,也有个问题:上下文窗口太小,无法装下一个代码库。但Sam Altman(OpenAI CEO)这样的领导者也很清楚这一点。

AI自动化会快速取代所有软件工程师吗?不会。软件工程不只是根据明确清晰的提示制作PR。与数学家不同,软件工程师需要不断与物理世界打交道(也就是其他人)。工程师必须与客户合作以理解他们的需求,与团队成员合作以理解他们的需求。当工程师设计架构或编写代码时,他们是带着大量组织背景在做这件事,o4做不到这一点。但o4将帮助掌握这些背景的工程师效率提高10倍。

如果软件工程师提效10倍,那么就会需要更少的软件工程师吗?嗯,如果说的是一家具体的公司,那么可能软件工程师需求确实会下降,因为他们可以用更精简的团队实现相同的产出。然而,全世界对软件工程师的需求可能会增加,因为这个世界肯定还需要10倍以上的高质量软件。所以我认为我们将看到精益公司应用开发的黄金时代。每个人和每家企业,都将获得自己的个性化微应用。

更长远地看(>2年),软件工程将变得完全不同,但我很难说它会变成怎样。当o6模型问世并且完全整合进我们的应用,又怎么会不变呢?3年后,前端工程师这样的岗位可能就不存在了。这听起来奇怪吗?并不。30年前,我们也没有前端工程师这个角色。

回头看看,我们能看到每一代软件都在发生天翻地覆的改变。软件的核心一直都围绕着将需求变成纯逻辑这个过程。在这个转变过程,已经从二进制代码上升到了Python。现在则是向英语等自然语言(Ps.中文也可以)上升。

能用英语等自然语言编程,这就为非技术人士进入这一领域打开了大门。但最好的开发者依然还是那些能在各个抽象层级上自如切换的人。

简而言之,由于软件工程实际上是通过代码来理解和解决组织的需求,因此,软件工程完全自动化的那天就是所有组织完全自动化的一天。

前面,我们经讨论了一些知识工作者。那AI对体力工作者有何影响呢?AI也会接替体力劳动,但会更慢一些。因为还必须处理重力和摩擦。o系列模型对机器人帮助不大,毕竟一次思考需要一个小时的模型,对生产线上的机器人来说没多大用处。

基础模型变得更智能确实对机器人有帮助,o系列模型也将帮助训练这些模型,但我不认为这能解决机器人技术进步的最大瓶颈。我认为,这个最大障碍是硬件提升以及快速/可靠的感知+动作模型。这些,需要更长的时间才能获得改进(好几年)。

只有当机器人开始制造机器人,AI开始进行AI研究时,机器人技术才会出现疯狂的快速进步。这可能会由o系列模型实现,也许等几年就可以看到了。

我一直在用年为单位讨论,但也许我们真的应该用「计算能力」为单位。时间决定人类产出,计算能力决定AI产出,而AI产出将逐渐成为研究机构最重要的事情。正因为此,科技巨头们都在激烈地竞相构建超级计算集群,比如Meta的2GW集群、xAI新增的10万台H100。

所有实验室都将快速跟进OpenAI,有些实验室可以通过更多的计算来弥补起初较差的算法。他们会像赶上GPT-4一样赶上o系列模型。要造出这些模型,需要结合常识和每个实验室的独特秘诀。

目前还不清楚OpenAI在o系列模型方面有多少独特秘诀,但他们的提升速度表明这是一种算法上的进步(更容易复现),而不是某种独特的数据组合(更难复制)。

在这个测试时间计算时代,我不清楚拥有更多计算能力更重要还是更优模型更重要。一方面,你可以通过投入更多的测试时间计算来弥补较差的模型。另一方面,稍好一点的模型可能会节省指数级的计算量。

如果xAI直接凭借更擅长打造超大集群而最终赶上了OpenAI,那一定会很有意思。

无论如何,模型护城河都不会持续超过一年时间,因为人工智能实验室就像在交换棒球卡一样交换研究人员,也许更重要的是,实验室之间的研究人员会一起聚会和睡觉。另外,我认为研究人员他们也很有理想主义,如果事情失控了,他们不会不分享信息。

我们现在的处境很疯狂。AI竞赛搞得像核竞赛一样,比如美国人和苏联人周末在洛斯阿拉莫斯一起聚会,在X上互相挑衅”打赌你2025年不会有最大的核弹哦,lols:)”

AI竞赛将继续给人一种嬉皮娱乐的感觉,直到政府介入或发生一些非常糟糕的事情。

o系列模型将激励大规模减少,因为它们能随着计算的增加而获得明显的收益。计算提供商最喜欢看到这样的Scaling Law(规模定律,训练数据越大,模型越智能)了。我猜,当Sam Altman想要一个数万亿美元的计算集群时,看到的就是这个定律。

对英伟达来说,并不见得是好事。o系列模型让推理比训练更重要。我认为,超级优化的推理芯片比训练芯片更容易制造,因此英伟达在这方面的护城河并没有那么不可撼动。

大胆预测:如果o系列模型能解锁全世界聚合的计算能力来训练最好的模型呢?比如,我们把Macbook Pro合在一起,组成一个推理千兆集群,那么开放源代码就能打败封闭源代码,那该有多酷?

现在除了计算之外,代码本身也是一个新的指数级增长因素。如果一个人工智能实验室独家/特权访问最智能的模型,使他们软件工程师的生产力比其他实验室高出2倍,那么他们就能更快地接近下一个生产力翻倍。

除非代码速度达到上限,有大量实验要运行,实验室再次被计算能力所限制。(我不知道,动态变化很复杂。如果能看到实验室如何模拟计算与人力之间的关系,那将是一件超酷的事。)

虽然所有这些计算建设和知识工作自动化听起来都很疯狂,但只有当科学家们开始感受到AGI的时候,这一切才会变得真正疯狂。这里,我指的是物理学家、化学家和生物学家。

AI将从任何带有”理论”二字的领域开始。理论物理学是第二位的。如果数学真的被解决了(写这句话听起来都很荒谬,但这并不意味着它不可能),那么理论物理学应该也不会落后太远,它也生活在符号领域,LLM将在这个领域成为超人。

当我们有一百万个AI冯诺伊曼在卢萨纳(Meta即将建立的数据中心)的田野上日夜工作时,会发生什么?他们会多快读完过去一个世纪数千科学家写的每篇物理论文,并立即吐出更多正确的科学理论?

显然,这是难以预测的。理论物理、化学、生物学,如果这些对经过RL强化学习训练出来的LLM来说是个笑话呢?在这一点上,我们有什么合理的理由来证明它不会是笑话?

是的,我们还没有从这些模型中看到真正的创新,它们目前大多停留在高中/大学水平,显然这些年龄段不会发明新的物理学。o系列模型带我们来到了博士水平,近期内我们有可能会看到一些由AI创造的发明。

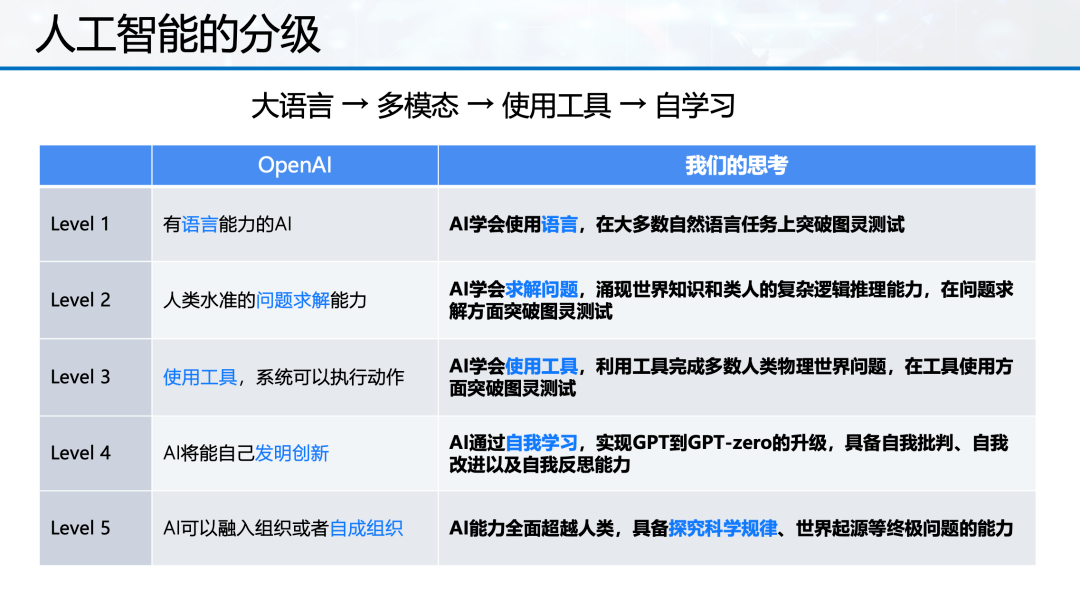

OpenAI&智谱对人工智能的分级,认为我们目前处于L2到L3的水平

一旦AI开始不断提出新的科学理论,进步的瓶颈将是在物理世界中进行测试和实验。那里的瓶颈是劳动力和材料。到那时,如果没有能制造出更多机器人,那才叫奇怪呢。因此,劳动力问题已经解决。然后,机器人可以开采材料。预计这里的时间表会很慢,因为建造-运输实物需要很长的时间,但这也是几年而不是几十年。

我以上所说的一切,都是假定人工智能和机器人的研究/开发不会遇到新的瓶颈,而且模型可以随心所欲地学习。但这几乎不可能,阻碍人工智能发展的最大瓶颈是人类。比如监管、就业和社会问题。

(以下部分辩证看待,为了保持原文味道,我还是将他们都放了上来。)

政府不会坐视地球被几家旧金山公司运营的自动机器人开采(监管问题)。如果政府无法阻止,那么愤怒的失业者可能会诉诸暴力(就业问题)。除非人们被AI增强的媒体弄得非常麻木以至于我们无法作为一个社会运作(社会问题)。

这会Kill所有人吗?我更害怕人类滥用AI而不是AI失控。

我们有5000年的证据表明人类使用新技术相互残杀。二战后的和平是一个异常现象,一旦人类认为有必要先发制人以阻止AI加速时,这种和平就可能会崩溃。当武器变得更致命、更自主时,风险就更高。

另一个风险是AI导致社会混乱。AI生成的媒体有可能导致大规模混乱、歇斯底里和大脑腐烂。

图由即梦AI生成。提示词:平面插画,极简主义,留白,矢量,时光倒流,远光中走来,你一身晴朗。

另一个风险是AI失控。这意味着它会导致我们无法预测的灭绝级事件。特别是随着RL强化学习的回归,AI正在发现自己的优化方法,而不是试图匹配人类数据(当然,匹配人类会更安全)。

到目前为止,这些模型的底层大脑仍是LLM,而LLM已经表现出只是理解人类。就像如果你在提示词中包含”确保不要做任何可能Kill我们的事情”,现在就得由你来证明它仍然可能Kill我们。

但,我的兴奋感多于害怕感。

我一直向往的科幻世界,它正加速到来。来得比预想的要快一些,因此我感到恐惧,但在所有可能到达那里的路径中,我不知道最好的路径会有多好。这是一个理想化的时间表。

-

-

-

完美的家庭教师/建议(几乎就要实现,需要良好的检索能力、记忆力和更多的个性);

-

-

-

-

意料之外:人工智能天文学家在望远镜数据中发现外星信号?人工智能化学家轻松设计出室温超导体?人工智能物理学家统一了一些理论?人工智能数学家解决了黎曼猜想?

这些看起来不再是科幻小说,而是近在咫尺的科学现实。

图由即梦AI生成。提示词:机器人正在建造火星基地,科幻风格,电影质感。

那这一切将走向何方?最终我们会得到超级智能,这意味着我们会得到物理定律所允许的一切。我想要永生并看到其他恒星系统。我也希望把我们的肉体升级到更好的东西。但到目前为止,我最想知道的是宇宙从何而来。

10年前,我开始写日记,记录我是多么想知道这个答案,以及人工智能将如何把我们带到那里,而现在这一切可能真的要发生了,这太疯狂了。

我们现在生活的世界,这一切听起来都有可能实现。每一次新的人工智能发展都会让更多的人意识到这一点。o3,就是离他们更近的一次。

现在唯一可能导致未来不那么美好的方式就是我们人类自己把它搞砸了。比如我们的舆论、政策、社会支持和国际合作,这些都是可能阻止这个美好未来的障碍。

人们认为人工智能实验室的人在控制我们的未来。我不这么认为。他们的工作已经确定。他们只是在探究模型架构,就算这个实验室不做,也会有其他的实验室来做。

我们每一个人都有责任帮助我们的世界渡过未来的艰难时期,让我们拥有一个美好的未来,而不是一个可怕的未来。

有很多方法可以帮助我们:帮助制造能让社会更稳定或让人们更聪明的产品(例如帮助人们规范社交媒体的应用程序)。帮助人们了解正在发生的事情(在社交媒体上提供更多高质量的文章(比如沃垠AI,这句话额外加的![]() )、一个非常好的搜索引擎等)。

几乎每个与我交谈过的人都害怕在人工智能世界中失去意义,你可能也是。我想对你说,这不正好相反吗?你生活在历史最重要的时期,你有能力影响它。一起帮助拯救世界就够了,不是吗?难道你想回到那个只有你的事业进步而不是世界都在进步的时代?

)、一个非常好的搜索引擎等)。

几乎每个与我交谈过的人都害怕在人工智能世界中失去意义,你可能也是。我想对你说,这不正好相反吗?你生活在历史最重要的时期,你有能力影响它。一起帮助拯救世界就够了,不是吗?难道你想回到那个只有你的事业进步而不是世界都在进步的时代?

图由即梦AI生成。提示词:NFT艺术,像素风,城市夜景,霓虹灯光,夜晚的海边公路,故障风,粒子特效。一辆车行驶在海边公路,大小不一的像素方块,意识流。

也许,人们需要做的转变是从「通过个人成功获得意义」到「通过集体成功获得意义」。我们目前的许多工作很快就会自动化,我们必须适应。如果你从一项特定的技能中获得意义,这项技能可能在5年后就不再需要了,那你就倒霉了。但如果你能从尽可能帮助世界中获得意义,那么这永远都不会消失。

对于所有因为o3而得到建议的应届毕业生,我的建议是:学习成为一个高水平的问题解决者和出色的团队合作者。你在学习过程中学到的具体技能并不重要,因为世界变化太快。但是,在很长一段时间内,跳跃性地解决问题和与团队良好合作将非常重要。

你也可能需要接受不稳定世界中的不稳定生活。事情会变得很怪异。你可能不会在郊区有两个孩子和一条狗。但你可能会在星际方舟上有两个机器人孩子和一只人工智能狗。

我们正生活在AGI的前夜,我希望你们能帮助AGI顺利过渡,这样我就能在公元3024年的新年夜,在四光年外绕着 Altman Centauri运行的星球上向你们问好。

原文:

https://x.com/WilliamBryk/status/1871946968148439260

(文:沃垠AI)

)的任务方面都非常出色。数学和编程的奖励函数相对容易设计,小说创作则比较困难。

)的任务方面都非常出色。数学和编程的奖励函数相对容易设计,小说创作则比较困难。

)、一个非常好的搜索引擎等)。

)、一个非常好的搜索引擎等)。