AI智能体终于有了「自测报告」!

开发者John David Pressman带来了一个全新的AI智能体架构:Weave-Agent,专门解决了传统ReAct智能体的决策脱节问题。

这可算得上是一个真正的技术突破,让AI智能体终于能够「自我检验」了。

为什么传统ReAct架构会「掉链子」?

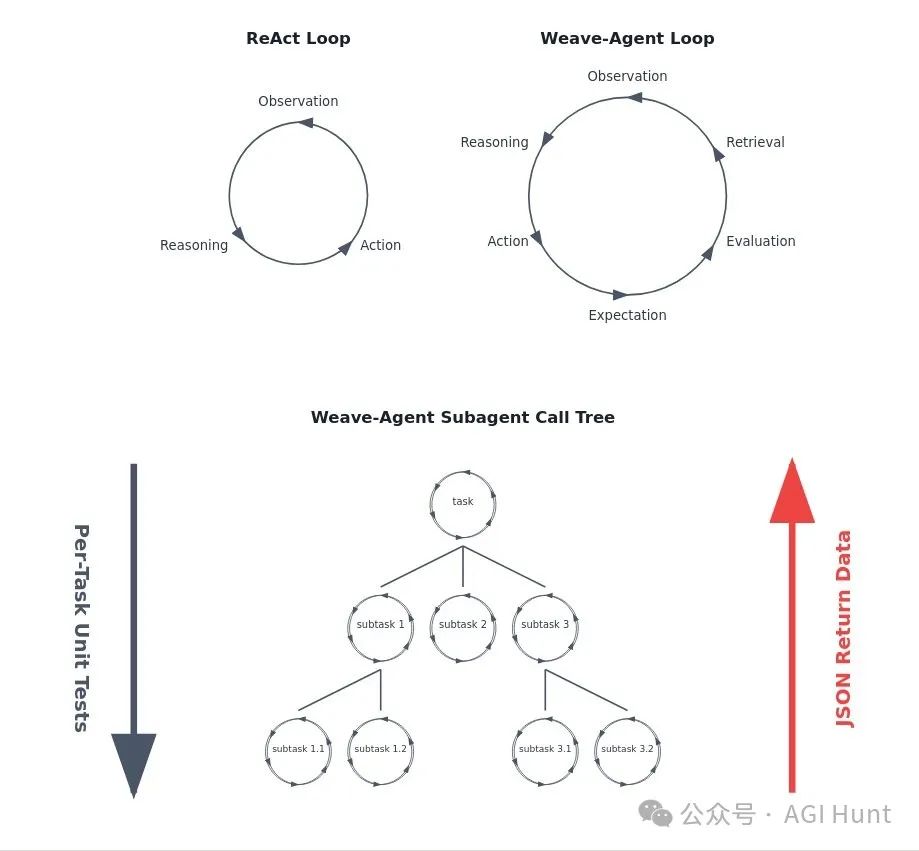

传统的ReAct架构包含三个步骤:观察(Observation)、推理(Reasoning)和行动(Action)。

这个过程就像个「没有自我检查的决策者」,它不断重复这个循环,但经常会出现推理过程与实际问题状态脱节的情况。

简单说,就像一个考生写完试卷后直接交卷,没有检查答案是否合理。这种方式显然容易出错,特别是在处理复杂任务时。

Weave-Agent:给AI装上「验算系统」

Pressman的解决方案很巧妙:在传统的ReAct循环中,增加了「单元测试回调」机制。具体来说:

-

写下预期:AI在执行每个动作前,都要先写下预期的结果

-

实时检验:通过单元测试来验证实际结果是否符合预期

-

数据返回:所有结果都以JSON格式返回,保证数据的标准化

-

评估反馈:增加了评估(Evaluation)和检索(Retrieval)环节

这就像给AI装上了一个「验算系统」,每走一步都要核对一下是否正确。

递归分解:化繁为简的智慧

Weave-Agent最厉害的是它的递归问题分解能力。它采用了一种树状结构:

-

主任务会被分解成多个子任务

-

每个子任务又可以继续分解,直到变得足够简单

-

所有子任务都有独立的单元测试

-

数据以JSON格式在各个层级间传递

这种方式让复杂问题变得容易处理,就像把一个大象切成小块,再一块块吃掉。

MiniHF:让Weave-Agent落地的工具箱

为了让这个创新架构更容易使用,Pressman开发了MiniHF工具套件,它提供了:

-

轻量级Web界面:让开发者可以轻松分支会话,选择最佳输出

-

交互式推理服务器:支持多种本地语言模型

-

Weave算法:基于蒙特卡洛树搜索(MCTS)的推理算法

-

双重微调能力:

-

生成器LoRa:生成待评估的文本

-

评估器LoRa:在树搜索中选择最佳分支

-

RLAIF支持:基于AI反馈的强化学习,可以引导新的文档上下文

-

简单安装:最小化依赖,快速部署

不仅是技术创新,更是思维方式的革新

Pressman强调:「这个项目的设计并非随意拼凑当下流行的技术,而是为了实现一个核心理念:我们应该为语言模型创造新的文档类型,让它们更容易推断出我们想要的信息。」

这项创新为AI开发带来了重要启示:

-

AI智能体需要自我检验机制

-

复杂问题需要系统化的分解方法

-

AI系统的设计要考虑可验证性

项目已在GitHub开源,地址在这里:

https://github.com/JD-P/minihf/tree/main/agent

当AI也能进行自我检验时,它的决策才会更可靠,和值得信赖。

或许,这将成为未来AI智能体的标准架构。

(文:AGI Hunt)