随着对高效轻量化语言模型的需求增长,资源受限场景迫切需要更加经济的解决方案。然而,当尝试使用小语言模型(SLMs)来代替 LLMs 时,当前的 RAG 框架暴露出明显不足。这些紧凑模型虽然具备计算效率和部署灵活性的优势,但在 RAG 的关键操作上却遭遇瓶颈:

- 语义理解不足:SLMs 难以精准捕获复杂的自然语言查询意图。

- 信息检索挑战:现有架构设计倾向于依赖强大的 LLM 推理能力,SLMs 很难高效适配。

- 性能显著下降:复杂查询、多步推理和细粒度信息合成任务对 SLM 带来了较大压力,导致实际表现难以满足预期。

这种架构不匹配造成了两种极端结果:要么严重损失性能,要么大幅提升计算成本,彻底偏离 RAG 在资源受限场景中的应用初衷。

针对这些关键痛点,学者们提出了 MiniRAG,一个极简高效的 RAG 框架,专为小语言模型设计。MiniRAG 的核心目标是通过创新架构和优化技术,让 SLM 在保持性能的同时满足轻量化需求。

两大技术创新:

-

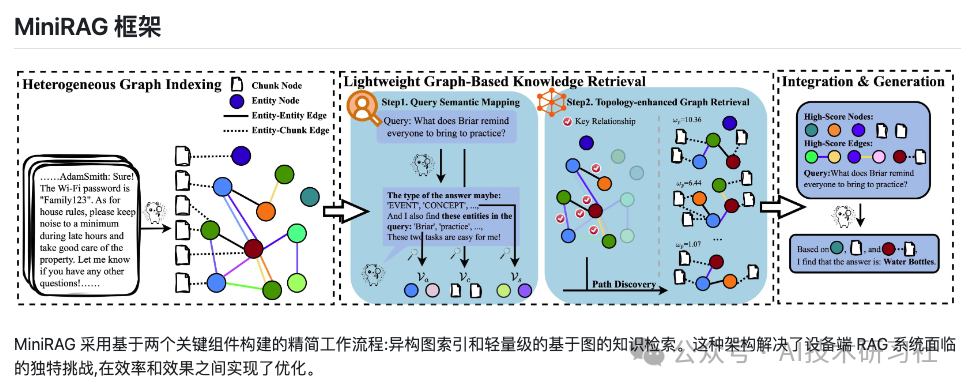

语义感知异构图索引

MiniRAG 将文本块和命名实体结合到一个统一的异构图结构中,显著减少了对复杂语义理解的依赖。借助这一机制,SLMs 能够高效地检索和关联相关信息,无需额外的深度推理支持。 -

轻量级拓扑增强检索

我们开发了一种基于图结构的知识发现方法,通过分析文本节点之间的拓扑关系,帮助模型快速找到核心信息。这一方法在不依赖高级语言能力的情况下,依然能够实现高效、精准的知识检索。

为应对上述挑战,MiniRAG 引入了两项创新设计:

- 异构图索引机制

通过统一结构将文本块与命名实体结合,简化语义理解过程,显著降低了 SLM 对复杂语言能力的依赖。例如,它能够自动识别重要的上下文关联,而无需深入推理。 - 拓扑增强检索方法

基于图结构的轻量级方法,通过节点之间的关系优化信息检索的精准度和效率,即使在面对嘈杂数据时,也能高效筛选出相关内容。

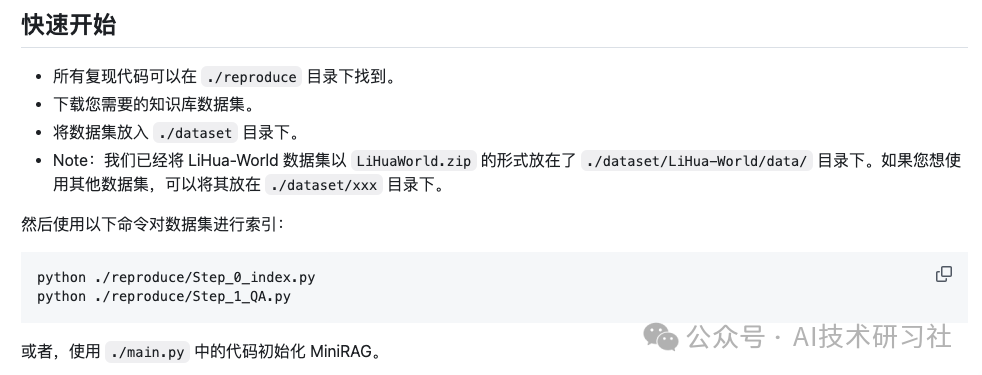

开源项目:https://github.com/HKUDS/MiniRAG/tree/main

cd MiniRAGpip install -e .

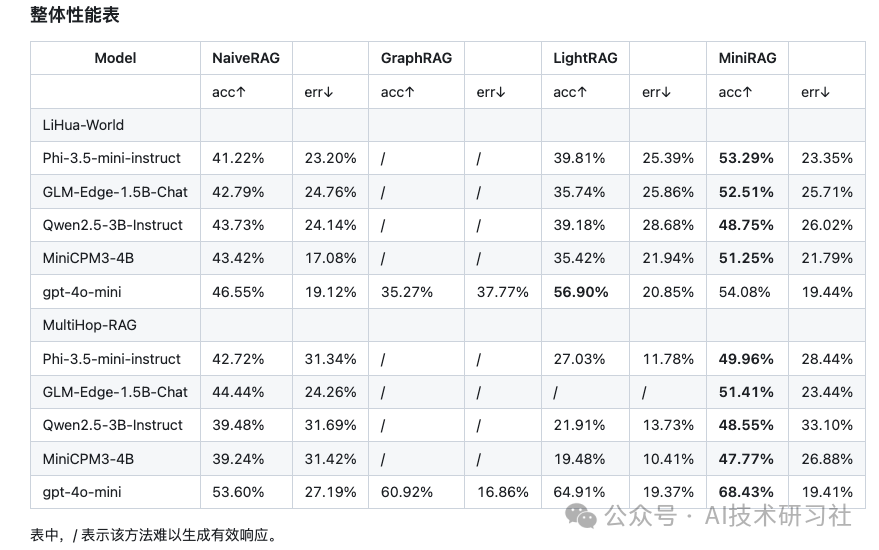

MiniRAG 通过引入语义感知的图索引和拓扑增强检索方法,为 SLM 在资源受限场景中的高效部署提供了强有力的解决方案。实验结果表明,MiniRAG 能在保持接近 LLM 性能的同时,仅需 25% 的资源消耗,这一突破为边缘设备和隐私敏感应用开启了新篇章。

(文:AI技术研习社)

现有架构设计倾向于依赖强大的 LLM 推理能力,真是讽刺啊! MiniRAG 这家伙倒是想得挺巧妙, Resource consumption just 25%? 不过话说回来,这东西能省下75%的资源,还是得给它点掌声。

现有RAG架构完全不懂装懂,只会依赖大模型做 everything!