笔者开始写公账号大概一个月时间了,期间收到很多同学的私信,发现大家对LLM基础技术还是比较感兴趣,故根据我现在已有的知识,给大家整理一个脑图;主要梳理了基础技术篇的脑图,后续文章会继续给出开发、应用偏的脑图;辅助小伙伴们对LLM认知。

脑图下载地址:https://github.com/PulsarPioneers/llm-learn/blob/main/assets/llm-learn-base-mind.svg

1. LLM基础概念

1.1 定义与背景

什么是LLM:

基于深度学习的自然语言处理模型,具备生成、理解和处理文本能力。

发展历史

- 早期NLP:规则系统、统计模型(HMM、CRF)。

- Transformer时代:2017年《Attention is All You Need》。

- 规模化模型:GPT系列、BERT、T5等。

核心特点

- 大规模参数(亿级到万亿级)。

- 自监督学习(Pre-training + Fine-tuning)。

- 多任务适应性。

1.2 工作原理

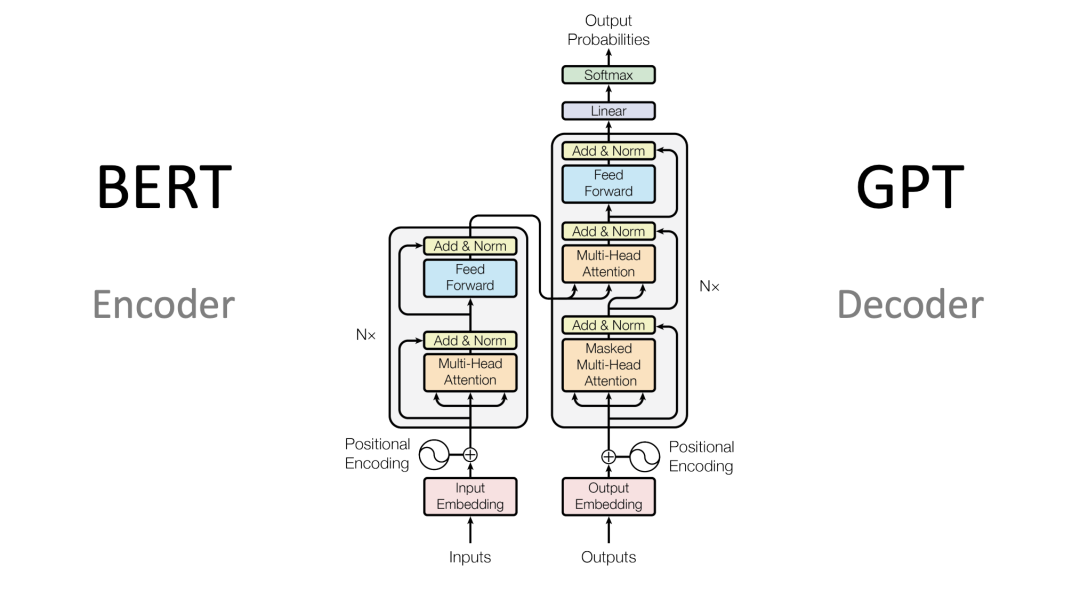

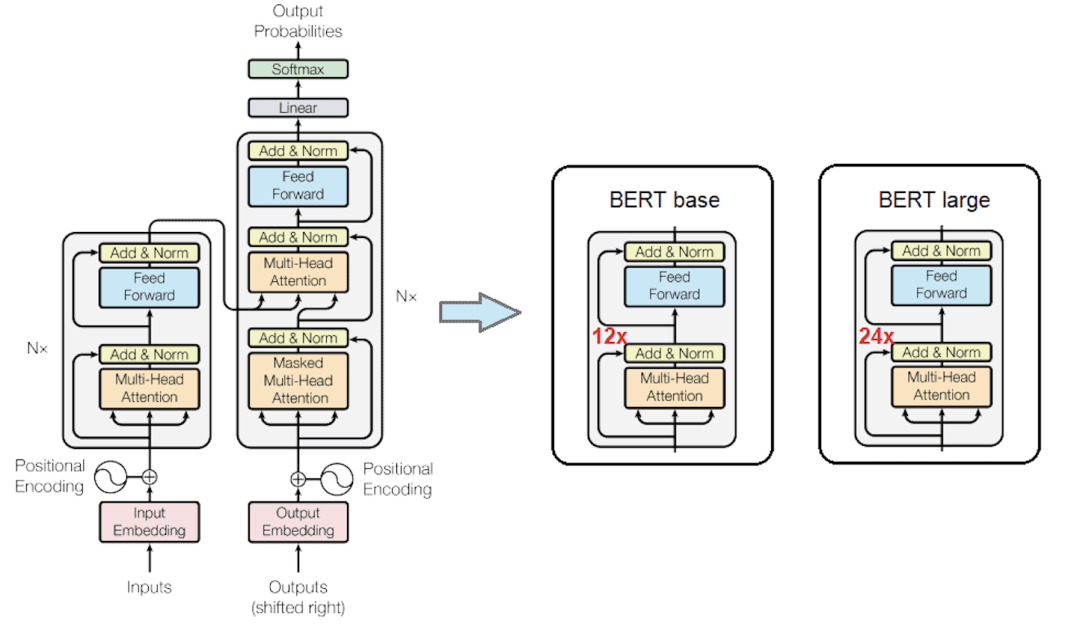

Transformer架构

- Encoder-Decoder结构(BERT vs GPT)。

- Attention机制:Self-Attention、Multi-Head Attention。

- Positional Encoding:处理序列顺序。

训练过程

- 预训练:大规模无标注文本(Common Crawl、Wikipedia)。

- 微调:针对特定任务(分类、生成)。

- 指令微调(Instruction Tuning):提升指令理解。

关键技术

- Tokenization:WordPiece、BPE。

- Embedding:Word、Position、Segment。

- Layer Normalization与残差连接。

2. LLM核心技术与算法

2.1 模型架构

主流模型

- GPT:生成式,自回归。

- BERT:双向,掩码语言模型。

- T5:文本到文本框架。

- LLaMA:高效研究模型。

架构优化

- Sparse Attention:降低计算复杂度。

- Mixture of Experts(MoE):动态路由提升效率。

- FlashAttention:优化GPU内存使用。

2.2 训练与优化

数据处理

- 数据清洗与去重。

- 多语言与多模态数据。

优化算法

- Adam/AdamW:主流优化器。

- Learning Rate Schedule:Warm-up与衰减。

分布式训练

- 数据并行 vs 模型并行。

- Pipeline Parallelism与Tensor Parallelism。

- ZeRO(DeepSpeed):内存优化。

2.3 评估与指标

通用指标

- Perplexity:生成质量。

- BLEU/ROUGE:文本生成评估。

- F1/Accuracy:分类任务。

任务特定指标

- GLUE/SuperGLUE:NLP综合基准。

- MMLU:多任务语言理解。

- 人类评估

- 流畅性、相关性、一致性。

3. LLM应用场景

3.1 文本生成

应用案例

- 文章创作、故事生成。

- 代码生成(Copilot、CodeLLaMA、Cursor)。

- 对话系统(ChatGPT、Grok、 DeepSeek)。

挑战

- 事实性(Hallucination)。

- 上下文一致性。

3.2 文本理解

任务类型

- 情感分析、文本分类。

- 命名实体识别(NER)。

- 问答系统(QA)。

技术要点

- 上下文建模。

- 知识增强(Knowledge-Augmented Models)。

3.3 多模态与跨领域

多模态LLM

- 文本+图像:CLIP、DALL·E、Flamingo。

- 文本+音频:Whisper。

跨领域应用

- 医疗:临床记录分析。

- 法律:合同审查。

- 教育:自动批改、智能辅导。

4. LLM开发与部署

4.1 开发工具与框架

主流框架

- PyTorch/TensorFlow:模型开发。

- Hugging Face Transformers:预训练模型库。

- DeepSpeed/Megatron:分布式训练。

开发流程

- 数据准备与预处理。

- 模型选择与微调。

- 超参数调优。

4.2 部署与优化

部署方式

- 云端API(OpenAI、DeepSeek)。

- 本地部署(ONNX、Triton、Ollama)。

优化技术

- 量化(Quantization):INT8、FP16。

- 剪枝(Pruning):减少冗余参数。

- 蒸馏(Distillation):小模型继承大模型能力。

硬件加速

- GPU/TPU:主流训练硬件。

- Inference优化:NVIDIA TensorRT。

4.3 开源与生态

开源模型

- LLaMA、Mistral、Grok(部分开源)。

- Hugging Face社区模型。

数据集

- The Pile、C4、RedPajama。

社区与工具

- GitHub、Kaggle。

- Weights & Biases:实验跟踪。

5. LLM挑战与未来

5.1 技术挑战

计算成本

- 训练与推理的高昂算力需求。

- 能耗与环境影响。

模型局限

- 偏见与公平性。

- 鲁棒性与对抗攻击。

伦理问题

- 隐私保护。

- 虚假信息生成。

5.2 未来方向

高效模型

- 更小、更快、更节能的模型。

- 模块化与可组合模型。

多模态融合

- 统一文本、图像、音频、视频。

自主学习

- 在线学习与自适应。

- 强化学习与人类反馈(RLHF)。

6. 学习资源与路径

6.1 入门资源

书籍

- 《Deep Learning》(Goodfellow et al.)。

- 《Natural Language Processing with Transformers》(Hugging Face)。

课程

- Stanford CS224N:NLP课程。

- Fast.ai:实用深度学习。

博客与教程

- Hugging Face Blog。

- Distill.pub。

6.2 进阶资源

论文

- 《Attention is All You Need》(Vaswani et al.)。

- GPT-3、PaLM、LLaMA系列论文。

项目实践

- Kaggle竞赛:NLP任务。

- GitHub项目:微调LLM。

社区

- Reddit:r/MachineLearning。

- Discord:Hugging Face社区。

6.3 学习路径

初学者

- 学习Python与PyTorch基础。

- 理解NLP基础(词向量、RNN)。

- 实践简单Transformer模型。

中级

- 微调BERT/GPT模型。

- 参与Kaggle NLP任务。

- 阅读核心论文。

高级

- 开发定制LLM。

- 优化分布式训练。

- 研究多模态与RLHF。

结束语

脑图最后结果在这里可以下载:

https://github.com/PulsarPioneers/llm-learn/blob/main/assets/llm-learn-base-mind.svg

后续我会继续出开发、应用的相关脑图;感谢各位小伙伴的支持~~~ 🚀🚀🚀

(文:PyTorch研习社)