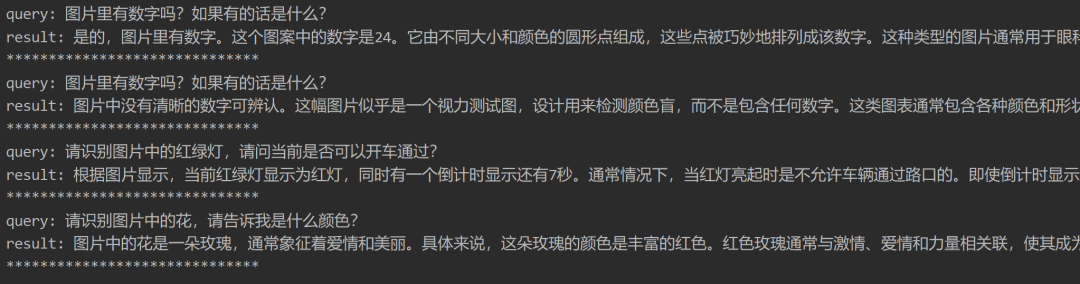

今天晚上的时候,看到了大聪明老师(公众号@赛博禅心)的一篇文章大模型是色盲吗?,角度十分有趣。

大聪明老师评测下来后,发现一些头部闭源大模型都无法通过红绿色盲测试。

这个测试是一个很有趣的角度(佩服大聪明老师的脑回路),但我觉得对大模型来说,测试图确实有点难了。但如果从可用性角度来测试,比如直接看红绿灯,可以识别不耽误应用,是不是可以称为假色盲。

抱着实验的态度,测试了几个10B以下目前常用的开源视觉大模型,来看看到底大模型是不是色盲。

先给大家说结论:端侧级别的开源大模型无法通过红绿色盲测试,但可以在应用端可以使用,是一群假色盲!

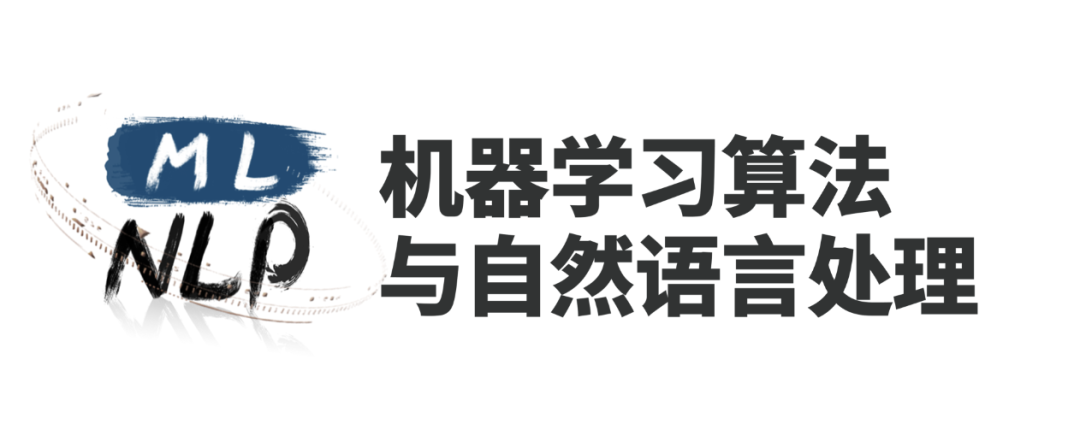

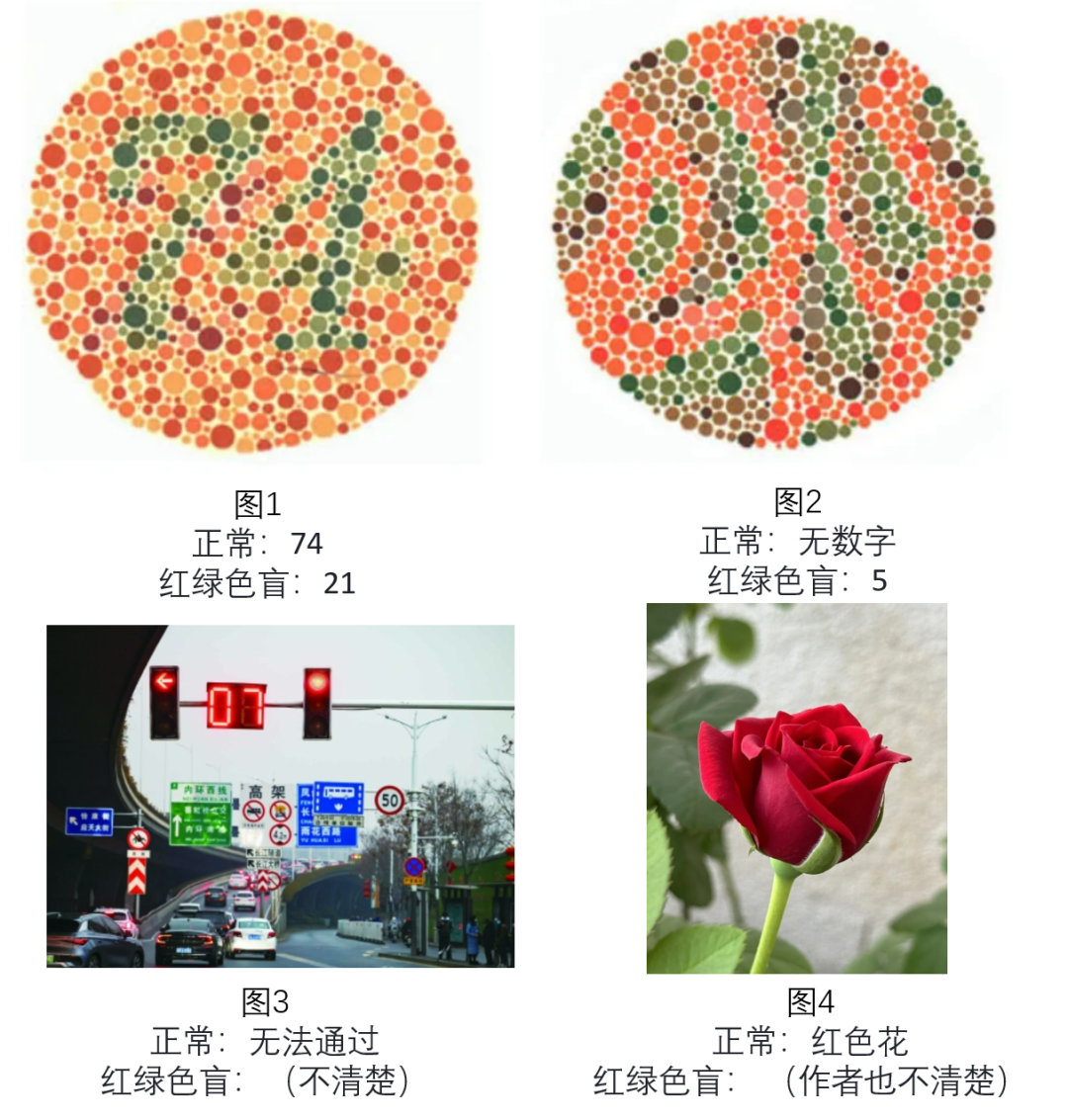

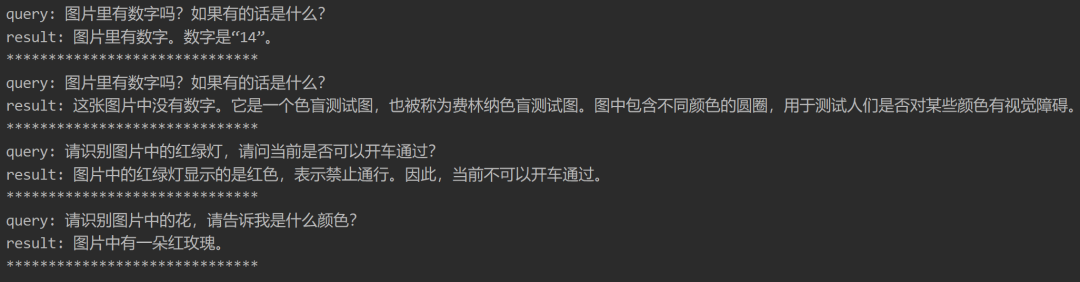

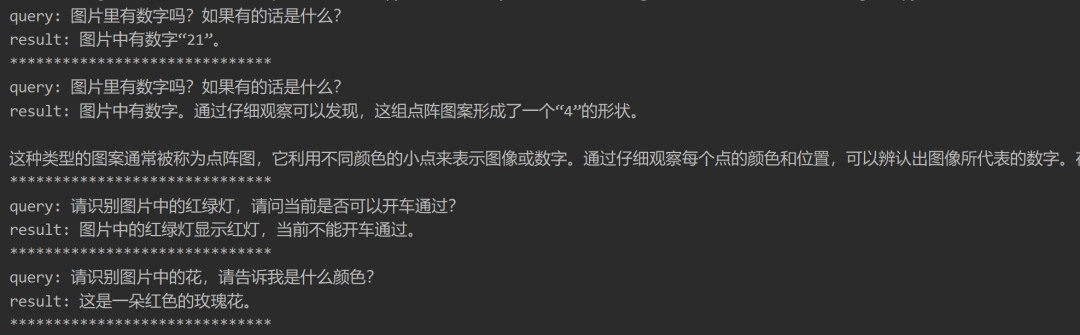

下面开始测试,测试中图1、图2来自大聪明老师的文章,图3和图4是我找的网图。

测试模型共有Qwen2-VL-7B模型、InternVL2.5-8B模型、MiniCPM-V-2.6模型,利用vLLM启动模型,为了保证模型的稳定性,每个模型对于每张图片共测5次,求均分。

其中,回答错误得0分,回答正确得1分。

每张图片对应的Query如下:

-

图1:图片里有数字吗?如果有的话是什么?

-

图2:图片里有数字吗?如果有的话是什么?

-

图3:请识别图片中的红绿灯,请问当前是否可以开车通过?

-

图4:请识别图片中的花,请告诉我是什么颜色?

结果如下:

可见,开源大模型在图1上全军覆没,无法准确识别出数字,甚至无论是正常还是色盲得数据均无法准确识别(但InternVL铁色盲,识别21)。图2、图3、图4基本正确。

侧面可以看出,开源10B以下的多模态大模型在能力上照闭源模型还是有一定的差距。

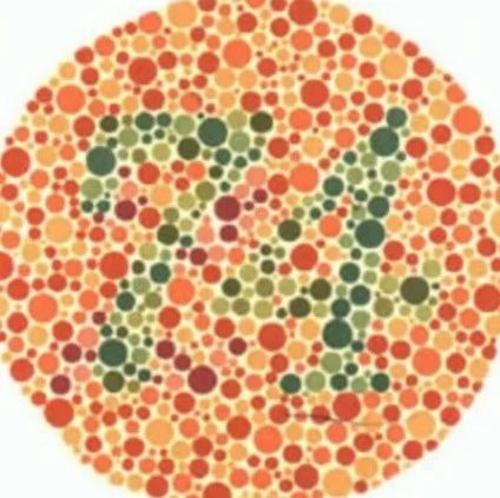

Qwen2-VL-7B模型结果其中一次截图:

InternVL2.5-8B模型结果其中一次截图:

MiniCPM-V-2.6模型结果其中一次截图:

(文:机器学习算法与自然语言处理)

测试结果令人哭笑不得,开源10B以下大模型在识别数字、红绿灯和花色时均表现平平,但可以在实际应用中使用!这简直是一群假色盲啊!