春节假期后的第二个工作周,字节还是憋不住要秀一下肌肉了。人工智能领域,大模型的推理成本与效率始终是制约其规模化应用的核心问题。MoE(Mixture of Experts)架构虽通过参数稀疏化提升了训练效率,但其推理阶段的访存瓶颈导致成本居高不下。

就在刚刚,字节跳动豆包团队提出的UltraMem架构,以最高83%的推理成本降幅和6倍的推理速度提升,个人觉得它不仅突破了现有技术局限,更重新定义了稀疏模型的性能边界。这一创新不仅入选ICLR 2025,更一定程度上重塑大模型产业的竞争格局。

架构困境与UltraMem破局逻辑

MoE在训练时通过稀疏激活专家(expert)降低计算量,但推理时小批量数据(batch size)导致所有专家被激活。

文本生成场景中,每个token需遍历全部专家参数,引发显存带宽压力,延迟显著增加。实验显示,MoE推理延迟中60%以上来自显存访问。

PKM(Product Key Memory)通过大规模稀疏参数存储(value)减少访存,但其单层结构导致参数利用率低,且检索机制仅依赖简单的行列得分加权,模型效果显著弱于MoE。

UltraMem通过三大创新实现“效率-效果-扩展性”的三角平衡:

分层动态内存结构,将单层PKM拆分为多层级联的小型Memory Layer,以固定间隔嵌入Transformer层中,并通过skip-layer连接实现参数跨层复用。例如,在12层Transformer中每3层插入Memory Layer,使稀疏参数参与80%以上的残差计算,显著提升参数利用率。

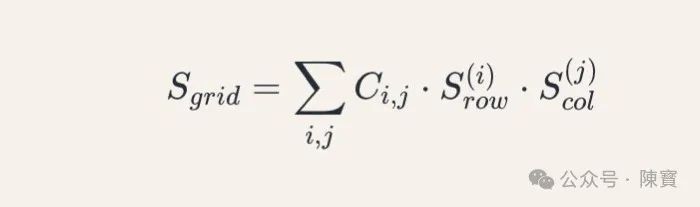

Tucker分解检索(TDQKR),引入高阶张量分解技术,将检索得分分解为行、列得分与核心矩阵的联合优化。

公式表达为:

性能对比与实验验证

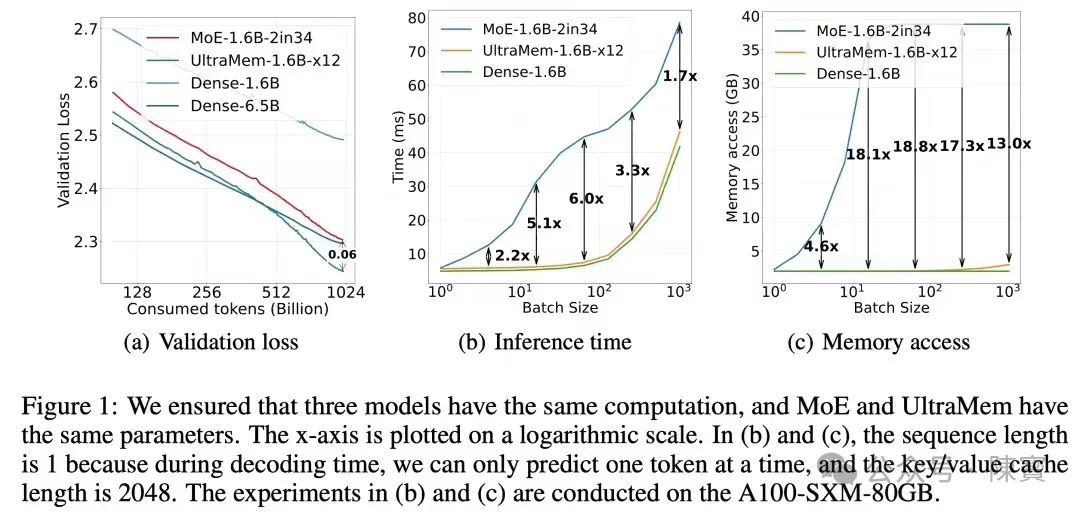

在151M、680M、1.6B参数规模下,UltraMem的推理速度较MoE提升2-6倍,成本降低最高83%。

关键数据如下:

访存优化,MoE推理时显存访问量随专家数线性增长,而UltraMem通过动态激活机制,仅需访问0.5%的稀疏参数。

延迟对比,在batch size=1的生成任务中,UltraMem延迟为12ms,而同等规模MoE高达72ms。

C4数据集中,UltraMem的验证损失(validation loss)较PKM降低0.092,较MoE亦有显著优势。

当稀疏参数与稠密参数比例从10:1提升至100:1时,UltraMem的损失下降呈现对数规律,而MoE因显存瓶颈无法扩展。

逐项引入分层结构、TDQKR和IVE后,模型效果累计提升23%,而计算量仅增加2%,证明技术创新的协同效应。

技术突破行业意义

成本敏感型应用落地中,以客服机器人场景为例。UltraMem能够将单次交互成本从0.003美元降至0.0005美元,使中小企业部署百亿级模型成为可能。

实时性需求场景中,自动驾驶的实时决策过程,UltraMem的毫秒级响应(如50ms内完成复杂环境推理)显著优于MoE的300ms延迟。

UltraMem的低访存特性降低了对HBM(高带宽内存)的依赖,推动GPU与ASIC芯片设计向算力密度优化倾斜。

若UltraMem开源,我认为一定程度上会催生类似Hugging Face的模型库,加速长尾场景的模型微调。

(一)UltraMem证明稀疏模型的损失下降遵循对数规律而非传统幂律,为超大规模模型(万亿参数)的训练提供新方向。

(二)通过算法层显存优化,倒逼硬件设计(如存算一体芯片)的创新迭代。

(三)当前实验集中于通用语料,在医疗、法律等专业领域的效果待验证。

⋯ ⋯

新生事物,总是需要更多的实践来验证的。TDQKR的复杂检索机制也会引入训练不稳定性,需进一步研究正则化方法。

不够完美,才能更加全面认识到不足的地方。现有推理框架(如TensorRT)对动态稀疏计算的支持尚不完善,一定程度上限制部署效率。

UltraMem诞生标志着大模型架构从“暴力扩展”向“智能稀疏”的范式转移,其通过算法-硬件协同优化,在推理效率与模型效果间找到了黄金平衡点。ICLR 2025的亮相之后,这一技术也会让全球AI实验室跟进研究,进而推动行业“低成本、高智能”进程。

(文:陳寳)