图片来源:CES

Z Highlights

开场白

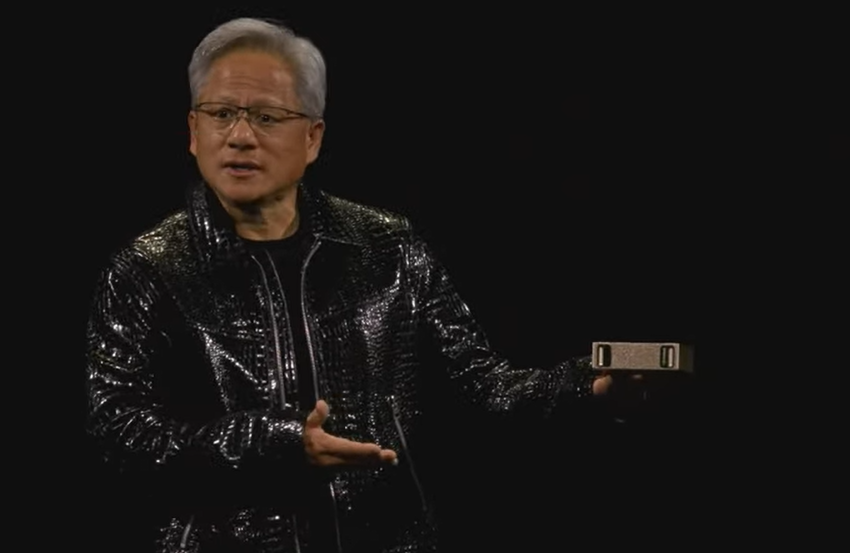

Gary Shapiro:女士们、先生们,欢迎来到CES 2025。我是Gary Shapiro,消费者技术协会的首席执行官兼副主席,CES的主办方。我非常激动地以一场来自世界上最具影响力公司的主题演讲开启这场展会。

Nvidia代表了尖端创新。创始人兼首席执行官黄仁勋是真正的远见者,展示了思想、技术和信念的力量,推动创新并重塑我们的行业和社会。我总是喜欢说,如果我上次多听一点黄仁勋在CTA活动中的发言,我现在可能已经退休了。在过去的三十年里,他已将Nvidia打造成一个在全球范围内推动变革的力量,涉及从医疗到汽车、娱乐等多个行业。今天,Nvidia正在引领AI和加速计算方面的突破,这些技术影响着几乎每个人和每个企业。得益于他的领导力,Nvidia的创新使得先进的聊天机器人、机器人、自动驾驶汽车、同步工厂车间的巨大虚拟世界等成为可能。

黄仁勋被《财富》和《经济学人》评为全球最佳首席执行官,并被《时代》杂志评为全球100位最具影响力的人物之一。但你知道,事实上,就像我们在座的每一个人一样,他的成功和我们的成功并非注定。黄仁勋的起点是作为洗碗工和服务员在Denny’s工作。他说,他在那里学到的努力工作、谦逊和热情待人的品质一直帮助他保持信念,并在Nvidia早期的挑战中坚持下来。

在几分钟后,我们将听到Nvidia创始人兼首席执行官黄仁勋谈论他对未来的坚定愿景以及我们下一步将走向何方。敬请期待,祝大家CES愉快!

GeForce为AI走向大众铺平了道路,而现在AI正回归GeForce

欢迎来到CES。你们激动吗?你们喜欢我的夹克吗?欢迎来到Nvidia。这里的一切都是由AI生成的,这是一次非凡的旅程,非凡的一年。

Nvidia始于1993年。通过NV1(ZP注:英伟达首款GPU),我们想要构建能做普通计算机无法完成的事情的计算机。NV1使得将游戏主机集成到PC中成为可能。我们的编程架构叫做UDA(Unified Device Architecture),其第一个开发者和第一个应用程序是《VR快打》(Virtua Fighter )。

六年后,在1999年,我们发明了可编程GPU,开启了20多年的惊人进展,这种被称为GPU的处理器让现代计算机图形成为可能。如今,30年后,《VR快打》已被完全影视化了。这个新虚拟战士项目正在开发中,我简直迫不及待了,真是太不可思议了。

1999年又六年之后,我们发明了CUDA,这样我们就能用丰富的算法来表达GPU的可编程性。CUDA的介绍曾经很难解释,这花了很多年,实际上差不多六年。又在大约六年后(2012年),Alex Krizhevsky、Ilya Sutskever和Geoffrey Hinton使用CUDA处理了AlexNet。

自从AI起步以来,它已经以惊人的速度发展。从感知AI,我们现在可以理解图像、文字和声音;到生成式AI,我们可以生成图像、文本和声音;现在,进入了AI Agent时代,AI能够感知、推理、规划和行动。接下来的阶段,其中一些我们今晚会讨论,便是物理AI。

2012年,神奇的事情发生了,2018年也发生了非常不可思议的事情。谷歌发布了基于Transformer的BERT(双向编码器表示技术),AI的世界真正起飞了。正如大家所知,Transformer彻底改变了AI的格局。事实上,它完全改变了计算的格局。我们意识到,AI不仅仅是一个新的应用或新的商业机会,更重要的是,机器学习通过Transformer使得计算的运作方式发生了根本性的变化。如今,计算在每一层面上都发生了革命性的变化,从手工编码指令到为CPU运行的程序工具,我们现在有了机器学习来创建和优化神经网络,这些网络在GPU上运行并创造AI。技术栈的每一层都发生了翻天覆地的变化,这在12年内发生了令人难以置信的转变。

现在,我们几乎能够理解任何形式的信息。你们肯定见过文字、图像和声音之类的内容,但我们不仅能够理解它们,我们还可以理解氨基酸,理解物理学,我们理解它们,能够翻译和生成它们。应用的可能性完全是无穷无尽的。事实上,对于几乎所有的AI应用,只要提问:输入是什么形式的学习信息,它从什么信息形式中学习,它又翻译成什么信息形式并生成新的形式,几乎每一个应用都能推测出来。所以,当你看到一个个以AI为驱动、AI为核心的应用时,这个基本概念始终在其中。机器学习已经改变了每个应用的构建方式、计算的运作方式,以及超越这一切的可能性。GPU就是GeForce(ZP注:英伟达开发的个人电脑的图形处理器品牌),在很多方面,这一切与AI紧密相关,GeForce为AI走向大众铺平了道路,而现在,AI正回归GeForce。

有很多事情,没了AI是做不到的。现在让我展示给你们一些。

没有计算机图形学研究员,也没有计算机科学家会告诉你,现在我们能够为每一个像素进行光线追踪。光线追踪是光的模拟。你所看到的几何图形的数量简直不可思议。没有AI,这是不可能实现的。

我们做了两件基本的事。我们使用了可编程着色(programmable shading)和光线追踪加速(ray traced acceleration)来生成令人惊叹的美丽像素。但我们还有AI,通过控制每个像素来生成其他像素。它不仅能够生成其他像素,还能在英伟达的超级计算机上进行了训练。因此,运行在GPU上的神经网络能够推断和预测我们没有渲染的像素。

不仅如此,最新一代的DLSS(ZP注:深度学习超级采样)甚至能够生成超越帧的内容,它可以预测未来,为每一帧生成三帧内容。如果我们仅仅呈现四帧画面,这大约有3300万个像素。那么在这3300万个像素中,我们只需要计算其中的200万个,剩下的由AI预测生成。因此,我们能够以极高的性能进行渲染,因为AI减少了大量计算。

当然,这需要经过大量的训练才能实现。但一旦训练完成,生成过程将会非常高效。这是AI的一个惊人能力,这也是目前许多令人惊叹的技术成果得以实现的原因。

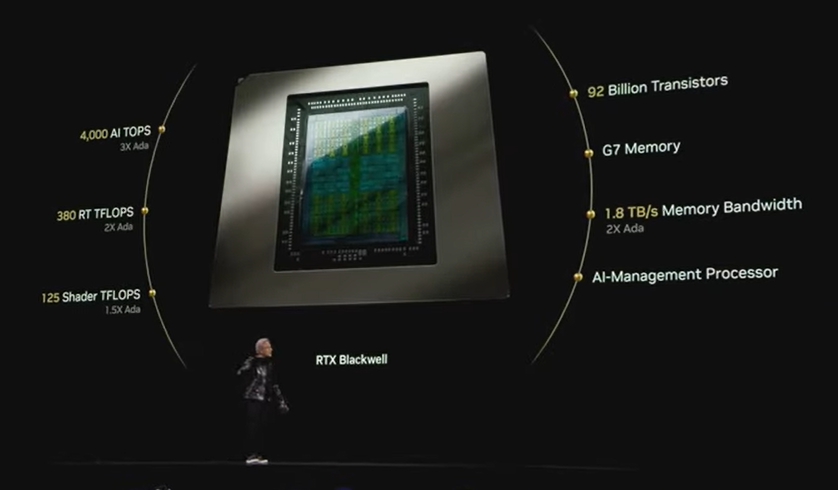

我们利用GeForce启用了AI,现在,AI正在彻底改变GeForce。今天,我们将宣布下一代RTX Blackwell系列。让我们来看看。

全新GeForce RTX 50系列发布,RTX 5090在Blackwell架构创新和DLSS 4的加持下性能是RTX 4090的2倍

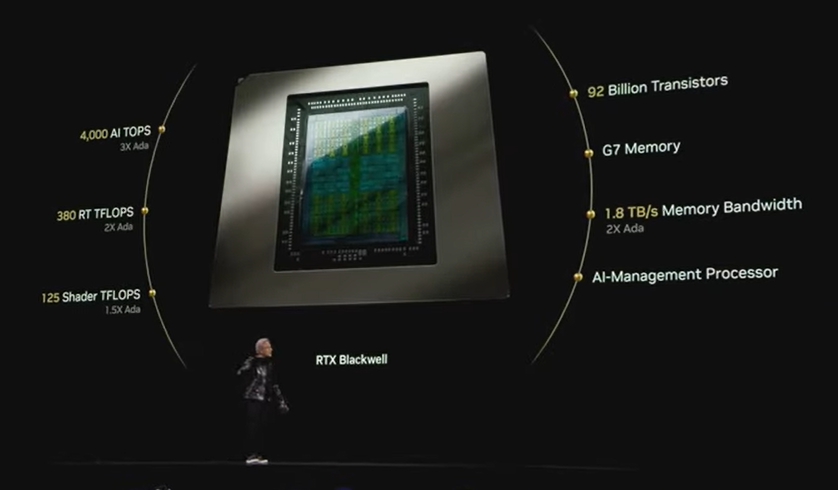

这是我们的全新GeForce RTX 50系列,基于Blackwell架构。GPU简直是个性能怪兽,拥有920亿个晶体管、4000 TOPS(每秒万亿次操作)的AI性能,是上一代Ada架构的三倍。

-

380个光线追踪RT TFLOPS(每秒万亿次浮点运算),用来计算那些我们必须计算的像素,确保计算出尽可能美丽的图像;

-

125个Shader TFLOPS的着色器性能,实际上还包括并行着色器TFLOPS和内存单元等多个因素。它具备浮动点运算、整数运算的性能。

-

这款显卡采用了Micron的G7显存,速度达到每秒1.8TB,是上一代的两倍性能。我们现在有能力将AI工作负载与计算机图形工作负载相互交织。

在这一代中,最令人惊讶的是可编程着色器也能处理神经网络。因此,着色器能够处理这些神经网络。由此我们发明了神经纹理压缩(neural texture compression) 和神经材质着色技术(neural material shading)。正因为如此,我们能够呈现出这些美丽的图像,而这一切都得益于AI学习纹理、学习压缩算法,从而获得了非凡的效果。

这就是全新的RTX Blackwell 5090,即使在机械设计方面,这款显卡也是一个奇迹。它采用了双风扇设计,整个显卡就像一个巨大的风扇,内部的电压调节模块是最先进的。如此卓越的设计完全归功于工程团队的努力。

那么它和之前的RTX 4090相比如何呢?只需1599美元,你就可以把RTX 5090带回家,装进价值10000美元的PC娱乐中心。它有液体散热,灯光效果炫酷,每次离开时都要锁上。这就是现代家庭影院,完美合理。

现在,你只需花1599美元就能升级它,超频到极致。同时,Blackwell系列RTX 5070的性能大幅提升,仅需549美元。没有AI,这一切都是不可能的,没有AI张量核心 (Tensor cores) 的四个顶级四阶运算也不可能,没有G7内存亦不可能。

非常令人惊叹的是,我们将这些强大的GPU放进了笔记本电脑里。RTX 5070 笔记本售价 $1299,却具备RTX 4090的性能。我们把这个强大的显卡装进了这么小的笔记本里——这正是AI的功劳,原因就在于我们通过张量核心生成了大部分像素。我们只进行光线追踪计算所需的像素,其余像素都通过AI生成。因此,能源效率得到了极大的提升。

计算机图形的未来是神经渲染(Neural rendering),AI与计算机图形的融合。令人惊讶的是,这一系列GPU将被放入其中。比如RTX 5090将被放入一台超薄的笔记本电脑中。上一台笔记本电脑的厚度是14.9毫米,搭载了5080、5070 Ti和5070系列。

女士们、先生们,这就是RTX Blackwell系列。

发布超级芯片GB200 NVLink 72,黄仁勋称全世界的互联网流量都能在此芯片上运转处理

GeForce将AI带入了世界,普及了AI,而现在,AI又回过头来彻底改变了GeForce。接下来我们来谈谈AI,走到Nvidia的另一部分。

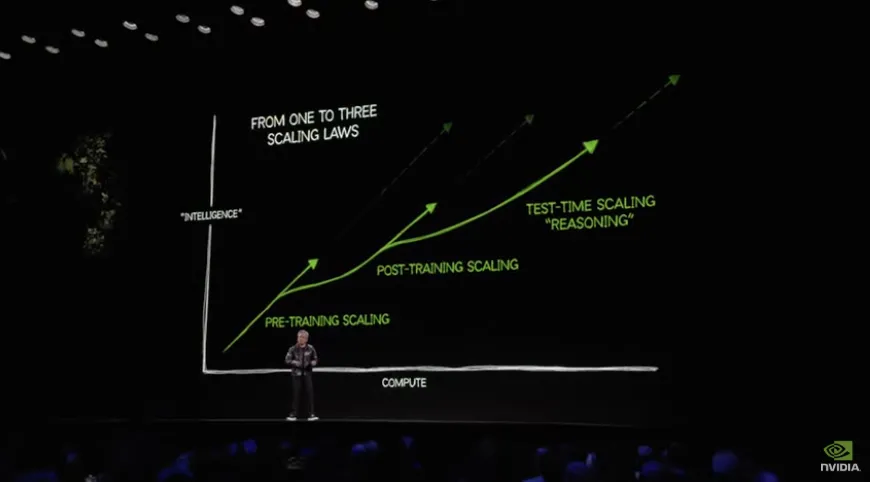

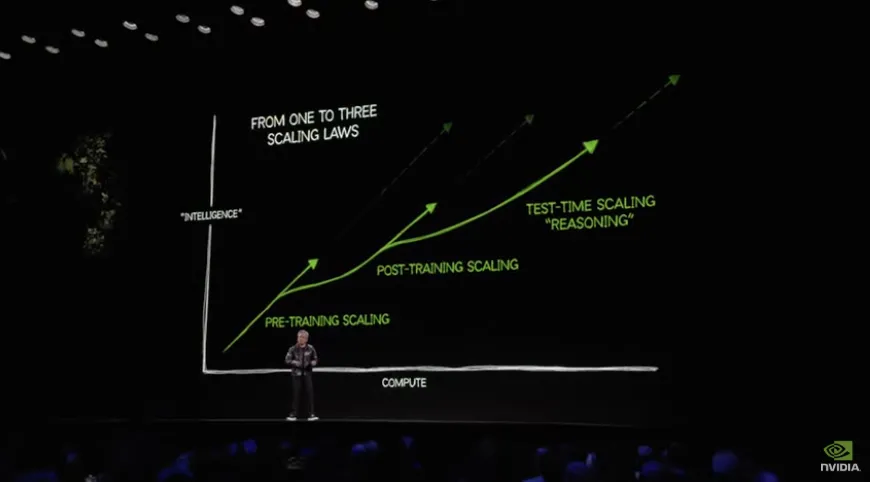

行业正在争相扩大AI的规模。AI的scaling law是一种强大的模型,这是一个通过几代人和行业的研究人员观察和验证的经验法则。Pre-Training Scaling Law(预训练缩放定律)表示,拥有更多的数据、训练模型的规模更大,以及应用更多的计算资源,模型的效果和能力就会越强。所以,scaling laws在继续发展。令人惊讶的是,现在互联网每年产生的数据量是去年数据量的两倍,预计在未来几年,人类将产生的数据量将超过人类历史上所有数据的总和。这些数据可以用来训练AI的基础知识。

第二个扩展法则是Post-training Scaling law(后训练缩放定律)。Post-training Scaling law(后训练缩放定律)使用像强化学习和人工反馈这样的技术。基本上,AI根据人类的查询生成答案,然后人类给出反馈。这个过程比想象的要复杂得多,但强化学习系统通过高质量的提示帮助AI不断优化自己的技能。这种方法就像导师或教练在你完成学校学习后,给你反馈并帮助你提升的过程。比如,AI可以在解决数学问题、推理等方面表现得更好。我们还可以使用强化学习AI反馈和合成数据生成。这些技术与自我提问有些相似,AI不断练习,直到找到正确的答案。

AI可能会面临一个复杂且可验证的数学问题,要求提供解决方案。通过强化学习,AI能够不断改进自己。这就是所谓的后训练,而这种方法需要巨大的计算量,但最终产生的模型非常出色。

我们现在有了第三个扩展法则,它与所谓的Test-Time Scaling Law(测试时间缩放定律)有关。Test-Time Scaling Law(测试时间缩放定律)是指当你使用AI时,AI现在可以决定分配多少计算资源来生成它想要的答案,而不是仅仅改善参数。推理就是一种方式,AI在推理时并不是直接推断或单次回答,而是可能分解问题、生成多个想法,评估哪个想法最有效,再一步一步地解决问题。因此,Test-Time Scaling Law(测试时间缩放定律)在实践中已被证明非常有效。从ChatGPT到o1、o3,再到Gemini Pro,所有这些系统都在经历这一过程:从预训练到后训练,再到测试时间缩放。

当然,这需要的计算量是巨大的。我们希望社会能够扩展计算能力,以生成更多、更先进的智能。智能显然是我们最宝贵的财富,可以应用于解决许多挑战性的问题。因此,scaling law正在推动对Nvidia计算能力的巨大需求,它正在推动这种令人难以置信的芯片——Blackwell的巨大需求。

让我们看看Blackwell。Blackwell已经全面生产,外观令人惊叹。首先,现在每个云服务提供商都已部署这些系统。我们有来自大约15家计算机制造商的系统,约200种不同的配置,涵盖液冷、风冷、x86服务器、、NVLink 36 x 2、72 x 1等多种类型系统,以适应全球几乎所有数据中心。当前,这些系统正在全球45个工厂制造。

其核心组件NVLink系统本身重量高达1.5吨,拥有60万个零件,相当于20辆汽车的复杂程度,背后连接了2英里的铜线与5000根电缆。整个制造过程极其复杂,但目标是为了满足对计算需求不断扩大的需求。

Blackwell的制造过程相当疯狂,但所有这一切的目标是,由于scaling law的推动,计算需求如此巨大,以至于Blackwell相对于上一代,提高了每瓦性能4倍,每美元性能提升3倍。基本上,意味着在一代产品的时间里,我们将训练这些模型的成本降低了三分之一。或者说,想要把模型的规模增加三倍,也差不多是相同的成本。

但最重要的是,这些生成的tokens将被我们所有人使用,无论是使用ChatGPT,还是使用Gemini,还是未来使用手机。几乎所有应用都会消耗这些AI tokens,而这些AI tokens正是由这些系统生成的。每个数据中心的限制在于电力。因此,如果Blackwell每瓦性能是上一代的4倍,那么数据中心所能生成的收入和业务也将增加4倍。正如这些AI工厂系统今天正在运作一样。

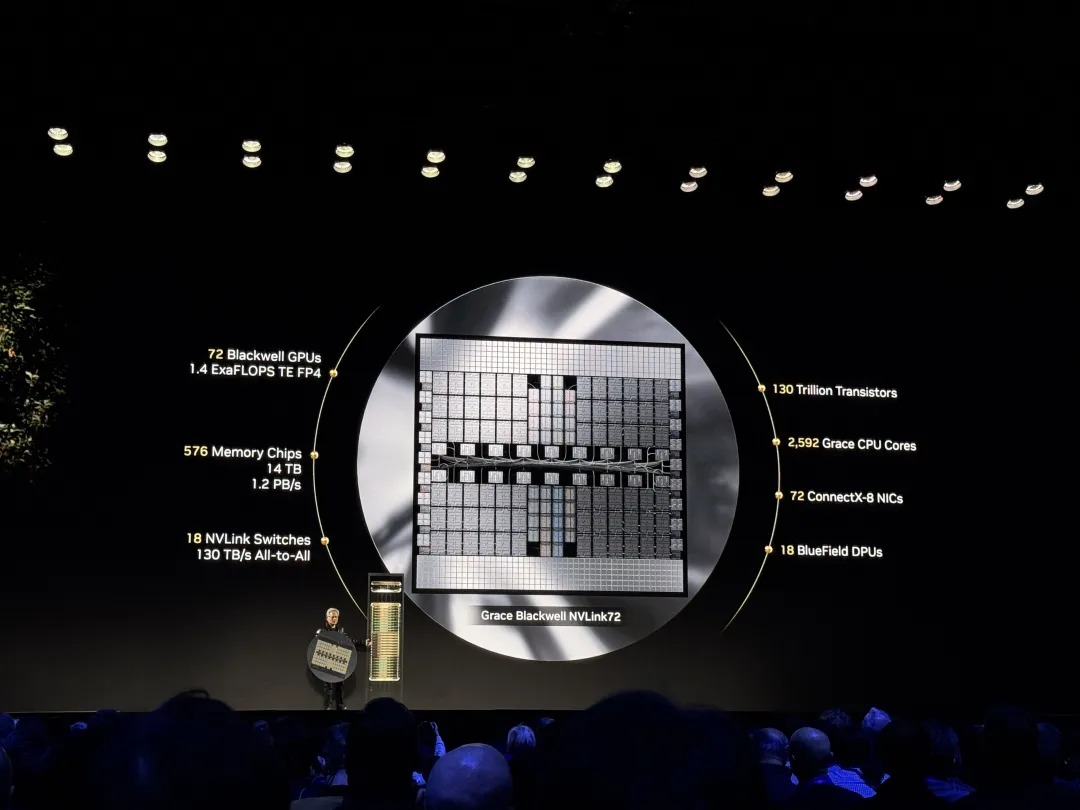

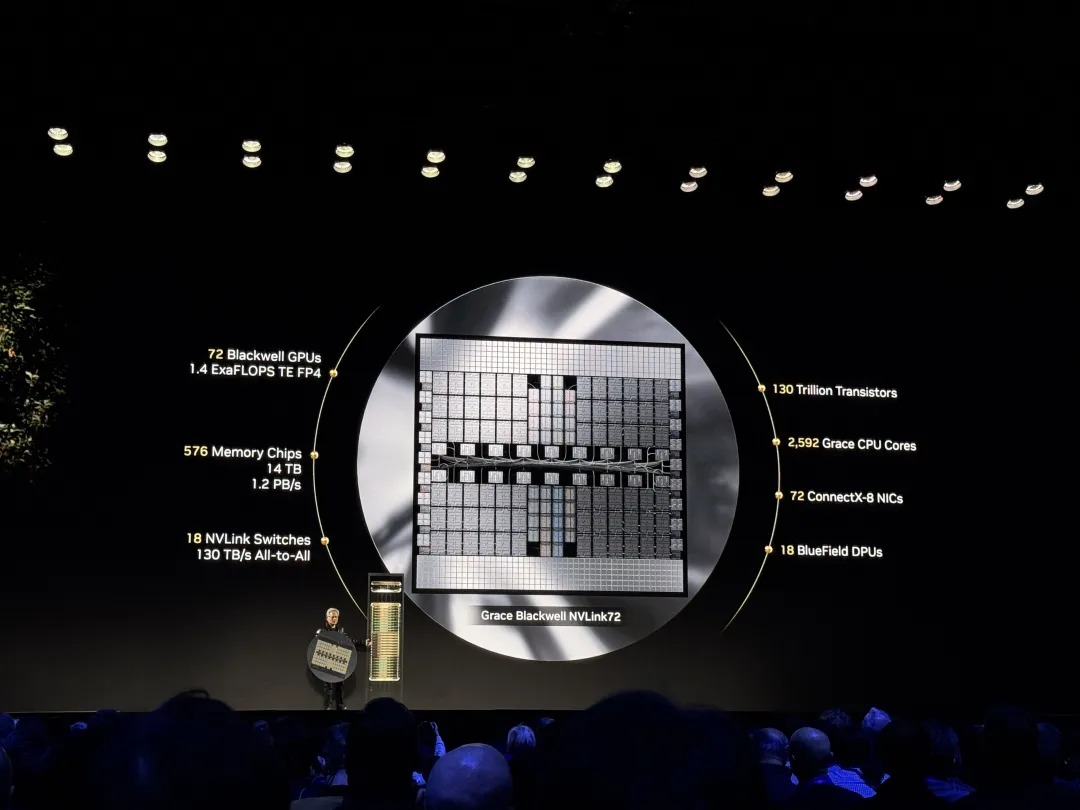

现在,所有目标是为了能够创建一颗巨型芯片GB200 NVLink 72。我们所需要的计算量实在是太惊人了。如果我们必须将其构建为一个芯片,显然这将是晶圆的大小,但这并不包括yield的影响,它可能需要三到四倍的大小。

但我们现在有的是72个Blackwall GPU,共有144个芯片。除此之外,这个系统的AI浮点性能为1.4 ExaFLOPS,内存达到14TB。更惊人的是,内存带宽达到了每秒1.2PB。这基本上相当于现在全世界的互联网流量,所有这些流量都在这些芯片中进行处理。

我们总共有130万亿个晶体管,2592个CPU核心,还有大量的网络连接。接下来这些是Blackwell GPU,这些是我们的connectX网卡,还有NVlink。这里是所有的HBM内存,总共12到14TB的HBM内存。

这就是我们正在尝试做的事情,也是Blackwell系统的奇迹。Blackwell芯片是世界上制造的最大单一芯片。但真正的奇迹不仅仅是这个,还有这个伟大的Blackwell系统。

我们需要极其强大的计算能力,因为我们想训练越来越大的模型。过去这些推理只是单一推理,但未来,AI将会自我对话。它将进行内部反思和处理。

今天每秒生成20到30个tokens就基本上是最快的速度了。然而未来,特别是像GPT-o1、Gemini Pro,它们会与自己对话、反思和思考。因此,tokens的生成速率将会非常高,我们需要大幅提高token生成的速度。同时,我们还需要大幅降低成本,以便服务质量保持卓越,客户的费用能继续保持低廉,而AI也能继续扩展。

英伟达利用AI Agent助力企业工作流自动化,并实现Windows PC端无缝嵌入

我们之所以创建NVlink,其中一个重要的原因是,AI正在成为世界上企业中的一大趋势。代理型AI就是完美的实例,展示了测试时扩展的可能性。

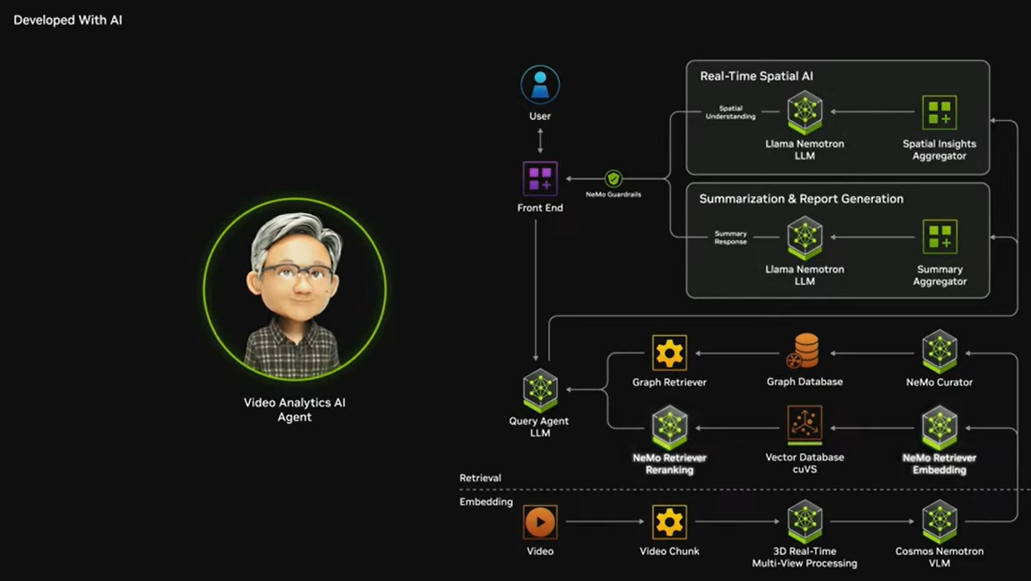

AI是一个由多种模型组成的系统。有些模型用于理解、与客户交互、与用户互动;有些模型可能用于从存储中检索信息。语义AI系统(例如RAG)可能会到互联网检索信息,或者研究PDF文件,使用各种工具、计算器或生成式AI来生成图表等。它将你给它的问题进行分解,逐步解决,并在这些不同的模型中反复迭代。

为了在未来让AI能更好地响应客户的需求,以前只是问问题,回答就会迅速输出。但未来,问一个问题时,会有一大堆模型在后台同时工作。所以,测试时的计算量会暴涨。我们需要更好、更精准的答案。

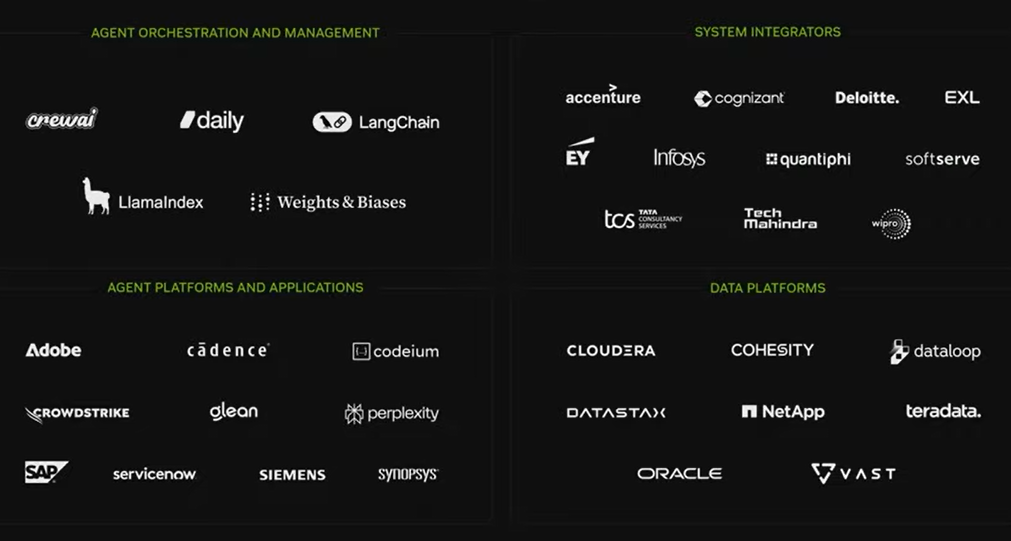

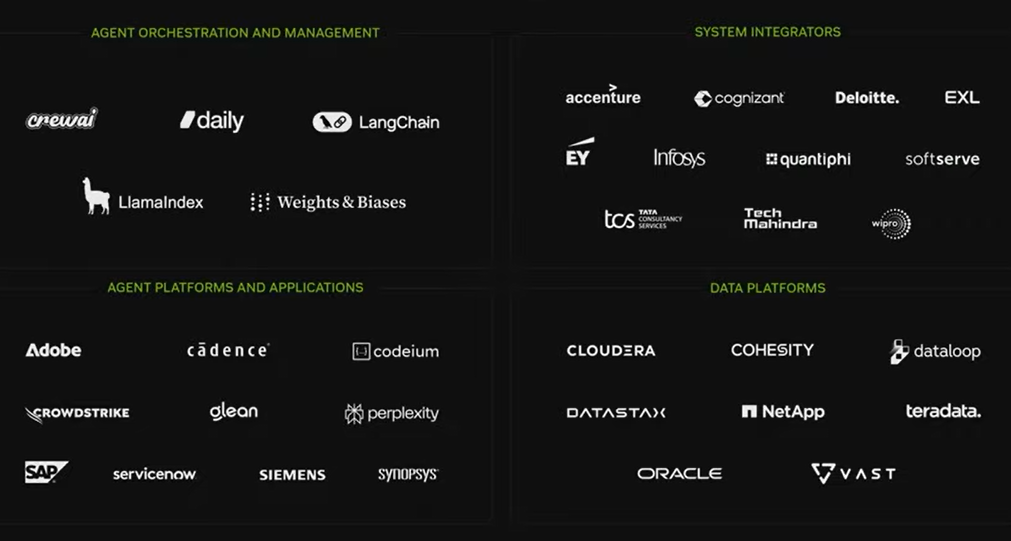

为了帮助行业构建代理型AI,我们的市场推广并非直接面向企业客户,而是与软件开发者及IT生态系统合作,整合我们的技术,开发新的能力。正如我们过去通过Cuda libraries为开发者提供了工具,现在我们也希望通过AI库来做到这一点。

我们为生态系统提供了三项重要工具(AI微服务、英伟达NeMo和加速库),帮助他们构建代理型AI。

Nvidia NIMS即AI微服务,它将所有这些复杂的软件(例如Cuda software、CUDA DNN、Cutlass、Tensor RTLM、Triton等)进行封装和优化,并以容器形式提供。你可以把它们带到任何地方,我们提供了视觉、语言理解、语音、动画、数字生物学等模型,未来还会有更多有关物理AI的激动人心的模型推出。

这些AI模型可以运行在每一个云平台上,因为Nvidia的GPU现在可以在每一个云平台中使用。这些模型能被集成到你的软件包中,创建AI Agent,能够在不同的环境中运行,不论是企业的Cadence,ServiceNow,还是SAP等,都能部署到客户端。

下一个层次是我们所说的Nvidia NeMo,NeMo是一个数字员工的入职培训和评估系统。未来,这些AI Agent将成为数字化劳动力,与你的员工共同工作,代表你完成任务。你将如何将这些Agents引入到你的公司呢?就像你为员工办理入职一样,为这些AI Agent入职。我们为它们提供特定公司语言的训练,可能你的公司有独特的词汇或业务流程,你会给它们提供实际工作样本,让它们尝试生成,你提供反馈,然后进行评估。这整个过程,我们把它称作Nemo。

在某种程度上,未来每个公司的IT部门将变成AI Agent的HR部门。今天,他们管理和维护各种IT软件。未来,他们将负责管理、培养、引导并改善一系列的AI Agent,并将它们提供给公司使用。

我们还为我们的生态系统提供了许多蓝图,大家可以利用这些开源蓝图并根据需要进行修改。我们有许多关于各种类Agent的蓝图。

今天,我们还宣布了一个非常酷的项目。我们发布了一个完整的基于Llama的模型系列,这些模型基于Nvidia的Llama Nemo Tron语言基础模型,Llama 3.1将会成为一个现象级的产品。

Llama 3.1从Meta被下载了大约350,650,000次,它被衍生并转化为其他大约60,000个不同的模型。正是因为这个原因,几乎所有行业中的每个企业都开始投入AI开发。我们所做的事情是,我们意识到Llama模型实际上可以更好地为企业使用进行微调。所以我们利用我们的专业能力对它们进行微调,推出了Llama Nemotron开放模型套件。

这些模型有些非常小,响应速度非常快,几乎是主流模型的超强模型。超强模型可以用作多个其他模型的教师模型,也可以作为奖励模型评估者,为其他模型创建答案并判断答案是否正确,给其他模型反馈。它还可以以多种方式进行提炼,作为教师模型、知识蒸馏模型,非常庞大且有能力。所有这些模型现在都可以在网上使用。这些模型非常强大,在聊天排行榜、指令排行榜和检索排行榜上都名列前茅,涵盖了AI Agent在全球范围内使用的不同功能,这些模型对于你们来说非常重要。

我们还在与生态系统合作。我们所有的Nvidia AI技术都已经集成到IT行业中,我们与ServiceNow、SAP、西门子等工业AI领域的优秀合作伙伴进行紧密合作,Cadence也在做非常出色的工作,Synopsys也有出色的表现;我为与Perplexity合作而感到骄傲,他们彻底颠覆了搜索领域,真的非常了不起。

Codeium将成为全球每一位软件工程师都将使用的AI应用,下一个巨大的AI服务领域就是软件编码。全球有3000万名软件工程师,每个人都会有一个AI助手来帮助他们编程。否则,你的生产力将大打折扣,写出来的代码质量也会更差,所以这是3000万人的市场。而全球有十亿知识工作者,很明显AI Agent可能是下一个机器人产业,很可能会成为一个万亿级的市场机会。让我展示一下我们与合作伙伴共同创建的一些蓝图,以及我们在AI Agent领域所做的工作。

“AI Agent是新的数字劳动力,既为我们工作,也与我们一起工作。AI Agent是一组能够推理的模型,能够将任务拆解,检索数据或使用工具生成高质量的回应。Nvidia 的代理AI构建模块、Nim pre-trained模型和Nemo框架使组织能够轻松开发AI Agent并将其部署到任何地方。我们将以员工培训的方式为我们的代理劳动力进行培训,传授公司的工作方法。AI Agent是特定领域的任务专家。”

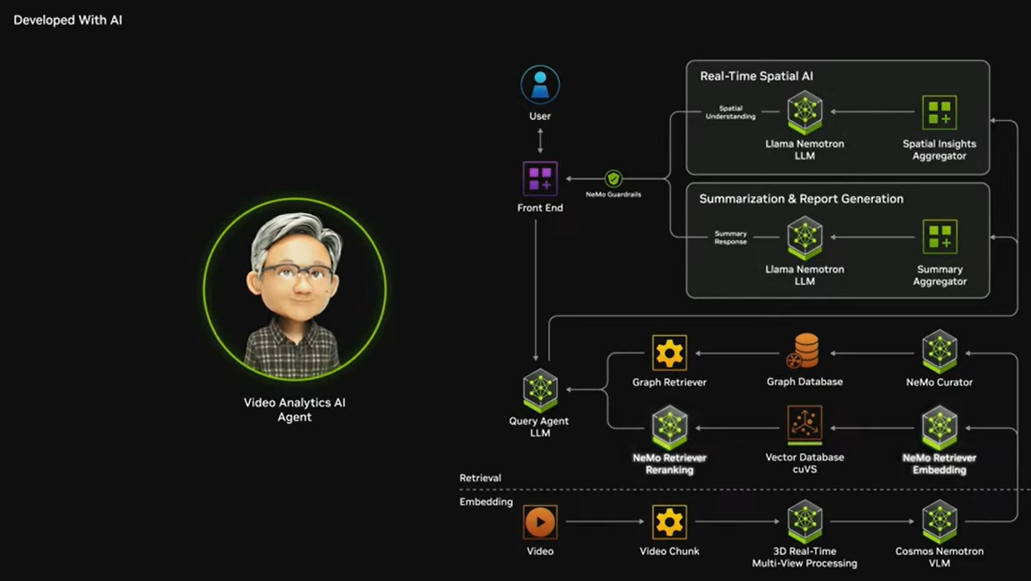

“让我们来看四个例子:为亿万知识工作者和学生提供的AI研究助手Agent,能够摄取像讲座、期刊、财务报告等文档,并通过结合单位回归模型和扩散模型生成互动播客,便于学习;Nvidia开发者的AI软件安全Agent,能够持续扫描软件漏洞,提醒开发人员需要采取的行动;虚拟实验室AI Agent帮助研究人员设计并筛选数十亿种化合物,帮助更快地找到有潜力的药物候选物;基于Nvidia Metropolis蓝图构建的视频分析AI Agent,能够分析来自数十亿摄像头的内容,每天生成10万PB的视频数据,支持互动搜索、总结和自动报告,帮助监控交通流量、标记拥堵或危险。在工业设施中,它们能够监控流程并生成改进建议。”

“AI Agent的时代已经到来,适用于每个组织。”

AI最初是在云端创建的,为云端而生,同时也非常适合在手机上使用。很快我们将拥有一个持续存在的AI,随时伴随在你身边。当你使用Meta眼镜时,你可以指向某个物体,看向某个东西,并询问任何你想要的信息。

然而,我们更希望能够将AI带到各个地方。我已经提到过,你可以将Nvidia的AI带到任何云端,但你也可以把它放在公司内部。但最重要的是,我们希望将它放在个人电脑上。正如你们所知,Windows 95革新了计算机行业,并使得多媒体服务成为可能,它改变了应用程序的开发方式。

Windows 95这种计算模式,当然不完全适合 AI。因此,我们希望未来能够让AI成为你的助手,而不仅仅是3D API、声音API 和视频API,你将能够有生成式API、生成式3D API、生成式语言API和生成式声音API等。我们需要一个能够实现这一目标的系统,同时还能利用云端巨大的投资。

我们不可能再创造出一种全新的 AI 模型编程方式,这种事情是不可能发生的。所以如果我们能够让Windows PC成为世界级的AI计算平台,那将是非常了不起的。事实证明,答案就在Windows上,那就是Windows WSL 2。Windows WSL 2实际上就是将两个操作系统合为一体,它完美适用于开发人员,并且让你能够访问底层硬件。

WSL 2已经过优化,非常适合云原生应用,并且它非常重要的是已经为CUDA进行了优化。因此,所有我向你们展示的Nvidia Nims、Nvidia Nemo以及我们开发的蓝图,只要计算机能支持这些模型,不管是视觉模型、语言模型、语音模型,甚至是动画数字人模型,所有这些模型都会完美适配你的PC,并且你下载后它就能运行。所以,我们的重点是将 Windows PC转变为一个一流的平台,我们将全力支持并维护这个平台,直到永远。因此,这对于全球的工程师和开发人员来说,是一项了不起的成就。让我展示一下我们可以做的事情。

生成式AI从简单的文本提示生成惊人的图像,但使用单一模型来控制图像的组成可能会面临挑战。通过Nvidia Nim微服务,创作者可以使用简单的3D对象来引导AI图像生成。让我们看看一位概念艺术家如何使用这项技术来开发场景的外观。他们开始时会布置手工制作或通过AI生成的3D资产,然后使用图像生成Nim(如Flux)来创建符合3D场景的视觉效果。添加或移动物体来完善构图,改变相机角度来构建完美的画面,或用新的提示来重新构想整个场景。在生成式AI和Nvidia Nim的帮助下,艺术家能够迅速实现他们的愿景。

Nvidia AI将适配全球数亿台Windows电脑,所以我们能够为这些电脑准备好AI环境。所有我们合作的PC OEM都将为这一技术栈做好准备,AI PC即将进入你身边。

发布世界基础模型Nvidia Cosmos,目前在仓储物流和自动驾驶领域得到广泛合作

接下来我们来谈谈物理AI。想象一下,你的LLM接收左边的上下文、提示信息,然后逐个生成 token,最终输出结果,这就是它现在的工作原理。这个中间的模型非常庞大,拥有数十亿个参数。它的上下文长度也非常大,因为你可能决定加载一个PDF。在我的例子中,我可能会在问问题之前加载几个PDF。这些PDF会被转化为tokens。

Transformer的基本注意力机制是每一个token都要找出它与其他token之间的关系和相关性。所以你可以有数十万个token,而计算负担会呈平方增长。它处理这些输入序列中的所有参数,通过每一层的Transformer,最后输出一个token。这也是为什么我们需要一个黑墙,然后下一个token会被生成。当当前的token处理完毕后,它会将当前token放入输入序列中,然后把整个序列输入到模型中生成下一个token。这个过程是一步步进行的,这就是Transformer模型。这也是为什么它在计算上非常有效,但同时也非常需要计算资源的原因。

那么如果不是PDF,而是你的周围环境呢?如果不是提示一个问题,而是给出一个请求呢?比如“走过去,把那个箱子拿过来。”如果生成的不是文本,而是动作tokens呢?

我刚才描述的,实际上是机器人技术的未来是非常合理的,而这项技术也已经触手可及。但我们需要做的,是创造一个有效的世界模型,而不是像GPT那样的语言模型。这个世界模型需要理解世界的语言,需要理解物理动态,比如重力、摩擦、惯性等。它需要理解几何和空间关系,需要理解因果关系。如果你把东西掉到地上,它会落地;如果你戳它,它会倾斜。它还需要理解物体的持久性。如果你把球从厨房柜台滚过去,当球从另一边掉下去,它并不会进入另一个量子宇宙,而是依然存在。

所有这些类型的直觉理解,今天大多数模型都非常难以处理。因此,我们想要创造一个世界模型。我们需要一个世界基础模型。今天,我们要宣布一件非常重要的事情——我们要宣布Nvidia Cosmos,这是一个世界基础模型,旨在理解物理世界。要真正理解这一点,你得亲眼看一看,让我们展示一下。

“AI的下一个前沿是物理世界。AI模型的性能与数据的可用性直接相关,但物理世界的数据采集、整理和标注是非常昂贵的。Nvidia Cosmos是一个世界基础模型开发平台,旨在推动物理AI的发展。它包括自回归世界基础模型、基于扩散的世界基础模型、先进的tokenizer以及一个Nvidia CUDA加速的数据管道。Cosmos模型能够吸收图像或视频流,并生成虚拟世界状态的视频。Cosmos的生成优先考虑AV和机器人应用的独特需求,比如真实世界环境、照明和物体持久性。开发者使用Nvidia Omniverse来构建基于物理的地理精确场景,然后将Omniverse的渲染输出到Cosmos,后者生成真实感的物理合成数据。”

“无论是多样的物体还是环境,像天气、时间、或边缘情况等条件,开发者都可以利用Cosmos生成世界,用于强化学习AI反馈来改进策略模型,或测试和验证模型的性能,甚至跨多传感器视角。Cosmos能够实时生成tokens,带来前所未有的多重宇宙模拟能力,生成每一种可能的未来,帮助模型选择正确的路径。通过与全球开发者生态系统的合作,Nvidia正在帮助推动下一波物理AI的进展。”

Nvidia Cosmos,世界上第一个世界基础模型,它经过了2000万小时的视频训练。这2000万小时的视频重点关注物理、动态的事物,比如自然景象、人物走动、手部运动、操控物体,以及快速的相机移动。它真正的目的是教AI理解物理世界,而不是生成创意内容。从这个物理AI出发,未来我们可以做很多下游的工作。

我们可以做合成数据生成,用来训练模型。我们可以将其提炼成一个机器人模型的雏形。它可以生成多个物理上合理的未来场景,基本上可以像奇异博士一样操作。因为这个模型理解物理世界。当然,你看到的这些图像,正是这个模型在理解物理世界的表现。它当然也能进行视频标注,可以将视频进行精确标注,这些标注和视频可以用于训练大型语言模型、跨模态语言模型。所以,你可以利用这个技术,利用这个基础模型来训练机器人以及大型语言模型。这就是Nvidia Cosmos。

该平台拥有自回归模型用于实时应用,扩散模型用于高质量图像生成。它是一个了不起的tokenizer,基本上是在学习现实世界的词汇,并且拥有一个数据管道,允许你在自己的数据上进行训练。因为涉及的数据量非常大,我们已经为你加速了整个端到端的处理过程。所以这是世界上第一个使用CUDA加速的AI数据处理管道,所有这些都包含在Cosmos平台中。

今天我们宣布Cosmos是开放许可的,已经在GitHub上开放,有小型、中型、大型快速模型、主流模型、以及教师模型。我们希望Cosmos能为机器人和工业 AI 领域带来像Llama 3对企业 AI 那样的推动效果。

Omniverse是基于物理的,不是物理存在的,而是物理基础的。它是一个算法物理、原则物理的模拟系统。当你将它与Cosmos连接时,它为生成提供了基础,控制和调节了Cosmos的生成。所以Cosmos生成的内容是基于真实的。这就像将大型语言模型与RAG(检索增强生成)系统连接一样,你想让AI生成的内容基于真实的基础。因此,两者结合后,你将得到一个基于物理模拟的多重宇宙生成器,其应用和用例非常令人兴奋。

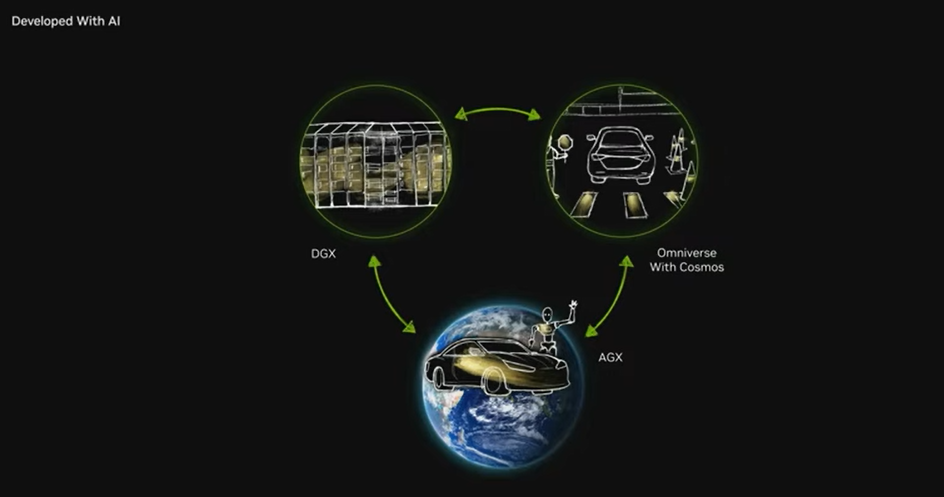

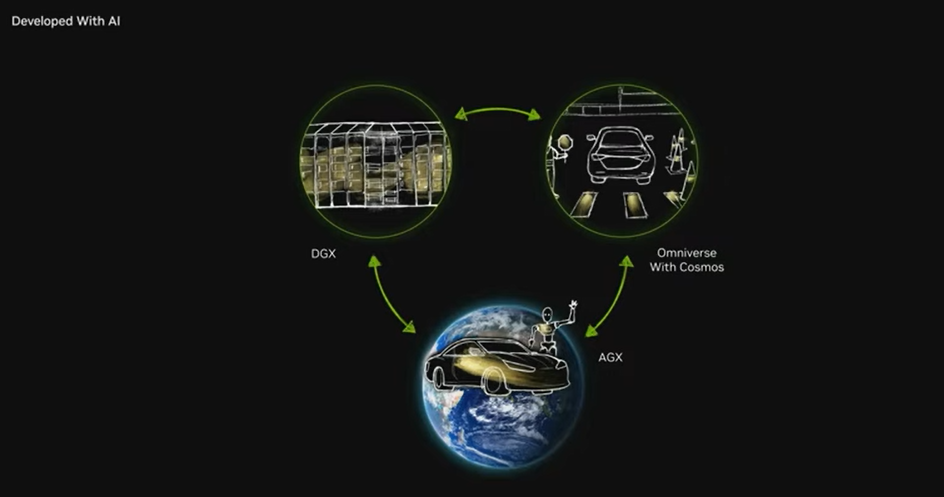

当然,对于机器人技术尤其是在工业应用中,Omniverse加上Cosmos代表了构建机器人系统所需的第三台计算机。每个机器人公司最终都必须建立三维计算机。机器人系统可以是一个工厂,可以是汽车,也可以是机器人。

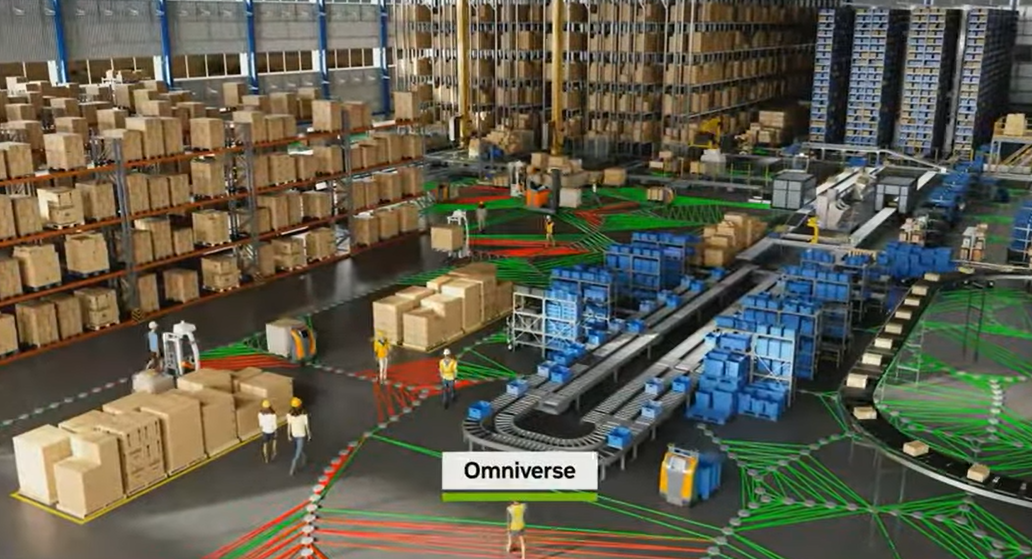

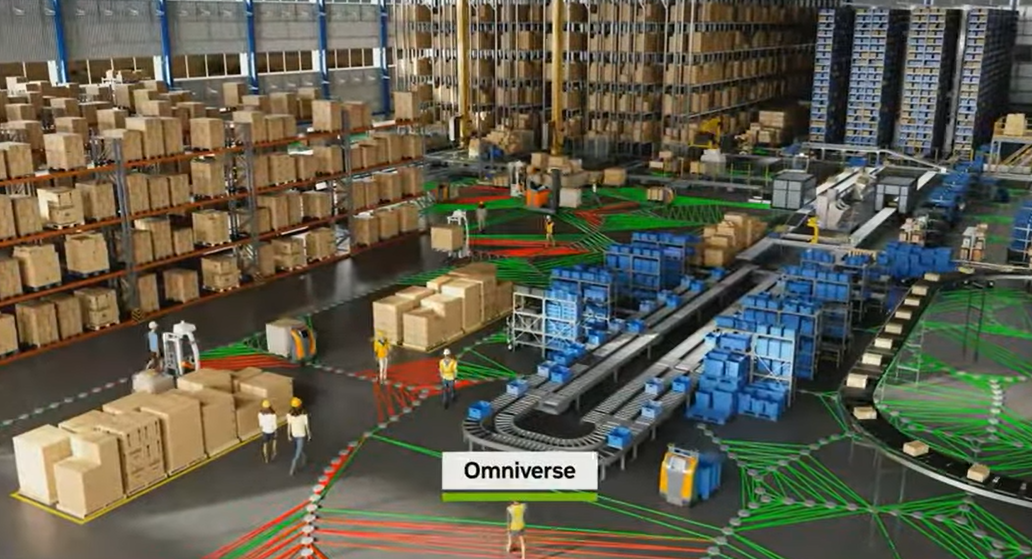

让我给你们举三个例子。第一个例子是我们如何将这一切应用到工业数字化中。全球有数百万个工厂,成千上万的仓库,它们是价值50万亿美元制造业的支柱。

这是我们与Keon和Accenture合作的一个例子。Keon是供应链解决方案公司,Accenture是全球领先的专业服务公司,Nvidia与他们合作,共同将物理AI引入到1万亿美元仓储和配送中心市场。

管理高效的仓储物流需要在复杂的决策网络中导航,这些决策受到日常和季节性需求变化、空间约束、劳动力可用性以及各种机器人和自动化系统集成的影响。预测物理仓库的操作KPI在今天难度很大,为了应对这些挑战,Keon正在采用Mega——一个Nvidia Omniverse蓝图,用于构建工业数字孪生,以测试和优化机器人车队。

首先,Keon的仓库管理解决方案将任务分配给数字孪生中的工业AI大脑,例如将负载从缓冲位置移动到穿梭存储解决方案。机器人的“大脑”位于Omniverse中的物理仓库仿真中,利用开放的USD连接器将CAD、视频、图像、3D激光雷达、点云和AI生成数据聚合到一起。机器人车队通过感知和推理他们的Omniverse数字孪生环境、规划下一步动作并付诸实践,机器人“大脑”能够通过传感器仿真看到结果状态,并决定下一步行动。这个循环继续进行,而Mega则精确追踪数字孪生中一切的状态。现在,Keon可以在部署到实际仓库之前,大规模模拟无限的场景,同时衡量运营KPI,如吞吐量、效率和利用率。

与Keon和Accenture共同合作的过程中,Nvidia正在重新定义工业自主性。未来每个工厂都会有一个数字孪生。这个数字孪生的运作就像真实工厂一样。AI会决定哪个场景对某个KPI来说是最优的,这就成为了编程约束,编程AI将被部署到真实的工厂中。

下一个例子是自动驾驶汽车,经过多年的发展,Waymo和Tesla的成功表明,自动驾驶革命终于到来了。我们为这个行业提供的方案就是三台计算机:用于训练AI的训练系统、仿真系统、合成数据生成系统——Omniverse,现在还加上Cosmos,以及车内的计算机。全球几乎每家主要汽车公司都以不同方式与我们合作,用上这三类计算机里的一个、两个或三个,像Waymo、Zoox、特斯拉,还有比亚迪——全球最大的新能源汽车公司,捷豹路虎有超酷新车,奔驰今年开始量产一批搭载英伟达技术的车。

还有很多其他公司,比如Lucid、Rivian、小米,当然还有沃尔沃。Wabi正在构建自我感知卡车,我们本周宣布Aurora将使用Nvidia来构建自动驾驶卡车。每年全球生产100万辆自动驾驶汽车,每年全球行驶一万亿英里,所有这些将会是高度自主或完全自主的,这将成为一个非常庞大的行业。我预测这将可能是第一个万亿级的机器人行业,尤其是在这些刚开始投入世界市场的汽车中,我们的业务已经达到了40亿美元,今年可能会达到50亿美元。这对于我们而言已经是一个非常重大的业务了,未来将会变得更加庞大。

今天,我们宣布下一代汽车处理器,我们为汽车提供的下一代计算机叫做Thor。这是一个机器人计算机,它接收传感器信息,并处理大量的传感器数据。各种摄像头、高分辨率雷达、激光雷达的数据都通过这个芯片输入。这个芯片必须处理这些传感器数据,将其转化为tokens,放入transformer中,预测下一步路径。这个自动驾驶计算机现在已经全面进入生产。

Thor是我们上一代产品Orin的20倍处理能力,Orin如今是自动驾驶汽车的行业标准。因此,这真的非常令人惊叹。Thor目前已经全面投入生产,不仅用于汽车,也能用在完整机器人里,比如 AMR(自主移动机器人),或是人形机器人,充当它们的大脑、操控器,是通用机器人计算机。

我们驱动系统的第二个部分,我非常自豪地宣布,现在是首个经过认证的、软件定义的可编程AI计算机,已经达到ASIL-D(汽车功能安全标准的最高级别)认证。这是唯一的,也是最高的标准。因此,作为功能安全计算机,CUDA也适用于构建机器人。如果你在构建机器人,Nvidia可以提供帮助。

接下来我会展示我们如何在自动驾驶汽车的背景下使用Omniverse和Cosmos。

“自动驾驶车辆革命已经到来。像所有机器人一样,构建自动驾驶车辆需要三台计算机:Nvidia DGX用于训练AI模型,Omniverse用于测试驾驶和生成合成数据,Drive AGX是车载超级计算机。”

“构建安全的自动驾驶车辆意味着要解决边缘场景问题,但现实世界的数据有限,因此合成数据对训练至关重要。由Nvidia Omniverse AI模型驱动的自动驾驶数据工厂,通过Cosmos生成合成驾驶场景,从而大幅增强训练数据。首先,Omni Map融合了地图和地理空间数据,构建可行驶的3D环境。可以从重播驾驶日志或AI交通生成器生成驾驶场景的变化。接着,神经重建引擎使用自动驾驶车辆的传感器日志,创建高保真度的4D仿真环境。它重播以前的驾驶过程并生成场景变化,以放大训练数据。最后,Edify用三毫秒即可自动搜索现有资产库或生成新的资产,以创建适合仿真的种子。”

“Omniverse场景用于调整Cosmos,生成大量照片级真实感的数据,缩小仿真与现实之间的差距,并通过文本提示生成几乎无限的驾驶场景变化。通过Cosmos Neotron视频搜索,将大规模的合成数据集与记录的驾驶数据结合,能够进行模型训练。Nvidia的AI数据工厂将数百次驾驶数据扩展为数十亿有效英里,为安全和先进的自动驾驶设定了标准。”

这是不是太不可思议了?把成千上万次驾驶转化为数十亿英里。我们将拥有大量的自动驾驶训练数据。当然,我们仍然需要实际的汽车在路上行驶。我们将持续收集数据,直到永远。然而,使用这个多元宇宙物理基础的合成数据生成能力,我们可以生成训练AI的数据,这些数据是物理上有依据、准确且合理的,这样我们就能拥有海量数据进行训练。

自动驾驶行业已经到来。这是一个令人兴奋的时代。我认为,正如计算机图形学革命化的速度令人难以置信,未来几年你将看到自动驾驶的发展速度大幅提升。

通用机器人的ChatGPT时刻即将到来,由Nvidia Isaac Groot提供动力

我想,接下来是机器人技术。普通机器人技术的突破即将到来。

为什么普通机器人如此重要呢?因为使用履带和车轮的机器人需要特别的环境来适应它们,而世界上有三种机器人我们可以制造,它们不需要绿色田地,能够适应已有的环境。我们可以将这些令人惊叹的机器人部署到我们为自己创造的世界中。这三种机器人是:第一,代理机器人和AI Agent,因为它们是信息工作者,只要能够适应我们办公室的计算机,就能很好地工作;第二,自主驾驶汽车,因为我们花了100多年的时间修建道路和城市;第三,人形机器人。如果我们能够解决这三者的技术问题,将会成为世界历史上最大的科技产业。因此,我们认为机器人时代即将来临。

关键能力在于如何训练这些机器人。在人形机器人方面,模仿信息的收集相当困难,原因在于,对于一辆汽车你只需要驾驶;而对于这些人形机器人,模仿信息和人类示范的收集则相当繁琐。因此,我们需要想出一个聪明的方法,将数百次、数千次人类示范数据,通过AI和Omniverse合成生成数百万次合成动作。通过这些动作,AI 就能学习如何执行任务。让我来展示一下如何做到这一点。

全球开发者正在构建下一代物理AI,具备实体的机器人——人形机器人。开发通用机器人模型需要大量的现实世界数据,而这些数据的捕获和整理成本极高。Nvidia Isaac Groot帮助解决这些挑战,为人形机器人开发者提供四项服务:机器人基础模型、数据管道、仿真框架和机器人计算机。

Nvidia Isaac Groot合成运动生成蓝图是一种用于模仿学习的仿真工作流,能够帮助开发者从少量人类示范中生成指数级的数据集。

首先,Groot teleop使熟练的人工操作员通过Apple Vision Pro门户进入机器人的数字孪生空间。这意味着操作员即使是在没有物理机器人的条件下也能捕获数据,并在无风险的环境中操作机器人,消除物理损坏或磨损的可能性。为了教机器人完成一个任务,操作员通过少数几次远程操作示范捕获运动轨迹,然后使用Groot Mimic将这些轨迹扩展成一个更大的数据集。

接着,他们使用基于Omniverse和Cosmos的Gro Gen来进行领域随机化和 3D 到现实的放大,生成一个更大的数据集。Omniverse和Cosmos多元宇宙仿真引擎提供了大规模的数据集来训练机器人策略。一旦策略训练完成,开发者可以在Isaac Sim中进行软件环测试和验证,然后部署到真实的机器人上。

通用机器人时代正在到来,由Nvidia Isaac Groot提供动力。我们将拥有大量的数据来训练机器人。Nvidia Isaac Groot是我们为机器人产业提供技术平台,推动通用机器人发展的平台技术元素。

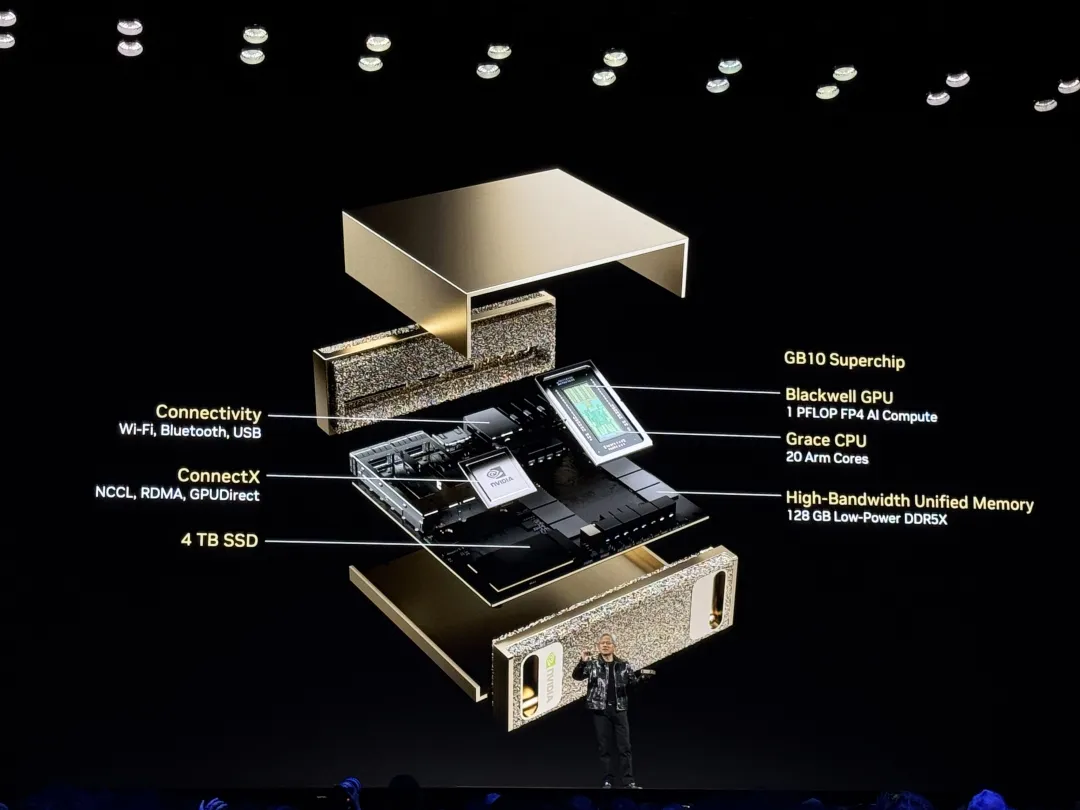

发布全球最小的个人AI超级计算机Project DIGITS

还有,我想给大家展示的最后一件事。如果没有十年前我们开始的这个令人难以置信的项目,一切都不可能实现。这个项目在公司内部被称为“Project DIGITS深度学习GPU智能训练系统”。

在我们推出之前,我缩小了DGX,并将其与RTX、AGX、OVC以及我们公司所有的X系列产品进行统一和整合。实际上,DGX 1彻底革命了AI。我们之所以构建它,是因为我们想让研究人员和初创公司能够拥有一个开箱即用的AI超级计算机。我于2016年将第一台DGX 1交付给了一家名为OpenAI的初创公司,Elon和Ilya Sutskever以及许多Nvidia工程师都在场,我们共同庆祝了DGX 1的到来,并且它显著地推动了AI和计算领域的革命。

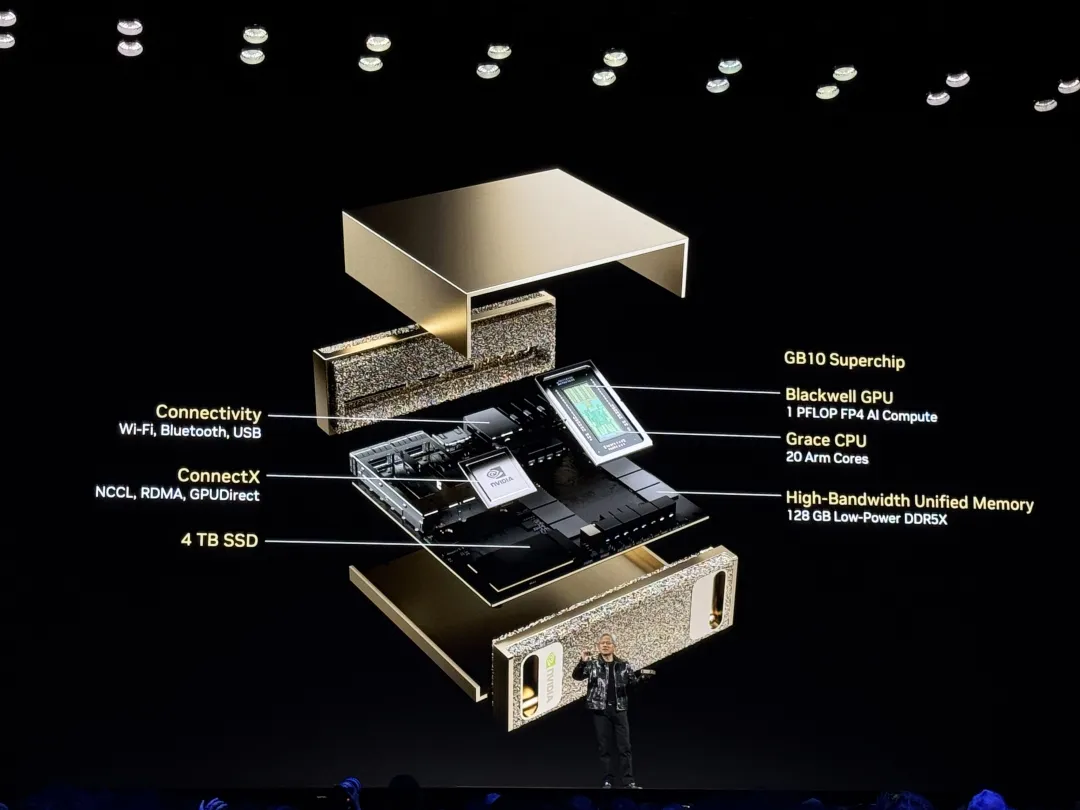

这是Nvidia最新的AI超级计算机,现在它被称为Project DIGITS。如果你有一个好名字,请联系我们。神奇的是,这是一台AI超级计算机,它可以运行Nvidia的整个AI技术栈,所有的Nvidia软件都可以在这台机器上运行,DGX cloud也运行在上面,它是无线连接的,你可以将其连接到你的计算机,它甚至可以作为工作站使用。如果你喜欢的话,你可以将它用作Linux工作站,而且你可以像云超级计算机一样访问它,Nvidia的AI软件也在其上运行,它基于我们与MediaTek合作开发的秘密芯片GB 110,这款是我们做的最小的Grace Blackwell。

Grace Blackwell已经投产了。这款高度机密的芯片由我们和全球领先的片上系统(SOC)公司Mediate合作打造,把CPU和英伟达的GPU通过芯片到芯片的Mv link连接起来。我们预计这款计算机会在大约五月份上市,很令人期待。

谁不想要一个这样的东西呢?无论是PC、Mac都可以使用,因为它是一个云平台,一个可以放在你桌面上的云计算平台,你也可以把它当作Linux工作站来使用。如果你希望拥有双位数的计算能力,你可以连接上ConnectX,它配备了GPU,所有的功能都能开箱即用,简直就像一台超级计算机。我们的整个超级计算堆栈都可以使用。这就是Nvidia的Project DIGITS。

最后让我再重复一遍,我们现在不仅有Grace Blackwell超级计算机、NVlink 72在全球范围内投入生产,还有三款新的Blackwell系统投入生产:一款是惊人的AI基础世界模型,这是全球首个物理AI基础模型,现已开放,可激活全球机器人等行业;还有关于Agentic AI、类人机器人和自动驾驶汽车的三款机器人。

这是收获满满的一年,感谢大家的合作,谢谢大家的到来。

原视频:CES 2025 Keynote with NVIDIA Founder and CEO, Jensen Huang

https://www.youtube.com/watch?v=K4qQtPpSn-k

编译:Faye Yu

(文:Z Potentials)