人工智能已经悄然走进了我们的生活,而其中一个常见的现象——AI幻觉,却让不少用户感到迷惑不解。

今天,我们就来揭开这个谜团,探讨DeepSeek以及大模型的“幻觉”问题,如何识别、应对,甚至发掘它的创造力价值。

AI幻觉,顾名思义,是指人工智能生成的内容看似合理,甚至非常有说服力,但实际却包含错误或虚假的信息。这种现象在自然语言生成模型中尤为突出。

AI通过大量数据的训练来预测下一步的最佳内容,但在某些情况下,它生成的内容完全是虚构的,或者缺乏与现实的关联。

这种问题的根源在于模型并不具备“理解”能力,它的“思维”只依赖于庞大的数据和算法,通过猜测最有可能的结果来生成答案。所以,尽管AI生成的内容可能听起来非常流畅和专业,但它却可能在事实、逻辑上完全失真。

作为国产大模型中的佼佼者,DeepSeek的表现堪称亮眼,但它也难逃AI幻觉的困扰。那为什么DeepSeek也会产生幻觉呢?

首先,DeepSeek使用了先进的MOE(Mixture of Experts)模型架构,能够处理更复杂的任务,生成更精确的内容。

但即便如此,MOE模型依旧是通过训练数据来“推测”最可能的输出,并非基于对事实的“理解”。这导致它在某些情况下会生成没有真实依据的内容,造成“幻觉”。

其次,DeepSeek的训练数据来自大量的文本资源,其中一些内容可能并不完全准确或已过时。当模型从这些数据中学习并生成答案时,它可能会将这些不准确的信息“当作事实”,从而产生错误的输出。

如何减缓AI幻觉?

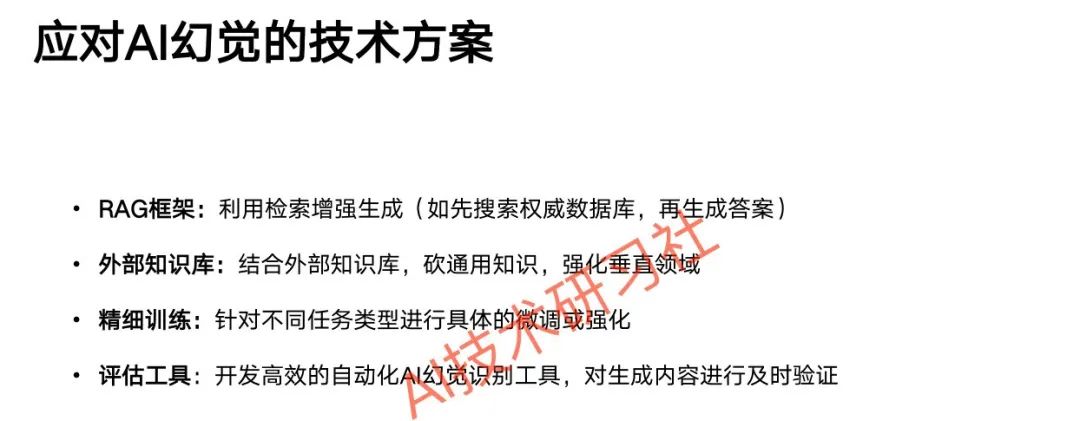

技术方案:

RAG技术:结合外部知识库(如医疗、法律数据库),确保回答基于可靠资料 。

双AI验证:通过多模型协作(如DeepSeek R1分析 + 通义千问纠错)交叉验证答案。

提示词工程:限定知识边界(如“仅基于2023年前数据回答”)、要求标注推测内容。

用户策略:

分步提问:限制单次生成内容长度,降低长文本中的错误累积。

三角验证:比对多个AI回答或权威来源(如学术论文、官方数据)。

警惕“过度合理”回答:对细节详实但缺乏来源的信息保持怀疑。

AI幻觉既是技术挑战,也是创新契机。通过优化模型架构与使用策略,可减少其负面影响;同时,合理利用其“想象力”,能在科学、艺术等领域开辟新可能。

科学发现:AI的“错误”可能启发新思路。例如,AI蛋白质错误折叠启发了新型结构设计,助力诺贝尔化学奖成果 。

文艺与设计:作为“超现实引擎”,突破人类思维定式。例如,生成虚拟角色、诗歌或游戏剧情,增强沉浸感 。

技术创新:将幻觉转化为方法论。例如,AI图像分割的“超现实边界”提升了自动驾驶在极端天气下的识别精度 。

娱乐与创意:生成天马行空的故事、对话,成为作家和艺术家的灵感来源 。

你在使用AI时是否遇到过幻觉现象?欢迎在评论区分享你的经验!

在面对AI幻觉时,我们需要找到一个平衡点:既要警惕不准确的内容,也要拥抱它所带来的创造力和灵感。你是如何看待这个问题的呢?快来一起讨论吧!

(文:AI技术研习社)