大家好!今天我们来聊一个关于AI的超级有趣话题——大模型蒸馏(Model Distillation)。

如果你听到“大模型”就联想到庞大、复杂、需要巨型计算资源,那你绝对没错!但你知道吗?这些“重型AI”也有一个“瘦身”的秘密武器——模型蒸馏。

这项技术就像是把一个超级重的AI“减肥”成更高效的小模型,但能力丝毫不打折!听起来是不是特别神奇?那就一起来看看吧!

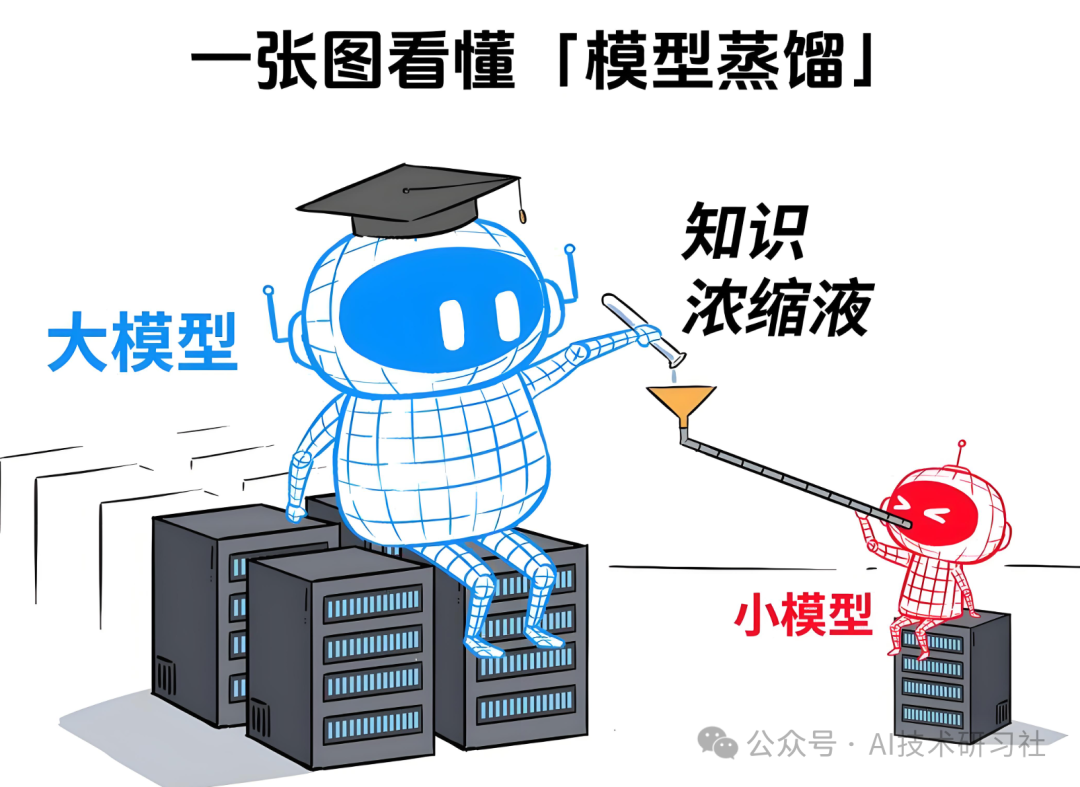

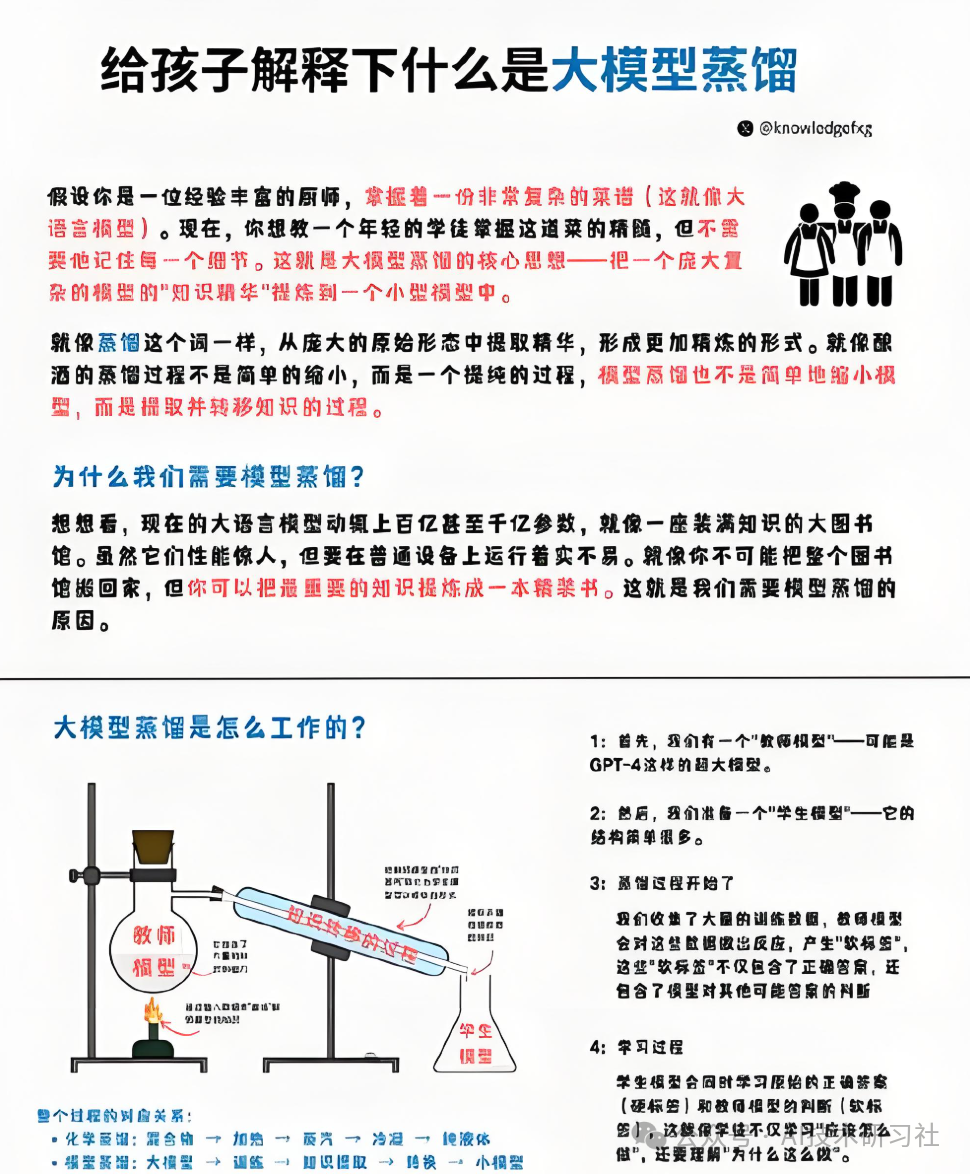

什么是“大模型蒸馏”?

简单来说,大模型蒸馏就像是把一个庞大的、重型的AI模型“瘦身”成一个精悍的小模型,精华依旧,效率大增。

你可以把它想象成把一瓶浓缩的精华倒入一个小瓶子,虽然瓶子变小了,但里面的精华却依然能给你强劲的能量。

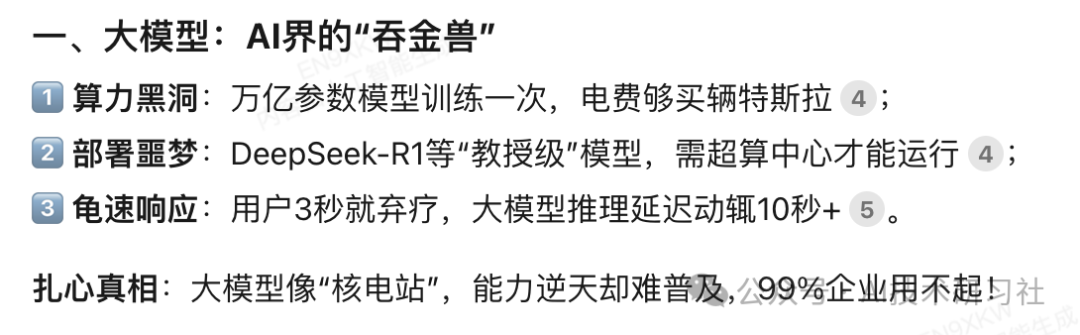

大模型通常是计算能力超强的AI,它能做出非常复杂的预测和判断,比如生成文本、图片或语音。但这些模型的问题也很明显——它们大到几乎“吞噬”了所有的计算资源。

而模型蒸馏的目标,就是把这些巨型AI的精华提取出来,让它们变得更加高效。

为什么要做“大模型蒸馏”?

1. 节省资源

大模型需要庞大的计算资源和存储空间,这就像是一个超能大的超级计算机,普通设备根本跑不动。蒸馏技术能把这些大模型的能力压缩成小巧的模型,不仅节省了计算资源,也让普通设备能够运行强大的AI。

2. 加速推理

大模型的推理速度很慢,尤其是在手机、嵌入式设备这种计算能力有限的设备上,速度会变得相当拖沓。而经过蒸馏后的小模型能够快速响应,极大地提高推理速度,响应更迅速!

3. 适应多平台

小模型不仅节省资源,而且能够广泛部署到更多平台上。例如,手机、智能家居、物联网设备等都能轻松承载这些经过蒸馏的小模型,即使是资源有限的设备也能运行强大的AI功能。

一句话痛点:大模型就像AI界的大象,虽然能力强大,但不适合所有地方使用。模型蒸馏就像是给大象装上了翅膀,它既能飞,又能适应更多环境。

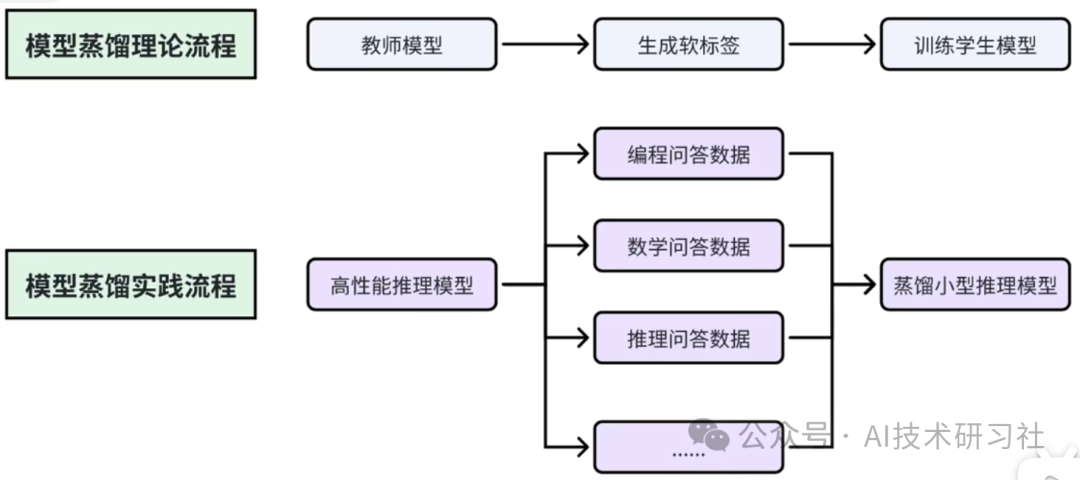

模型蒸馏是如何工作的?

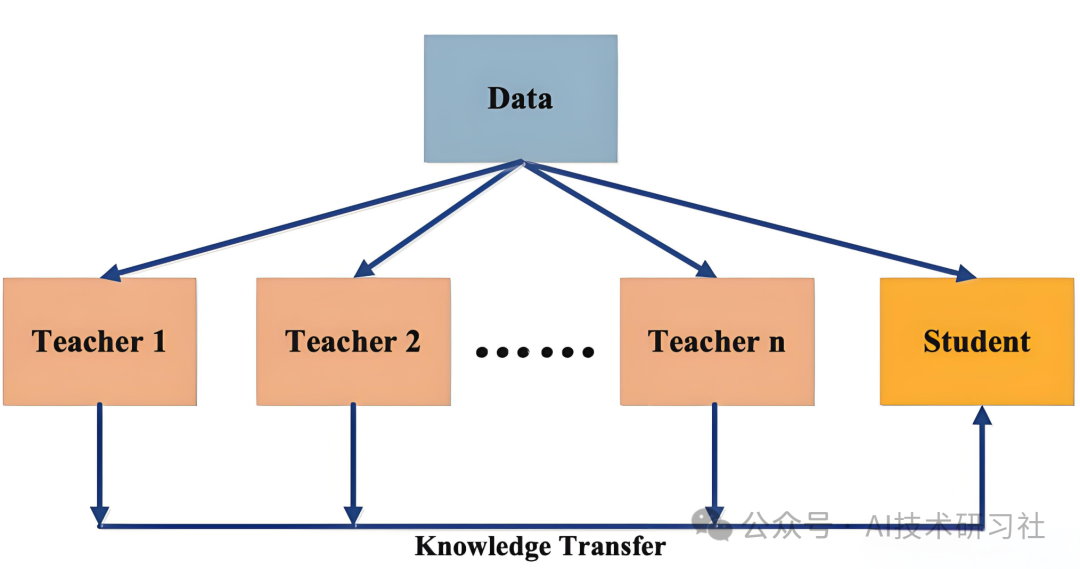

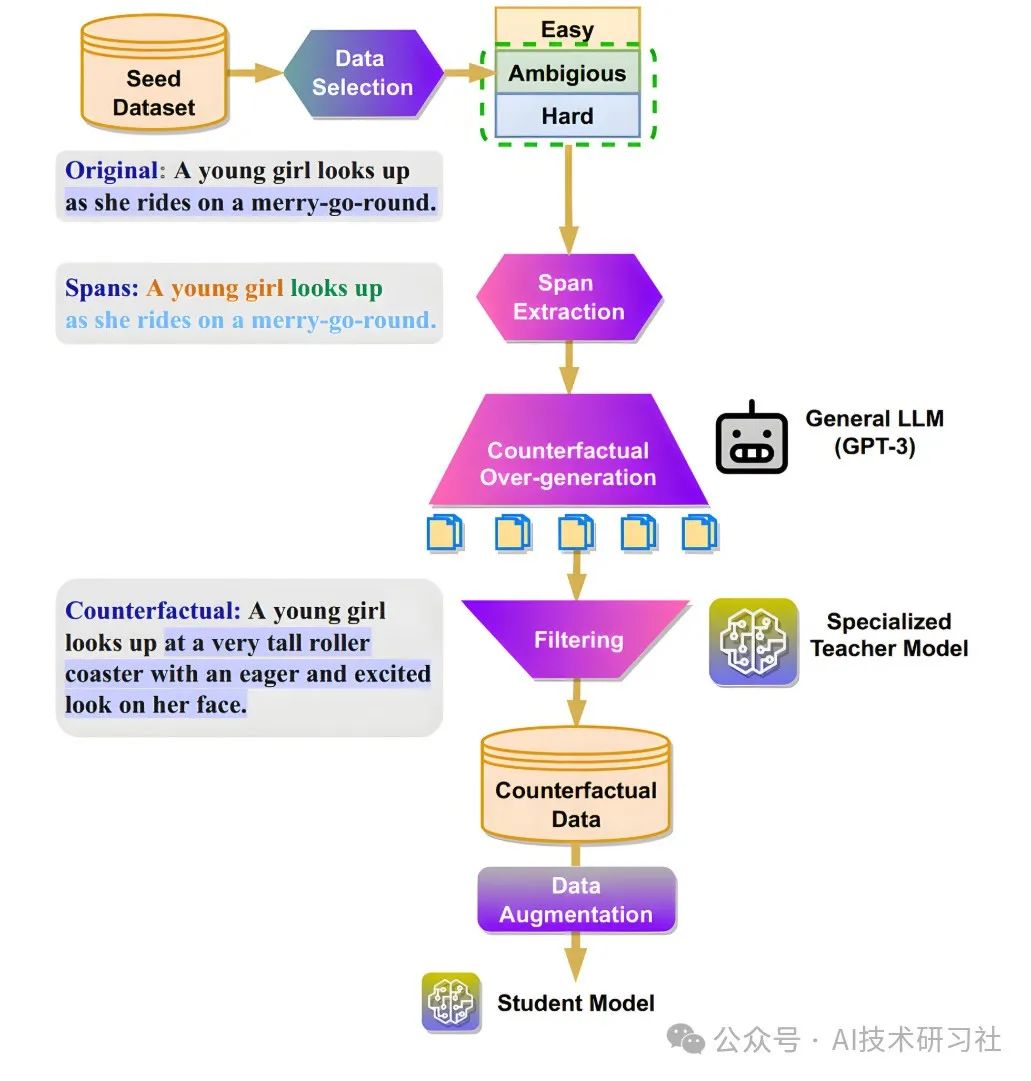

模型蒸馏的核心原理就是“知识转移”,让小模型从大模型这里“偷师学艺”。想象一下,你有一个超级聪明的“教师模型”,它学识渊博,能够做出精准的预测。

接下来,你要做的就是将教师模型的知识“传授”给一个“学生模型”,让学生也能尽可能地表现得像教师一样聪明。

1. 教师模型与学生模型

教师模型是那种超级大、计算资源消耗巨大的模型,它拥有强大的预测能力。学生模型则是相对较小且高效的模型,目标是模仿教师模型的预测能力,但计算资源消耗更少,速度更快。

2. 知识转移

学生模型并不会直接学习正确答案,而是学习教师模型的输出。简单来说,学生模型的输出要尽量接近教师模型的输出,这样学生就能拥有类似的能力,但却不需要那么多计算资源。

3. 软目标与中间层匹配

为了让学生模型更好地“模仿”教师模型,通常会用一些技巧。例如,教师模型的输出会通过温度调节,变得更加平滑,信息更丰富。学生模型通过“软目标”学习这些信息。此外,学生模型还会学习教师模型的中间层特征,复制神经网络的思考路径,这样小模型的逻辑和思维方式会更像大模型。

核心原理:

-

知识萃取:让小模型学习大模型的解题思路(软标签),而不是死记硬背(硬标签)。

-

温度调控:通过调整温度参数,控制知识的浓度,像调节咖啡的苦度一样,确保知识传递平滑、有效。

-

双轨学习:既要模仿大模型的思维(逆向KL散度),又要保证基础正确性(交叉熵损失),确保学习效果。

技术突破:

-

涌现能力迁移:将大模型的一些超能力(如推理链、上下文学习)迁移到小模型中,让它依然强大。

-

特征层蒸馏:不仅要学会最终答案,还要让学生模型理解神经网络的内部逻辑,这样它的“思维”方式与大模型更加接近。

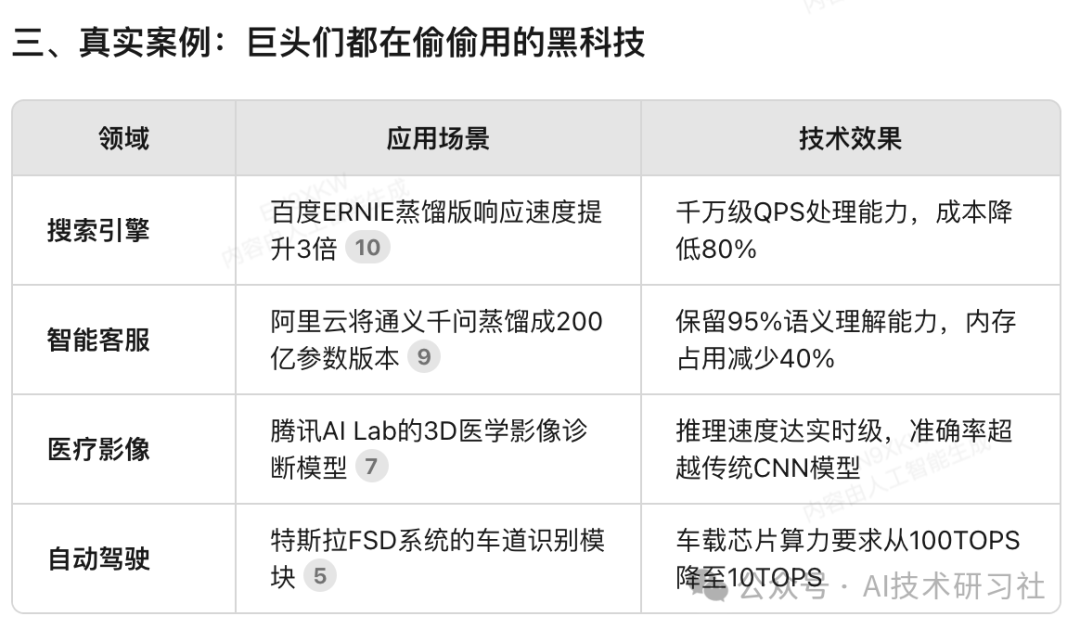

大模型蒸馏的实际应用

1. 智能手机AI助手

想象一下,你的手机有一个超智能语音助手,它能快速响应你的需求,理解你说的话。背后可能就是一个经过蒸馏的语音识别模型,它把一个巨型的语音识别系统“瘦身”,让它能在手机上流畅运行。

2. 自动驾驶系统

自动驾驶车需要在极短的时间内处理大量的传感器数据,快速作出决策。通过蒸馏技术,原本庞大的AI模型可以被压缩成更小的模型,既保证推理速度,又减少计算资源的消耗。

3. 边缘计算设备

物联网设备、智能摄像头等边缘设备往往没法运行庞大的深度学习模型。蒸馏技术可以让这些设备使用更小巧的AI模型,进行图像识别、语音处理等任务,保证效能的同时节省资源。

蒸馏技术的三大雷区

1. 知识同质化

如果过度依赖某个教师模型,可能会导致所有小模型的思维方式趋于一致,缺乏创新和多样性。

2. 能力阉割

有些专业领域(如法律文书、医学分析)可能在蒸馏过程中丢失精细度,导致小模型的专业性不足。

3. 数据污染

如果教师模型本身存在偏见或错误,学生模型可能也会“继承”这些缺陷,导致推理结果出现偏差。

解决方案

-

混合蒸馏(多教师模型融合):通过引入多个教师模型,整合不同模型的优势,避免过度依赖单一模型的知识。

-

领域适配模块:为特定领域(如法律、医学)加入适配模块,确保细节处理能力不丧失。

-

对抗训练机制:通过生成对抗样本,增强学生模型的鲁棒性,避免教师模型中的潜在偏见。

大模型蒸馏是一项非常酷的技术,它让庞大的AI模型变得轻便又高效,保持了强大的推理能力,却不再依赖超大的计算资源。

通过蒸馏,AI可以更加聪明、更加高效,并能够适应越来越多的设备和平台。无论是在智能手机、自动驾驶系统,还是边缘设备中,蒸馏技术都能发挥巨大的作用。

如果你是AI技术的爱好者,或者正在开发相关项目,那么了解和应用模型蒸馏绝对值得你深入探索!

希望这篇文章能帮助你快速理解大模型蒸馏的基本原理,也激发你对AI技术的更多兴趣!

(文:AI技术研习社)