专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

今早10点20,DeepSeek开启了本周连续5天技术分享的第2天,开源了专为混合专家模型(MoE)训练和推理设计的开源EP通信库——DeepEP。

值得一提的是,DeepSeek昨天开源的FlashMLA已经超过7000颗星,成为github霸榜项目。今天这个已经破1000颗星啦。

开源地址:https://github.com/deepseek-ai/DeepEP

通常在MoE模型中,不同的GPU节点往往需要分工合作处理数据,而All-to-All通信是一种常见的模式,用来实现GPU之间数据的互相交换。

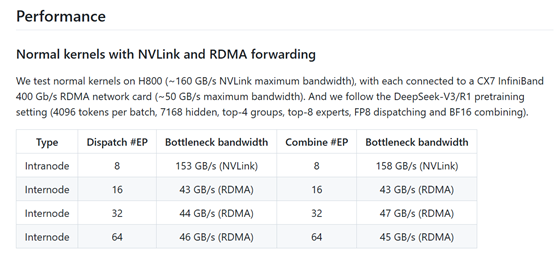

DeepEP通过高效且优化的All-to-All通信机制,支持节点内部和节点之间的通信,分别利用NVLink和RDMA实现。

例如,假设你有4个GPU,每个GPU专注于处理部分“专家模块”,通过All-to-All通信,GPU1需要将部分数据发给GPU2,同时也从GPU3接收数据。DeepEP优化了这种通信方式,让数据交换更快更高效。

同时,DeepEP还支持高吞吐量和低延迟内核。高吞吐量内核适用于训练中的数据批量处理阶段,比如预填充大批量数据时,能够显著提升训练速度。而低延迟内核则针对推理解码阶段,低延迟的计算能够让生成结果更快。

例如,推理时,如果GPT模型正在完成一句话生成,低延迟内核会减少每个单词生成的等待时间。

DeepEP原生支持FP8分发。FP8是一种更低精度的计算格式,相比于传统的FP16或FP32,更节省显存和计算资源,同时还能保持一定的精度。例如,在使用超大MoE模型生成文本时,使用FP8可以显著减少计算成本,DeepEP天生支持这种低精度操作。

此外,DeepEP还实现了计算与通信的重叠。在深度学习中,通信(传输数据)和计算往往是分阶段进行的,而DeepEP可以让这两者同时进行,进一步提升整体效率。例如,在训练过程中,一个GPU可以在等待通信完成的同时,继续处理其他计算任务,从而避免浪费时间。

网友表示,DeepSeek 对混合专家模型的优化程度令人瞩目,这类模型因其规模和复杂性而极难处理。DeepEP利用 NVLink 和 RDMA 等前沿硬件,如此精准地应对挑战并支持 FP8 数据格式,实在是太厉害了。

更多 CUDA 内核!又是出色的成果!

DeepEP来了,它将给 AI 模型训练带来革命性变化!

(文:AIGC开放社区)