作者|周一笑

邮箱|zhouyixiao@pingwest.com

-

高效优化的全对全通信

-

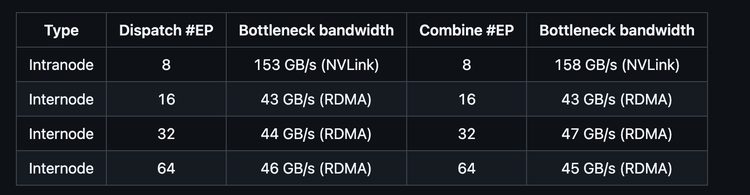

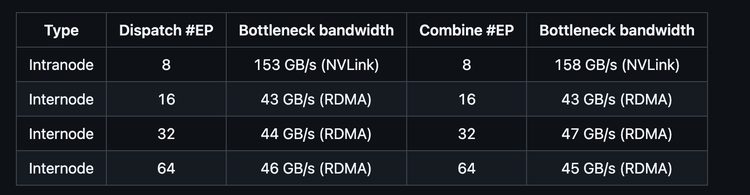

通过 NVLink 和 RDMA 实现节点内与节点间支持

-

用于训练和推理预填充的高吞吐量内核

-

低延迟推理解码内核

-

原生 FP8 调度支持

-

计算与通信重叠的灵活 GPU 资源控制

(文:硅星GenAI)

作者|周一笑

邮箱|zhouyixiao@pingwest.com

高效优化的全对全通信

通过 NVLink 和 RDMA 实现节点内与节点间支持

用于训练和推理预填充的高吞吐量内核

低延迟推理解码内核

原生 FP8 调度支持

计算与通信重叠的灵活 GPU 资源控制

(文:硅星GenAI)