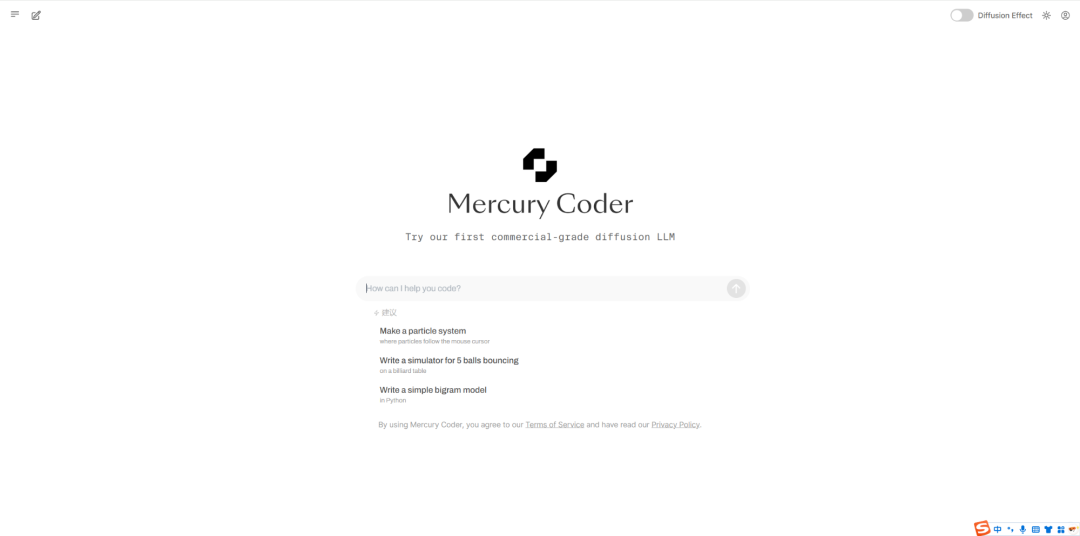

Mercury 首款商业级扩散大型语言模型(dLLM)来了!dLLMs以其并行、由粗到细的文本生成技术,使得AI生成的速度奇快!

吴恩达评价:Transformers 主导了 LLM 文本生成,并按顺序生成 token。这是一个很酷的尝试,探索扩散模型作为替代方案,通过使用由粗到细的过程同时生成整个文本。

-

Mercury Coder dLLMs达到了与最先进的速度优化模型(如GPT-4o Mini和Claude 3.5 Haiku)相匹配的性能,同时运行速度提升至10倍。

-

在NVIDIA H100s上实现了每秒超过1000个Tokend的生成速度,实现了闪电般的快速生成,而无需专用芯片!

-

在Copilot Arena上,开发者一致偏爱Mercury的生成内容。在速度上排名第一,在质量上排名第二。Mercury Coder是市场上最快的代码LLM。

参考文献:

[1] 访问:https://chat.inceptionlabs.ai

[2] Blog:https://www.inceptionlabs.ai/news

(文:NLP工程化)