Gemma 3 是一个开源的多模态(文本 + 视觉)、多语言的 LLM,拥有 128k token的上下文窗口,并提供 4 种不同大小的模型!

-

提供 4 种大小的模型,分别有 1B、4B、12B 和 27B 参数量。

-

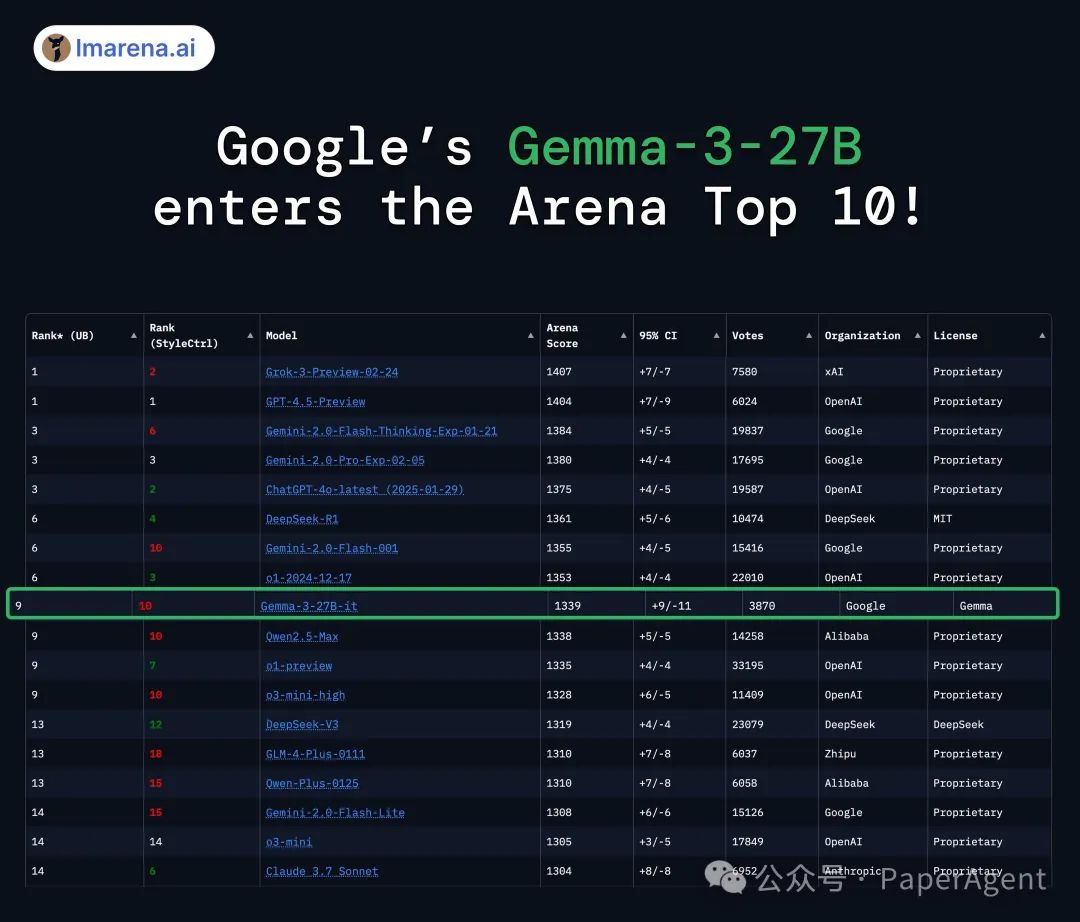

在 LMArena 中排名第一的开源非推理模型,得分为 1339,超越了 o1-mini。

-

支持 140 多种语言的多语言能力

-

上下文窗口扩展至 128k token(1B 模型为 32k)。

-

后续训练结合了 RLHF、RLMF 和 RLEF,以及模型融合。

-

Gemma 3 的 12B 版本超越了 Gemma 2 的 27B 版本,4B 版本也超越了 9B 版本。

-

基于 SigLIP 的视觉编码器,采用自适应窗口算法处理高分辨率图像。

-

在 Google TPUs 上使用 JAX 训练,最大训练量达 14T token(27B 模型)。

https://hf-mirror.com/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6dhttps://blog.google/technology/developers/gemma-3/?linkId=13397566

(文:PaperAgent)