清华AIR 投稿

量子位 | 公众号 QbitAI

具身智能当中,动作空间的异构一致性问题带来的泛化瓶颈有解了!

清华智能产业研究院(AIR)团队联合商汤研究院等机构发布了首个基于通用动作空间的具身基础模型框架UniAct。

UniAct以视觉语言模型为核心,构建了首个tokenized通用动作空间,解决了具身智能中的通用动作异构一致性难题。

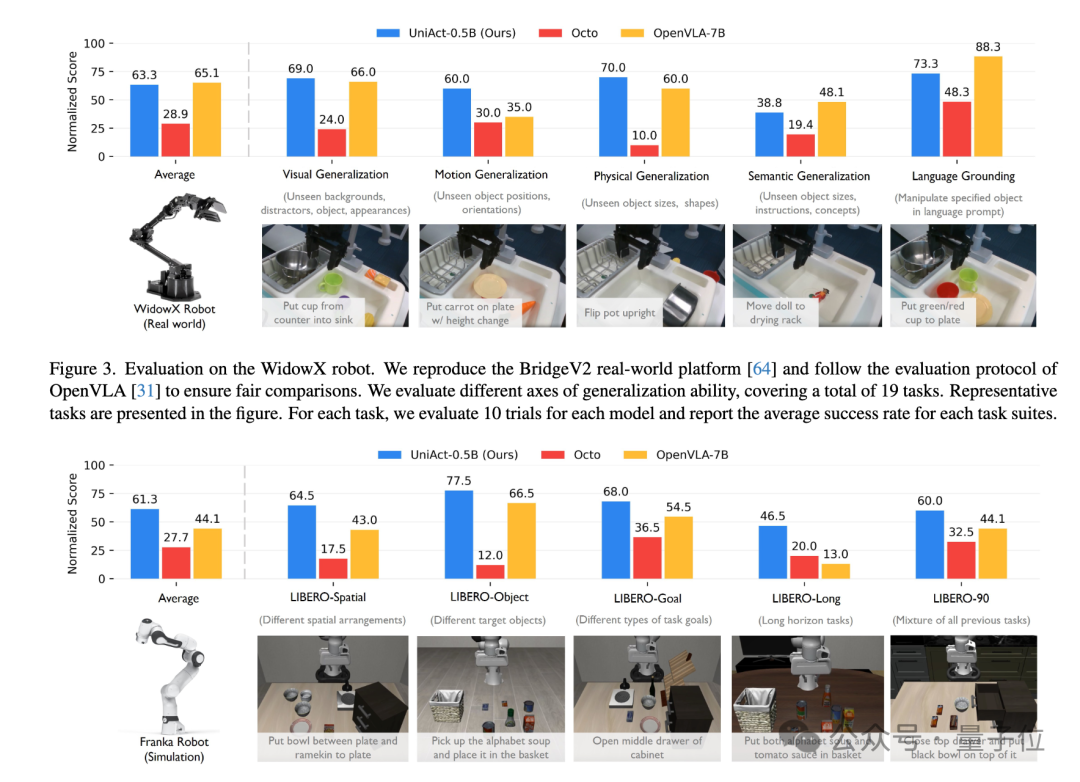

在多项权威评测中,UniAct都超越了参数量达14倍的顶尖对手OpenVLA。

目前,UniAct代码与论文已开源。

制约智能体泛化的瓶颈

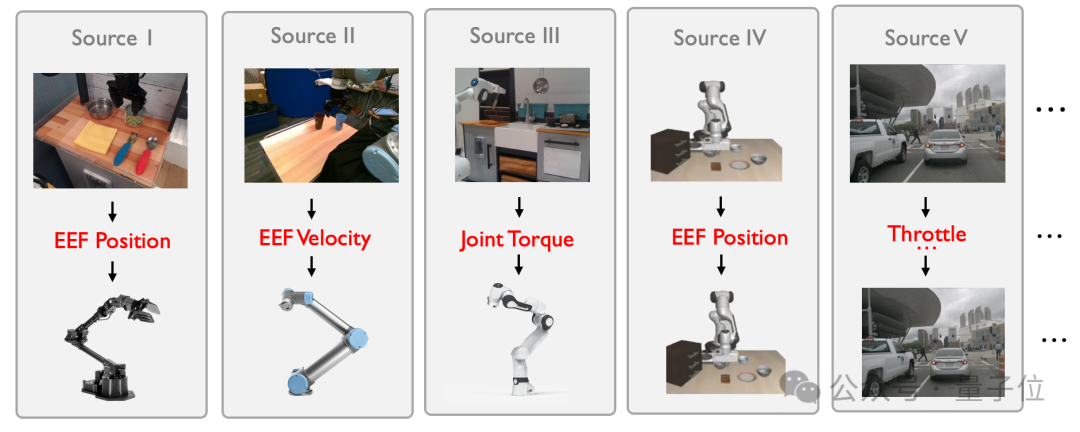

在人工智能领域,视觉、语言类基础模型通过海量数据训练实现跨模态泛化,但具身智能的构建却因动作空间的异质性陷入瓶颈。

不同机器人(如机械臂、四足机器人、汽车)因物理形态、控制接口差异,其动作指令在物理空间中呈现“不相交流形”,具体来说可以体现在三个方面:

-

本体差异:机械臂的末端执行器(EEF)位置与四足机器人的关节角度,物理含义截然不同;

-

控制接口多样性:同一指令(如“抓取物体”)在不同机器人中可能转化为EEF速度或关节扭矩;

-

多模态干扰:人类操作者的动作风格差异进一步加剧数据冲突。

传统方法尝试通过微调或聚合异构数据缓解问题,但收效甚微。

多数研究被迫将异构动作空间“强行对齐”,导致相似编码代表不同物理行为,甚至引发控制逻辑混乱。

从“通用原子行为”到“跨具身泛化”

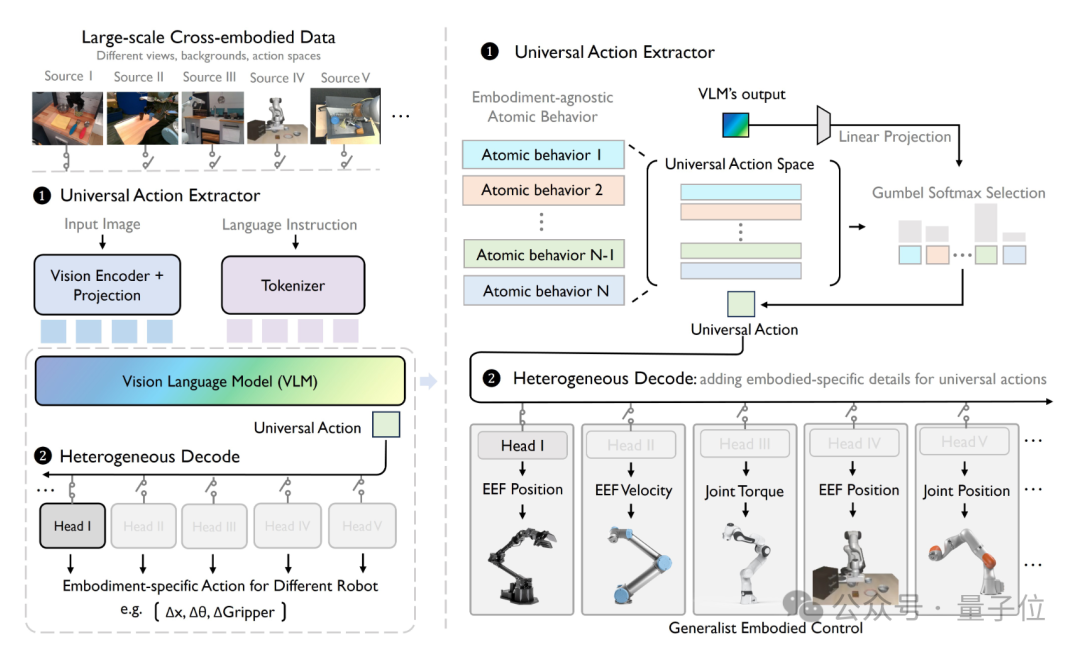

团队提出的UniAct框架,以视觉语言模型(VLM)为核心,构建了首个tokenized通用动作空间。

UniAct通过三大创新实现突破。

一是通用动作编码,也就是将不同机器人的原子行为(如“移动到目标位置”“避开障碍物”)封装为向量量化的codebook,每个token代表可跨机器人共享的通用技能。

这种设计既保留了动作的物理因果性,又消除了异构性

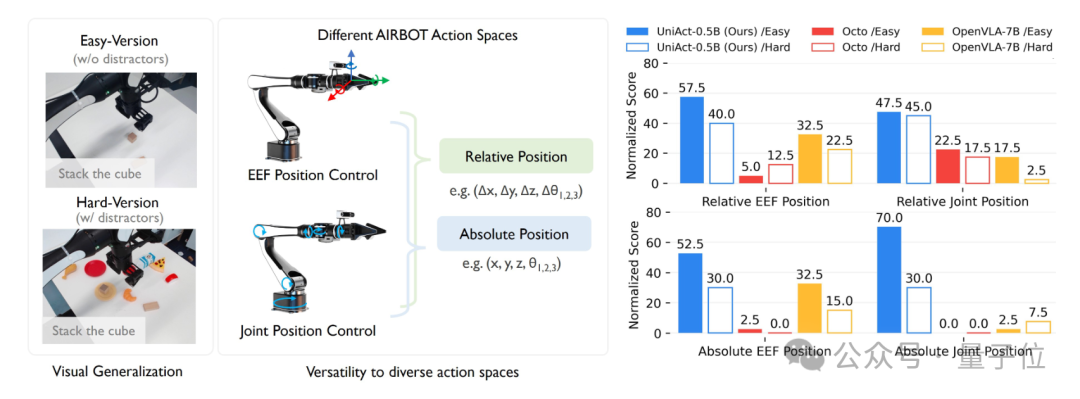

二是异质解码器,即针对不同机器人平台,通过轻量化解码器添加本体感受特征(如关节力矩)或不同摄像头视角下的图像,将通用动作转换为可执行指令。

例如,机械臂需EEF位置控制,而四足机器人需关节角度指令,解码器可动态适配。

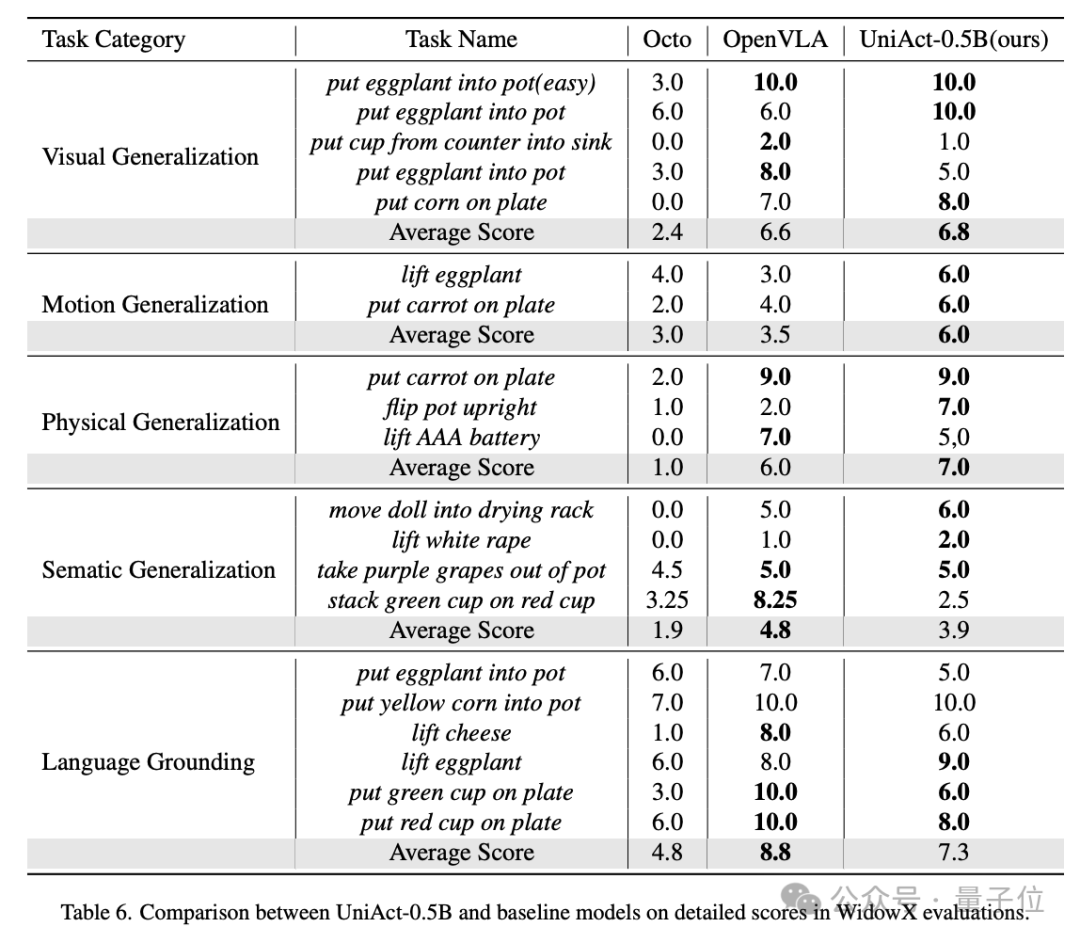

三是轻量化架构,UniAct-0.5B模型仅用0.5亿参数,即在对现实与模拟机器人任务的测试中超越14亿参数的OpenVLA,验证了通用动作的高效性。

复杂场景下的“全能选手”

在包含大视角变化(如第三人称转第一人称)和未见机器人类型(如双臂机械臂)的测试中,UniAct展现了惊人的泛化能力。

UniAct凭借跨机器人迁移与复杂环境适应能力,在真实世界和仿真环境的不同机械臂任务下,大幅提升任务成功率。

并且拥有极高的数据效率,仅需50条示教的机器人专用数据即可完成模型到新环境的微调。

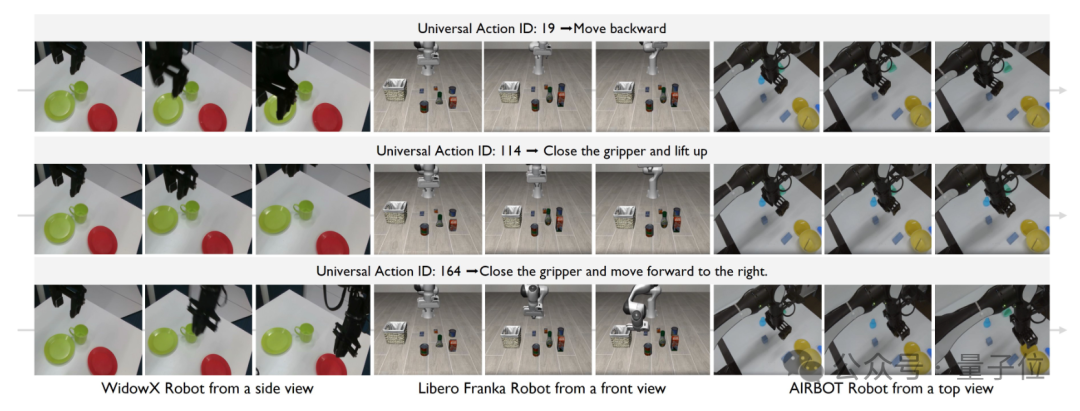

在通用动作异构一致性上,通过大量的异构数据预训练,UniAct框架也探索出了具有高度一致的通用动作空间。

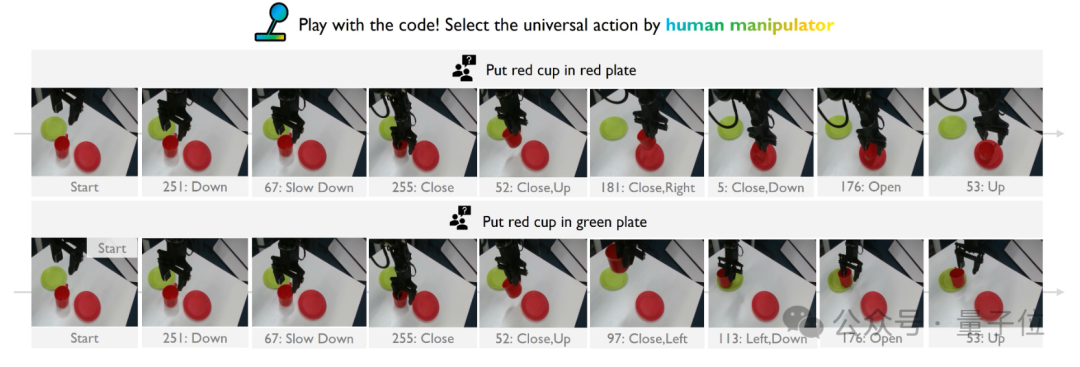

如下图所示,同一个通用动作表征可以在完全不同的部署场景和具身智能体上表现出一致的行为模式。

此外,高效的异构解码机制让UniAct具备了可直接快速部署的通用动作,为控制具身智能体提供了新的方式,通过从码本中直接挑选通用动作即可控制不同具身智能体完成指定的任务,play with code!

作者表示,UniAct的突破为具身智能的Scaling Law探索提供新思路。

UniAct证明了通用动作是解锁具身基础模型潜力的关键钥匙。

传统方法依赖单一机器人数据,而UniAct通过共享通用动作空间,使模型能吸收全球众包数据的精华,有望突破数据规模限制。

项目主页:

https://2toinf.github.io/UniAct/

论文地址:

https://arxiv.org/abs/2501.10105

GitHub:

https://github.com/2toinf/UniAct

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

—

(文:量子位)