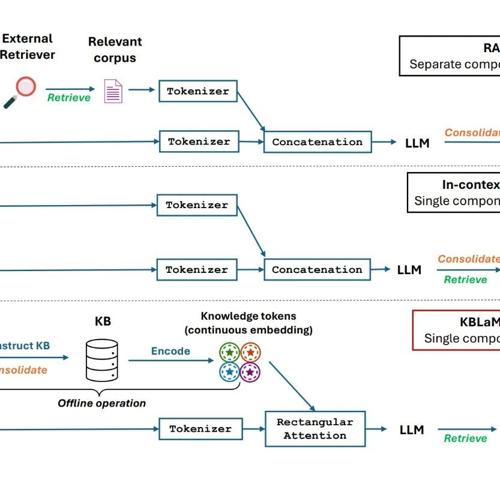

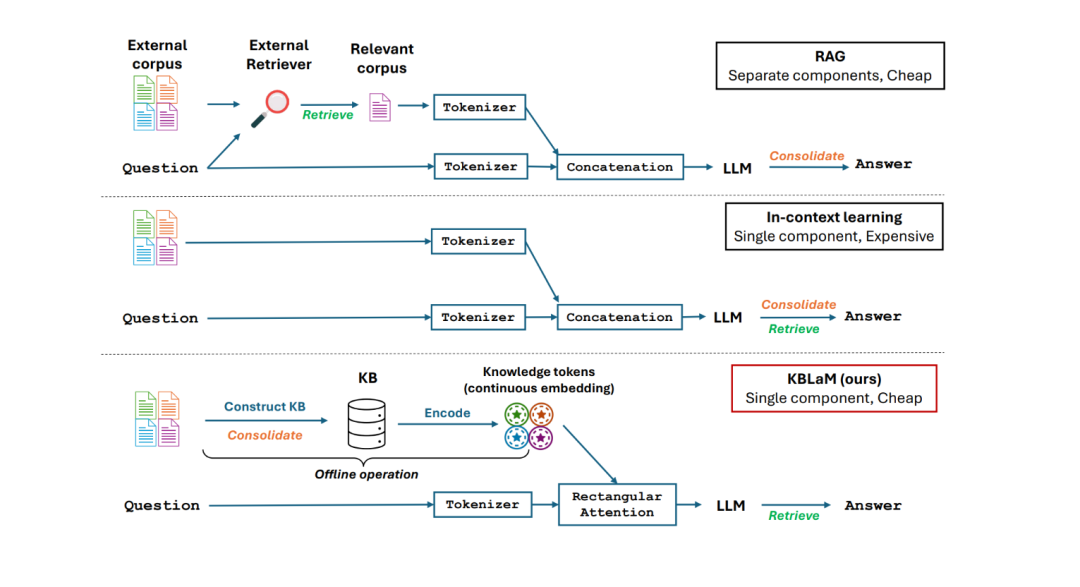

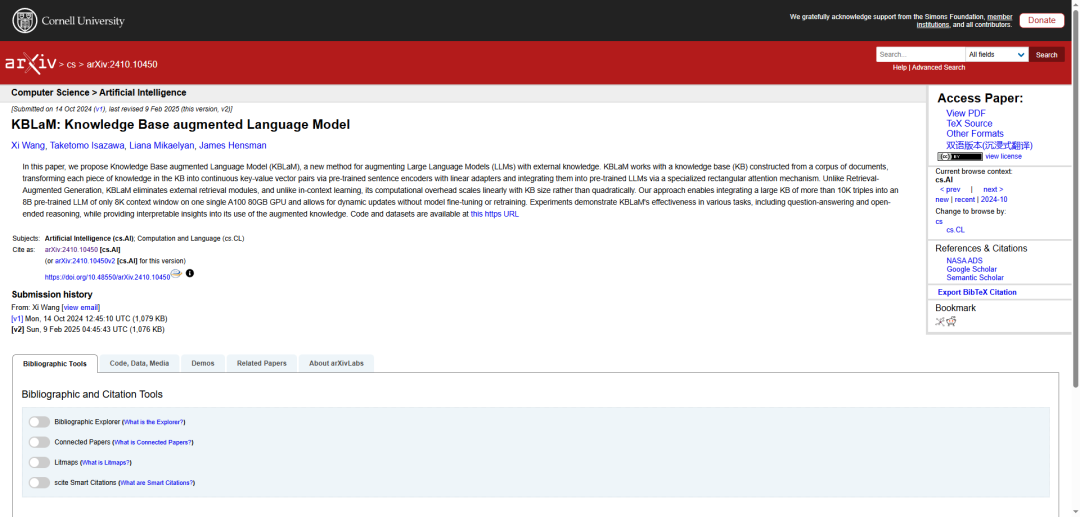

微软新出了一个KBLaM技术,相当于给AI配了个”活字典”,解决了LLM高效整合外部知识的问题。KBLaM可以随时更新,不用重新训练。它把外部知识转换成连续的键值向量对,直接嵌入到模型的注意力层中,从而实现隐式检索,当知识库更新时,只需要更新对应的键值对即可,无需重新训练整个模型。这种方法比RAG更直接,不需要外部检索;比上下文学习更高效,可以处理更多知识;比微调更灵活,可以随时更新知识。

参考文献:

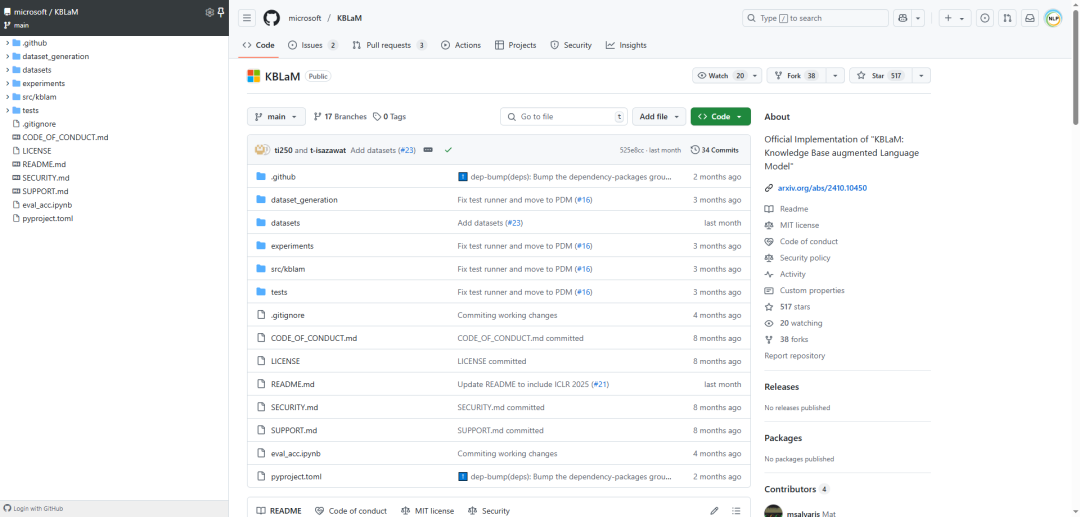

[1] github:https://github.com/microsoft/KBLaM/

[2] https://www.microsoft.com/en-us/research/blog/introducing-kblam-bringing-plug-and-play-external-knowledge-to-llms/

[3] https://arxiv.org/abs/2410.10450

(文:NLP工程化)