阿里的 Qwen Chat (通义千问聊天) 现在可以直接进行实时语音和实时视频聊聊天了,每天10次

全能选手 Qwen2.5-Omni 登场并开源

支撑这项新功能的,是刚刚发布的 Qwen2.5-Omni-7B 模型,它是一个 Omni(全能)模型。简单说,就是一个模型能同时理解 文本、音频、图像、视频 多种输入,并且能输出 文本和音频

阿里继续大搞开源,直接将 Qwen2.5-Omni-7B模型基于 Apache 2.0 许可证开源 了!同时,详细的技术报告也已公开,干货满满

这里是所有传送门,方便大家深入研究和上手:

-

• 体验 Qwen Chat 新功能: -

https://chat.qwenlm.ai -

• 技术报告 (Paper): -

https://github.com/QwenLM/Qwen2.5-Omni/blob/main/assets/Qwen2.5_Omni.pdf -

• 官方博客: -

https://qwenlm.github.io/blog/qwen2.5-omni -

• GitHub 代码仓库: -

https://github.com/QwenLM/Qwen2.5-Omni -

• Hugging Face 模型: -

https://huggingface.co/Qwen/Qwen2.5-Omni-7B -

• ModelScope 模型: -

https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

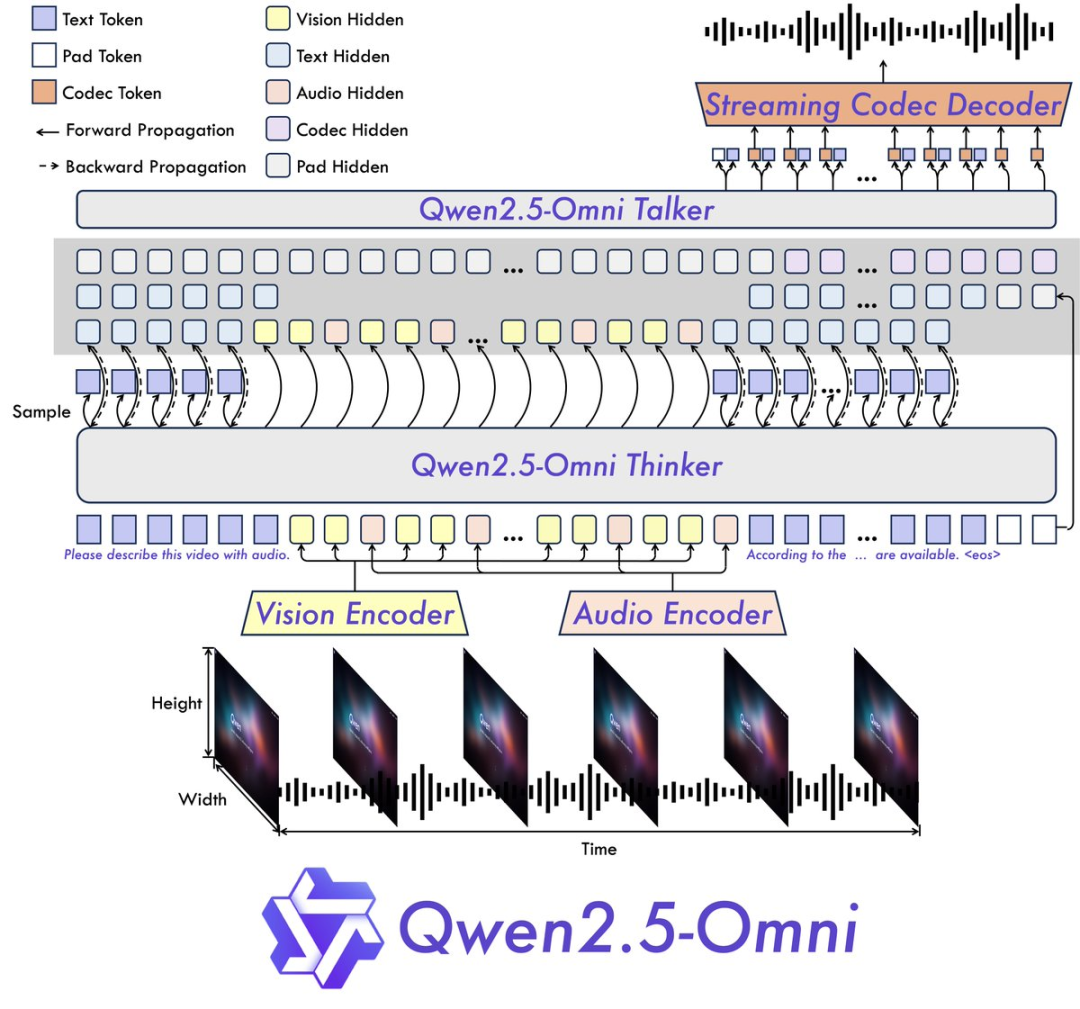

核心架构:「思考者-说话者」

Qwen2.5-Omni 实现这种全能能力的关键,在于其设计的 「Thinker-Talker」(思考者-说话者) 架构。这个设计非常巧妙,让模型能 同时思考和说话:

-

1. Thinker (思考者): 扮演大脑的角色。它负责处理来自文本、音频、视频等多种模态的输入,通过专门的音视频编码器提取信息,再利用一个 Transformer 解码器进行理解和处理,最终生成高层语义表示和相应的文本内容 -

2. Talker (说话者): 担当嘴巴的功能。它以流式(streaming)方式接收 Thinker 生成的高层表示和文本,并采用一种双轨自回归 Transformer 解码器架构,流畅地合成并输出离散的语音单元(tokens)。

关键点在于,Talker 并非独立工作,它能直接获取 Thinker 产生的高维表示,并且 共享 Thinker 全部历史上下文信息。这使得 Thinker 和 Talker 构成了一个紧密协作的 单一整体模型,可以进行端到端的训练和推理。这种设计是实现低延迟、高流畅度语音交互的核心

性能表现如何?全面且强大

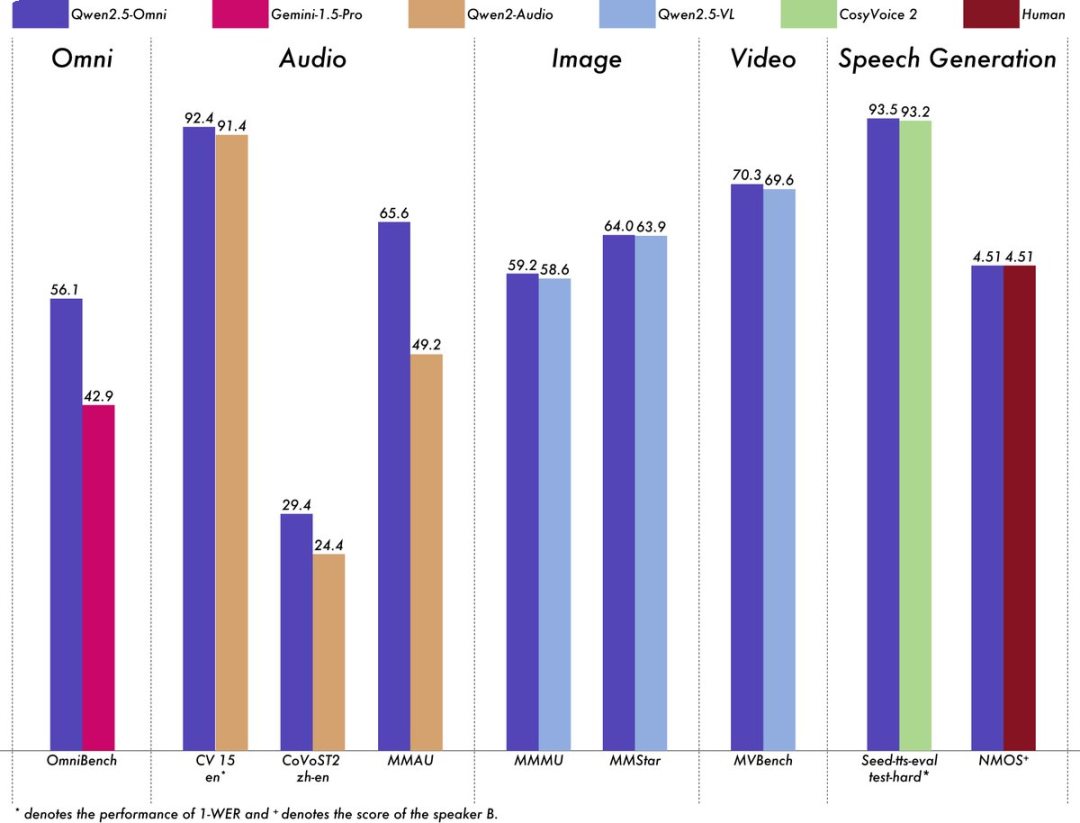

研究团队对 Qwen2.5-Omni 进行了全面评估,结果相当亮眼:

跨模态能力 SOTA: 在需要整合多种模态信息的任务上(如 OmniBench 基准测试),Qwen2.5-Omni 达到了当前最佳水平(State-of-the-Art)

单模态能力不俗: 与同等规模的单模态模型(如 Qwen2.5-VL-7B、Qwen2-Audio)以及一些强大的闭源模型(如 Gemini-1.5-pro)相比,Qwen2.5-Omni 在各项单模态任务上也展现出强大的竞争力。具体包括:

*语音识别:Common Voice

*语音翻译:CoVoST2

*音频理解:MMAU

*图像推理:MMMU, MMStar

*视频理解:MVBench

*语音生成: Seed-tts-eval 及主观自然度评估

可以说,Qwen2.5-Omni 在保持全能的同时,并没有牺牲在各个垂直领域的能力

总结:

⭐

(文:AI寒武纪)