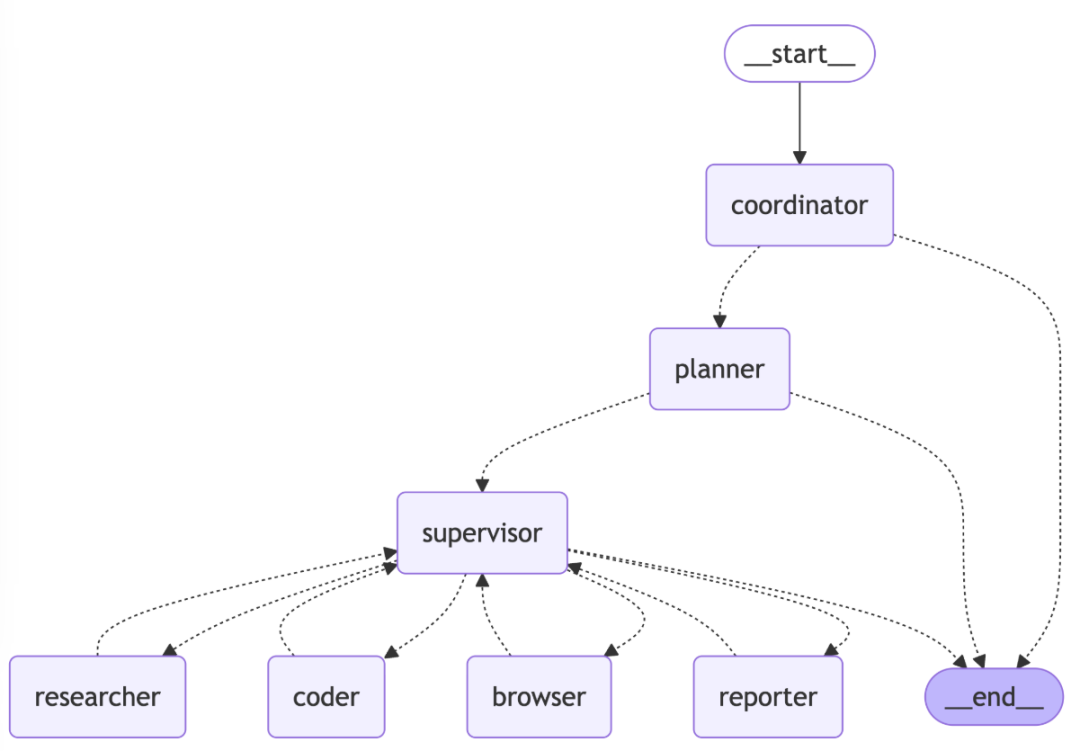

从其 GitHub 官网来看,LangManus 是一个社区驱动的 AI 自动化框架,它建立在开源社区的卓越工作基础之上。我们的目标是将语言模型与专业工具(如网络搜索、爬虫和 Python 代码执行)相结合,同时回馈让这一切成为可能的社区。

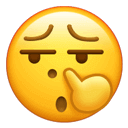

根据官方文档介绍,LangManus 实现了一个分层的多智能体系统,其中有一个主管智能体协调专门的智能体来完成复杂任务:

系统由以下智能体协同工作:

-

协调员(Coordinator):工作流程的入口点,处理初始交互并路由任务

-

规划员(Planner):分析任务并制定执行策略

-

主管(Supervisor):监督和管理其他智能体的执行

-

研究员(Researcher):收集和分析信息

-

程序员(Coder):负责代码生成和修改

-

浏览器(Browser):执行网页浏览和信息检索

-

汇报员(Reporter):生成工作流结果的报告和总结

下面是官方演示视频:

接下来我就来分享一下如何在本地部署并运行 LangManus。

我的电脑是 Windows 11。其他操作系统应该也是同样的步骤。

拉取 LangManus GitHub 项目

配置后端项目

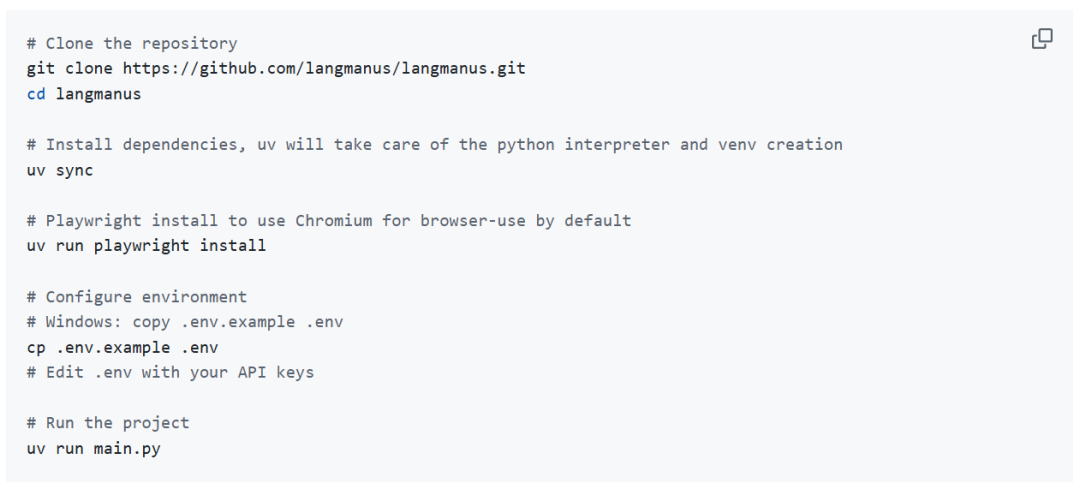

后端是一个使用 uv 管理包的纯 Python 项目:

注意!要执行接下来的操作,你需要先安装好 Miniconda。

打开终端,依次执行下述指令:

# 替换成你本地实际的后端项目地址cd C:\Home\Documents\Projects\langmanusconda create -n langmanus python=3.12conda activate langmanuspip install uvuv sync# 安装 Playwright 来使用浏览器uv run playwright install

接下来很关键!配置环境变量和模型。

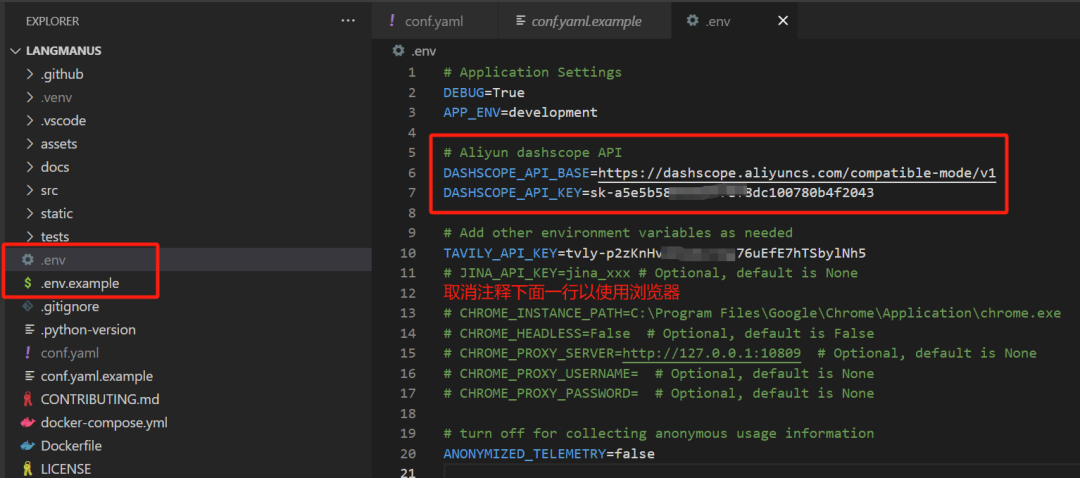

首先配置环境变量,复制一份 .env.example 为 .env 文件,然后填入下面的内容。

-

上图中我使用的是阿里云的模型服务,你可以自由选择其他厂商甚至是本地的模型。

-

TAVILY_API_KEY:这是用来执行网络搜索的。

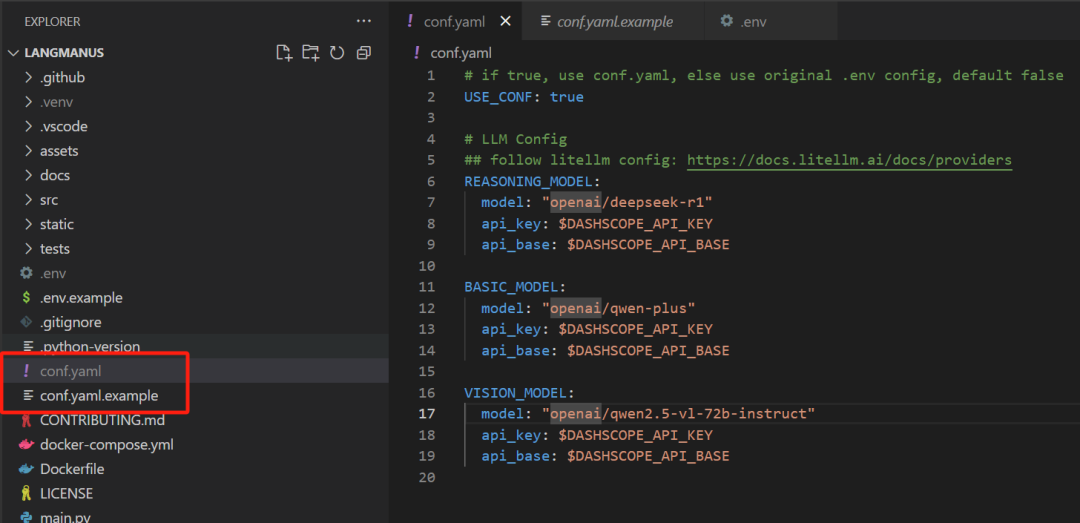

然后我们配置 conf.yaml 文件,也是从 cong.yaml.example 中复制一个得到的。

熟悉我的读者朋友都知道,我用惯了以 OpenAI API 兼容格式调用其他模型,所以上图我都加了一个 openai 前缀。(当然, litellm 也要求你必须提供一个模型提供商 )

)

conf.yaml 里面配置了三种模型:

-

推理模型,我选择了 deepseek-r1

-

基础模型,我选择了 qwen-plus

-

视觉模型,我选择了 qwen2.5-vl-72b-instruct

现在,我们后端配置完了。

配置前端项目

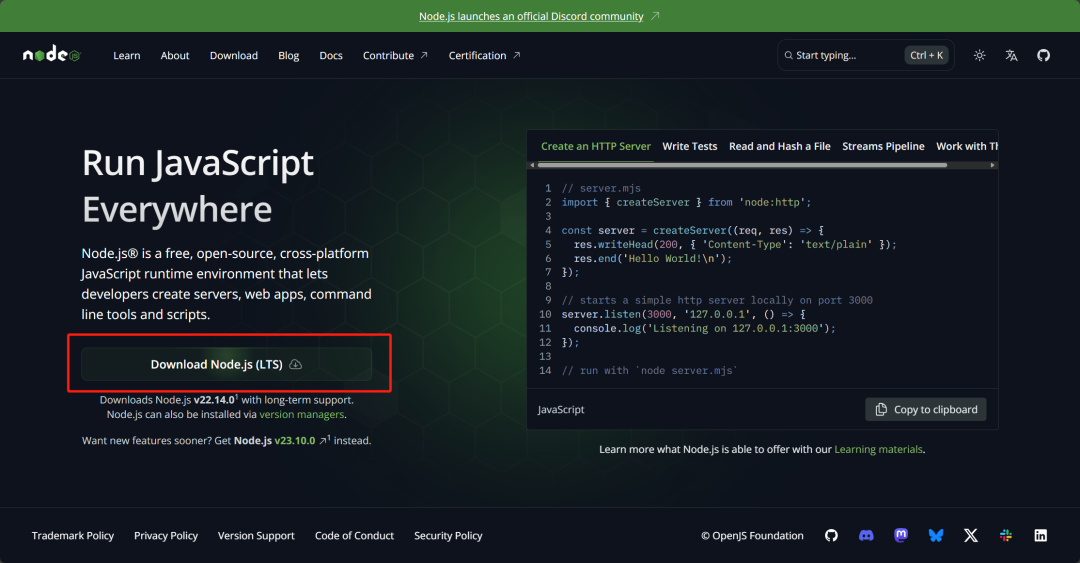

首先下载并安装 Node.js,安装时一切默认往下点就对了。

下载地址:https://nodejs.org/en

安装结束之后,安装一个 pnpm:

npm install -g pnpm@latest-10安装成功之后别忘了重启一下终端。

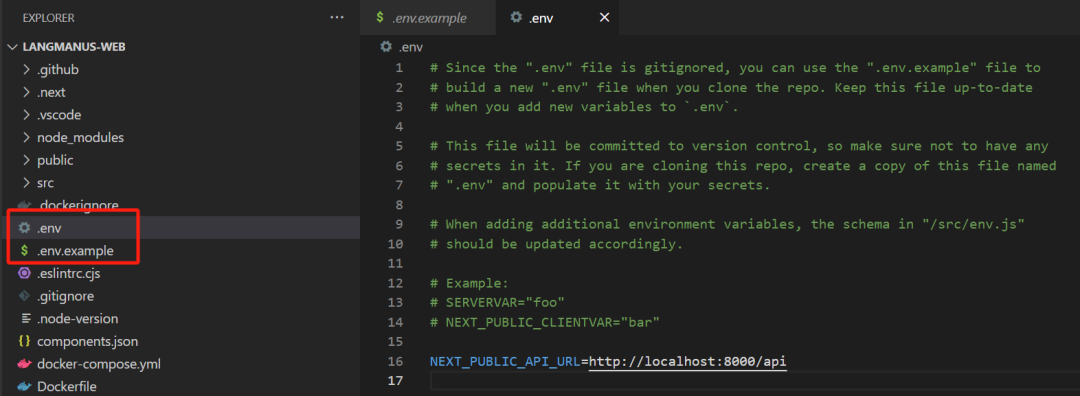

现在回到 langmanus-web 项目,这个项目的环境变量文件就一行:指定后端服务接口的配置。同样的从 .env.example 复制一个 .env 文件。

接下来安装前端依赖:

# 替换成你本地实际的后端项目地址cd C:\Home\Documents\Projects\langmanus-webpnpm install

现在前端项目也配置好了。

开始使用 LangManus

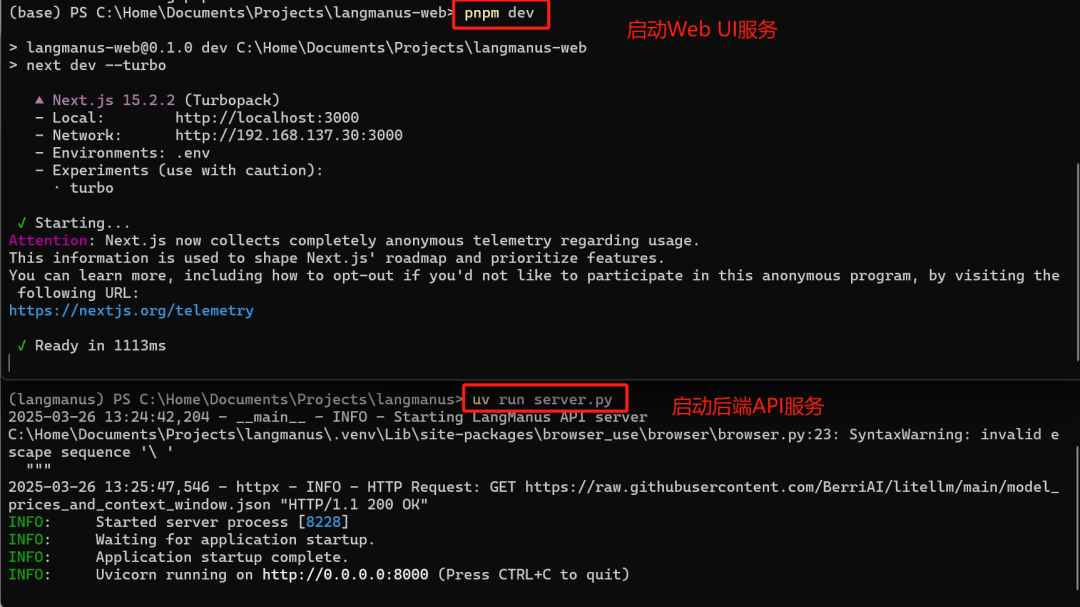

接下来分别启动前后端项目:

在浏览器中打开:http://localhost:3000/

我使用和官方演示同样的任务:Calculate the influence index of DeepSeek R1 on HuggingFace. This index can be designed using a weighted sum of factors such as followers, downloads, and likes.

第一次我配置了 Chrome 浏览器,下面是效果:

最后的结果出现了 404,可能是我现在的 VLM 不太好,也可能是其他原因。

然后我不配置 Chrome 浏览器:

可以看到这次速度快多了。

LangManus 官方仓库:

https://github.com/langmanus

文章来源:PyTorch研习社

(文:PyTorch研习社)