在大规模语言模型(LLM)的训练过程中,强化学习(RL)已被证明能够在没有监督微调的情况下直接增强模型的推理能力。DeepSeek-R1-Zero 的提出,突破了传统的训练方式,通过引入 R1-Zero-like 训练范式,展示了强化学习在提升 LLM 推理能力中的巨大潜力。

然而,这种新兴的训练方法在实践中仍面临着一些挑战,包括如何选择合适的基础模型和优化策略。本文旨在对 R1-Zero-like 训练进行深入分析,通过研究基础模型和强化学习这两个核心组成部分,探索如何优化训练过程,消除潜在的优化偏差,并进一步提升推理性能。

文章的主要贡献包括:

-

基础模型分析:研究了不同基础模型的表现,特别是 Qwen2.5 系列模型和 DeepSeek-V3-Base 模型,分析了预训练特征如何影响强化学习性能。发现 Qwen2.5 模型无需提示模板也能展示出强大的推理能力。

-

优化方法改进:发现了 GRPO(Group Relative Policy Optimization)优化方法中存在的偏差,该偏差会导致模型生成过长的错误回答。为此,提出了 Dr. GRPO 优化方法,消除了该偏差,并提升了令牌效率。

-

提出简化版 R1-Zero 训练方案:通过优化后的 Dr. GRPO 算法,成功地提升了 Qwen2.5-Math-7B 模型在数学问题上的表现,达到了最新的最优性能,并展示了训练高效性。

通过这些贡献,研究人员展示了如何通过改进模型优化和基础模型的选择,实现更高效、更强大的推理能力提升。

Understanding R1-Zero-Like Training: A Critical Perspective

论文地址:

https://arxiv.org/abs/2503.20783

代码地址:

https://github.com/sail-sg/understand-r1-zero

对现有 base model 的分析

1.1 R1-Zero 可训练性:模板构建探索性基础策略

在 R1-Zero-like 训练框架中,基础模型是一个重要的组成部分。研究首先探讨了是否广泛使用的开源基础模型(通常用于句子补全任务)能够通过适当的模板有效地引出其问答能力,从而充当问答基础策略。实验使用了三种模板:

-

R1 模板:用户提出问题,助手首先思考推理过程,并给出答案,推理过程和答案分别用 <think> 和 <answer> 标签标记。

-

Qwen-Math 模板:系统指示逐步推理,并将最终答案放在 \\boxed{} 中。

-

无模板:直接使用问题进行模型输入。

研究涵盖了 Qwen2.5-Math 系列、Llama-3.1、DeepSeek-Math、DeepSeek-V3-Base 等多个基础模型,并测试了它们在 500 道 MATH 训练集问题上的回答能力。

实验首先采用无模板的方式进行测试,然后使用 R1 模板和 Qwen-Math 模板,并通过 GPT-4o-mini 判断模型的回答是否为问答格式,最后评估模型在不同模板下的 Pass@8 准确率。

结果表明,Llama 和 DeepSeek 模型在使用正确模板(R1 模板)后能显著提升问答能力,而 Qwen2.5 系列模型展现出无模板情况下显著提升的问答能力。

研究假设,Qwen2.5 模型在预训练过程中可能已经通过问题-答案对的数据进行训练,使得它们能够在不使用任何模板的情况下表现得像聊天模型一样,直接提供答案。

1.2 DeepSeek-V3-Base 已经展现出 “Aha 时刻”

“Aha 时刻”是指模型在强化学习过程中学会自我反思等能力。在 DeepSeek-R1-Zero 实验中,模型在 RL 训练后展现了自我反思行为。

研究进一步验证了 DeepSeek-V3-Base 模型,发现其在回答 MATH 问题时也表现出了类似的自我反思行为,如生成 “Aha” 或 “wait” 等关键词。

虽然这些行为在强化学习之前就已显现,但它们在后续的 RL 训练中得到了进一步增强。值得注意的是,尽管出现了自我反思行为,但并没有明确证据表明这些行为直接提升了准确性。

1.3 有趣的实验发现

模板对模型表现的影响:DeepSeek 和 Llama 模型使用 R1 模板后,问答能力显著提升,而 Qwen2.5 模型在没有模板的情况下表现出最好的性能。尤其是 Qwen2.5 模型,去掉模板后在多个基准任务上的表现提升了约 60%。

Qwen2.5 模型的预训练影响:Qwen2.5 模型的表现提示它们可能已经在预训练过程中使用了问题-答案对的文本,这使得它们在去除模板的情况下仍然能够很自然地进行问答。

自我反思行为的出现:DeepSeek-V3-Base 模型在回答问题时已经表现出了 “Aha 时刻”,即在思考过程中通过自我反思不断调整答案。尽管这些行为出现在 RL 训练之前,但它们对最终的推理能力仍有一定的提升作用。

这些发现提供了对基础模型在 R1-Zero-like 训练中的作用以及强化学习如何提升模型推理能力的新见解。

解决 GRPO 的长度偏差问题

2.1 GRPO 引入了偏见优化

在 DeepSeek-R1-Zero 实验中,模型的输出长度随着训练的进行不断增加,这通常被解释为推理能力(如自我反思)的发展。许多研究复制了这一现象,但本研究认为,响应长度的增加可能也与 GRPO(Group Relative Policy Optimization)目标函数中的偏差有关。

GRPO 的目标函数中引入了两个主要的偏见:

响应级别的长度偏见:GRPO 通过除以响应长度 |oi| 来计算优势。对于正优势(即正确响应),这一偏见导致较短的响应获得较大的梯度更新,从而使策略更倾向于简短的正确回答;相反,对于负优势(即错误响应),较长的响应因其较大的 |oi| 而受到较小的惩罚,使得策略倾向于选择较长的错误响应。

问题级别的难度偏见:GRPO 通过标准差归一化来调整不同问题的奖励,从而对标准差较低的问题赋予更高的权重。这种归一化方式可能导致不同问题的策略更新权重不均,从而影响优化效果。

2.2 Dr. GRPO:优化方法的改进

为了避免 GRPO 中的优化偏差,提出了 Dr. GRPO(Group Relative Policy Optimization Done Right),该方法通过简单的修改去除了 |oi| 和标准差归一化项。在 Dr. GRPO 中,使用常量值(如生成预算)替代原来基于 mask.sum(axis=dim) 的归一化方式,从而使优化目标更加公平并符合无偏优化。

Dr. GRPO 的优化过程恢复了传统 PPO(Proximal Policy Optimization)目标函数,并采用蒙特卡洛回报估计无偏基准。实验验证了 Dr. GRPO 相较于传统 GRPO 的有效性,证明其能够有效避免响应长度偏差,并显著提高令牌效率。

2.3 实验部分有趣的发现

2.3.1 发现1:GRPO 在训练过程中导致响应长度增加

实验显示,尽管 GRPO 和 Dr. GRPO 在训练初期有相似的训练趋势,但 GRPO 模型在奖励提升放缓时,响应长度仍然不断增加。这种现象通常被认为是通过 RL 训练生成长链推理(Long-CoT)的结果。然而,作者指出,这种现象也可能受到响应长度偏差的影响。

2.3.2 发现2:Dr. GRPO 有效遏制了响应长度的过度增长

相比之下,Dr. GRPO 通过计算无偏的策略梯度,成功避免了训练过程中响应长度的无节制增长。这表明,去除优化偏差后,模型能够更高效地生成答案,避免了过度推理的现象。

模板与问题集覆盖度对RL动态的影响

模板对初始策略的影响:模板的选择影响初始策略的表现,但 RL 训练后,各种模板的策略最终会收敛到类似的性能水平(约 40% 的准确率),前提是问题集合适。

问题集对 RL 动态的影响:使用 R1 模板时,问题集的覆盖度显著影响RL动态,覆盖范围较窄的问题集导致较低的最终表现。相比之下,Qwen-Math 模板则显示出在 GSM-8K 问题集上取得了最佳性能,这表明训练较简单的问题集可以显著提高在更难问题上的测试准确性,几乎将其提升了一倍。

Qwen2.5 模型的初始能力:Qwen2.5-Math-1.5B 基础模型本身已经具备较强的数学解决能力,应用模板反而会在 RL 前破坏其能力,表明我们在谈论纯 RL 训练所带来的巨大提升时应更为谨慎。

模板与基础模型不匹配:当模板与基础模型不匹配时(例如 R1 模板与 Qwen2.5-Math-1.5B 不匹配),策略的改进主要来源于 RL 微调,这要求问题集必须有足够的覆盖度才能有效提高推理能力。

域特定预训练提升 RL 性能上限

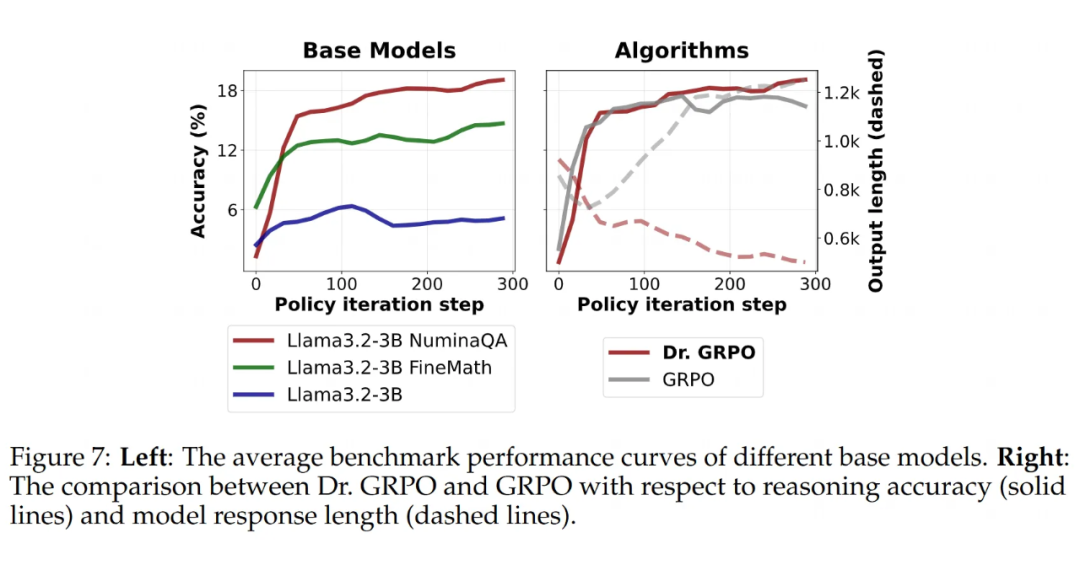

针对原本在数学推理方面较弱的基础模型,研究探讨了域特定预训练是否能够提升 RL 训练的效果。通过使用 Llama-3.2-3B 基础模型并进行数学领域特定的预训练,研究发现,域特定预训练能够显著提升 RL 训练的表现。

RL 训练确实能够提升原始 Llama 模型的性能,但提升幅度较小。然而,在进行数学领域预训练(无论是 FineMath 预训练还是拼接式预训练)后,Llama 模型的 RL 性能显著提高,验证了预训练对 RL 上限的提升作用。

此外,研究还重访了 GRPO 优化偏差的问题,右侧图展示了使用 GRPO 和 Dr. GRPO 的比较。结果表明,GRPO 可能导致“响应长度的双重增长”现象,容易误认为是长链推理的出现,而这种长度增加可能源自优化偏差,Dr. GRPO 有效地解决了这一问题。

结论

本文对 R1-Zero-like 训练的核心组件进行了深入分析,重点探讨了基础模型与强化学习(RL)动态的相互关系。通过对模板选择、问题集覆盖度和优化方法的详细研究,作者发现多个因素显著影响 RL 的表现。特别是提出的 Dr. GRPO 优化方法,成功地消除了响应长度偏差,提高了令牌效率和推理性能。

此外,研究还强调了预训练偏差和领域特定预训练对 RL 结果的影响。研究表明,在大规模语言模型的 RL 训练中,规模的扩大既可以有效提升性能,也能提高效率——有时,简单的优化方法反而更为高效。

本研究不仅为 RL 训练提供了重要的见解,也为未来模型优化技术的改进与精细化提供了新的思路。

(文:PaperWeekly)