-

• 核心观点: 微软通过 Phi-4 推理系列,展示了优化数据与训练策略比单纯扩大模型规模更能有效提升小型语言模型 (SLM) 的复杂推理能力,推动 AI 发展范式革新。 -

• 关键模型: 发布侧重推理的 Phi-4-reasoning (14B)、增强版 plus (14B+RL) 及轻量级 Phi-4-mini-reasoning (3.8B)。 -

• 性能实证: Phi-4 系列以显著更小的参数量,在数学、科学等高难度推理基准上,达到了与顶尖大型模型相当甚至更优的性能。 -

• 方法论核心: 成功关键在于高质量数据优先及针对性训练技术(如 SFT、RL),验证了“小而精”的技术路径。 -

• 深远影响: Phi-4 加速 AI 向更高效、易部署、能力模块化发展,尤其利好端侧智能和资源受限场景,标志着 AI 效率与专业化时代的到来。

AI 发展转向——微软 Phi-4 引领效率与能力平衡

大型语言模型 (LLM) 的发展展示了规模的力量,但也带来了成本与部署的挑战。微软最新的 Phi-4 推理模型系列代表了 AI 领域的一个重要探索方向:如何在控制模型规模的前提下,实现高级认知能力,特别是复杂推理的突破。Phi-4 的实践及其成果,揭示了通过精细优化数据和训练策略提升 SLM 能力的可能性,预示着 AI 发展正从规模竞赛转向效率与专业能力的精巧平衡。

Phi-4 推理系列概览:差异化定位

Phi-4 推理系列包含三款模型,通过不同的参数规模、训练数据和优化技术,满足不同场景下的推理需求:

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

注:模型均可通过 Azure AI Foundry 和 Hugging Face 获取。

驱动 SLM 推理跃迁的关键

Phi-4 系列模型在推理任务上取得的显著进展,其背后蕴含着对 AI 能力构建的深刻理解:

1. 数据质量是核心引擎 (Data Quality as the Core Engine):

Phi-4 的训练明确将数据质量置于优先地位。无论是精心筛选的、能体现复杂推理过程的真实样本(如 o3-mini 的推理轨迹),还是利用先进模型生成的大规模、高质量合成数据(如 Deepseek-R1 的数学题解),都证明了训练数据的质而非量,对于模型学习高级认知能力(尤其是推理)起着决定性作用。 与其投入巨量资源扩大模型规模,不如投入资源精心构建和筛选与目标能力高度相关的优质数据集。这代表了向数据中心化 AI (Data-Centric AI) 的实质性转变。

2. 能力的模块化构建与迁移 (Modular Capability Building & Transfer):

Phi-4 推理模型并非从零开始,而是在一个通用的基础模型 (Phi-4) 之上,通过引入特定数据和训练技术(如 SFT、RL)来专门强化推理能力。这种“基础模型 + 能力强化”的模式,体现了 AI 能力构建的模块化和迁移学习思想。它允许研究者和开发者更灵活、高效地为模型赋予特定专长,而无需重新训练庞大的通用模型。这为构建由多个专业化 SLM 协作的复杂 AI 系统(如 AI Agent)奠定了基础。

3. 推理过程的可学习性 (Learnability of Reasoning Processes):

通过使用包含详细解题步骤或思考过程的数据进行训练(借鉴“思维链” Chain-of-Thought 的思想),Phi-4 证明了模型能够有效学习并内化分步推理的策略。这不仅直接提升了模型在复杂问题上的表现,也可能间接增强了其输出的可解释性。Phi-4-reasoning-plus 进一步通过 RL 优化,表明这种习得的推理能力具备持续改进的空间。

性能实证:“小模型”亦可“强推理”

关键基准测试结果证实了 Phi-4 的能力:

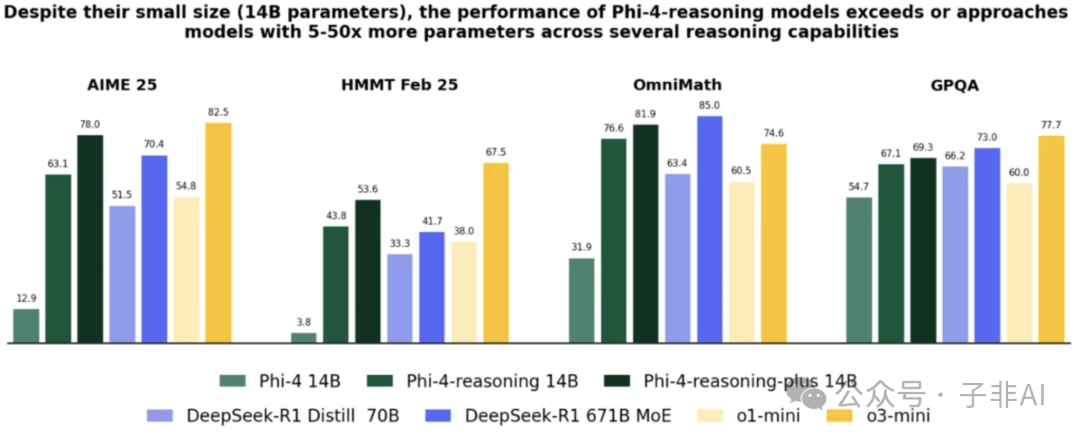

-

• 越级挑战: 14B 参数的 Phi-4-reasoning 在高难度推理任务(如 AIME 级别数学)上,性能超越了数倍于其参数量的模型,并达到或超过了部分顶尖大模型(如 o1-mini)。 -

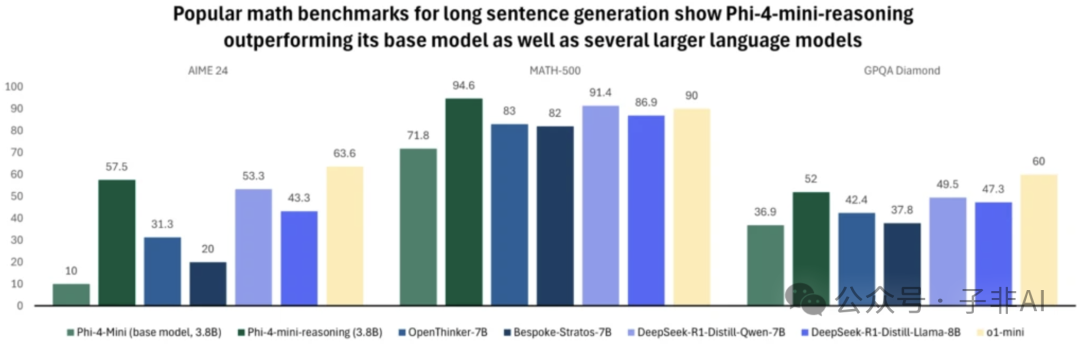

• 极致效率: 3.8B 参数的 Phi-4-mini-reasoning 在数学基准上,性能优于参数两倍于己的模型,并与 o1-mini 相当。 -

• 均衡发展: 推理能力的提升并未牺牲通用性,在问答、编码等任务上同样表现出色。

(图注:Phi-4-reasoning 在推理基准上的性能对比)

(图注:Phi-4-mini-reasoning (3.8B) 在数学任务上的突出表现)

这些数据明确显示,优化数据与训练是提升 SLM 高级认知能力的关键杠杆。

应用价值:拓展 AI 边界

Phi-4 推理模型的高效率和强大推理能力,使其特别适用于以下场景:

-

• 端侧 AI: 可部署于个人电脑 (如 Copilot+ PC 中经 NPU 优化的 Phi Silica 的后续演进)、智能手机及其他边缘设备,提供低延迟、高隐私的本地智能服务。 -

• 资源受限环境: 在物联网、嵌入式系统等对计算、功耗、成本敏感的场景中部署高级 AI 能力。 -

• 专业领域: 赋能教育科技(个性化辅导)、科学研究、金融建模、工程设计等需要深度逻辑推理的应用。 -

• AI Agent: 作为构建能够自主规划和执行复杂任务的智能体的理想基础模块。

Phi-4 正推动 AI 从云端走向更广泛的终端,并深入到对智能要求更高的垂直领域。

AI 新范式——效率与专业化并行

微软 Phi-4 推理系列不仅是 SLM 技术的进步,更象征着 AI 发展思路的演进。它证明了智能深度可通过优化而非仅仅规模来实现。通过聚焦数据质量和训练策略,小型模型也能在复杂推理等高级认知任务上取得卓越成就。

未来,AI 技术将更加注重效率、专业化和可部署性。“小而精”模型将与大型通用模型互补,共同推动 AI 在更广泛的场景中落地应用。Phi-4 正是这场 AI 效率革命的有力注脚。

资源链接

-

• 模型访问: -

• Azure AI Foundry: https://aka.ms/try-phi -

• Hugging Face: https://huggingface.co/microsoft(搜索 “Phi-4”) -

• 技术报告: -

• Phi-4 Reasoning: https://aka.ms/phi-reasoning/techreport -

• Phi-4-mini-reasoning: https://arxiv.org/pdf/2504.21233 -

• 使用指南: -

• Phi Cookbook: https://aka.ms/phicookbook -

• 相关文章: -

• 官方博客: https://azure.microsoft.com/en-us/blog/one-year-of-phi-small-language-models-making-big-leaps-in-ai/

(文:子非AI)