由两人创立的初创公司 Nari Labs 推出了一款名为 Dia 的文本转语音(TTS)模型,该模型拥有 16 亿个参数,旨在直接根据文本提示生成自然逼真的对话。其中一位创始人声称,其性能超越了 ElevenLabs、谷歌广受欢迎的 NotebookLM AI 播客生成产品等竞争对手的专有产品。

此外,它还可能对 OpenAI 近期推出的 gpt-4o-mini-tts 的应用推广构成威胁。

“Dia 在质量上可与 NotebookLM 的播客功能相媲美,甚至超越了 ElevenLabs Studio 和 Sesame 的开源模型。”Nari 和 Dia 的联合创始人之一托比·金(Toby Kim)在其社交网络 X 账号上发布的一则帖子中表示。

在另一则帖子中,金指出,该模型是在“零资金”的情况下开发的,并补充道:“……我们一开始并非人工智能专家。一切始于去年 NotebookLM 播客功能发布时,我们对其一见倾心。我们想要更多——对语音有更多的控制权,对脚本有更多的自由度。我们尝试了市场上所有的 TTS 应用程序编程接口(API),但没有一个听起来像真实的人类对话。”

金还感谢谷歌通过其研究云服务,为他和他的合作者提供了谷歌的张量处理单元(TPU)芯片用于训练 Dia。

Dia 的代码和权重(内部模型连接集)现已在 Hugging Face 或 GitHub 上提供下载,任何人都可以进行本地部署。个人用户可以在 Hugging Face Space 上尝试用它生成语音。

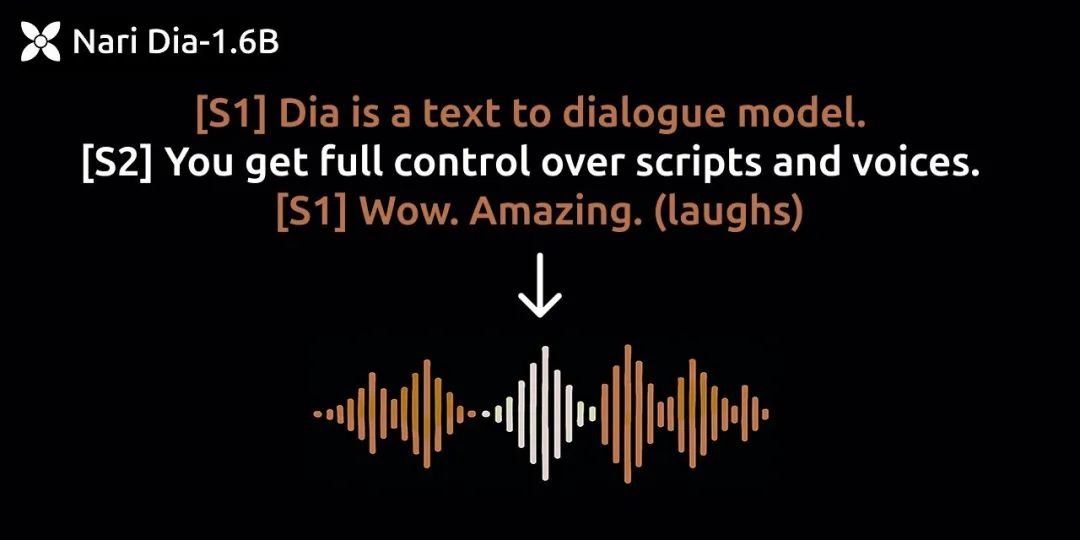

Dia 支持从纯文本中生成具有情感语调、说话人标记和非语言音频提示等细微特征的内容。

用户可以使用 [S1] 和 [S2] 等标签标记说话人轮换,并添加(笑)、(咳嗽)或(清嗓子)等提示,以丰富生成对话中的非语言行为。

据该公司示例页面显示,这些标签在生成过程中能够被 Dia 正确解读,而其他可用模型则无法可靠地支持这一点。

该模型目前仅支持英语,且不绑定于任何单一说话人的声音,除非用户固定生成种子或提供音频提示,否则每次运行都会生成不同的声音。音频调节(或语音克隆)功能允许用户通过上传样本片段来引导语音语调和声音相似度。

Nari Labs 提供了示例代码以简化这一过程,并提供了一个基于 Gradio 的演示,用户无需设置即可尝试。

Nari Labs 在其 Notion 网站上提供了大量由 Dia 生成的示例音频文件,并将其与其他领先的语音转文本竞争对手进行了比较,特别是 ElevenLabs Studio 和 Sesame CSM-1B,后者是 Oculus VR 头显联合创始人布伦丹·艾里布(Brendan Iribe)今年早些时候在 X 上小有名气的一款新文本转语音模型。

Nari Labs 分享的对比示例显示,Dia 在多个方面优于竞争对手:

在标准对话场景中,Dia 在自然节奏和非语言表达方面处理得更好。例如,在一个以(笑)结尾的脚本中,Dia 能够解读并生成实际的笑声,而 ElevenLabs 和 Sesame 则输出“haha”等文本替代词。

例如,这是 Dia 生成的……

……而这是 ElevenLabs Studio 生成的同一句话

在具有情感范围的多轮对话中,Dia 表现出更流畅的过渡和语调变化。一项测试包括一个戏剧性的、情绪激动的紧急场景。Dia 有效地呈现了紧迫感和说话人的压力,而竞争对手的模型往往让表达显得平淡或失去了节奏。

Dia 能够独特地处理仅包含非语言内容的脚本,例如涉及咳嗽、吸鼻子和笑声的幽默对话。竞争对手的模型无法识别这些标签或直接跳过了它们。

即使在节奏复杂的内容(如说唱歌词)方面,Dia 也能生成流畅、富有表现力的语音,保持节奏。这与 ElevenLabs 和 Sesame 1B 模型生成的更单调或脱节的输出形成鲜明对比。

使用音频提示时,Dia 可以将说话人的语音风格延续或融入到新的台词中。一个使用对话片段作为种子的示例展示了 Dia 如何将样本中的语音特征贯穿整个脚本对话。其他模型并不支持这一功能。

在一组测试中,Nari Labs 指出,Sesame 最佳的网站演示可能使用了该模型的内部 80 亿参数版本,而非公开的 10 亿参数检查点,这导致了广告宣传与实际性能之间的差距。

开发者可以从 Nari Labs 的 GitHub 仓库及其 Hugging Face 模型页面访问 Dia。该模型在 PyTorch 2.0+ 和 CUDA 12.6 上运行,需要约 10GB 的显存。

在 NVIDIA A4000 等企业级 GPU 上进行推理时,每秒可生成约 40 个标记。虽然当前版本仅支持 GPU 运行,但 Nari 计划提供 CPU 支持和量化版本以提高可访问性。该初创公司提供了 Python 库和命令行界面(CLI)工具,以进一步简化部署流程。

Dia 的灵活性为其在内容创作、辅助技术以及合成配音等领域开辟了应用场景。

Nari Labs 还在开发一款面向休闲用户的 Dia 消费者版本,旨在让用户能够轻松混合或分享生成的对话。感兴趣的用户可以通过电子邮件注册加入等待名单,以获取早期访问权限。

该模型在完全开源的 Apache 2.0 许可下分发,这意味着它可以用于商业目的——这显然会吸引企业或独立应用程序开发者。Nari Labs 明确禁止将该模型用于冒充个人、传播虚假信息或从事非法活动。该团队鼓励负责任的实验,并采取了反对不道德部署的立场。

Dia 的开发得到了谷歌 TPU 研究云、Hugging Face 的 ZeroGPU 资助计划以及 SoundStorm、Parakeet 和 Descript 音频编解码器先前工作的支持。

Nari Labs 仅由两名工程师组成——一名全职和一名兼职——但他们积极通过其 Discord 服务器和 GitHub 邀请社区贡献。凭借对表现力质量、可重复性和开放访问的明确关注,Dia 为生成式语音模型领域增添了一抹独特的色彩。

(文:AI音频时代)