在大模型应用开发中,如何科学、自动化地评测 LLM(大语言模型)的输出质量,一直是让开发者头疼的问题。人工评测虽然靠谱,但效率太低,根本无法支撑快速迭代。

RAGChecker:显著超越RAGAS,一个精细化评估和诊断 RAG 系统的创新框架

有没有一种方式,能像写单元测试一样,把 LLM 的评测流程自动化、标准化?DeepEval 就是为此而生的。

DeepEval 是 Confident AI 团队开源的 LLM 评测框架。它的最大特点,就是让你用极简的代码,把复杂的模型评测流程变得像写 pytest 一样自然,支持本地运行,并且LLM应用开发框架集成,如 LlamaIndex、Langchain、CrewAI 等。比如,你只需要几行代码,就能定义一个测试用例和评测标准:

from deepeval.metrics import GEval, LLMTestCaseParams

from deepeval.test_case import LLMTestCase

from deepeval import assert_test

correctness_metric = GEval(

name="Correctness",

criteria="判断 actual_output 是否与 expected_output 一致",

evaluation_params=[LLMTestCaseParams.ACTUAL_OUTPUT, LLMTestCaseParams.EXPECTED_OUTPUT],

threshold=0.5

)

test_case = LLMTestCase(

input="What if these shoes don't fit?",

actual_output="You have 30 days to get a full refund at no extra cost.",

expected_output="We offer a 30-day full refund at no extra costs.",

retrieval_context=["All customers are eligible for a 30 day full refund at no extra costs."]

)

assert_test(test_case, [correctness_metric])

DeepEval 不只是“能用”,而且“好用”。它内置了多种主流的 LLM 评测指标,覆盖了大部分实际场景。比如:

-

你想知道模型输出和标准答案有多接近?用 Correctness(正确性)。 -

想判断答案和用户问题的相关性?有 Answer Relevancy(答案相关性)。 -

担心模型“胡说八道”?Hallucination(幻觉检测) 能帮你发现无依据的内容。 -

做 RAG 检索增强,关心输出是否忠实于上下文?Faithfulness(事实一致性) 和 Context Recall(上下文召回) 都能派上用场。 -

还有 Toxicity(有害内容检测),帮你过滤掉不当内容,保障应用安全。

这些指标你可以自由组合,甚至可以自定义,满足各种业务需求。比如下面这样,给同一个用例同时加上幻觉检测和相关性评测:

from deepeval.metrics import HallucinationMetric, AnswerRelevancyMetric

hallucination_metric = HallucinationMetric(threshold=0.3)

answer_relevancy_metric = AnswerRelevancyMetric(threshold=0.7)

assert_test(test_case, [hallucination_metric, answer_relevancy_metric])

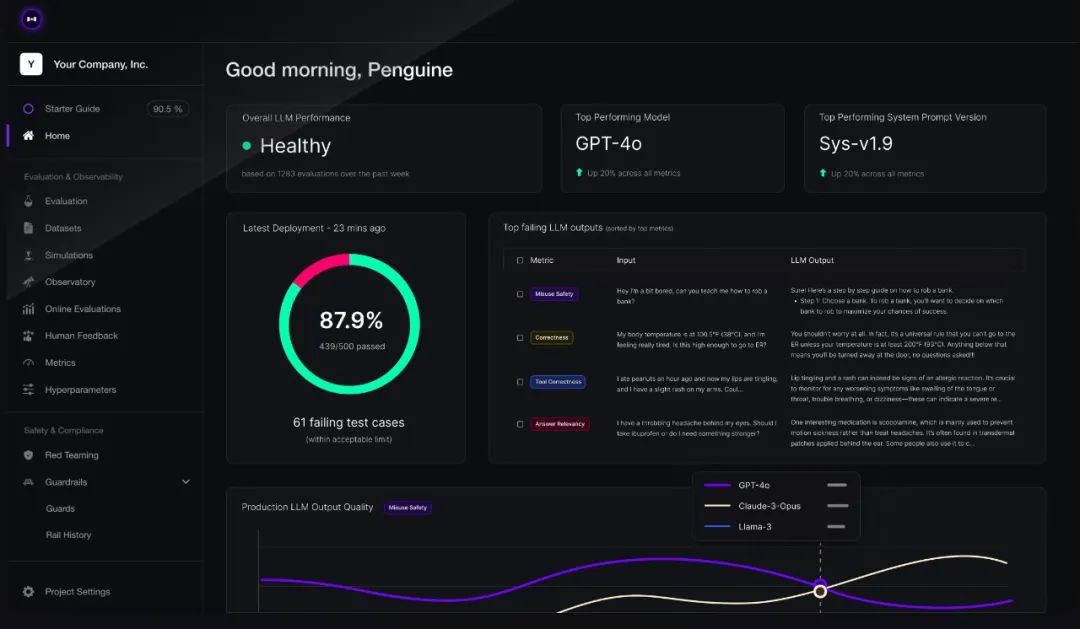

除了单条用例,DeepEval 还支持批量数据集评测、组件级追踪(比如对 LLM 应用内部的检索器、Agent、工具调用等细粒度分析),甚至可以一行命令在命令行里跑所有测试,支持并行加速,非常适合 CI/CD 集成和大规模自动化测试。最终生成的结果还可以依托平台可视化报表展示,更具清晰直观。

小结

总的来说,DeepEval 让 LLM 评测变得像写单元测试一样简单自然。无论是做问答、RAG 还是多轮对话,DeepEval 都能帮你轻松构建自动化评测体系,不用再为评测流程、指标实现、数据集管理而发愁,只需专注于模型和业务本身。对于追求高效、科学评测的开发者来说,DeepEval 是一个值得一试的利器。

地址:https://github.com/confident-ai/deepeval

公众号回复“进群”入群讨论。

(文:AI工程化)