鹭羽 发自 凹非寺

量子位 | 公众号 QbitAI

大模型目前的主导地位只是暂时的,在未来五年甚至十年内都不会是技术前沿。

这是新晋图灵奖得主、强化学习之父Richard Sutton对未来的最新预测。

就在刚刚的新加坡国立大学建校120周年(NUS120)之际,Sutton受邀发表演讲——塑造AI和强化学习的未来。

其实,这已经不是Sutton第一次在公开场合表达类似的观点,早在他19年的著作《痛苦的教训》中,他就明确提出:

让AI尤其是LLM模仿人类思维方式,只能带来短期的性能提升,长期看只会阻碍研究的持续进步。

在他4月份新发表的论文《欢迎来到体验时代》也再度强调了这点,同时他表示,扩展计算才是正解。

本次NUS120演讲长达一个多小时,可谓是干货满满、信息量超大。

让我们一起来看看完整演讲内容。

LLM主导是暂时的

Sutton首先提及当前人类处于数据时代,像ChatGPT这类大语言模型,都是靠分析人类产生的大量数据(如文本、图像、视频)进行训练。

但始终追逐人类思维方式,至多也只能达到“人类水平”。

在数学、科学等领域,人类数据里的知识已经接近极限,AI难以突破现有认知,纯靠模仿已经很难再有创新。

AI需要新的数据来源,且要随着AI增强而改进,静态数据集显然不足。

因此他认为AI终将从依赖人类数据,转向通过Agent与世界的第一人称交互,以获取“体验数据”的学习。

AlphaGo在与李在石对弈的第二局中,下出的神之一手——第37手,在人类标准下完全非常规的走法,就充分展现了AI在这种体验学习下的思考潜力。

也就是说,AI将会在自主体验中,完成自己的更新迭代,产生更高级的数据并反哺自身,构成一个“越学越强”的循环。

还能不受人类现有知识限制,自由探索人类未涉及的领域,比如全新的科学理论、材料设计等。

Sutton举了个例子:

一个蹒跚学步的婴儿会通过不断探索周围环境主动学习,然后随着认知增长,每一次互动方式都会随着经验有所不同。

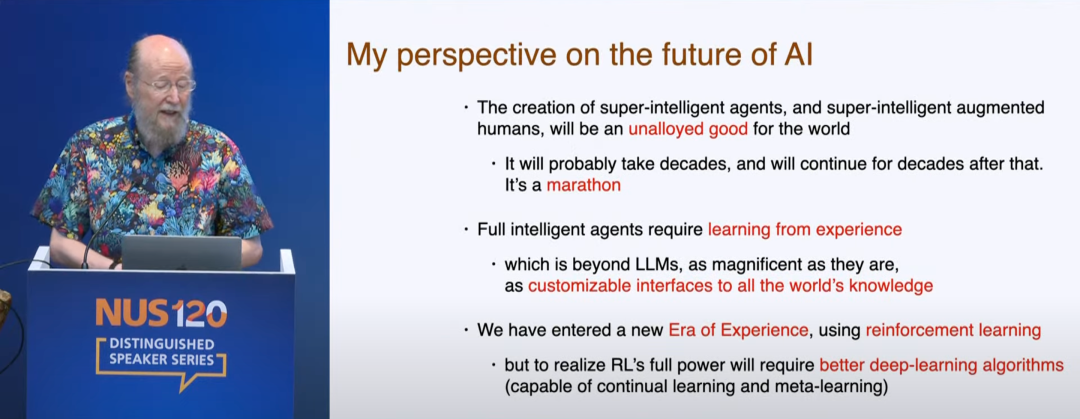

因此AI的未来将属于通过互动和经验学习的“体验时代”,Agent需要从经验中学习,而这远远超出了LLM的能力范畴。

即使现有LLM在连接全球知识上表现出色,但通往这一未来的核心路径始终是强化学习。

强化学习正是围绕着经验学习构造,但要发挥强化学习全部潜力,还需具备持续学习能力的深度学习算法。

而这背后要靠对大规模算力的充分利用来支撑,继续基于搜索和学习扩展算力,以适应AI性能需求增加。

可以说,从长远看,真正的突破还是来自规模计算。

不同Agent去中心化互利共赢

谈及Agent的前景,Sutton提出对不同目标的Agent可以寻求去中心化合作。

他认为每个Agent的奖励信号都各不相同,且都试图最大化自己的回报,那么只需要让不同Agent各自实现其目标,再通过互动,就能实现互利共赢。

这就类似于人类社会中的经济运转,得益于自然语言和货币的发明,尽管人们拥有不同的目标和能力,但在过程中相互协调配合,也能产生出不错的效果。

但还是有不少人主张集中控制AI,甚至呼吁暂停AI。

Sutton认为这种声音更多的是来源于对未知的恐惧,要接受个体目标的多样性,建立合作化秩序,AI的潜力恰恰就在去中心化合作。

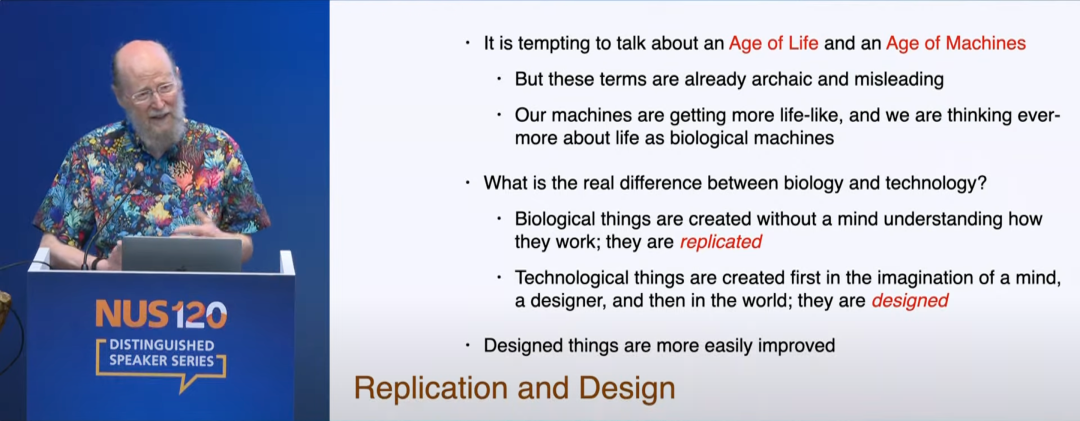

另外,Sutton还提到了“设计时代”的概念,当前的机器越来越类生命化,而生命也被视作生物机器。

但生命与技术之间存在本质差异,生命是在无意识下被复制产生,而技术则先经设计师意识想象再落地创造,这是一个设计过程,且设计产物也更易改进。

因此人类发展AI,就是为了将设计做到极致——设计出能自主设计的Agent,而人类将会在设计时代扮演催化剂和创造者的角色,将AI视作推动发展的机遇,而非单纯的技术产物。

One More Thing

Sutton的言论一出,很快在社区引起了激烈讨论。

支持者认为技术的突破往往来自未知与偶然,技术已趋向成熟的LLM似乎即将触及领域天花板。

而反对者则认为技术的发展在于不断改进,也许LLM不是AI的最终形态,但它也必定在AGI发展过程中占据重要作用。

那么你对LLM的未来抱有怎样的看法呢?欢迎在评论区留言讨论。

(文:量子位)