随着人工智能技术的飞速发展,多模态大模型逐渐成为研究和应用的热点。蚂蚁集团开源的Ming-Lite-Omni模型以其强大的多模态感知和生成能力,为AI领域带来了新的突破。本文将详细介绍Ming-Lite-Omni的技术原理、功能特性、基准测试表现以及应用场景,并通过实践案例展示其部署和使用方法。

一、项目概述

Ming-Lite-Omni是由蚂蚁集团开源的统一多模态大模型,基于Mixture of Experts(MoE)架构设计,能够处理文本、图像、音频和视频等多种模态的数据,并生成高质量的文本和自然语音。该模型在多个模态基准测试中表现出色,具备高度的可扩展性和广泛的应用前景,适用于智能客服、内容创作、教育、医疗健康等多个领域。

二、技术原理

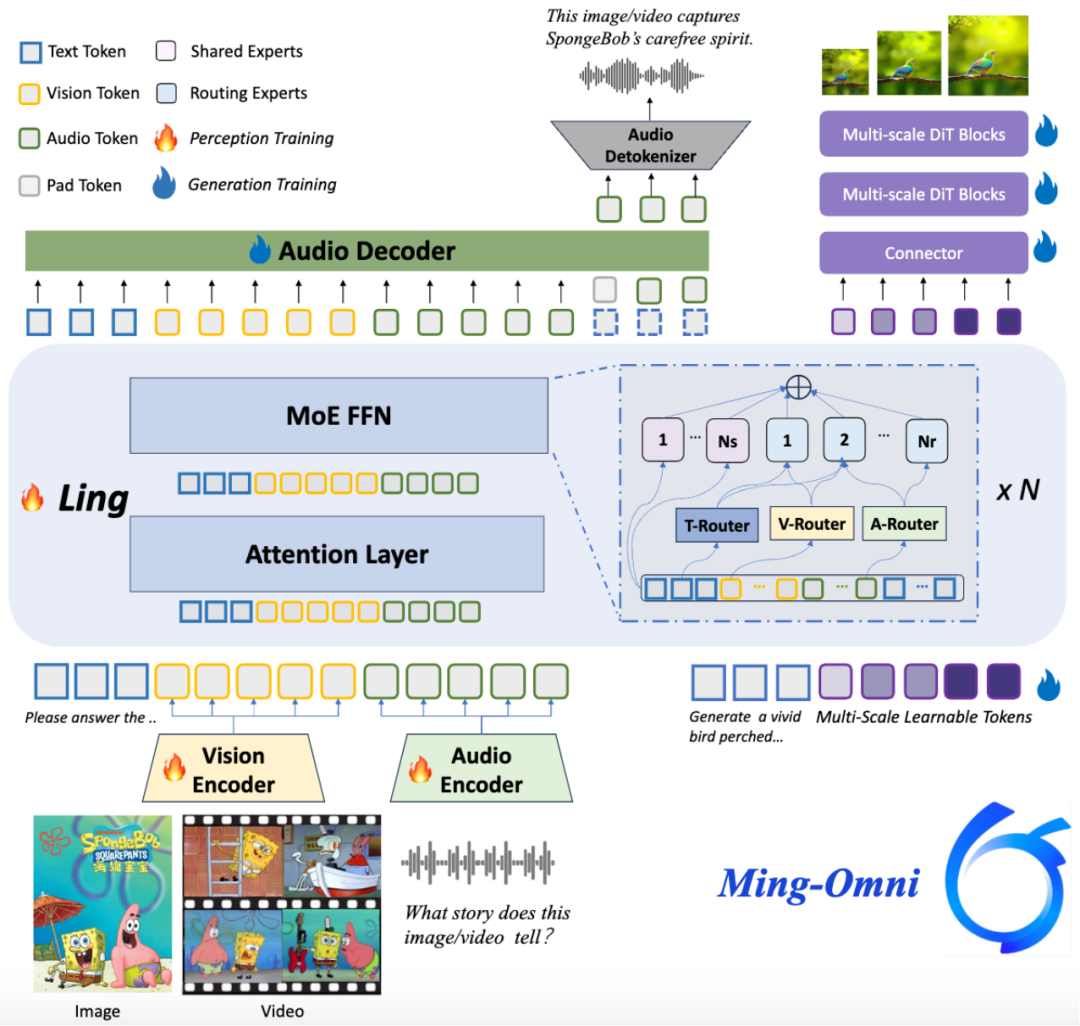

(一)Mixture of Experts(MoE)架构

Ming-Lite-Omni采用MoE架构,通过将模型分解为多个专家网络和门控网络,实现高效的并行化处理。每个专家网络专注于处理特定的输入数据,而门控网络则负责决定输入数据分配到哪些专家网络进行处理。这种架构不仅提高了模型的计算效率,还增强了其对大规模数据的处理能力。

(二)多模态感知与处理

Ming-Lite-Omni为每种模态设计了特定的路由机制,确保模型能够高效处理不同模态的数据。例如,在视频理解中,模型通过KV-Cache动态压缩视觉token,支持长时间视频的理解,同时减少计算量。这种机制使得模型能够更好地融合多种模态的信息,实现统一的理解和生成。

(三)统一理解和生成

Ming-Lite-Omni采用编码器–解码器架构,编码器负责理解输入数据,解码器负责生成输出数据。通过跨模态融合技术,模型能够将不同模态的数据进行有效融合,实现统一的理解和生成。这种架构不仅提高了模型的灵活性,还使其能够适应多种任务需求。

(四)优化与训练

Ming-Lite-Omni通过大规模预训练学习通用的模态特征,并通过微调适应特定任务。模型采用分层语料预训练策略和需求驱动的执行优化体系,进一步提高了训练效率和模型性能。

(五)推理优化

Ming-Lite-Omni基于混合线性注意力机制,降低了计算复杂度和显存占用,突破了长上下文推理效率瓶颈。这种优化使得模型能够支持实时交互,适用于需要快速响应的应用场景。

三、主要功能

(一)多模态交互

Ming-Lite-Omni支持文本、图像、音频、视频等多种输入输出方式,能够实现自然流畅的交互体验。用户可以通过多种模态与模型进行交互,获取更丰富的信息。

(二)理解与生成

Ming-Lite-Omni具备强大的理解和生成能力,能够处理问答、文本生成、图像识别、视频分析等任务。模型不仅能够理解输入数据的语义,还能够生成高质量的输出内容。

(三)高效处理

基于MoE架构的优化,Ming-Lite-Omni能够高效处理大规模数据,并支持实时交互。这种高效性使得模型能够适用于多种应用场景,满足不同用户的需求。

四、基准测试

(一)图像基准测试

在图像基准测试中,Ming-Lite-Omni在多个指标上表现出色。例如,在AI2D、HallusionBench、MMBench_TEST_V11等多个基准测试中,Ming-Lite-Omni的平均得分达到了71.42,显著优于其他主流模型。

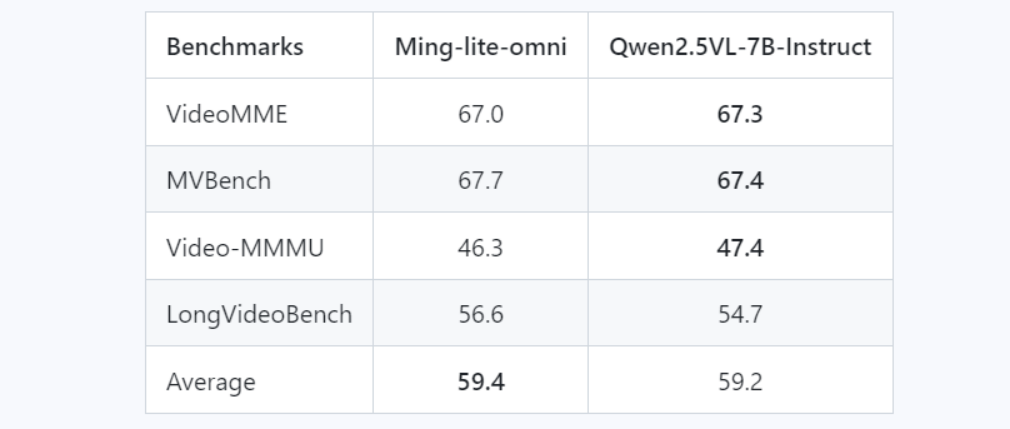

(二)视频基准测试

在视频基准测试中,Ming-Lite-Omni在VideoMME、MVBench、Video-MMMU等指标上表现优异,平均得分达到了57.7,接近行业领先水平。

(三)音频基准测试

在音频基准测试中,Ming-Lite-Omni在SpeechQA和ASR任务中均取得了优异成绩。例如,在SpeechQA任务中,Ming-Lite-Omni的平均得分达到了4.34,显著优于其他模型。

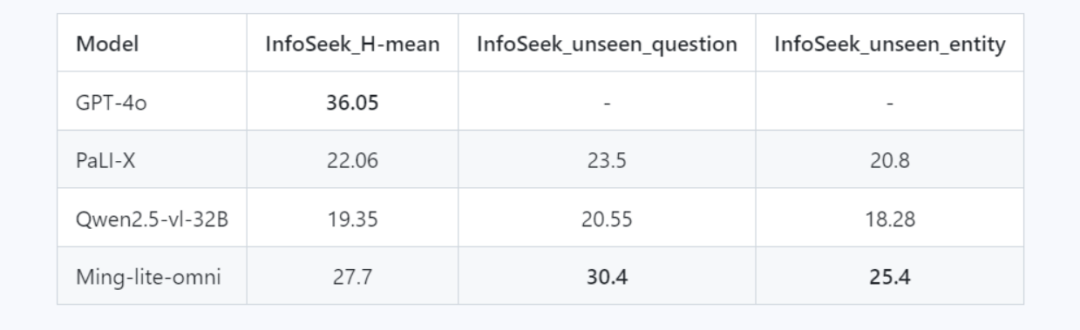

(四)知识问答基准测试

在知识问答基准测试中,Ming-Lite-Omni在InfoSeek_H-mean、InfoSeek_unseen_question等指标上表现突出,平均得分达到了27.7,接近行业领先水平。

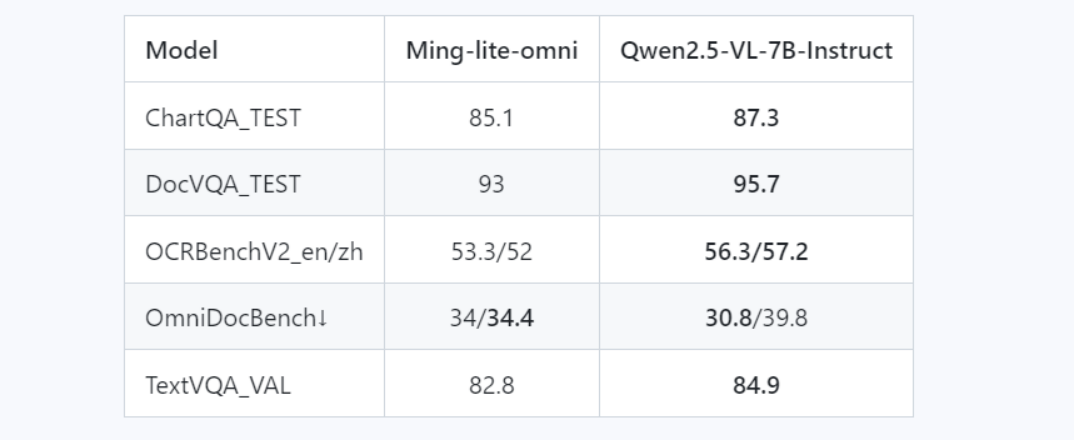

(五)OCR与GUI基准测试

在OCR与GUI基准测试中,Ming-Lite-Omni在ChartQA_TEST、DocVQA_TEST等指标上表现出色,平均得分达到了85.1和93,接近行业领先水平。

(六)统一生成基准测试

在统一生成基准测试中,Ming-Lite-Omni在GENEVAL指标上取得了0.638的高分,显著优于其他主流生成模型。

五、应用场景

(一)智能客服与语音助手

Ming-Lite-Omni支持语音交互,能够快速解答用户问题,适用于智能客服和语音助手场景。通过多模态交互,模型能够更好地理解用户需求,提供更准确的答案。

(二)内容创作与编辑

Ming-Lite-Omni能够生成和编辑文本、图像、视频等内容,辅助内容创作,提高创作效率。例如,用户可以通过输入文本描述,生成相应的图像或视频内容。

(三)教育与学习

Ming-Lite-Omni可以提供个性化学习建议,辅助教学,支持教育信息化。通过多模态交互,模型能够更好地满足不同学生的学习需求。

(四)医疗健康

Ming-Lite-Omni能够辅助病历分析、医学影像解读,支持AI健康管家,提升医疗服务水平。通过多模态数据融合,模型能够更准确地分析医疗数据,提供有价值的建议。

(五)智能办公

Ming-Lite-Omni可以处理文档、整理会议记录,提高办公效率,助力企业智能化管理。通过多模态交互,模型能够更好地理解用户需求,提供更高效的服务。

六、快速使用

(一)环境准备

在使用Ming-Lite-Omni之前,需要确保Python环境已安装相关依赖。可以通过以下命令安装:

pip install -r requirements.txtpip install data/matcha_tts-0.0.5.1-cp38-cp38-linux_x86_64.whlpip install diffusers==0.33.0pip install nvidia-cublas-cu12==12.4.5.8 # for H20

(二)模型加载

从Hugging Face或ModelScope下载模型后,可以通过以下代码加载模型:

import osimport torchfrom transformers import AutoProcessor, GenerationConfigfrom modeling_bailingmm import BailingMMNativeForConditionalGeneration# 加载模型model = BailingMMNativeForConditionalGeneration.from_pretrained("Ming-Omni-18B-A3-Preview",torch_dtype=torch.bfloat16,low_cpu_mem_usage=True).to("cuda")# 设置资产路径assets_path = YOUR_ASSETS_PATH# 加载处理器processor = AutoProcessor.from_pretrained("Ming-Omni-18B-A3-Preview", trust_remote_code=True)

(三)文本问答

通过以下代码实现文本问答:

messages = [{"role": "HUMAN","content": [{"type": "text", "text": "请详细介绍鹦鹉的生活习性。"}],},]# 输出结果output_text = model.generate(messages=messages,processor=processor,max_new_tokens=512,use_cache=True,eos_token_id=processor.gen_terminator,generation_config=GenerationConfig.from_dict({'no_repeat_ngram_size': 10}))print(output_text)

(四)图像问答

通过以下代码实现图像问答:

messages = [{"role": "HUMAN","content": [{"type": "image", "image": os.path.join(assets_path, "flowers.jpg")},{"type": "text", "text": "What kind of flower is this?"}],},]# 输出结果output_text = model.generate(messages=messages,processor=processor,max_new_tokens=512,use_cache=True,eos_token_id=processor.gen_terminator,generation_config=GenerationConfig.from_dict({'no_repeat_ngram_size': 10}))print(output_text)

(五)视频问答

通过以下代码实现视频问答:

messages = [{"role": "HUMAN","content": [{"type": "video", "video": os.path.join(assets_path, "yoga.mp4")},{"type": "text", "text": "What is the woman doing?"}],},]# 输出结果output_text = model.generate(messages=messages,processor=processor,max_new_tokens=512,use_cache=True,eos_token_id=processor.gen_terminator,generation_config=GenerationConfig.from_dict({'no_repeat_ngram_size': 10}))print(output_text)

(六)音频任务

通过以下代码实现音频识别和语音合成:

# 音频识别messages = [{"role": "HUMAN","content": [{"type": "text", "text": "Please recognize the language of this speech and transcribe it. Format: oral."},{"type": "audio", "audio": 'data/wavs/BAC009S0915W0292.wav'}],},]# 输出结果output_text = model.generate(messages=messages,processor=processor,max_new_tokens=512,use_cache=True,eos_token_id=processor.gen_terminator,generation_config=GenerationConfig.from_dict({'no_repeat_ngram_size': 10}))print(output_text)# 语音合成messages = [{"role": "HUMAN","content": [{"type": "audio", "audio": 'data/wavs/speechQA_sample.wav'}],},]# 输出结果output_text = model.generate(messages=messages,processor=processor,max_new_tokens=512,use_cache=True,eos_token_id=processor.gen_terminator,generation_config=GenerationConfig.from_dict({'no_repeat_ngram_size': 10}))print(output_text)

其他更多详情,请查看官方提供的示例说明:https://huggingface.co/inclusionAI/Ming-Lite-Omni

七、结语

Ming-Lite-Omni作为蚂蚁集团开源的统一多模态大模型,凭借其强大的多模态感知和生成能力,在多个领域展现出巨大的应用潜力。通过本文的介绍,相信大家对Ming-Lite-Omni的技术原理、功能特性、基准测试表现以及应用场景有了更深入的了解。希望本文能够为AI领域的技术探索者提供有价值的参考。

八、项目地址

Hugging Face模型库:https://huggingface.co/inclusionAI/Ming-Lite-Omni

ModelScope模型库:https://www.modelscope.cn/models/inclusionAI/Ming-Lite-Omni

(文:小兵的AI视界)