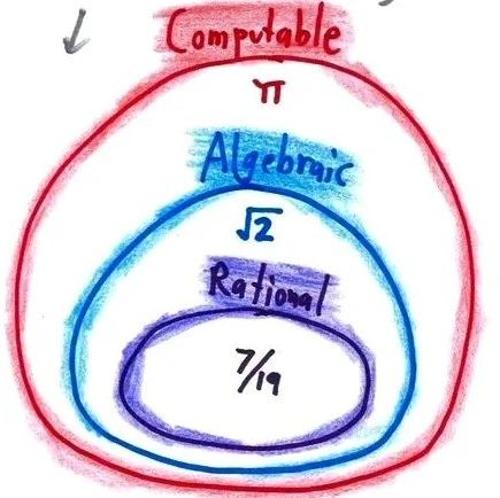

自注意力机制

ICLR 2025 Oral|差分注意力机制引领变革,DIFF Transformer攻克长序列建模难题

建模能力为语言理解与生成带来了前所未有的突破。

然而,随着模型规模的不断扩大和应用场景的日益复杂,传

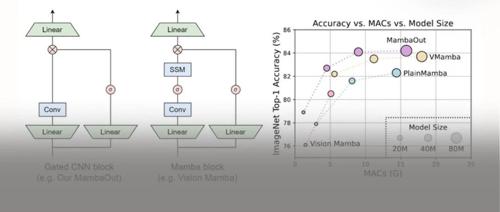

ICLR 2025 性能与效率的更优平衡!哈工深等提出极性感知线性自注意力机制

哈工大深圳、鹏城实验室和昆士兰大学合作提出了一种极性感知线性自注意力机制(Polarity-aware Linear Attention),解决了现有方法在保证注意力分数正值性时会忽视掉 Q,K 矩阵中的负值元素的问题,并在多个视觉任务上取得了精度与效率的平衡。

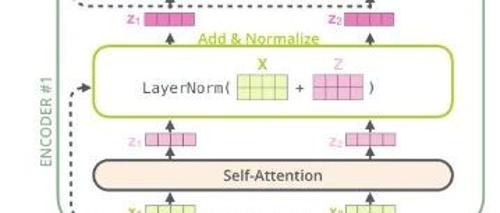

大模型Transformer架构之编码器(Encoder)和解码器(Decoder)

Transformer的编码器负责将人类可识别的数据转换为大模型可以处理的形式,并进行特征提取;解码器则用于重建模式,生成新的数据。其架构包括自注意力机制等多重数据处理步骤。