在人工智能呈爆发式发展的当下,音乐创作这片艺术天地正经历着前所未有的变革浪潮。AI音乐生成工具的问世,宛如一把神奇钥匙,打开了音乐创作高效与便捷的全新大门。今天,我们将深度聚焦一款在业内备受瞩目的AI音乐生成利器——DiffRhythm。它由西北工业大学音频、语音与语言处理研究组(ASLP Lab)携手香港中文大学(深圳)大数据研究院精心打造,凭借其卓越强大的功能以及极具创新性的技术架构,正大刀阔斧地改写着音乐创作领域原有的格局。

一、项目概述

DiffRhythm(中文名“谛韵”)堪称全球首个基于潜在扩散模型(Latent Diffusion)的端到端全长度歌曲生成模型。其强大之处令人惊叹,仅仅只需10秒,它便能生成一首涵盖人声与伴奏的完整歌曲,时长最长可达4分45秒。用户操作极为简便,仅需输入歌词内容以及风格提示信息,DiffRhythm就如同一位灵感爆棚的音乐大师,迅速创作出高质量的音乐作品。这种高效且便捷的音乐生成模式,无疑为专业音乐人增添了得力的创作助手,同时也为广大音乐爱好者以及内容创作者带来了前所未有的奇妙体验。

二、功能特点

1. 端到端生成

它能够直接对原始音频波形进行处理,完全省去了中间复杂的符号转换环节。这一独特优势使得音乐在生成过程中能够最大程度保留其细腻的情感与丰富的细节,让每一首生成的歌曲都充满生命力。

2.多模态理解

DiffRhythm具备强大的多模态信息处理能力,它能够综合分析文本、音乐甚至图像信息。通过对这些不同模态信息的深度融合与理解,精准把握其中蕴含的抽象风格特点,从而生成与输入信息高度契合的音乐作品。

3.动态可控性

用户在使用DiffRhythm时拥有极高的创作自由度,可以实时对节奏进行调整,改变和弦走向,并且灵活地组合各种音乐元素。这种动态可控性让用户仿佛置身于一个音乐创作的“魔法实验室”,能够随心所欲地打造出符合自己心意的音乐。

4.快速生成

在极短的10秒时间内,DiffRhythm就能生成一首完整的歌曲,并且支持多种音乐风格,无论是激昂的摇滚风,还是悠扬的古典风,亦或是动感的流行风,它都能轻松驾驭。

5. 高音乐性和可理解性

DiffRhythm生成的歌曲不仅在音乐性方面表现卓越,旋律优美、和声和谐,而且歌词表达清晰易懂,让听众能够轻松理解歌曲所传达的情感与主题。

6. 支持多种风格

用户只需在输入时给出风格提示,DiffRhythm就能依据提示生成相应风格的音乐,充分满足用户多样化的创作需求。

三、技术架构

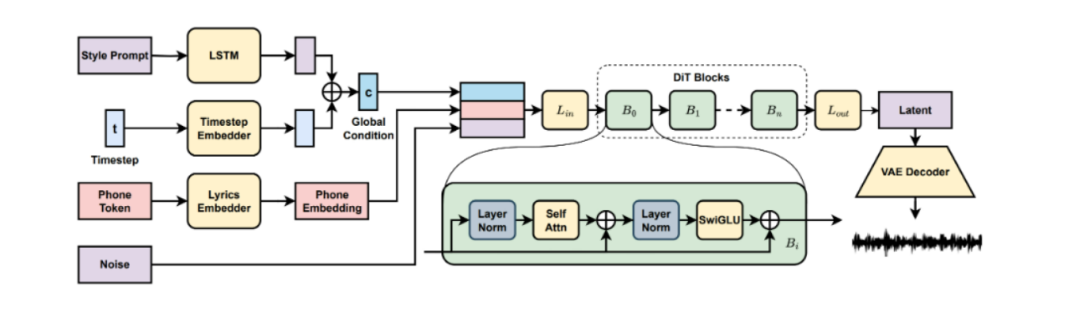

DiffRhythm依托于精妙复杂的潜扩散模型构建其技术架构,核心组件包含以下关键部分:

1. 潜扩散模型(Latent Diffusion)

-

前向加噪:在这一环节,原始音乐片段会被逐步、有规律地混入随机噪声。随着噪声的不断增加,音乐片段的特征逐渐被掩盖,最终彻底转化为毫无规律的白噪声。这个过程看似是对音乐的破坏,实则是为后续的反向去噪操作奠定基础。

-

反向去噪:预训练的神经网络此时发挥关键作用,它如同一位拥有超凡洞察力的解谜高手,从充满噪声的混乱数据中,抽丝剥茧般逐步还原出契合用户需求的音乐。通过对噪声的层层分析与处理,精准恢复音乐原本的旋律、节奏和音色等关键要素。

2. 变分自编码器(VAE)

DiffRhythm借助变分自编码器实现对音频数据的高效编码与解码。在编码阶段,音频信号被巧妙压缩为具有代表性的潜在特征表示,这些潜在特征如同音乐的“密码”,蕴含了音频的关键信息。之后,扩散模型基于这些潜在特征生成全新的潜在特征,最后通过解码操作,将新的潜在特征转化为可供聆听的音频输出,实现了从原始音频到潜在特征再到新音频的完整转换过程。

3. 扩散变换器(Diffusion Transformer)

该组件基于变换器架构搭建,通过交叉注意力层和门控多层感知器协同工作,实现高效的音乐生成。交叉注意力层能够敏锐捕捉音乐元素之间的关联,而门控多层感知器则对信息进行有效筛选与处理。这种架构的优势在于能够妥善处理长上下文窗口的数据,从而生成结构连贯、逻辑顺畅的完整音乐作品。

4. 非自回归结构

DiffRhythm采用的非自回归结构是其一大技术亮点。传统自回归模型在生成音乐时,需逐元素依次生成,效率较低。而非自回归结构打破了这一局限,它能够并行处理数据,显著提升生成速度。这不仅极大地缩短了音乐生成所需的时间,还为模型在面对大规模数据或复杂任务时的可扩展性提供了有力保障。

四、应用场景

DiffRhythm凭借其强大功能,在众多领域拥有广泛的应用场景,成为音乐创作与内容生产领域的得力工具:

1. 内容创作

短视频博主在创作过程中,常常为寻找合适的背景音乐而苦恼。有了DiffRhythm,他们可以快速生成与视频情绪完美适配的背景音乐,而且无需担忧版权问题,极大提升了创作效率与视频质量。

2.独立游戏开发

对于独立游戏开发者而言,打造高品质的场景音效库往往成本高昂。DiffRhythm的出现为他们提供了低成本解决方案,能够快速生成丰富多样的场景音效,为游戏增添独特魅力。

3. 音乐产业

唱片公司可以借助DiffRhythm的AI辅助创作功能,轻松打造热门歌曲的Remix版本。通过创新的音乐改编,延长音乐IP的生命周期,吸引更多听众,创造更大的商业价值。

4. 演出行业

在演出过程中,DiffRhythm能够实时生成与观众互动反馈同步的即兴音乐。这种独特的互动方式能够极大增强演出的趣味性与吸引力,为观众带来前所未有的现场体验。

5. 教育领域

教育者可以利用DiffRhythm制作个性化的教学素材,通过生动的音乐示例帮助学生更好地理解音乐理论、节奏、和声等知识,提升音乐教学的效果与趣味性。

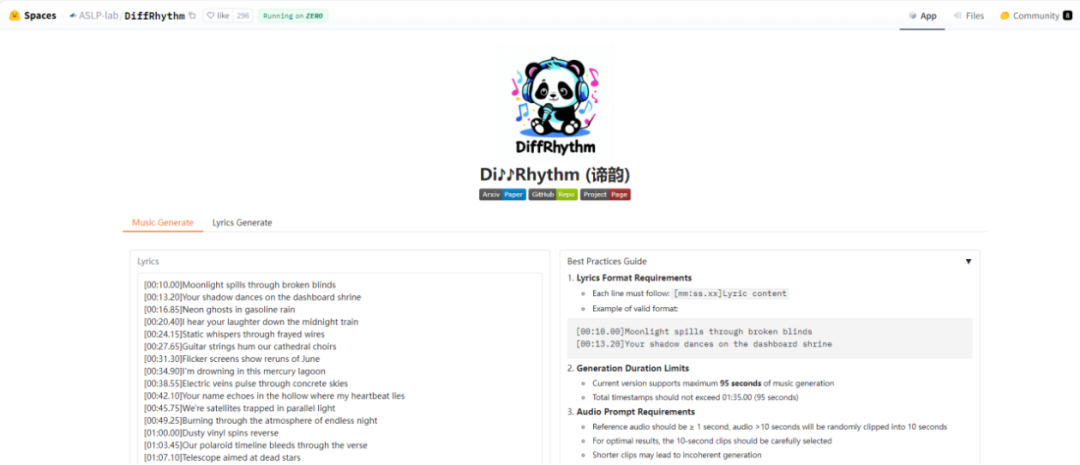

五、在线体验

DiffRhythm的操作过程极为简便,以下为快速上手的详细步骤:

1. 访问项目页面:用户可前往DiffRhythm在Hugging Face上提供的体验地址:https://huggingface.co/spaces/ASLP-lab/DiffRhythm

2. 准备输入内容:精心准备好歌词文本,清晰构思想要的音乐风格并整理成风格提示信息,将二者作为模型的输入内容。

3. 生成音乐:将准备好的输入内容提交给DiffRhythm模型,模型将在短短10秒内迅速生成一首包含人声和伴奏的完整歌曲。

六、本地部署

DiffRhythm的使用非常简单,以下是详细的快速上手指南。通过以下步骤,你可以在本地环境中快速部署并生成完整的歌曲。

1. 环境准备

在开始之前,请确保你的系统满足以下要求:

-

Python版本:推荐使用Python 3.10。

-

显存要求:DiffRhythm-base至少需要8GB的显存(VRAM)。如果显存不足,建议启用分块解码(`chunked=True`)。

2. 克隆仓库

首先,克隆DiffRhythm的GitHub仓库到本地。打开终端或命令提示符,运行以下命令:

git clone https://github.com/ASLP-lab/DiffRhythm.gitcd DiffRhythm

3. 安装依赖

DiffRhythm需要一些额外的工具和Python库。按照以下步骤安装所需的环境:

3.1 安装`espeak-ng`

`espeak-ng`是一个文本到语音的工具,用于生成歌词的语音提示。根据你的操作系统,选择合适的安装方式:

-

Debian的系统(如Ubuntu、Linux Mint等):

sudo apt-get install espeak-ng-

RedHat的系统(如CentOS、Fedora等):

sudo yum install espeak-ng-

Windows用户:

请访问[espeak-ng的GitHub发布页面](https://github.com/espeak-ng/espeak-ng/releases),下载`.msi`安装程序并安装。

3.2 创建并激活Python环境

使用`conda`创建一个新的Python环境,并安装所需的Python依赖:

conda create -n diffrhythm python=3.10conda activate diffrhythmpip install -r requirements.txt

4. 准备输入文件

DiffRhythm需要歌词文件(`.lrc`格式)和参考音频作为输入。你可以在`infer/example`目录中找到示例文件。如果需要生成自己的歌词文件,可以使用Hugging Face上的工具来创建。

5. 运行推理脚本

在完成环境配置和输入文件准备后,运行以下命令开始生成音乐:

python infer/infer.py --lrc_path infer/example/your_lyrics.lrc --ref_audio_path infer/example/your_reference_audio.wav参数说明:

`–lrc_path`:指定歌词文件的路径。

`–ref_audio_path`:指定参考音频的路径。

注意:如果显存不足,请确保在`decode_audio`函数中设置`chunked=True`,以启用分块解码。

6. 输出结果

生成的音乐将保存在指定的输出目录中。你可以根据需要进一步编辑或调整生成的音乐。

7. 验证与调整

生成的音乐可能需要根据具体需求进行微调。你可以尝试修改歌词、参考音频或调整模型参数,以获得更理想的输出。

通过以上步骤,即可在本地快速部署并使用DiffRhythm生成完整的歌曲。

结语

DiffRhythm凭借其强大无匹的功能以及极具开创性的技术架构,正以不可阻挡之势重新定义音乐创作的边界。它宛如一位不知疲倦的音乐创作伙伴,为音乐创作者提供了高效且强大的创作工具,同时也为音乐爱好者与内容创作者带来了耳目一新的体验。随着科技的持续进步与发展,希望DiffRhythm能够给我们带来更多的惊喜,发挥更大的作用,引领音乐创作领域大步迈入一个充满无限可能的全新时代。

项目地址

项目官网:https://aslp-lab.github.io/DiffRhythm.github.io/

GitHub仓库:https://github.com/ASLP-lab/DiffRhythm

Hugging Face模型库:https://huggingface.co/ASLP-lab/DiffRhythm-base

在线体验:https://huggingface.co/spaces/ASLP-lab/DiffRhythm

技术论文:https://arxiv.org/pdf/2503.01183

(文:小兵的AI视界)