极市导读

生成只是起点,理解世界、构建智能,才是终局。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

一段视频,看起来足够真实,但它知道自己在演什么吗?

一次跳跃、一场碰撞,是否只是像素的移动,还是蕴藏着因果、物理与交互的世界逻辑?

随着 AIGC 的飞速发展,图像生成已经“卷”入日常,视频生成也不再是最初的“抖动幻影”,而是跃升为能够讲故事、控制动作、进行较长时推理的高质量动态内容。

可灵、Sora、Genie、Cosmos、Movie Gen 等一系列模型的突破正在不断拓宽视频生成的边界,研究者们开始重新关注更深层次的问题:

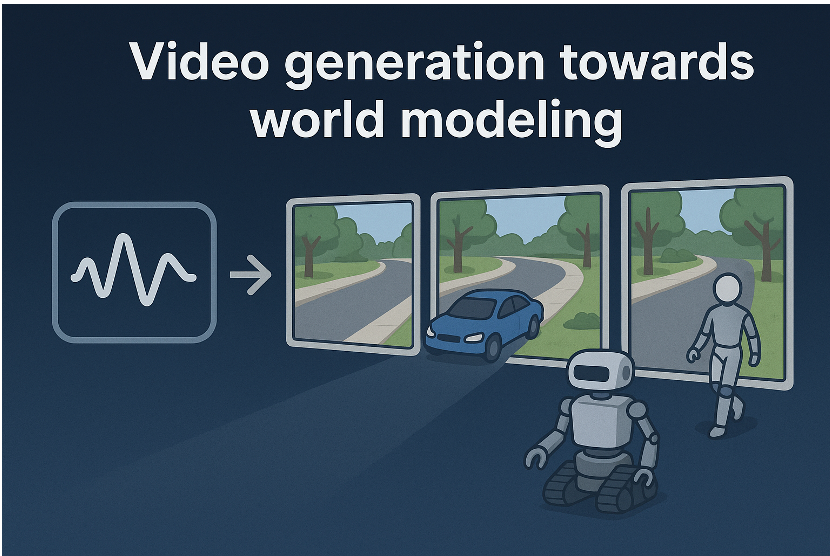

🧠 视频生成是否能成为通往世界模型的桥梁?

🧠 它是否具备成为可执行、可交互、可推理的智能中枢?

🧠 它是否正在走向支撑具身智能(Embodied Intelligence)的核心能力?

这些问题正是我们将在《From Video Generation to World Models – 从视频生成到世界模型》中深入探讨的核心议题。我们希望系统梳理这一技术路径:

如何将视频生成作为强大的视觉先验,赋能 AI 感知世界、理解交互、推理物理,从而迈向更通用、更具具身智能能力的世界模型。

🔗 官网地址:https://world-model-tutorial.github.io/

👥 顶尖讲者,重磅阵容集结

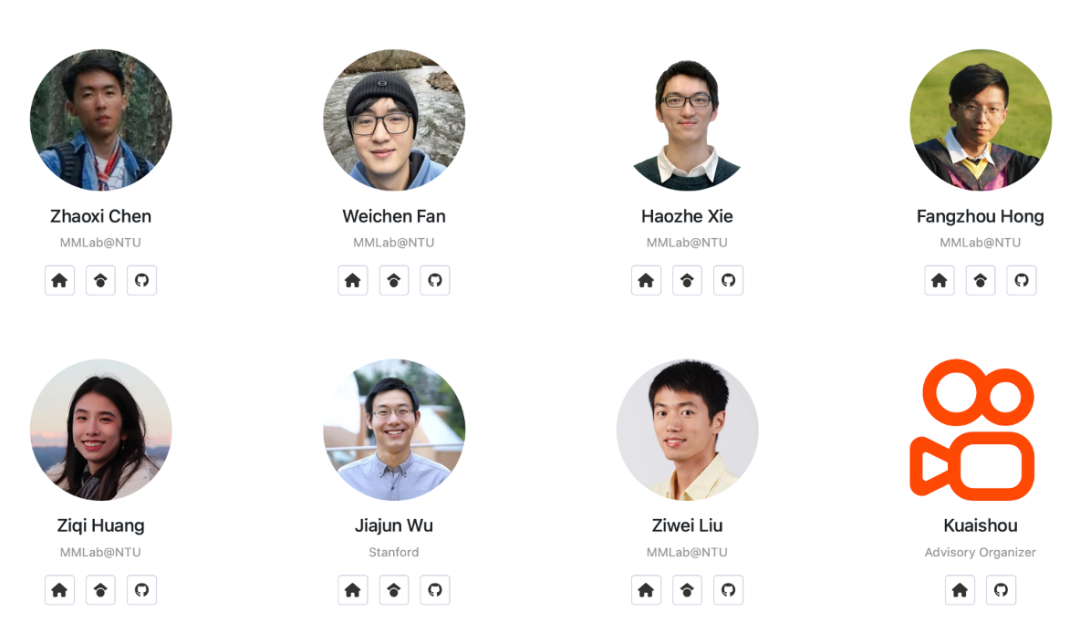

本教程汇聚来自学术界与产业界的一线研究者:

他们将在生成建模、3D理解、强化学习与物理推理等方向展开分享,探讨如何将生成能力转化为感知、预测与决策的智能基座。

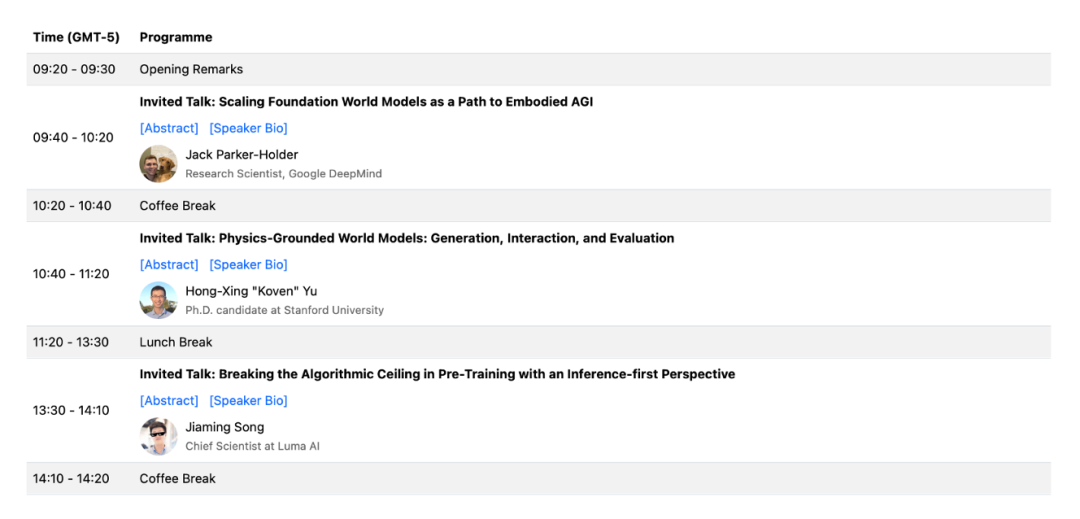

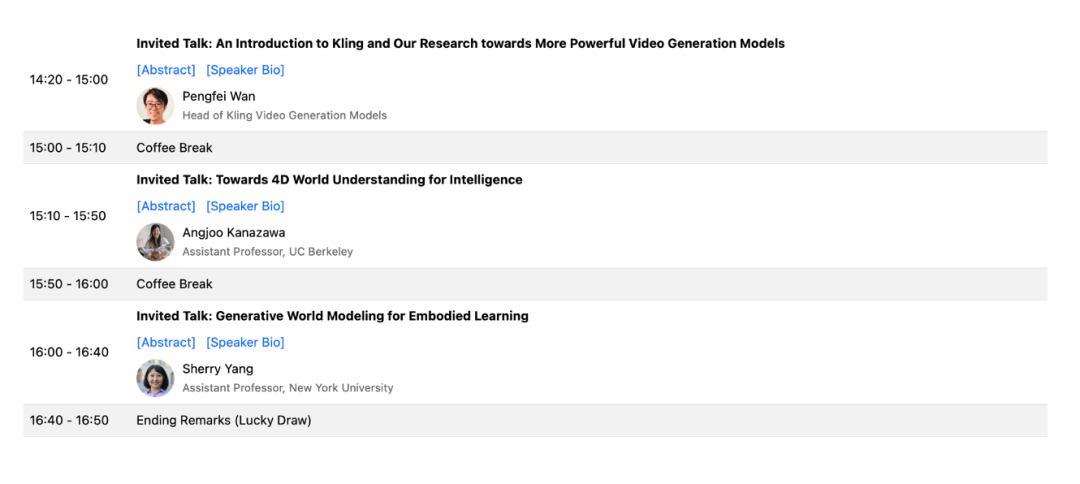

🗓 日程安排一览(CVPR 2025 |6 月 11 日)

(注:均为美国纳什维尔当地时间 UTC-5)

🧩 不只是生成,更是理解与交互

视频生成技术本身,已经初步展现出对时空一致性、视觉因果链的建模能力。我们更关心的是:

● 它是否能被用来理解物体之间的交互?

● 是否能捕捉人类行为背后的物理与语义因果?

● 是否具备从“生成”走向“交互式世界模型(Interactive World Model)”的潜力?

可灵、Sora、Genie、Cosmos、Movie Gen 等模型的发展已提供初步答案:

视频生成可以不仅仅是输出,更是通向感知-建模-推理-决策一体化世界模型的入口。

✅ 如果你正在关注:

● 视频生成与多模态理解

● Embodied AI、机器人与交互智能

● 用生成式模型进行世界建模与物理推理

那么,这场教程将为你提供思路、工具与未来研究的方向感。

📌 我们还将现场提供讲义与综述材料,助你全面了解从视频生成到世界建模的研究全景:

🔗 资源地址:

https://github.com/ziqihuangg/Awesome-From-Video-Generation-to-World-Model

🧭 教程组织团队

📅 时间:2025年6月11日

📍 地点:美国 Music City Center, Nashville TN

🎓 欢迎大家现场参与,一起探讨:

如何以视频生成为基石,迈向理解、交互与建模真实世界的下一代智能系统。

生成只是起点,理解世界、构建智能,才是终局。

Video is just the start. World modeling is the goal.

🔗 最新信息详见官网:https://world-model-tutorial.github.io/

(文:极市干货)