PCL团队 投稿

量子位 | 公众号 QbitAI

生成式视角可以对监督学习重新思考乃至重新定义!

想象你在教一个学生解数学题——你会直接让他交卷对答案,还是会让他参考完整答案来理解解题思路?

如今,一种全新的监督学习范式正受到关注:标签不应只是用于对照回答的标准答案,更可能成为学习过程中的辅助参考。

受生成式一致性模型的启发,来自上海交大、SII、MIT、港中文深圳等机构的研究团队在ICML 2025最新提出预测一致性学习(PCL,Predictive Consistency Learning)。

PCL通过扩散模型的扩散过程消减标签的信息,将噪声标签(Noised Labels)引入模型的输入,使得模型在数据输入和噪声标签的共同参照下预测完整标签,实现标签信息的复用和价值挖掘。

训练过程概览

传统监督学习中,输入 通过神经网络预测

通过神经网络预测 ,通过对比和标准答案

,通过对比和标准答案 之间的关系,来计算损失和反向传播更新模型,对应损失函数

之间的关系,来计算损失和反向传播更新模型,对应损失函数

其中 为具体损失函数,

为具体损失函数, 为神经网络函数。受生成一致性模型中一致性映射思想的启发,PCL对应一种全新的监督学习范式,旨在通过渐进式分解标签信息来更好地捕捉复杂标签的完整表征,使得模型在部分标签信息的提示下实现完整标签信息的预测。

为神经网络函数。受生成一致性模型中一致性映射思想的启发,PCL对应一种全新的监督学习范式,旨在通过渐进式分解标签信息来更好地捕捉复杂标签的完整表征,使得模型在部分标签信息的提示下实现完整标签信息的预测。

与传统方法不同,PCL学习框架将完整标签的学习过程分解为逐步逼近的渐进式任务:模型会接收一个含有部分标签信息的额外输入 作为提示,首先学习捕捉互补的部分标签信息,随后逐步逼近完整标签。

作为提示,首先学习捕捉互补的部分标签信息,随后逐步逼近完整标签。

为了系统化地规划标签学习过程,研究人员借鉴了扩散模型和一致性模型中的加噪过程,通过生成带噪标签作为额外的输入提示,使模型能够在学习带噪部分的同时补充完整信息。

具体而言,PCL在训练时:以输入数据为条件,将不同噪声水平的带噪标签映射回真实标签,噪声程度由时间步 控制;约束不同噪声时间步的预测结果均一致地逼近目标标签。

控制;约束不同噪声时间步的预测结果均一致地逼近目标标签。

模型每次采样两个不同的时间步,要求模型在不同时间步的提示下尽可能精准还原标签,同时预测的结果尽可能保持一致。

通过这种跨噪声水平的一致性约束,模型能够学习从完全噪声到精确标签的不同层级的标签信息,从而构建更具表达力的映射关系。

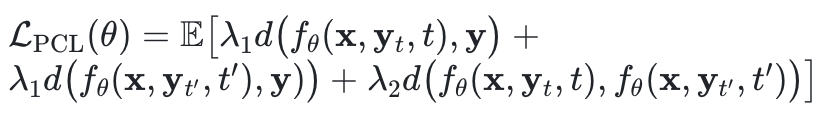

预测一致性机制的作用在于,将低噪声条件下的预测精度传递至高噪声条件,同时约束模型在不同噪声水平下表征的不变性,从而减小对于标签提示的过度依赖,服务于测试过程。最终损失函数形式为:

其中模型接收输入 ,两个不同时间步的噪声标签

,两个不同时间步的噪声标签 和相应的时间步

和相应的时间步 ,模型在两个不同噪声标签的提示下完成预测,在预测结果逼近噪声标签的同时,额外约束两个预测结果的一致性。

,模型在两个不同噪声标签的提示下完成预测,在预测结果逼近噪声标签的同时,额外约束两个预测结果的一致性。 分别控制预测精度loss和预测一致性loss的权重。

分别控制预测精度loss和预测一致性loss的权重。

标签噪声过程

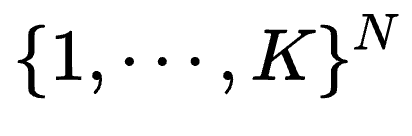

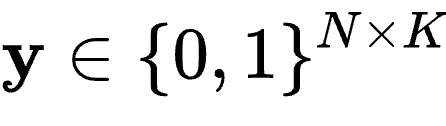

离散标签的噪声过程:对于多维分类标签 ,其中

,其中 表示类别数,

表示类别数, 表示维度,研究人员遵循离散扩散模型将噪声过程建模为在每个时间步

表示维度,研究人员遵循离散扩散模型将噪声过程建模为在每个时间步 引入类别噪声到标签中。

引入类别噪声到标签中。

他们将标签表示为 ,它是

,它是 个独热编码向量的拼接。噪声可以理解为在每个维度的不同类别之间进行转换。从初始点

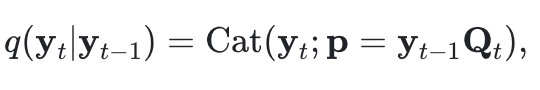

个独热编码向量的拼接。噪声可以理解为在每个维度的不同类别之间进行转换。从初始点 开始,噪声过程定义为:

开始,噪声过程定义为:

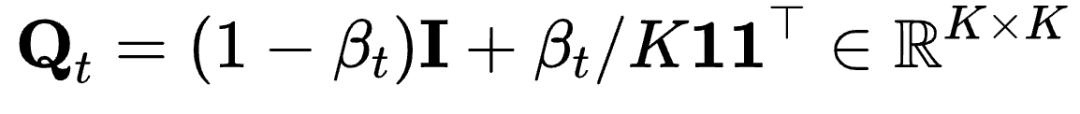

其中 是在

是在 个独热向量上的分类分布,概率由

个独热向量上的分类分布,概率由 给出,

给出, 是转移矩阵,决定了在时间步

是转移矩阵,决定了在时间步 引入的噪声,对应的标签类别以概率

引入的噪声,对应的标签类别以概率 转移到任何其他类别。

转移到任何其他类别。

随着时间的推移,当 接近最终时间步

接近最终时间步 时,标签会收敛到

时,标签会收敛到 个类别的均匀分布。由于噪声矩阵可以事先计算,因此跨步噪声计算代价很低。

个类别的均匀分布。由于噪声矩阵可以事先计算,因此跨步噪声计算代价很低。

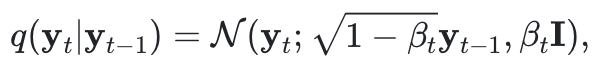

连续标签的噪声过程:对于多维连续标签 ,其中

,其中 表示维度,研究人员遵循高斯扩散模型将扩散过程建模为在每个时间步向标签引入高斯噪声。在每个时间步

表示维度,研究人员遵循高斯扩散模型将扩散过程建模为在每个时间步向标签引入高斯噪声。在每个时间步 ,高斯噪声被应用于标签,逐步将其推向一个噪声分布。噪声过程定义为:

,高斯噪声被应用于标签,逐步将其推向一个噪声分布。噪声过程定义为:

其中 是均值为

是均值为 ,协方差为

,协方差为 的高斯分布,

的高斯分布, 控制在时间步

控制在时间步 上添加噪声的方差。随着时间的推移,当

上添加噪声的方差。随着时间的推移,当 接近最终时间步

接近最终时间步 时,标签会收敛到一个以零为中心的高斯分布。同样噪声函数可以事先计算,因此跨步噪声计算代价很低。

时,标签会收敛到一个以零为中心的高斯分布。同样噪声函数可以事先计算,因此跨步噪声计算代价很低。

嵌入空间的噪声过程:在标签过于复杂,无法直接表示为分类或连续值,或者类别数过大时,PCL直接向标签的潜在嵌入空间引入高斯噪声,这种方式与连续标签的噪声过程一致。

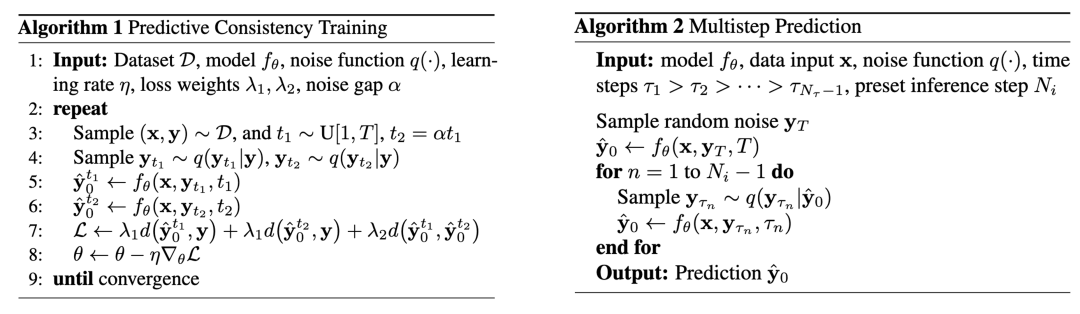

测试过程概览

在训练完成后的推理阶段,可以通过从随机噪声分布采样标签作为提示信息 ,并进行单次前向传播来进行高效预测。

,并进行单次前向传播来进行高效预测。

由于 不包含任何信息量,这个推理过程实际上和传统监督学习的直接预测是一致的。然而在训练阶段的改进使得PCL模型具有更好的预测能力,即使不依赖任何标签提示已经能够超越传统监督学习的精度。

不包含任何信息量,这个推理过程实际上和传统监督学习的直接预测是一致的。然而在训练阶段的改进使得PCL模型具有更好的预测能力,即使不依赖任何标签提示已经能够超越传统监督学习的精度。

在训练过程中,当 较小时,直接预测精度往往较高,因为标签提示包含更多的信息。目标是通过训练将这种高精度逐步转移到较大的

较小时,直接预测精度往往较高,因为标签提示包含更多的信息。目标是通过训练将这种高精度逐步转移到较大的 值,从而提升整体模型性能。

值,从而提升整体模型性能。

在理想情况下,当一致性损失趋于零时,可以通过一步推理获得最优结果,但实际上,通过逐步将 从

从 降至0可以规划不同层级标签信息的预测,带来精度的提升。

降至0可以规划不同层级标签信息的预测,带来精度的提升。

为了实现这种提升,可以采用多步推理策略,通过对上一步标签重新引入噪声作为下一步预测的标签提示并且交替执行预测,使得模型能够在多个推理步骤中逐步细化其输出,并利用早期预测中嵌入的越来越丰富的提示信息。

给定一系列时间点 ,在每一步

,在每一步 ,上一步预测

,上一步预测 会通过噪声函数被扰动到状态

会通过噪声函数被扰动到状态 作为下一步预测的噪声提示信息,从而修正

作为下一步预测的噪声提示信息,从而修正 预测。

预测。

噪声水平随着每一步的进行而降低,即 。然后,模型通过应用

。然后,模型通过应用 对标签进行更精确的预测。这个过程会在接下来的步骤中重复进行,每一步新的标签提示信息都包含了从前一步获取的更精确的信息。

对标签进行更精确的预测。这个过程会在接下来的步骤中重复进行,每一步新的标签提示信息都包含了从前一步获取的更精确的信息。

这使得模型能够逐步恢复 的全部信息,通过将可能的近似预测作为标签提示,并利用逐步增益的信息来进行最终预测。

的全部信息,通过将可能的近似预测作为标签提示,并利用逐步增益的信息来进行最终预测。

信息论视角

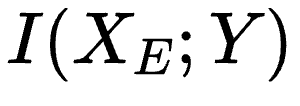

从理论角度出发,在标准监督学习场景下,模型的主要目标是捕捉输入 和标签

和标签 之间的互信息。

之间的互信息。

通常,由于输入 的信息量常常远远大于标签

的信息量常常远远大于标签 ,模型希望通过学习一个压缩的特征表示来最大化

,模型希望通过学习一个压缩的特征表示来最大化 并最小化

并最小化 ,其中

,其中 是从

是从 提取的特征表示。默认情况下,从

提取的特征表示。默认情况下,从 到

到 之间的映射是直接且容易捕捉的。

之间的映射是直接且容易捕捉的。

然而,随着任务的复杂性增加,标签 的信息也变得越来越复杂,例如高维度、复杂的内部结构等。这使得从

的信息也变得越来越复杂,例如高维度、复杂的内部结构等。这使得从 到

到 之间的映射变得更加复杂,模型需要应对更加困难的学习问题。

之间的映射变得更加复杂,模型需要应对更加困难的学习问题。

为了更有效地建模 ,相较于一次性学习

,相较于一次性学习 所有的信息,PCL的设计实则提出了一种结构化的学习过程,逐步捕捉这些信息。

所有的信息,PCL的设计实则提出了一种结构化的学习过程,逐步捕捉这些信息。

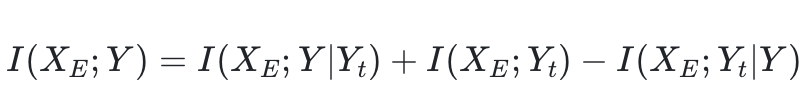

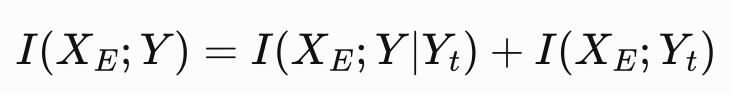

为了将标签信息分解为一个更为渐进的学习过程,PCL引入了一个附加的噪声标签 ,用于在每次迭代中调节学习的标签信息量。通过引入

,用于在每次迭代中调节学习的标签信息量。通过引入 ,原始的互信息

,原始的互信息 可以分解为如下形式:

可以分解为如下形式:

由于 是由

是由 推导而来的,当

推导而来的,当 已知时,

已知时, 对

对 并没有额外的信息,因此冗余项

并没有额外的信息,因此冗余项 ,公式简化为:

,公式简化为:

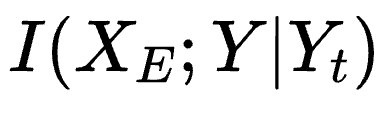

这一分解揭示了两个关键成分,其中第一个项 捕捉了在给定

捕捉了在给定 的条件下可以学习的

的条件下可以学习的 的增量信息。该项作为

的增量信息。该项作为 的下界,且它们之间的差距可以通过

的下界,且它们之间的差距可以通过 的信息量进行控制。

的信息量进行控制。

通过最大化 ,模型逐步学习捕捉

,模型逐步学习捕捉 的完整信息内容。具体而言,当

的完整信息内容。具体而言,当 时,

时, 提供的信息极少,迫使模型完全捕捉

提供的信息极少,迫使模型完全捕捉 ;而当

;而当 时,

时, 逼近

逼近 ,允许模型专注于优化标签的细节。

,允许模型专注于优化标签的细节。

在训练过程中,通过随机采样一批 值,模型能够同时学习标签的不同方面。最初,模型期望能够轻松捕捉标签的部分细节,通过迭代训练,模型逐步积累

值,模型能够同时学习标签的不同方面。最初,模型期望能够轻松捕捉标签的部分细节,通过迭代训练,模型逐步积累 的完整信息内容。

的完整信息内容。

在实现方面,模型暴露于带噪声的 。模型的输入包括

。模型的输入包括 和

和 ,其中

,其中 作为条件输入。尽管引入

作为条件输入。尽管引入 作为辅助输入有助于学习,但最终目标是使模型尽可能少地依赖

作为辅助输入有助于学习,但最终目标是使模型尽可能少地依赖 来进行预测。

来进行预测。

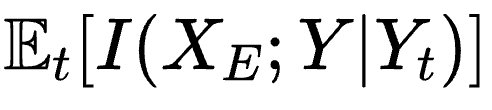

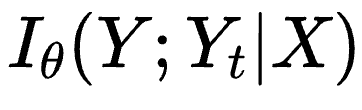

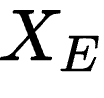

形式上,目标是最小化噪声条件依赖 ,该项衡量模型预测在多大程度上依赖于噪声标签

,该项衡量模型预测在多大程度上依赖于噪声标签 。理想情况下,这一项应该为零,表明在给定

。理想情况下,这一项应该为零,表明在给定 和模型参数

和模型参数 的条件下,模型的预测与

的条件下,模型的预测与 无关。数学上,它可以通过以下公式进行度量:

无关。数学上,它可以通过以下公式进行度量:

该项对应预测一致性的约束,确保对于所有的 和

和 ,都有

,都有 。这种正则化确保了模型的预测在不同噪声水平下保持一致,从而减少了对

。这种正则化确保了模型的预测在不同噪声水平下保持一致,从而减少了对 的依赖,鼓励

的依赖,鼓励 尽可能编码所有必要的信息,以实现准确的预测。

尽可能编码所有必要的信息,以实现准确的预测。

实验结果

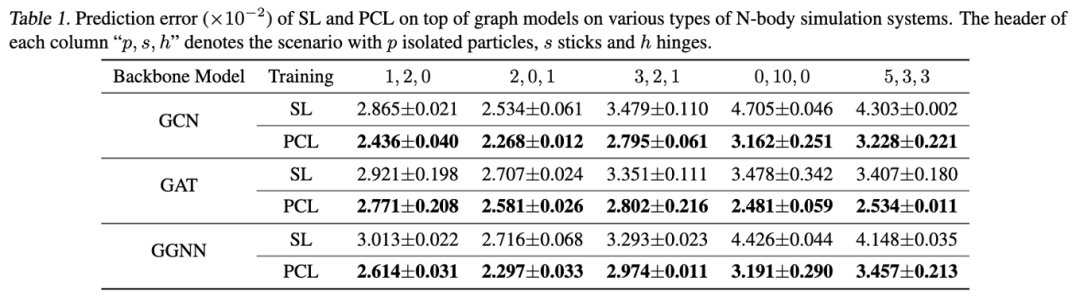

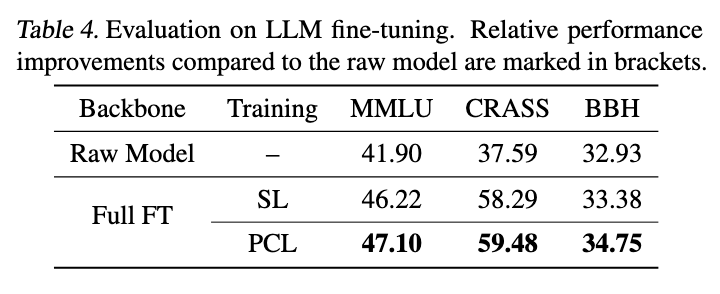

由于PCL作为一种新颖的训练范式被提出,因此主要的基准对比是传统的监督学习。研究者在不同模态的经典代表性模型骨干网络上进行比较,以展示PCL的通用适用性。这些任务包括视觉模态的语义分割、图模态的N体问题仿真和语言模态的next-token prediction监督微调。

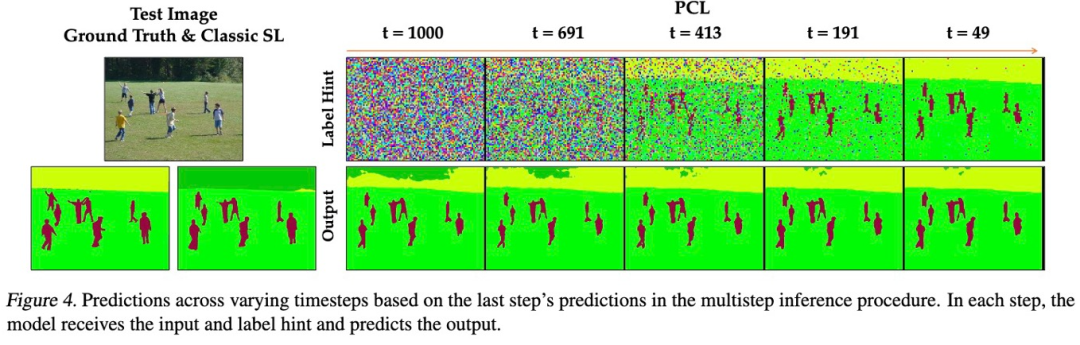

在图像语义分割任务中,上图展示了PCL的预测过程。模型首先在完全随机噪声的提示下进行预测,然后将上一步的标签预测加噪到更小的噪声程度,作为下一步的标签提示。

通过这种递进式的噪声处理和多步推理,最终得到更加精确的预测结果。与传统监督学习(SL)进行对比,PCL在单步预测时就已经超过了SL,而随着预测步骤的增多,预测质量持续提升。

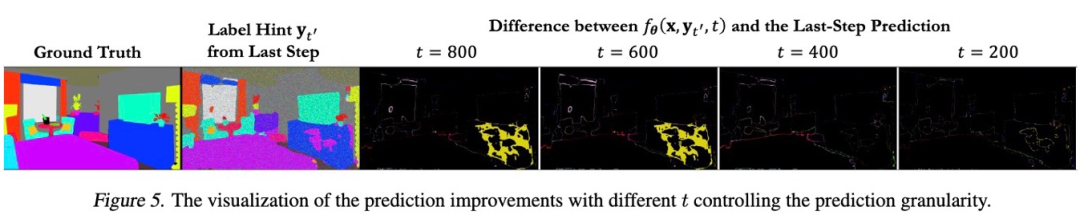

上图展示了在给定标签提示的情况下,不同时间步设置对模型预测错误范围的影响。可以发现,设置较大的时间步倾向于鼓励模型改进更广泛的结构关系,而设置较小的时间步则鼓励模型专注于更精细的细节,例如物体的边界。

这一现象表明,模型通过引入时间步的设计,能够在标签预测过程中分层次地学习不同粒度的信息,从全局结构到局部细节。

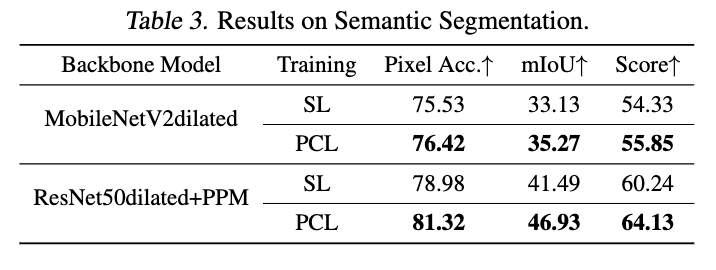

上表展示了在语义分割任务上,PCL与SL的定量表现对比,进一步验证了PCL在提升预测精度方面的优势。

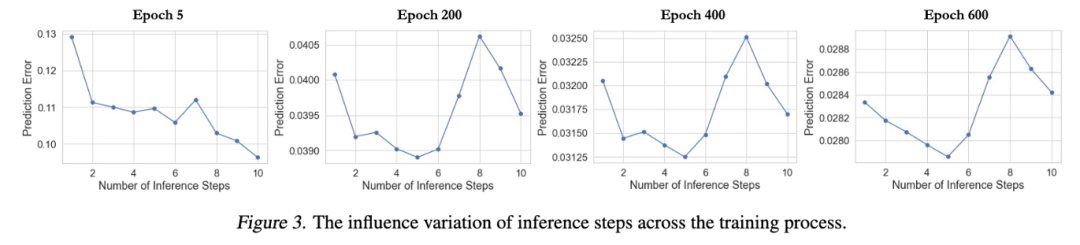

在图模态的预测任务中,上图展示了不同学习阶段下模型在预测阶段的推理步数对预测质量的影响。在训练尚不完全时,推理步数越多,预测精度越高。

然而,随着训练逐渐完成,观察到随着推理步数的增加,预测误差会持续下降,但在达到某个临界点后,误差可能会反弹上升。

这种现象源于训练与推理阶段的差异:在训练阶段,模型始终以真实标签的噪声扰动版本作为输入,而在推理阶段,模型依赖于自身的中间预测结果,这些预测可能包含误差,并在多步迭代中逐渐累积。

由此产生了一个权衡问题:更多的推理步数有助于捕捉更精细的预测细节,但也增加了误差累积的风险。为了优化这一平衡,研究人员通过验证集确定最佳的推理步数,并在测试阶段引入早停机制,在误差开始上升之前终止推理流程。

值得注意的是,单步预测的精度相比于传统监督学习已经有了显著提升。

上表展示了PCL相较于SL在预测精度上的显著提升,进一步验证了PCL在处理复杂预测任务中的优势。

在语言模态的next-token prediction监督微调任务中,研究人员对比了使用SL和PCL微调LLaMa2-7B模型的效果,结果表明,PCL相较于SL在性能上具有优势。

由于噪声过程尚未进行定制化,并且next token作为标签信息的提示量相对单薄,当前的框架仍然有较大的提升空间。

未来的研究可以进一步优化噪声过程并增强标签信息的丰富度,从而进一步提升PCL在语言任务中的表现。

论文链接:https://openreview.net/pdf?id=FO2fu3daSL

代码链接:https://github.com/Thinklab-SJTU/predictive-consistency-learning

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

(文:量子位)